Piktogramm

Admiral

- Registriert

- Okt. 2008

- Beiträge

- 8.906

@Nagilum99

Gepufferter Schreibcache ist aus mehren Gründen ein Witz..

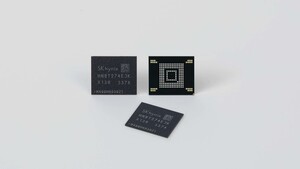

Wenn man das Ganze nach Stand der Technik umsetzen will nutzt man heute einfach gescheite Softwareraids mit zum Beispiel ZFS. Das Dateisystem ist gegen Unterbrechungen beim Schreiben gehärtet[1]. Kernelpaniks und Stromausfälle verlieren damit ihren Schrecken. Gleichzeitig kann das Dateisystem fast den ganzen Arbeitsspeicher des Systems als Cache nutzen[2]. Wer einen fixen Zwischencache will kann SSDs (hier empfiehlt sich das 3D XPoint Gerümpel von Micron/Intel) einbinden. Die Kosten die ein entsprechender Raid Controller im Vergleich zu ner HBA Karte kosten könnte steckt man einfach in CPU, RAM oder SSD-Cache.

Dem System sollte man im Zweifelsfall dennoch ein UPS gönnen, da man Neustarts ja in der Regel vermeidet, da leere Caches einfach "unschön" sind und selbst mit entsprechenden Vorkehrungen bei großem Storage Stunden ins Land gehen, eh die Caches wieder warm sind. Wenn die Daten im RAM derart wichtig sind, dass sie geschützt werden sollen, dann ist die UPS sowieso Pflicht. Alternativ gibt es heute auch mit Pufferakkus für den Arbeitsspeicher und Intels Optane Memory inkl. Linux Kernelpatches, die es erlauben Arbeitsspeicher nach Reboots "warm" einzubinden.

Was die Leistung angeht, da profitieren Software Raids massiv von AVX2 und AVX512 und zunehmend auch von CPU Erweiterungen die direkt das Berechnen von Prüfsummen beschleunigen.

Ja und was ich als klein bezeichne, sagen wir mal alles was sich in einem einzelnem 4U Einschub oder drunter abwickeln lässt.

[1] ZTFS ist da schon ein bisschen geil. Selbst wenn da gerade Informationen des Dateisystems geschrieben wird und der Strom weg fällt bleibt das Dateisystem konsistent. Das kann BTRFs ohne Verrenkungen noch nicht schnief

[2] 1.5-2TB sind das heute glaube maximal. Es ist unwahrscheinlich, wenn die <100GB Caches der Raid Controller da noch irgendwas reisen..

Gepufferter Schreibcache ist aus mehren Gründen ein Witz..

- Die CPU kann heute >2TB Memory anbinden und als Cache nutzen. Da sind die paar GB des Laufwerkcontrollers echt witzlos.

- Viele Controller melden, dass Daten geschrieben wurden obwohl sie noch in deren Cache liegen. Eigentlich ein Antifeature. Dessen negative Auswirkungen mit einem extra Bufferakku kompensiert werden muss. Wobei es darauf ankommt, dass eben dieser Akku nicht versagt..

- Mitunter sind die Raids mit propritären Technologien "angereichert" was bedingt, dass man auf einzelne Controller Marken/Baureihen festgenagelt ist.

Wenn man das Ganze nach Stand der Technik umsetzen will nutzt man heute einfach gescheite Softwareraids mit zum Beispiel ZFS. Das Dateisystem ist gegen Unterbrechungen beim Schreiben gehärtet[1]. Kernelpaniks und Stromausfälle verlieren damit ihren Schrecken. Gleichzeitig kann das Dateisystem fast den ganzen Arbeitsspeicher des Systems als Cache nutzen[2]. Wer einen fixen Zwischencache will kann SSDs (hier empfiehlt sich das 3D XPoint Gerümpel von Micron/Intel) einbinden. Die Kosten die ein entsprechender Raid Controller im Vergleich zu ner HBA Karte kosten könnte steckt man einfach in CPU, RAM oder SSD-Cache.

Dem System sollte man im Zweifelsfall dennoch ein UPS gönnen, da man Neustarts ja in der Regel vermeidet, da leere Caches einfach "unschön" sind und selbst mit entsprechenden Vorkehrungen bei großem Storage Stunden ins Land gehen, eh die Caches wieder warm sind. Wenn die Daten im RAM derart wichtig sind, dass sie geschützt werden sollen, dann ist die UPS sowieso Pflicht. Alternativ gibt es heute auch mit Pufferakkus für den Arbeitsspeicher und Intels Optane Memory inkl. Linux Kernelpatches, die es erlauben Arbeitsspeicher nach Reboots "warm" einzubinden.

Was die Leistung angeht, da profitieren Software Raids massiv von AVX2 und AVX512 und zunehmend auch von CPU Erweiterungen die direkt das Berechnen von Prüfsummen beschleunigen.

Ja und was ich als klein bezeichne, sagen wir mal alles was sich in einem einzelnem 4U Einschub oder drunter abwickeln lässt.

[1] ZTFS ist da schon ein bisschen geil. Selbst wenn da gerade Informationen des Dateisystems geschrieben wird und der Strom weg fällt bleibt das Dateisystem konsistent. Das kann BTRFs ohne Verrenkungen noch nicht schnief

[2] 1.5-2TB sind das heute glaube maximal. Es ist unwahrscheinlich, wenn die <100GB Caches der Raid Controller da noch irgendwas reisen..