Magl

Langzeitbelichter

- Registriert

- Feb. 2010

- Beiträge

- 5.011

nö, man lässt Crysis laufen .. allerdings auf 120 fps begrenzt, damit sie es packenGrovy schrieb:was macht man mit so einem super computer?

wetter berechnen?

Folge dem Video um zu sehen, wie unsere Website als Web-App auf dem Startbildschirm installiert werden kann.

Anmerkung: Diese Funktion ist in einigen Browsern möglicherweise nicht verfügbar.

nö, man lässt Crysis laufen .. allerdings auf 120 fps begrenzt, damit sie es packenGrovy schrieb:was macht man mit so einem super computer?

wetter berechnen?

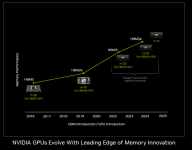

Abwarten, VCZ (wo man in der Regel ziemlich gut informiert ist) rechnet auch mit einem Marktstart in 2024 bis 2025 (als Quelle wird nVidia angegeben, siehe Tabelle unten) und es gab auch schon anderweitig Gerüchte, die Blackwell gegen Ende 2024 verordnet haben.Volker schrieb:Und das Blackwell 2024 kommt bezweifeln wir mal stark

Chismon schrieb:Abwarten,

Daß die USA da ziemlich gut informiert sind, kann man mit Sicherheit annehmen; so ganz verheimlichen lässt sich so eine Anlage ja nicht. Wenn China aber Exascale Systeme offiziell und öffentlich macht und vielleicht noch den ersten Platz auf der Liste reklamiert, würde das auch viel politischen Druck von Seiten der "China Hawks" (v.a. auf der Republikanischen Seite) auf die Biden Regierung bringen, hier noch rigorosere Handelsbeschränkungen zu verhängen. Die derzeitige US Regierung versucht ja gerade, die Beziehungen zur PRC etwas zu entspannen, und das passt zB den Leuten um Trump überhaupt nicht. Ich glaube daß wir Technik- Interessierte oft unterschätzen, wie politisch Großprojekte wie Supercomputer auch sind. Die Entscheidung, wo da wieviel Geld von wem in derartige Anlagen gesteckt wird, beruht auch auf Prestige und öffentliche Wahrnehmung. Daß hohe und höchste Rechenleistung für viele wissenschaftliche Fragen sehr wichtig oder unabdingbar ist, steht natürlich auch außer Frage.=dantE= schrieb:Die USA wissen auch ohne diese Liste ganz gut Bescheid.

Die werden sich bestimmt nicht anhand dieser hier veröffentlichten Liste orientieren müssen.

Ich habe hierzu zwar keine Quelle, aber ich bin ja auch nicht in deren Nachrichtendienste eingebunden.

Topic:

Mich wundert ein Intelsystem auf der 1 in den Green500.

Die muss man ja derbe optimiert haben damit die die darunter rangierenden EPIC Systeme aussticht.

Jemand genauere Infos?

Wiki Zitat:eastcoast_pete schrieb:wie sich zB Folding@Home und ähnliche Schwarm Computing Ansätze bei der Rechenleistung einordnen lassen?

Die Meldung hatte ich auch im Kopf; ich frage mich dann auch, wieviel andere "Supercomputing" Aufgaben auf Crowd Basis angehbar sind; kann ja auch durchaus in kontrollierten Umgebungen, zB den PCs/Macs eines großen Unternehmens oder einer größeren Behörde oder Einrichtung erfolgen, und war, glaube ich, vor einigen Jahren schon mal probiert worden. Natürlich gibt es sehr gute Gründe, auch hierzulande Supercomputer einzurichten, aber der alte Slogan von SUN (RIP) gilt auch: "The Network is the Computer".=dantE= schrieb:Wiki Zitat:

„

Folding@Home erreichte am 13. April 2020 während der COVID-19-Pandemie eine kombinierte Rechenleistung, die schneller als die 500 schnellsten Supercomputer der Welt zusammengenommen war, und übertraf damit den zu diesem Zeitpunkt schnellsten Supercomputer um das 15-Fache.[3]

„

von PCGHDenniss schrieb:Frontier #1 overall und immer noch #8 bei Green 500.

Was man so hört dürfte Aurora bei den Green 500 nicht sonderlich gut abschneiden.

| CPUs | GPUs | Leistung (Rmax) | Leistungsaufnahme | |

|---|---|---|---|---|

| AMD Frontier HPE Cray EX | Epyc 7A53 | Instinct MI250X | 1,194 Exaflops | 22.703 kW |

| Intel Aurora HPE Cray EX | Xeon Max 9470 | Data Center GPU Max 1550 | 0,585 Exaflops | 24.687 kW |

An der Stelle sind noch Projekte für die Auswertung von extraterrestrischen Radiosignalen anzumerken. Da gab es vom SETI Projekt ein entsprechendes Netzwerk zur Analyse der anfallenden Datensätzen.eastcoast_pete schrieb:ich frage mich dann auch, wieviel andere "Supercomputing" Aufgaben auf Crowd Basis angehbar sind;

Nein, da sich nur ein gewisses Subset an Problemen für solche Distributed Computingansätze eignen. Im Wesentlichen gibt es drei Anforderungen die erfüllt sein müssen=dantE= schrieb:Ich sehe es grundsätzlich als vielversprechender an, wenn man dezentral und unter Mitwirkung der „Bevölkerung“ derartige Projekte umsetzt. So ist die Sensibilisierung für derartige Themen einfacher.

Sorry, das ist bullshit.=dantE= schrieb:Allerdings ist der Aspekt der Skalierung und verlässlicher, zur Verfügung stehender Rechenleistung immer vom „Marketing“ abhängig, und funktioniert teilweise nur dadurch, dass man die Gemeinschaft mit öffentlichkeitswirksamen Maßnahmen wieder an Bord holt.

Viele sind eben nur kurzfristig dabei und der „Hype“ parkt nur kurzzeitig.

Damit habe ich mich auf Herangehenweisen wie Folding@Home bezogen.Skysnake schrieb:Sorry, das ist bullshit.

Was heißt da „Nein“ … es ist zwar nur unter bestimmten Vorraussetzungen ideal umsetzbar, und ja, zentral hat man weniger Aufwand, aber deshalb ist mein Ansatz/dieser Ansatz nicht falsch.Skysnake schrieb:Nein, da sich nur ein gewisses Subset an Problemen für solche Distributed Computingansätze eignen.

Naja, man bittet um Spenden. Ist doch klar das man da klappern muss und nicht zwingend etwas bekommt.=dantE= schrieb:Damit habe ich mich auf Herangehenweisen wie Folding@Home bezogen.

Dafür braucht man adäquate Mittel zur Bekanntmachung, ansonsten hast du zwar ein tolles Konzept, aber keiner macht mit.

Nein heißt nein. Es ist einfach im größtenTeil der Fälle einfach nicht sinnvoll.=dantE= schrieb:Was heißt da „Nein“ …

Die Voraussetzungen habe ich bereits genannt.=dantE= schrieb:es ist zwar nur unter bestimmten Vorraussetzungen ideal umsetzbar,

Ds geht es nen Dreck um den Aufqand. Es eignen sich einfach nur wenige Probleme für so 3einen Ansatz. Punkt...=dantE= schrieb:ja, zentral hat man weniger Aufwand, aber deshalb ist mein Ansatz/dieser Ansatz nicht falsch.

Nein ist es nicht...=dantE= schrieb:Alles nur eine Frage der Konzeption.

Weils nichts kostet und ihr Problem sich überhaupt für so einen Ansatz eignet.=dantE= schrieb:Was glaubst du warum man mit Folding@Home diesen Weg beschreitet, und nicht ausschließlich auf dedizierte, in Hallen stehende Cluster zurückgreift?

Und du bist der Mittelpunkt des Universums oder was möchtest du uns jetzt damit sagen ? Stempel es unter "Pech gehabt" ab.Spike Py schrieb:@MichaG könnt ihr mal bitte solche schwachsinnigen Click-Bait-Titel unterlassen? Ich will anhand des Titels erkennen können, ob der Artikel für mich relevant ist und nicht raten müssen, was damit gemeint sein könnte.