PCI-Express-Grafik: Hype oder nützlich?

PCI-Express - der Busstandard; wenn schon nicht für die Zukunft, so doch zumindest für die nächsten paar Jahre. Heiß und zumindest in Bezug auf Grafikkarten auch kontrovers diskutiert, nicht erst seit seiner Einführung durch Intel im Juni dieses Jahres. Im März konnten wir anläßlich der CeBit 2004 einen ersten kurzen Benchmark auf einem damals noch nicht öffentlich erhältlichen PCI-Express-System durchführen.

Dieser eine Benchmark, der die Rückkanal-Geschwindigkeit, mit der Daten aus dem Grafikkartenspeicher zurück in das Host-System ausgelesen werden können, misst, lief pikanterweise auf einer nVidia-PCI-Expresskarte, die bekanntlich über den sogenannten HSI-Bridge-Chip einen AGP-Grafikchip mit der PCI-Express-Schnittstelle auf dem Mainboard kommunizieren läßt und umgekehrt, um etwa 45-50% schneller als auf einem entsprechenden AGP-Modell.

Als dann das Marketinggetöse um die bevorstehende Einführung des neuen Standards mit Intels Vorstellung der Grantsdale und Alderwood-Chipsätze im Juni von den beiden Hauptverantwortlichen ATi und nVidia mit nahezu täglich neuen Pressemeldungen - wer von welchem Systemintegrator als Zulieferer der Wahl auserkoren wurde und wer wie eng mit Intel an der Validierung der Schnittstellen für sein jeweiliges Produkt zusammengearbeitet habe - ins schier unermeßliche gesteigert wurde, brachten auch wir im Rahmen unserer Berichterstattung zum Launch der neuen Intelchipsätze einen aktuellen und nicht mehr ganz so heimlich durchgeführten Durchlauf des 3D-Download-Benchmarks, in dem diesmal sowohl ATis als auch nVidias zu der Zeit als Sample verfügbare AGP- und PCI-Expresskarten gegeneinander antreten mussten, um die allüberall als Hauptvorzug beworbene Rückkanalgeschwindigkeit von PCI-Express zu veranschaulichen. Denn dass die im Vergleich zu AGP8X verdoppelte Upload-Geschwindigkeit von brutto rund 4 GB/s nicht viel mehr nutzen würde, als das schon als sinnlos gehypte AGP-Upgrade von vier- auf achtfache Geschwindigkeit, war von vornherein klar, so dass auch ATi und nVidia kaum versuchten, allein hierdurch großen Staat zu machen.

Wie nicht weiter verwunderlich, geriet in den Foren die Diskussion, ob der HSI-Chip, verbaut auf sämtlichen GeForce PCX-Modellen und auf der PCI-Express-Version der 6800 GT, von nVidia eine adäquate Nutzung von PCI-Express erlauben würde, oder ob allein ein natives Interface, wie es die X300/X600/X800-Chips von ATi aufweisen, dazu in der Lage sei, zusehens in eine heißere Phase.

Ein separater Chip, der das Protokoll umsetzt, stellt zweifelsohne eine mögliche Fehlerquelle dar, wie oftmals nahegelegt wird. Auf der anderen Seite stellt ein in den Grafikchip integriertes Interface eine ebenso mögliche Fehlerquelle dar, so die Argumente der anderen Seite und er würde die Produktion nur unnötig verteuern.

In einem seit nunmehr knapp sechs Wochen unkorrigierten Marketing-PDF über die Vorzüge von PCI-Express wird dann auch weiterhin der AGP-Bus fälschlich als bei 266 MB/s abgeschnitten bezeichnet, wie in der schon vorher für Furore sorgenden Save the Nanosecond-Präsentation, die ursprünglich mit Vortragsnotizen versehen ins Internet gelangte, in der ATi auf den Seiten 12 und 13 dringend von der Nutzung des AGP-Rückkanals abrät.

Nun kam uns aber in der letzten Woche gleich dreimal der inoffizielle, geleakte Forceware-Treiber 65.62 ins Blickfeld. Zuerst als ganz normale Newsmeldung mit ein paar Benchmarks, dann in einer ausführlicheren Betrachtung, wie die Performancegewinne zustande kommen und schließlich und endlich wurde entdeckt, dass dieser Treiber wohl schon Unterstützung für SLI mitbrachte.

Insbesondere letztere Tatsache hätte uns jedoch alarmieren müssen, dass nun endlich die PCI-Express Unterstützung so richtig ernsthaft in Angriff genommen worden ist - durch Zufall stießen wir jedoch heute auf folgende, interessante Tatsache:

Der 3D-Download-Benchmark von Serious Magic.com rendert in ein - der Videobearbeitung angepasstes - 720x480 Bildpunkte großes Fenster und liest den Inhalt des Fensters per Rückkanal wieder aus dem Grafikspeicher aus.

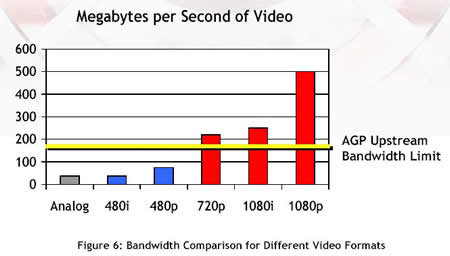

Dass der nV40-Chip zu einer weitaus höheren Rückkanal-Geschwindigkeit als den vermeintlich festgelegten 266 MB/s fähig war, ist schon seit einiger Zeit bekannt - jedoch wurde diese Fähigkeit bislang nur in OpenGL genutzt, wo auch die Konkurrenz in Form von 3Dlabs hohe Rückkanalbandbreiten bietet. Nun scheint es jedoch ernst zu werden und angesichts von deutlich mehr als 900 MB/s - was grob einer Steigerung von 450% entspricht - Rückkanalgeschwindigkeit, werden einige Punkte aus der PCI-Express-Werbung, wie beispielhaft in folgendem Bild zu bewundern, doch ein wenig fraglich.

Gut das vierfache dessen, was man dem AGP hier zutraut, sind also mit Willen und dem richtigen Treiber praktisch erreichbar - genug selbst für knapp zwei Streams der 1080er-progressive HDTV Auflösung.

So sind nämlich bislang die Abteilungen für Developer Relations sowohl bei ATi als auch bei nVidia damit beschäftigt gewesen, die Entwickler davon abzuhalten, den Rückkanal zu nutzen - bis also das offenkundig mögliche knappe Gigabyte (im FullScreen-Modus legt die Transferrate nochmals zu) an Busgeschwindigkeit in Richtung Grafikkarte -> Host-System auch nur annähernd ausgenutzt wird, werden sicher noch viele Flame-Wars ausgefochten, viele Marketing-PDFs erstellt und viele Terabyte an Daten über den vermeintlich langsamen AGP-Rückkanal geschoben werden.

Davon unabhängig verbleiben natürlich die anderen Vorteile, die PCI-Express bietet, wie zum Beispiel gleichzeitige Nutzung der Up- and Downstreams, deutlich geringere Latenzen usw., die aber in der Werbung kaum großartig herausgestellt werden - da war sie wieder, die Gier nach hohen Zahlen.

Pikantes Detail am Rande:

Am gestrigen Tage war sich die Marketing-Abteilung von nVidia nicht zu schade, darauf hinzuweisen, dass kalifornische GPUs bislang die einzigen seien, die auf der Liste der PCI-SIG stünden und somit offiziell als validiert für PCI-Express-Systeme gelten (was nicht heisst, dass andere Grafikkarten nicht in PCI-Express-Systemen ordentlich funktionieren).