Google I/O 2024: Neue Gemini-1.5-Modelle für den KI-Wettstreit mit OpenAI

Auf der Entwicklerkonferenz I/O 2024 hat Google eine Reihe neuer AI-Modelle vorgestellt. Das bisherige Spitzenmodell Gemini 1.5 Pro erhält lediglich ein Facelift, ist dafür aber sowohl über Gemini Advanced als auch für Entwickler verfügbar.

Vorgestellt hatte Google Gemini 1.5 Pro schon im Februar, weil noch Sicherheitstests liefen, war es zunächst nur für einen kleinen Kreis verfügbar. Das Upgrade zur Februar-Version umfasst Verbesserungen bei den zentralen Anwendungsgebieten wie Übersetzung, Programmieren oder Schlussfolgern.

Vergrößert wurde auch das Eingabefenster: Statt 1 Millionen Token – was schon die Konkurrenz mit rund 200.000 Token übertraf – kann es nun 2 Millionen Token verarbeiten. Bei Tokens handelt es sich im Kern um Wortbestandteile, die die Grundlage für die Wortgenerierung sind. Details dazu erklärt ComputerBase in einem Hintergrundbericht.

Gemini 1.5 Flash als effiziente Variante

Völlig neu ist hingegen Gemini 1.5 Flash als kleinere Variante. Vorteile bieten soll es bei der Effizienz. Laut DeepMind-Chef Demis Hassabis ist es für Aufgaben ausgelegt, bei denen eine große Anzahl von Anfragen verarbeitet werden muss. Wie zuvore die Pro-Variante kann es eine Kontext-Länge von bis zu 1 Millionen Token verarbeiten.

Gemini 1.5 Pro und Flash sind ab heute weltweit in einer Vorschauvariante verfügbar. Der allgemeine Start soll im Juni erfolgen. Gemini 1.5 Pro wird dann auch die Grundlage für Gemini Advanced sein – also die kostenpflichtige Variante von Googles AI-Chatbot.

Zusätzlich hat Google zwei neue Gemma-Modelle angekündigt. Das ist die Open-Source-Reihe des Konzerns. Das Gemini-Nano-Modell – also praktisch der Mobil-Ableger der Gemini-Reihe – beherrscht nun auch multimodale Funktionen, kann künftig neben Text also auch Bilder und Sprache verarbeiten.

Beim Bildgenerieren präsentiert Google mit Imagen 3 eine neue Version des Bildgenerators. Mit Veo kündigte Google zudem ein generatives Videomodell an, durch das sich Videos per Texteingabe generieren lassen. Man schließt somit die Lücke zu OpenAI mit Sora und Adobe.

Multimodal: Sprachsteuerung in Echtzeit

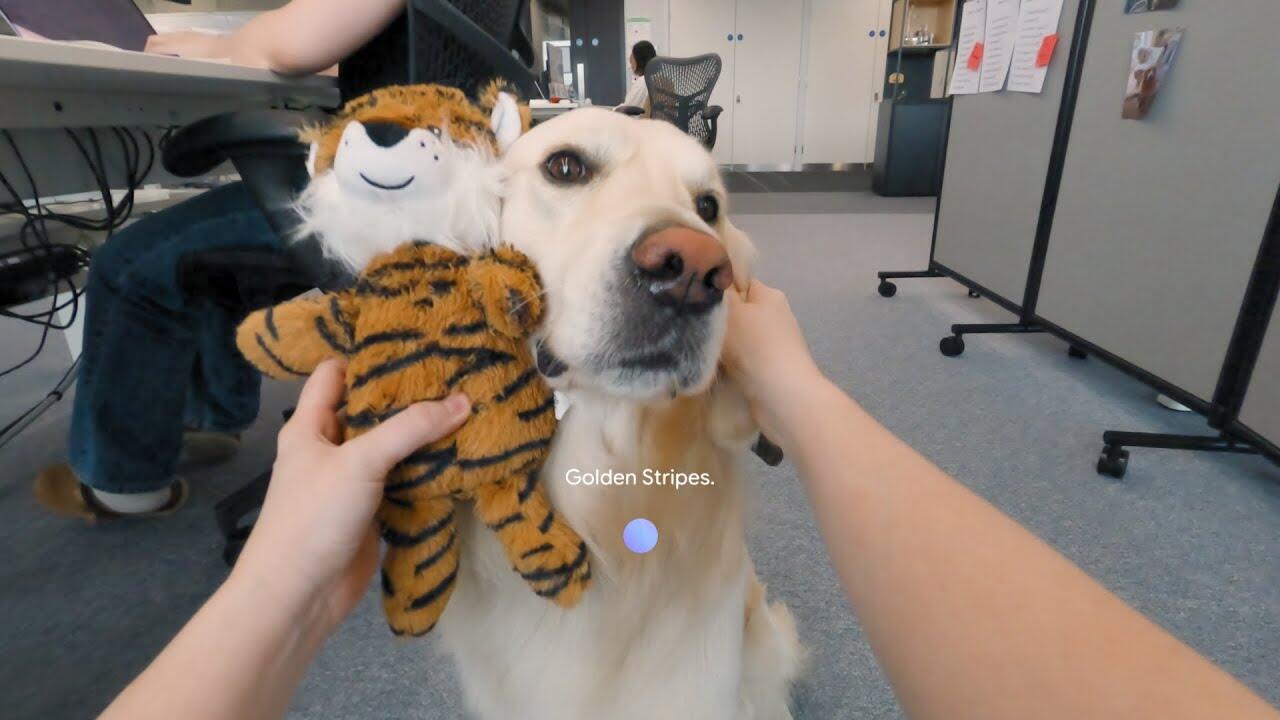

Multimodale Funktionen – also das Verarbeiten von Text, Bild und Sprache – stehen auch bei der I/O 2024 im Fokus. Wie OpenAI bei GPT-4o setzt auch Google auf einen verbesserten Sprachmodus mit einer Echtzeit-Videoverarbeitung, sodass Gemini sich zu einem AI-Assistenten entwickelt, der Sachen im Raum erkennen und darauf reagieren kann.

Diese Entwicklung verläuft bei Google unter dem Project Astra, das Hassabis als Agent-System angekündigt. Solche Systeme sind grundsätzlich eher in der Lage, selbst komplexe Aufgaben eigenständig zu erledigen. Für Hassabis ist dabei entscheidend, dass ein AI-Agent in der Lage ist, die Umwelt eigenständig wahrzunehmen und zu lernen. Reaktionszeiten seien zudem entscheidend, Nutzer sollen ohne Latenz mit dem Assistenten sprechen können.

Im Kern verfolgt Google damit dasselbe Ziel wie OpenAI mit GPT-4o, die Entwicklungen gehen in dieselbe Richtung. So wirkte auch der Inhalt eines Demo-Videos vertraut, der Inhalt ähnelte OpenAIs Spring-Update-Präsentation von Montagabend. Auffälliges Detail bei Google: Die Steuerung erfolgte nicht nur über das Smartphone, sondern auch eine Smart Glass.

Nichtsdestotrotz wirkt der Status bei Google noch wesentlich experimenteller als bei OpenAI. Teile der gezeigten Funktionen will Google im Verlauf des Jahres in die Google-Produkte sowie in Gemini integrieren.