Larrabee: Fakten zur Intel Highend-Grafikkarte

Es ist schon merkwürdig: Seit Monaten macht Intel mit seinem Larrabee-Projekt von sich reden, handfeste Details wurden jedoch nie bekannt. Bereits im August 2006 wurden Stellen für ein Projekt im Bereich der High Performance Graphics bei Intel ausgeschrieben.

Im Dezember 2006 folgten weitere Stellenausschreibungen, die das Larrabee-Projekt in den Themenbereich von AMDs Fusion rückten. Larrabee – so die Mutmaßungen – könnte als CPGPU (Central Processing/Graphics Processing Units) die Aufgaben von Hauptprozessor (CPU) und Grafikkarte (GPU) auf sich vereinen. Weiterhin wurde im Dezember klar, dass Larrabee unter der Flagge der neu gegründeten „Visual Computing Group“ (VCG) entwickelt würde.

Daneben war auch GPGPU (General-Purpose Graphics Processing Unit) ein großes Thema, da ATi und nVidia im September und November 2006 erkannten, dass ihre massiv-parallelen Grafikchips in vielen Bereichen modernen Prozessoren bei Weitem überlegen sind. Ein vereinfachter (nicht komplett korrekter) Vergleich: Intels Core 2 Duo kann (im Normalfall) pro Takt und Kern bis zu vier beliebige Befehle verarbeiten. nVidia GeForce 8800 GTX/Ultra erlaubt bei sehr speziellen Berechnungen (Multiply-Add, MADD) bis zu 128 parallele Verarbeitungen.

ATi (mittlerweile AMD) stellte deswegen spezielle Stream-Prozessoren (FireStream) vor. Hierbei handelt es sich eigentlich um normale Grafikkarten, die jedoch mit 1 GB Speicher ausgestattet waren. Außerdem wurden mit dem Catalyst 6.10 Programmierschnittstellen für Grafikkarten der Radeon X1-Generation (und mittlerweile auch der X2-Generation) freigegeben. Es folgten erste Anwendungen, wie z.B. Folding@Home, und auch die Beschleunigung von Physik-Berechnungen in Spielen ist bei ATI/AMD unter dem Titel CrossFire Physics weiterhin ein Thema. Außerdem hat AMD nicht grundlos unter dem Codenamen Hammerhead ein Mainboard mit RD790-Chipsatz in der Entwicklung, dass bei Bedarf bis zu vier Grafikkarten aufnehmen kann. Bei nVidia wurde das Thema GPGPU mit CUDA (Compute Unified Device Architecture) in Angriff genommen. Der passende C-Compiler war ebenfalls im Gepäck.

In Sachen Larrabee folgten weitere Gerüchte, die jedoch nicht viel Klarheit in das Thema brachten. Im April 2007 stolperten die Kollegen von Beyond3D über eine Intel-Präsentation, die sich mit dem Thema „Future CPU Architectures: The Shift From Traditional Models“ befasste und von Douglas Carmean, Chef-Architekt der Visual Computing Group (VCG), an verschiedenen Universitäten gehalten wurde. Primär ging es um das Thema GPGPU, mit interessanten – wie es schien – Gedankenexperimenten mit insgesamt 16 einfach gestrickten Prozessoren, von denen jeder pro Takt 4 Threads ausführten konnte.

Am 17. und 18. April wurde in Peking (Beijing) Intels jährlich mehrmals stattfindendes Intel Developer Forum abgehalten. Auch ComputerBase war vor Ort um die Ankündigungen live zu verfolgen. Niemand geringeres als Patrick „Pat“ Gelsinger, Senior Vice President und General Manager der Intel Digital Enterprise Group hat sich dem Thema Larrabee in seiner Keynote angenommen. Demnach soll Larrabee mit „IA++“-Kernen bestückt sein, die für wissenschaftliches Rechnen, Visualisierungen oder andere Anwendungen im Bereich Gesundheit und Analyse angesiedelt sind. Larrabee, eine Grafikkarte? Aufgrund der Auflistung irgendwie nur eine Randerscheinung im Bereich „Visualisierungen“. Er gab außerdem an, dass die Performance im Teraflop-Bereich liegen würde. Die Vorstellung kann man im Webcast von Pat ab Minute 54 Revue passieren lassen. (Seite im Internet Explorer öffnen)

Wo stehen wir heute? Details über Larrabee sind weiterhin unklar und Intel sucht unvermindert Verstärkung im Bereich der Grafikentwicklung – entweder auf externen Webseiten wie Careerbuilder oder auf seiner eigenen Webseite, wie z.B. die folgende:

Intel's Visual Computing Group is seeking Graphics System Architects in all aspects of graphics development. This includes component architecture, micro-architecture and performance simulation development. In this position, you will be helping to drive requirements for hardware interfaces and influence the software architecture and execution direction.

Was nun folgt, ist eher ungewöhnlich: Seit Monaten ist das versammelte Internet auf der Suche nach Informationen über Larrabee. Urplötzlich taucht nun eine Präsentation von einem im Dezember 2006 in Florida abgehaltenen Workshop auf, in der Ed Davis, Chief Architect bei Intel, nicht nur im Detail über Larrabee spricht, sondern auch wichtige Eckdaten zu Gesher, dem Nachfolger des Nachfolgers (Westmere) des Nachfolgers (Nehalem) des Nachfolgers (Penryn) des derzeit aktuellen Core 2 Duo (Merom) nennt.

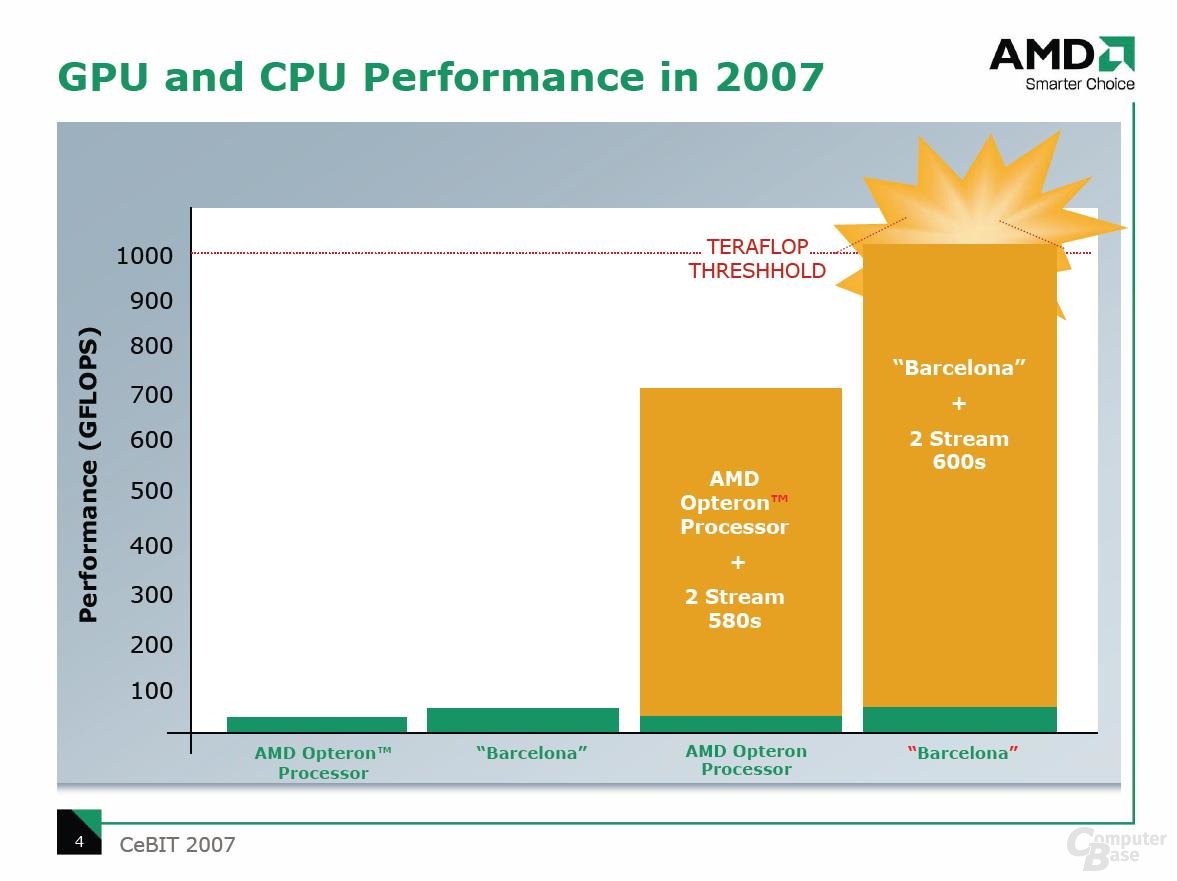

Was ist Larrabee wirklich? Larrabee ist der Grafikchip einer Highend-Grafikkarte, der als GPGPU auch für andere Berechnungen eingesetzt werden kann. Er besitzt 16 einfach gestrickte In-Order-Kerne, von denen jeder 4 Threads parallel verarbeiten kann – die Präsentation von Beyond3D war also kein Gedankenexperiment. Das Ganze verbraucht bei einem Takt von 2 GHz ca. 150 Watt und bietet eine Leistung von einem Teraflop. Der Grafikchip ist somit nicht nur sparsamer als ATis R600 (Radeon HD 2900 XT, bis 215 Watt), sondern bietet dabei auch noch die doppelte Performance. AMD hatte Anfang des Jahres ein System mit zwei R600-Grafikkarten und einem Barcelona-Prozessor gezeigt und dabei eine Leistung von 1 Teraflop erreicht (siehe Grafik). Auch nVidias G92 soll die 1 Teraflop-Marke knacken. Laut Spekulationen soll es sich hierbei jedoch um eine Dual-Chip-Lösung nach dem Vorbild der GeForce 7950 GX2 handeln.

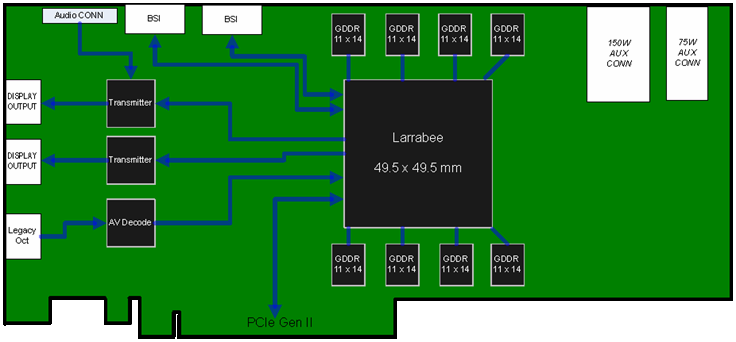

Intel schafft diese Leistung bei Larrabee mit nur einem und dabei vollständig programmierbaren Chip. Jeder der 16 Kerne verfügt laut Präsentation über einen 32 KB großen L1- und einen 256 KB großen L2-Cache. Außerdem sind zwei Speichercontroller für GDDR (GDDR5?) mit einer Gesamtbandbreite von 128 GB/s integriert. Der Grafikspeicher soll eine Größe zwischen 1 und 2 GB haben. In der Präsentation versteckt sich eine Prinzipskizze der Grafikkarte, die sich mit geeigneten Tools extrahieren lässt. Demnach handelt es sich um eine PCI Express Gen 2-Lösung, die zwei Stromanschlüsse besitzt. Der ganze Chip ist einem 24,5 cm² großen Package untergebracht. Setzt man die Länge der ganzen Grafikkarte ins Verhältnis zur Länge des PCI Express-Steckplatzes ergibt sich, dass Larrabee auf einem 28 cm langen Board untergebracht wird (Zum Vergleich: Radeon HD 2900 XT (R600) – 24,1 cm, GeForce 8800 GTX (G80) – 28 cm).

In seiner Präsentation stellt Ed Davis unter dem Thema „Hypothetical Solution: HPC Platform Building Blocks“ außerdem vor, wie Larrabee in eine Lösung für High-Performance-Computing verwandelt werden kann. Dabei werden vier Larrabee-Prozessoren über CSI (mit einer Bandbreite von 17 GB/s) miteinander verbundenen. Jeder Larrabee-Chip verfügt in diesem Szenario über seinen eigenen Speicher, der mit einer Bandbreite von 20 bis 50 GB/s angebunden ist.

Auch der Vergleich von Larrabee und Gesher (heißt inzwischen Sandy Bridge) ist interessant. Mit Gesher nimmt Intel wieder die 4 GHz-Marke in Angriff. Eigentlich hätte der Pentium 4 mit Prescott-Kern diese Marke nehmen sollen. Das Produkt wurde aufgrund des Stromverbrauchs zu Gunsten von Mehrkern-Prozessoren jedoch eingestellt. Gesher verfügt über 4 bis 8 Kerne. Neben einem 32 kB großen L1-, 512 kB großen L2- gibt es einen 2 bis 3 MB großen L3-Cache. Offenbar hält auch eine vierte Cache-Hierarchie Einzug, wie Intel erst kürzlich im Rahmen des Microprocessor Forum kürzlich andeutete. Hierbei handelt es sich scheinbar um FastDRAM mit einer Größe von bis zu 512 MB.

Larrabee bietet eine theoretische Leistung von 0,2 bis 1,0 Teraflop bei doppelter Genauigkeit (64 Bit). Gesher bringt es nur auf 0,1 bis 0,2 Teraflop. Laut The Inquirer könnte Larrabee als fertiges Produkt Ende 2008 zur Verfügung stehen und tritt damit vermutlich gegen nVidia G100 und ATi R800 an.