IBM entwickelt „denkende“ Computerchips

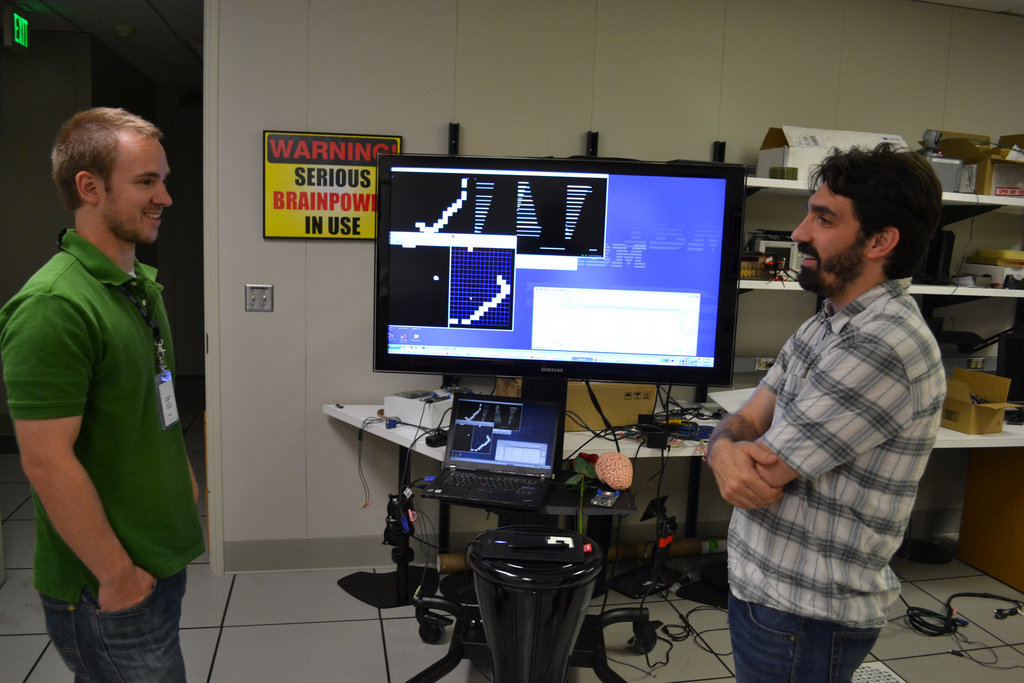

Forscher aus dem kalifornischen IBM Research Center in Almaden haben erstmals Prototypen einer neuartigen Klasse von Computerchips vorgestellt, die die Fähigkeiten des menschlichen Gehirns hinsichtlich Wahrnehmung, Kognition und Reaktion in Grundzügen nachahmen.

Der als Basis für die Forschungsarbeiten dienende Ansatz lautet „Cognitive Computing" und könnte in den Augen der Forscher zukünftig die Herstellung von lernenden Computern ermöglichen, die zudem um ein Vielfaches effizienter und kleiner werden könnten als heutige Systeme.

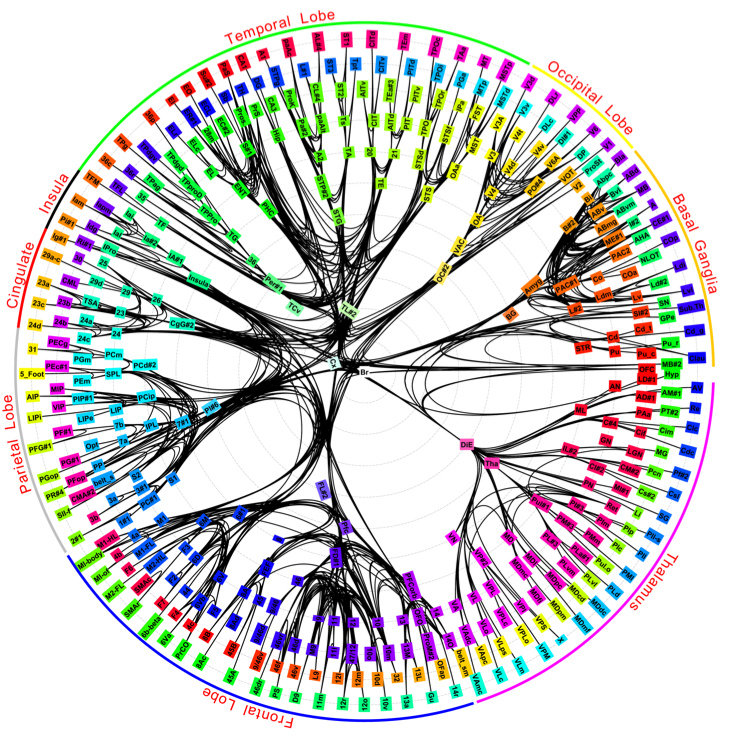

Das Gehirn als Vorbild

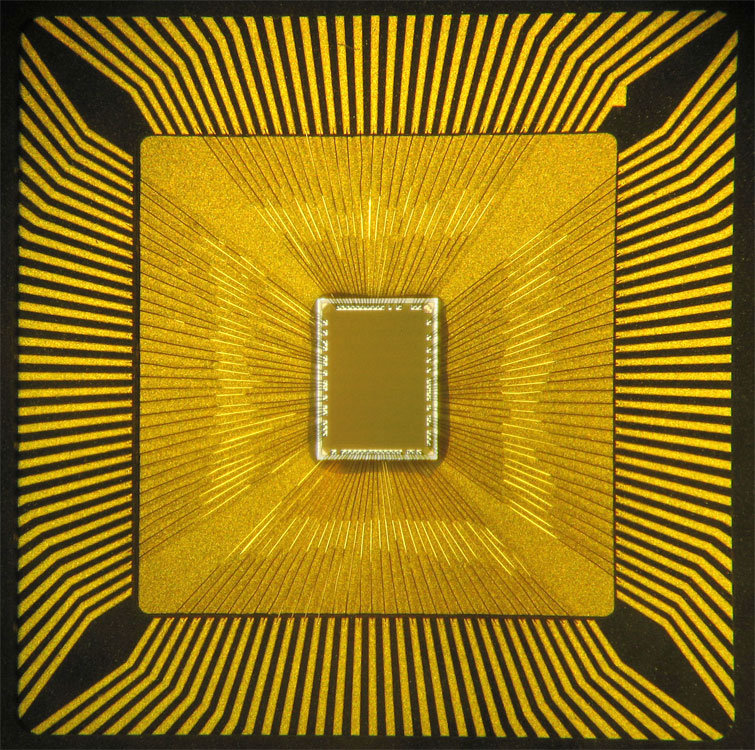

Die von den Forschern vorgestellten neurosynaptischen Computerchips enthalten Silizium-Schaltkreise und Algorithmen, deren Aufbau der Neurobiologie entnommen sind und dem sogenannten „Neuroynaptischen Kern“ ähnliche Abläufe ermöglichen, wie sie zwischen Neuronen und Synapsen im Gehirn auftreten. Der integrierte Speicher bildet die Synapsen des Gehirns nach, die Recheneinheiten die Neuronen und die Kommunikationswege die Axonen.

Systeme, die auf dieser neuartigen Technologie basieren, bilden mit einem Netzwerk vieler kleiner Kerne in einem integrierten System eine Abkehr von der seit über einem halben Jahrhundert geltenden, sogenannten Von-Neumann-Architektur, nach der die meisten heute verwendeten Computer aufgebaut sind und der zufolge ein Computer aus Rechen-, Steuer-, Eingabe- und Ausgabeeinheit sowie einem Arbeitsspeicher besteht und von definierten Programmen und Instruktionen abhängt, um Aufgaben durchzuführen, die Schritt für Schritt abgearbeitet werden. In der Architektur von kognitiven IT-Systemen verschmilzt die Grenze zwischen Hard- und Software. Darauf aufbauende Computer werden nicht wie heute üblich programmiert, sondern sollen durch Erfahrung lernen, Korrelationen finden, Hypothesen zu bilden und sich Ergebnisse zu merken und aus ihnen zu lernen. Auf diese Weise ahmen sie die strukturelle und synaptische Plastizität des menschlichen Gehirns nach.

Die ersten Testchips arbeiten bereits

Zwei erste Prototypen wurden bereits gefertigt und befinden sich derzeit in der Testphase. Beide Prozessorkerne wurden in einem 45-nm-SOI-CMOS-Prozess in IBMs Halbleiterwerk in Fishkill, N.Y. hergestellt und enthalten 256 Neuronen. Ein Testchip enthält 262.144 programmierbare Synapsen, der andere 65.536 lernende Synapsen. Das IBM-Team konnte damit bereits einfache Anwendungen wie Navigation, maschinelles Sehen, Mustererkennung, sowie assoziative Speicherung und Klassifizierung demonstrieren.

Bei der Entwicklung der Chips, die Teil der mehrjährigen Forschungsinitiative SyNAPSE (Systems of Neuromorphic Adaptive Plastic Scalable Electronics) ist, wurden Erkenntnisse und Wissen aus der Nano- sowie Neurowissenschaft und dem Supercomputing eingebracht. IBM und eine Reihe US-amerikanischer Universitäten haben zudem für die zweite Phase des SyNAPSE-Projektes Unterstützung in Höhe von 21 Millionen US-Dollar von der DARPA erhalten, der Forschungs-Behörde des amerikanischen Verteidigungsministeriums.

Computer sollen lernen und sich anpassen

Das Ziel von SyNAPSE ist es, ein Computersystem zu entwickeln, das nicht nur verschiedenartige sensorische Eingangsdaten gleichzeitig analysiert, sondern sich auch auf Basis seiner Interaktion mit der Umwelt dynamisch neu verdrahtet. Zudem gehe es darum, ein System mit dem geringen Energieverbrauch und Volumen des menschlichen Gehirns zu entwickeln. Längerfristig möchten die IBM Forscher ein System mit 10 Milliarden (10^10) Neuronen und 100 Billionen (10^14) Synapsen realisieren, das weniger als 1 Kilowatt Energie verbraucht und ein Volumen von weniger als 2 Litern aufweist.

Ideal für die Verarbeitung großer Mengen Echtzeitdaten

Zukünftige Computersysteme dieser Art könnten beispielsweise zur Überwachung der weltweiten Wasserversorgung und der Ozeane eingesetzt werden und ein Netzwerk von Sensoren und Aktuatoren umfassen, die Daten zu Temperatur, Druck, Wellenhöhe, Schallsignalen und Gezeiten erfassen und gegebenenfalls schnell Warnungen vor Tsunamis oder anderen Problemen ausgeben. Prinzipielle Vorteile sollen sich wie im eben beschriebenen Beispiel also vor allem dann ergeben, wenn es um die schnelle Verarbeitung großer Mengen von sich schnell ändernden Echtzeitdaten geht, für die heutige Computersysteme nicht ideal sind.