Nvidia GeForce GTX Titan im Test: Schnellste Grafikkarte mit großem Namen

3/22GPU Boost 2.0

GPU-Taktrate? Auf diese sind wir bis jetzt bewusst nicht eingegangen. Nvidia hat mit der Kepler-Generation erstmals einen Turbo-Modus namens „GPU Boost“ eingeführt und die GeForce GTX Titan ist mit der verbesserten Version namens „GPU Boost 2.0“ ausgestattet. Der „Base“-Takt der GeForce GTX Titan liegt bei 837 MHz – diesen soll die Grafikkarte unter jeden Umständen halten können.

Zusätzlich gibt es noch den „Boost Clock“, der bei 876 MHz liegt. Jedoch hat die Zahl keine echte Aussagekraft, denn dabei handelt es sich nur um einen Wert, den die Grafikkarte im Durchschnitt schaffen soll. Meistens wird die Frequenz aber weit darüber liegen, sodass auch 1.000 MHz und mehr keine Seltenheit sind.

Ein alter (wichtiger) bekannter ist das sogenannte Power Target. Denn dieses legt schlussendlich fest, wie hoch die Grafikkarte sich selber übertaktet. Das Power Target (Standard: 100 Prozent) bezieht sich auf die Leistungsaufnahme, sodass die GeForce GTX Titan bei der Standardeinstellung versucht, auf 250 Watt zu kommen (Power Target 100 Prozent entspricht bei Titan der TDP). Ist noch Luft nach oben, können die Taktraten und Spannungen in einem gewissen Rahmen weiter erhöht werden. Liegt die Karte über dem Limit, werden diese verringert.

So weit ist also alles beim Alten geblieben. GPU Boost 2.0, das exklusiv auf der GeForce GTX Titan eingesetzt wird, verfügt darüber hinaus aber über kleinere Verbesserungen. Der Algorithmus achtet nämlich nicht nur auf das Power Target, sondern auch auf die GPU-Temperatur, wodurch zu hohe Temperaturen verhindert und die Lebensspanne erhöht werden soll – dies spielt vor allem bei Multi-GPU-Systemen eine Rolle.

Die Nvidia GeForce GTX Titan ist mit einem Lüfterprofil programmiert, die GPU-Temperatur bei 80 Grad Celsius zu halten. Ist der Rechenkern kälter und das Power Target noch nicht erreicht, wird die Taktrate und die Spannung erhöht. Erhitzt sich der GK110 dann auf über 80 Grad, versucht die GeForce GTX Titan dies mit einer höheren Lüfterdrehzahl und geringeren Taktraten sowie Spannungen zu kompensieren, um erneut die 80 Grad-Marke zu erreichen.

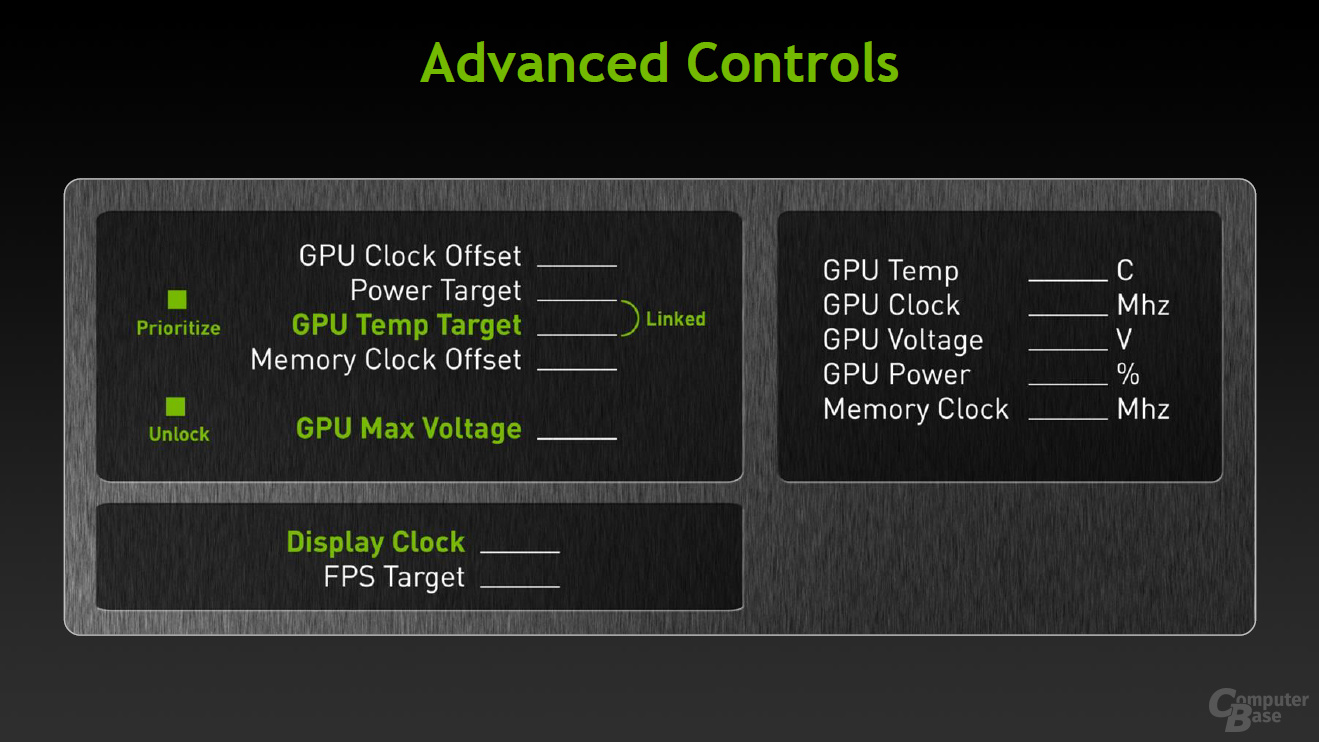

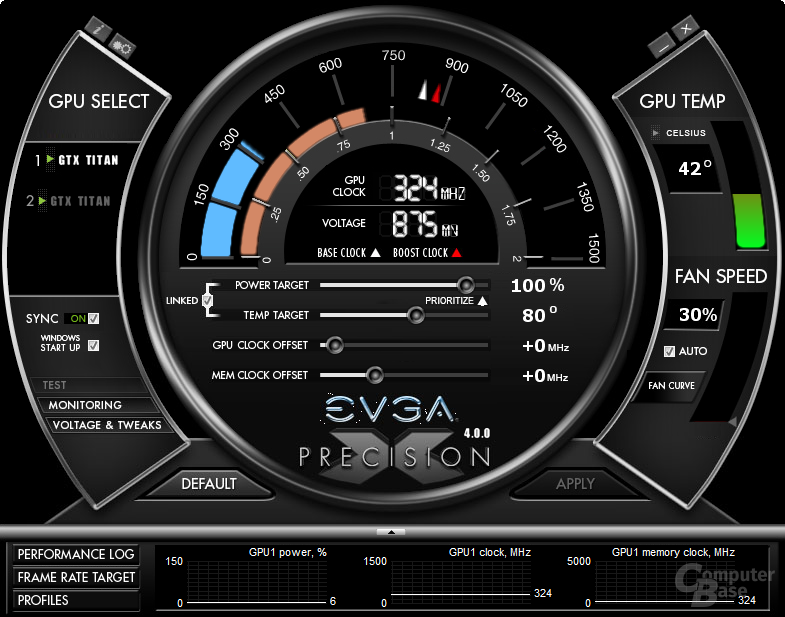

Nvidia gibt dem Käufer erneut einige Möglichkeiten, den Turbo-Modus zu beeinflussen. Dazu ist es nötig, externe Tools wie EVGAs „Precision X“ zu installieren. Nicht neu ist die Möglichkeit, das Power Target selbst zu verändern. Dieses kann verringert oder um bis zu sechs Prozent erhöht werden (106 Prozent: 265 Watt), sodass die Karte den Takt weiter erhöhen oder länger auf einem Niveau halten kann.

Zusätzlich gibt es die bei (fast) allen Grafikkarten vorhandene Möglichkeit, die Lüfterkurve zu verändern. Wem die GeForce GTX Titan zu laut ist, der kann entsprechend das Profil anpassen, um bei identischen Temperaturen einen leiseren Betrieb zu ermöglichen. Da der 3D-Beschleuniger versuchen wird, die Grafikkarte bei 80 Grad Celsius zu halten, wird automatisch der Boost geringer ausfallen.

Mit Titan kommt ein neuer Regler zum Einsatz, mit dessen Hilfe es möglich ist, die Zieltemperatur zu verändern. Die voreingestellten 80 Grad lassen sich dann zum Beispiel auf 85 Grad Celsius erhöhen, sodass der GPU-Boost effektiver mit der veränderten Lüftersteuerung agieren kann. Maximal können 95 Grad Celsius als Zieltemperatur eingestellt werden. Alternativ lässt sich eine höhere Temperatur ohne veränderte Lüfterkurve nutzen, sodass die Grafikkarte beim Erreichen der 80 Grad zwar den Lüfter schneller drehen lässt, aber die Taktraten noch nicht verringert. Darüber hinaus kann der Benutzer die Priorität entweder auf das Power Target oder auf die Temperatur legen, sodass der andere Faktor nur die zweite Geige spielt.

Nvidia hat auch bei den anliegenden Spannungen Modifizierungen vorgenommen. So liegt die Maximalspannung bei den bisherigen Kepler-Karten bei 1,162 Volt. Dies ist bei der GeForce GTX Titan nicht anders, jedoch lässt sich die Spannung in externen Tools auf bis zu 1,2 Volt erhöhen. Dies muss vom Hersteller der Partnerkarte erlaubt werden und kann dementsprechend genauso auch verboten werden und es muss zudem ein Warnhinweis auf eine verringerte Lebensdauer akzeptiert werden. Ferner wird es den Partnern möglich sein, höhere Werte als 1,2 Volt anzustreben – diese müssen aber mit Nvidia vereinbart werden.

Durch die Verbesserungen bei GPU Boost 2.0, die primär per Software realisiert worden sind, will Nvidia die Performance um drei bis sieben Prozent gegenüber GPU Boost 1.0 verbessert haben.