Project Soli: Google erforscht Fingergesten-Erkennung per Radar

Systeme zur Gestenerkennung nutzen in der Regel Kameras, Datenhandschuhe oder Wisch-Eingaben auf Touchscreens. Ideal ist keine dieser Varianten, sei es aufgrund des Aufwands oder der Präzision. Eine für die Nutzer unkomplizierte und hochpräzise Methode könnte die Gestenerkennung mittels Radarwellen sein, an der Google forscht.

Project Soli ist Teil der Advanced Technology and Projects Group (ATAP) bei Google, die unter anderem auch an Project Tango arbeitet. Ziel des Projektes ist es, eine kompakte, präzise und leistungsfähige Lösung zur Erkennung von Fingergesten zu entwickeln, die der Schnelligkeit und Präzision gewachsen ist, mit der der Mensch seine Hand nutzen kann.

Der Einsatz von Radarwellen hat gleich mehrere Vorteile. Sie erlauben nicht nur eine sehr genaue Positionsbestimmung, sondern auch eine sehr hohe Abtastrate. Im Prinzip funktioniert dies wie bei einem großen Radargerät, das beispielsweise zur Überwachung des Luftraums oder mittlerweile – in kleinerer Form – auch in Autos eingesetzt wird. Das Gerät sendet Radiowellen aus, berechnet anhand der vom Objekt zurückgeworfenen Radiowellen die genaue Position des Objekts, von dem das Signal zurückgeworfen wurde, und lässt beispielsweise auch Rückschlüsse zur Größe und Form zu.

Im Falle von Project Soli berechnet eine mehrstufige Pipeline zur Gestenerkennung aus dem Radarecho alle nötigen Informationen zur Bewegung und Position der Finger. Eine Möglichkeit, wie die Informationen schließlich zur Steuerung von Elektronik genutzt werden können, sind sogenannte virtuelle Werkzeuge, die sich an den Bewegungen orientieren, die der Mensch bei der Bedienung physischer Steuerelemente ausführt.

Dies kann zum Beispiel der Dreh- oder Schiebeschalter zur Lautstärkeregelung sein, oder aber auch das Drücken eines Knopfes zwischen Daumen und Zeigefinger und das Nachahmen einer Trackpad-Bewegung mit dem Daumen auf der Seitenfläche des Zeigefingers. All diese Bewegungen sind sehr spezifisch und können zur Steuerung verschiedenster Geräte genutzt werden. In einem Video demonstrieren die Forscher, wie dies im Falle einer Smartwatch und eines Radios aussehen könnte.

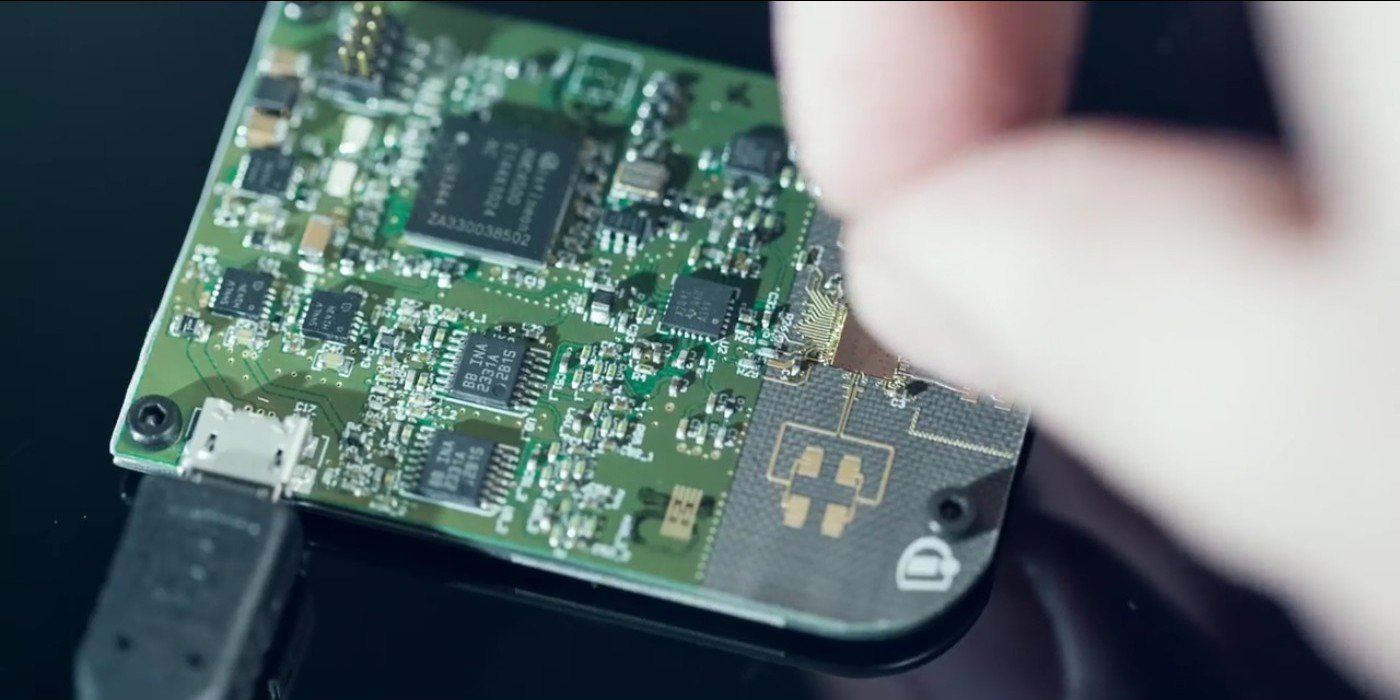

Die nötige Technik passt auf einen kleinen Siliziumchip, der in den meisten Elektronikgeräten Platz hätte. Projektgründer Ivan Poupyrev verspricht eine hohe Zuverlässigkeit, da keine beweglichen Teile, Linsen oder dergleichen notwendig sind. Da Radiowellen langwellige elektromagnetische Wellen sind, können sie sich durch viele Materialien hindurch ausbreiten, sodass der Radar-Chip gut geschützt im Inneren eines Gerätes platziert werden kann.

Jetzt, da der Radar-Chip und die grundlegende Technik entwickelt wurden, soll in einem nächsten Schritt erprobt werden, wie gut die Gestenerkennung in der Praxis zur Steuerung von Elektronik funktioniert. Zudem ist angedacht, Project Soli auch der Entwicklergemeinde zur Verfügung zu stellen, um zu sehen, wie diese die Technik verwendet. Bis es die ersten fertigen Produkte auf Basis von Project Soli gibt, wird es also noch ein wenig dauern.

- Google Fotos: Fotodienst speichert Bilder trotz Deinstallation der App

- Project Soli: Google erforscht Fingergesten-Erkennung per Radar

- Google Project Tango: Neues Entwickler-Smartphone mit Snapdragon 810

- +15 weitere News