Analyse: Facebooks Kampf mit der Wahrheit

3/3Filterblasen: „We have just one world, but we live in different ones“

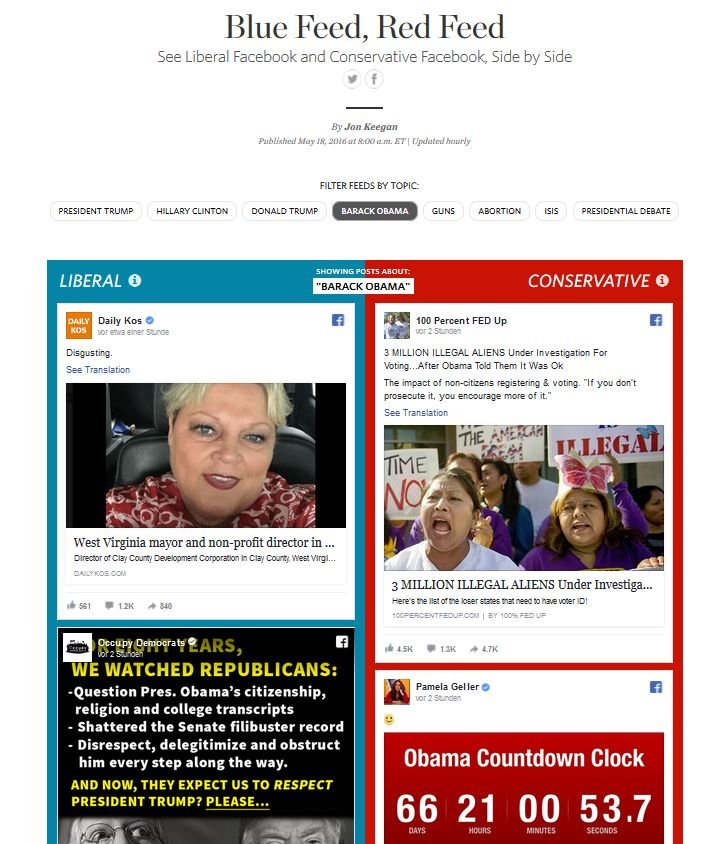

Noch schwieriger wird es, wenn es nicht nur um das Identifizieren von Falschmeldungen geht, sondern um die Konsequenzen für die Nutzer. Die Rede ist von den Filterblasen, ein Effekt, vor dem Informatiker und Soziologen ohnehin schon seit Jahren warnen. Das Konzept besagt: Wenn Nutzer erst einmal in einer solchen Blase gefangen sind, erhalten sie nur noch die Informationen, die ihr Weltbild untermauern. Widersprüche und abweichende Meinungen kommen nicht mehr vor. Die sozialen Netzwerke sind dafür besonders anfällig, denn die Algorithmen sind darauf ausgelegt, den Nutzern am besten nur die Inhalte zu präsentieren, die sie auch interessieren. Wie das dann in der Praxis aussehen kann, visualisierte das Wall Street Journal bereits im Mai.

Das Resultat ist irritierend wie erschreckend, denn bei jedem Thema unterscheiden sich die Meldungen vollends, die in dem liberalen und konservativen News-Feed auftauchen. Wer wissen will, wieso einige Menschen bei bestimmten Themen so komplett unterschiedliche Haltungen einnehmen, bekommt einen Hinweis. Allerdings handelt es sich hierbei auch um die Ränder des politischen Spektrums. Die Frage ist nun: Sind die Filterblasen tatsächlich so gravierend? Eine Antwort lässt sich nicht so leicht finden, vieles hängt vom individuellen Verhalten der Nutzer ab, was die Sache umso schwieriger macht.

Bei Facebook selbst beschwichtigt man. Angesprochen auf die Filterblasen, erklärte Zuckerberg bei der Technonomy-Konferenz zunächst allgemein: Grundsätzlich ist der News-Feed eines der wichtigsten Produkte von Facebook. Denn der Algorithmus entscheidet, was die Nutzer zu Gesicht bekommen, wenn sie das soziale Netzwerk aufrufen – und entscheidet damit auch, wie zufrieden sie sind. „Wir entwickeln den News-Feed, damit Leute die Dinge sehen, die für sie am bedeutsamsten sind“, so Zuckerberg.

Der Haken ist nur: Erhalten Nutzer nur Informationen, die für sie am bedeutsamsten sind, handelt es sich dabei nicht unbedingt um eine ausgewogenen Berichterstattung. Zuckerberg selbst erklärt nun, dass Nachrichten ohnehin nicht der wichtigste Part sind. Das wären eher private Dinge, weil Leute das soziale Netzwerk nutzen, um sich mit Freunden und der Familie auszutauschen. Nichtsdestotrotz ist Facebook mittlerweile aber eine der zentralen Anlaufstelle für Nachrichten, 44 Prozent der Amerikaner nutzen das soziale Netzwerk mittlerweile als Nachrichtenquelle, wie eine Studie von Pew Research zeigt.

Dass Facebook nun Filterblasen fördert, bestreitet Zuckerberg allerdings. Eher wäre das Gegenteil der Fall: Soziale Medien wie Facebook würden dazu beitragen, dass Nutzer mit deutlich mehr Beiträgen konfrontiert werden, die von der eigenen politischen Haltung abweichen, als es noch im Zeitalter von Zeitungen und wenigen TV-Sendern der Fall war. Es stimme zwar, dass die meisten mit Leuten befreundet sind, die denselben politischen Hintergrund teilen. Doch es gebe immer welche, die einen anderen Standpunkt vertreten. Und diese sorgen dafür, dass sich das Meinungsspektrum erweitert. Dabei verweist Zuckerberg auf eine Studie, die Facebook-Mitarbeiter 2015 im Science-Magazin veröffentlicht haben. Diese besagte zunächst, dass der News-Feed nur rund ein Prozentpunkt Artikel aussortiert, die Liberale und Konservative im News-Feed angezeigt bekommen.

Facebooks „Es-ist-nicht-unsere-Schuld“-Studie

Die Studie ist allerdings höchst umstritten. Christian Sandvig, Professor an der University of Michigan, bezeichnet sie etwa als Facebooks „Es-ist-nicht-unsere-Schuld“-Studie. Einer der zentralen Probleme ist demnach, dass nicht unabhängige Forscher die Daten ausgewertet haben, sondern Facebook-Mitarbeiter. Hinzu kommt: Die Basis sind zwar die Aktivitäten von mehr als 10 Millionen Nutzern, dabei handele es sich aber nur um solche, die explizit eine politische Ideologie im Profil angeben – also etwa Liberal oder Konservativ. Aussagen über die Allgemeinheit lassen sich damit also nicht treffen.

Neben der Datenbasis ist es zudem die Interpretation der Ergebnisse, die andere Forscher anzweifeln. Denn im Kern bestätigt auch diese Studie, dass der Algorithmus Inhalte aussortiert, die nicht der eigenen Haltung entsprechen. Eine wichtige Rolle spielt zudem noch die Position, die Inhalte im News-Feed einnehmen. Wie schon bei den Ergebnislisten in Suchmaschinen gilt: Angeklickt wird, was ganz oben steht. Was weiter unten auftaucht, registrieren hingegen nur Wenige. Selbst wenn der Algorithmus also bestimmte Inhalte nicht herausfiltert, bestimmt das Ranking im News-Feed die Wahrscheinlichkeit, ob Nutzer ein Nutzer bestimmte Inhalte wahrnimmt.

Wenn der Algorithmus nicht filtert, macht es der eigene Kopf

Produzieren soziale Netzwerke wie Facebook also Filterblasen? Wenn man noch weitere Studien wie die von den Universitäten Oxford und Stanford (PDF) anschaut, ist die Antwort ein vorsichtiges Ja. Vorsichtig, weil die Ergebnisse stets nur moderat ausfallen und sich auch nicht ohne Weiteres verallgemeinern lassen, da auch die Nutzer eine entscheidende Rolle spielen. Denn Viele sorgen schon bei der Auswahl der Nachrichtenquellen selbst dafür, dass sie überwiegend nur Artikel sehen, die der eigenen Haltung entsprechen.

„Ich weiß nicht, wie wir damit umgehen sollen.“ Mark Zuckerberg

Unterstützt wird das noch durch einen Effekt, der in der Psychologie als Confirmation Bias bekannt ist. Menschen tendieren dazu, ihre bestehenden Ansichten nicht zu hinterfragen, sondern zu bestätigen. Im Falle von Facebook heißt das also, dass Nutzer zwar die Überschriften sehen, aber nicht klicken. Was nicht in das eigene Weltbild passt, wird ausgeblendet – eine Filterblase im Kopf.

Es ist also ein Problem, dass sich nicht durch einen angepassten Algorithmus lösen lässt. Selbst der Facebook-Chef wirkt da ratlos. „Ich weiß nicht, wie wir damit umgehen sollen“, so Zuckerberg. Was letztlich aber auch eine Aussage ist, die das Dilemma um Falschmeldungen und Filterblasen recht akkurat beschreibt.

Dieser Artikel war interessant, hilfreich oder beides? Die Redaktion freut sich über jede Unterstützung durch ComputerBase Pro und deaktivierte Werbeblocker. Mehr zum Thema Anzeigen auf ComputerBase.