HPE The Machine: Künftig dreht sich alles um den Speicher, nicht die CPU

Hewlett Packard Enterprise (HPE) macht Fortschritte beim Forschungsprojekt The Machine. Auf den funktionalen Prototyp folgen weitere Pläne. Ziel ist es, eine neue Computer-Architektur mit einem gemeinsam genutzten einheitlichen Universalspeicher zu schaffen und den Flaschenhals der Speicherhierarchie zu eliminieren.

Der Prozessor als zentrale Einheit heutiger Systeme ist von Speicherklassen unterschiedlichster Geschwindigkeiten umringt. Die verschiedenen Speicherhierarchien sind wie Treppenstufen, die den Datenfluss und damit auch die Leistung bremsen. Prozessoren müssen allein für den ständigen Datentransfer von einer in die andere Speicherstufe, zum Beispiel vom schnellen RAM auf die langsamere HDD/SSD und zurück, viel Rechenzeit aufbringen.

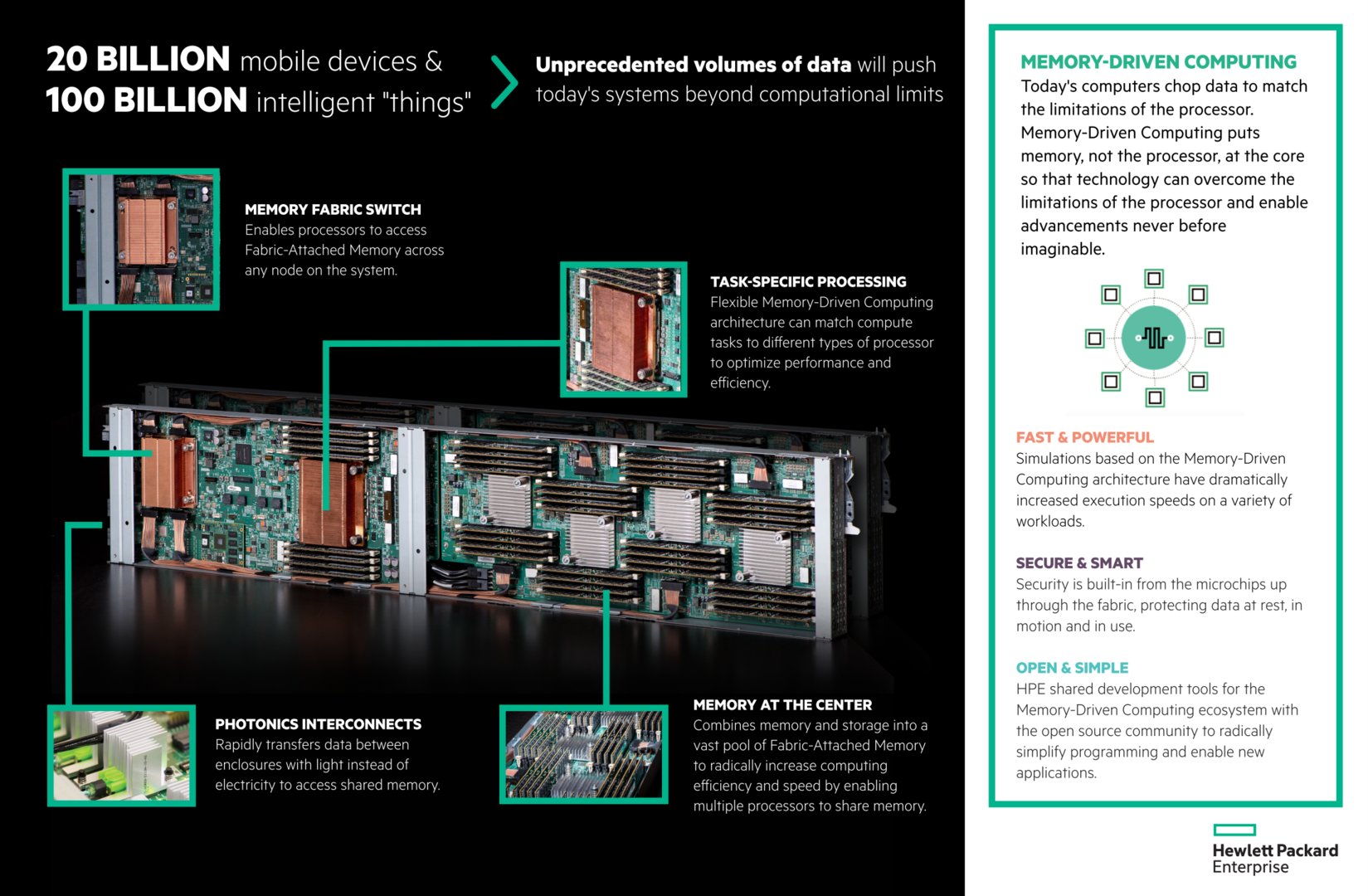

Beim Forschungsprojekt The Machine rückt HPE statt Prozessoren den Speicher in den Mittelpunkt und schafft die Speicherhierarchien ab. Ein großer und für alle Komponenten zugänglicher Universalspeicher spielt dabei die zentrale Rolle. Das Prinzip wird Memory-Driven Computing (Speicher getriebenes Rechnen) genannt.

Universalspeicher, Fabric und Photonics

Nachdem HPE Ende Oktober erstmals die Funktion des Konzepts unter Beweis stellen konnte, wurde auf der Discover-Konferenz ein Prototyp als Konzeptstudie gezeigt. Auf einer Platine sind vier Speichercontroller mit jeweils 1 TByte DRAM untergebracht. Über ein Fabric ist die Platine mit einem weiteren PCB verbunden, das einen ARM-basierten Prozessor und einen Memory-Fabric-Switch besitzt. Das Ganze ist als Einschub für Server-Racks gestaltet und wird über schnelle optische Verbindungen (Photonics Interconnects) angebunden. Jede CPU soll dann auf den geteilten Fabric-Attached-Memory Zugriff haben. Standards für neue Verbindungstechniken werden auch im Rahmen des neu gegründeten Gen-Z-Consortiums entwickelt, dem HPE jüngst beigetreten ist.

Prototyp mit DRAM, später Non-Volatile Memory

Zumindest der Prototyp arbeitet somit mit flüchtigem DRAM, der Daten ohne Stromzufuhr nicht halten kann. Für die Zukunft plant HPE jedoch mit neuartigem nicht-flüchtigem (non-volatile) Arbeitsspeicher der sogenannten Storage-Class, der nicht ganz die Leistung von DRAM erreicht, aber weitaus schneller als Massenspeicher arbeitet. Zunächst hat HPE NVDIMMs im Sinn, die bereits in einigen Servermodellen des Herstellers vertrieben werden. In naher Zukunft soll auch die Kooperation mit SanDisk (nun Western Digital) beim sogenannten 3D ReRAM (PDF) zum Einsatz kommen, den der Hersteller von der Skalierbarkeit in der Herstellung besser aufgestellt sieht als den von Intel und Micron entwickelten 3D-XPoint-Speicher.

Auch die Software muss mitspielen

Oftmals ist die Hardware der Software einen Schritt voraus, doch erst wenn beide harmonieren ist das volle Potenzial der Technik auch abrufbar. Damit Modelle wie HPEs The Machine auch wirklichen Nutzen bringen, bedarf es auch Anpassungen am Betriebssystem. Zunächst arbeitet der Prototyp mit Linux, doch später soll ein eigenes System namens MachineOS die Aufgabe übernehmen. Auch Anwendungen müssen eigens für die neue Architektur geschrieben werden. Hier soll die Zusammenarbeit mit Hortonworks bezüglich Apache Spark zum Tragen kommen. Erste Code-Pakete wurden auf Github publiziert; für 2018/2019 rechnet HPE mit fertigen Programmen.

Ihr habt die Wahl: Macht mit bei den Reader's Choice Awards 2025 und bestimmt eure Hersteller des Jahres!