Intel zur SC16: Die Ära der Künstlichen Intelligenz hat begonnen

Im Vorfeld der gerade stattfindenden SC16, einer Messe rund um das Thema Supercomputing, hatte Intel Pressevertreter zu einer Telefonkonferenz eingeladen. Die nun im Rahmen der Messe angekündigten Neuerungen umfassen unter anderem neue Xeon-Prozessoren, die für das High-Performance-Computing (HPC) bestimmt sind.

Ein Schlagwort der Intel-Präsentation lautete: „The AI Era has arrived“. Im Bereich des Hochleistungsrechnens wächst der Stellenwert von Themengebieten wie Künstliche Intelligenz (AI) und Machine Learning. Hier ist hohe Rechenleistung gefordert, was wiederum lukrative Märkte für die Hard- und Software-Branche eröffnet.

Plattformen für AI

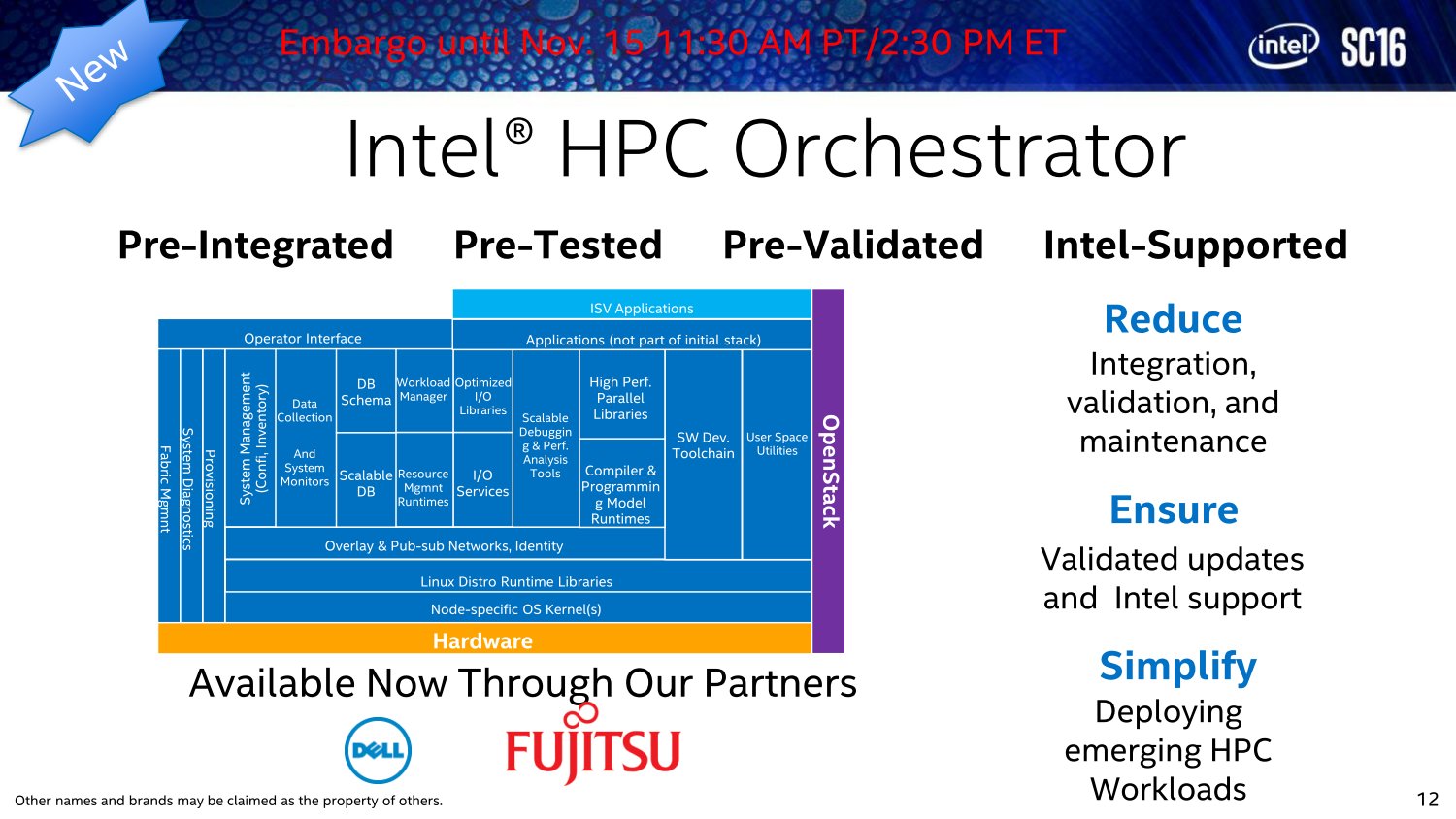

Intel bedient den Bereich AI mit zahlreichen Lösungen. Darunter sind vor allem Werkzeuge und Plattformen für Software-Entwickler. Im Rahmen der OpenHPC-Community wurde die Systemsoftware Intel HPC Orchester entworfen, der Intel zur SC16 viel Aufmerksamkeit schenkt. Echte dedizierte AI-Hardware hat Intel noch nicht im Programm. Doch diese wird kommen. Vielmehr werden zunächst CPUs und Rechenbeschleuniger für den Bereich Künstliche Intelligenz, im Speziellen Machine Learning und Deep Learning, optimiert. Xeon-Prozessoren mit vielen Kernen sowie die Beschleunigerkarten der Familie Xeon Phi stehen dabei im Fokus.

Für allgemeine HPC-Aufgaben ist der neue Prozessor Xeon E5 2699A mit 22 Kernen und 44 Threads auf Basis der Broadwell-Architektur bestimmt. Der im verbesserten 14-nm-Prozess gefertigte und fast 5.000 US-Dollar kostende Chip erhält im kommenden Jahr Nachfolger der Skylake-Generation, deren Verfügbarkeit Intel für Mitte 2017 ankündigt. Im Zentrum der Neuerungen steht die Unterstützung der Advanced Vector Extensions mit 512 Bit (AVX-512). Der erweiterte Befehlssatz soll Gleitkommaberechnungen und Verschlüsselungs-Algorithmen beschleunigen. High-Speed-Netzwerke sollen von der integrierten Omni-Path-Architektur profitieren. Für die SC16 plant Intel eine erste Live-Demo der neuen Plattform.

Neue Hardware für AI

Bei den Xeon Phi soll im nächsten Jahr die neue Generation Knights Mill eingeführt werden. Hier verspricht Intel eine „Optimierung für Künstliche Intelligenz“, ohne zunächst ins Detail zu gehen. Gänzlich dem AI-Untersegment des Deep Learning verschrieben sind PCIe-Karten mit Intels FPGA Arria 10. Diese nennt Intel auch Deep Learning Inference Accelerator (DLIA) und sieht sie zur Beschleunigung sogenannter Neuraler Netzwerke für 2017 vor. Der Vorteil der programmierbaren Prozessoren liegt in der sehr spezifischen Abstimmung. Damit können FPGAs oftmals gewisse Aufgaben weitaus schneller erledigen als eher universell ausgerichtete Prozessoren, sind dafür aber im Grunde „Fachidioten“ und nicht flexibel einsetzbar.

Fortschritte durch Community und Open-Source

Intels HPC-Bestrebungen gehen über die Firma hinaus. So hat Intel nach eigenen Angaben inzwischen rund 2,5 Millionen Entwickler im Rahmen von Ausbildungsprogrammen geschult. Erfahrungen werden auch über Community-Foren wie OpenHPC oder IXPUG ausgetauscht. Zusätzlich betreibt Intel weltweit über 80 sogenannte Parallel Computing Center. Open-Source ist auch bei Supercomputern ein großes Thema, wie auch das Dateisystem Lustre zeigt, das sich laut Intel wachsender Verbreitung erfreut und mittlerweile in 72 der Top-100-Supercomputer genutzt wird.

Nervana-Übernahme verdeutlicht Stellenwert von AI

Im Sommer hatte Intel die Übernahme des auf Deep Learning und AI spezialisierten Startups Nervana verkündet. Als unbestätigter Kaufpreis standen stolze 400 Millionen US-Dollar im Raum. Auch diese Investition verdeutlicht Intels Bestrebungen in diesem Marktsegment. In der abschließenden Fragerunde zur Telefonkonferenz hatte Intel erklärt, mit Nervana das beste unter vielen AI-Startups erworben zu haben.