Facebook: AI kann Fotos nach Inhalten durchsuchen

Die von Facebook entwickelte Lumos-AI ist mittlerweile in der Lage, eigenständig Inhalte auf Bildern zu erkennen, ohne dabei auf Hashtags oder dergleichen angewiesen zu sein. Das Feature ist laut Facebook bereits verwendbar – zumindest auf Englisch.

Laut Facebooks Angaben hat die Bildersuche des Unternehmens ab nun die Fähigkeit, Bilder etwa konkret nach Katzen oder Hunden zu durchsuchen, ohne dass das Bild zuvor entsprechend markiert wurde. Die Ergebnisse sollen auch bereits dahingehend optimiert worden sein, dass eine vielfältige Auswahl an Bildern und nicht nur jeweils leicht unterschiedliche Motive präsentiert werden. Alte Bilder, bei denen man sich nur mehr an bestimmte Dinge erinnern kann, sollen so wieder einfach auffindbar sein.

Langwierige Entstehung

Die Implementierung dieser Fähigkeit ist das Resultat eines langwierigen Entwicklungsprozesses. An dessen Anfang stand die Überlegung, eine Mehrzweck-Codeplattform zu errichten, der einer späteren Skalierung nichts im Wege stehen würde. Diese wurde FBLearner Flow genannt und bildet das Fundament, auf dem die Lumos-AI – neben anderen Projekten – aufgesetzt ist.

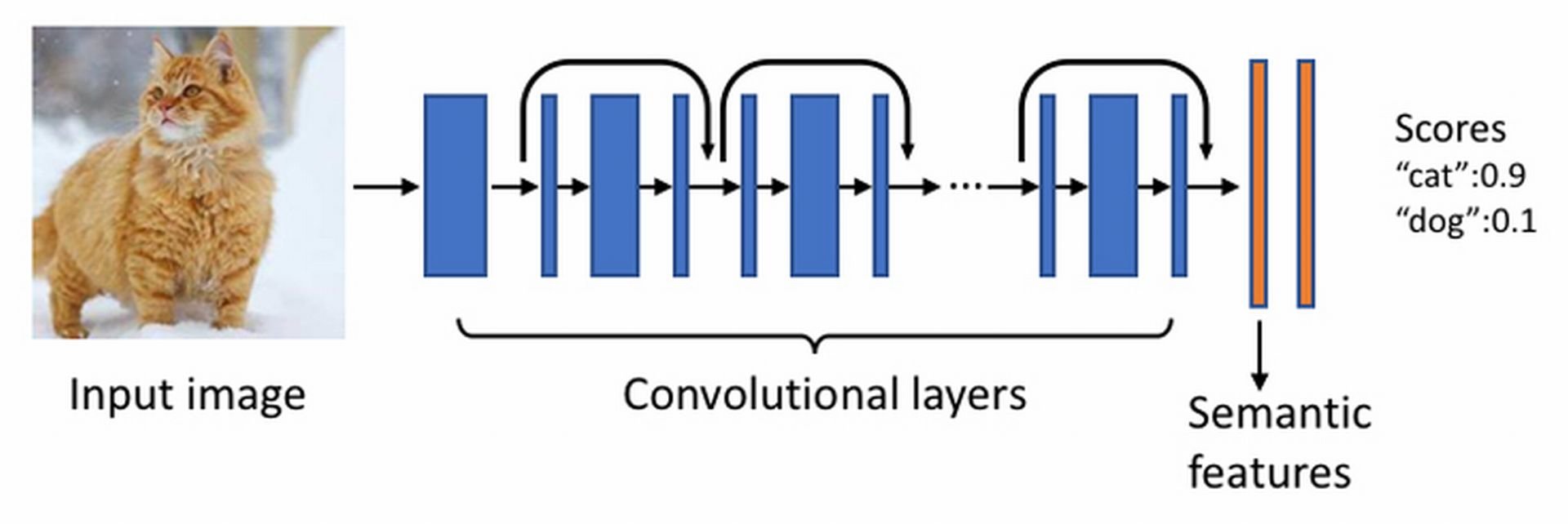

Anschließend begann Facebook damit, die AI mit Millionen von Bildern zu versorgen, um das stetige Lernen der AI zu ermöglichen. Die Bilder werden durch eine Deep-Learning-Engine geschickt, die das jeweilige Bild in Segmente zerlegen und währenddessen Objekte und Szenen identifizieren kann. Das können Menschen, Tiere, Kleidungsstücke, Gegenstände oder Sehenswürdigkeiten sein.

Die sich daraus abgeleiteten Daten stehen allen Facebook-Produkten oder Diensten zur Nutzung offen. Beispielsweise wurde die AI auch für die Identifizierung von urheberrechtlich geschützten Inhalten, den Kampf gegen Spam oder das automatische Untertiteln von Bildern genutzt.

Hilfsmittel für Sehbehinderte

Ein weiterer wesentlicher Zweck der AI ist es, sehbehinderten Menschen Bilder per Audiowiedergabe erfahrbar zu machen. Die Technologie dahinter wird Automatic Alt Text (AAT) genannt und ist in der Lage, Bildinhalte zu beschreiben. Bislang beschränkte sich das Verfahren auf die Aufzählung von dargestellten Objekten. Durch die Lumos-AI sollen nun aber auch Zustandsbeschreibungen möglich sein. Nicht nur das simple Vorhandensein von beispielsweise einer Person würde dann dem Nutzer mitgeteilt werden, sondern auch, was diese Person gerade macht.

Facebook hat dies erreicht, indem die Lumos-AI mit einem Pool von 130.000 manuell mit Beschreibungen versehenen Bildern gefüttert wurde. Darauf aufbauend wurde ein Maschinenlernmodell erstellt, das der AI die oben genannten Fähigkeiten ermöglicht.

Facebook verspricht sich viel von der neuen Technologie. Das Unternehmen könne immer treffsicherer automatisch und pixelgenau Bilder analysieren und dies auch auf Videos übertragen – ein für das Unternehmen stetig wichtiger werdender Bereich. Dass durch diese Technologie allerdings auch noch wesentlich einfacher und präziser Daten über Nutzer automatisiert erhoben werden können, fand in der Ankündigung keine Erwähnung.