Intel NNP zur AI DevCon: Spring Crest folgt Lake Crest mit vierfacher Leistung

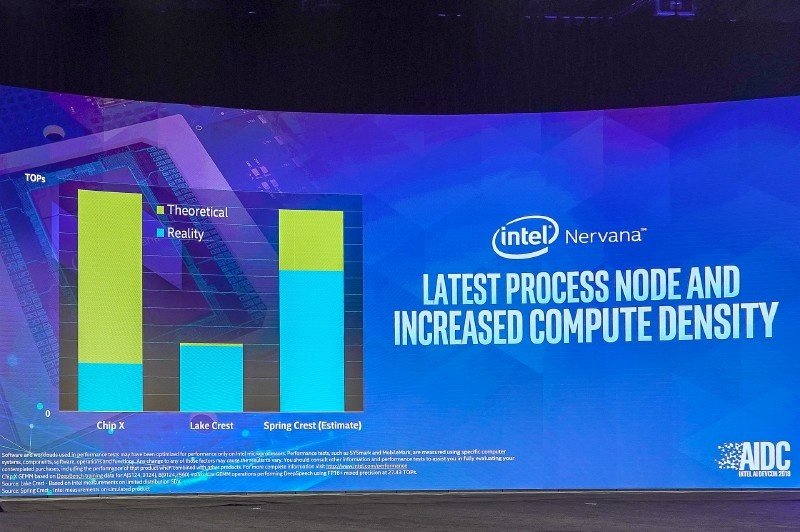

Intels erste Generation eines Neural Network Processor (NNP) mit dem Codenamen Lake Crest ist bei Partnern im Test, da kündigt der Hersteller auf der heutigen AI Developers Conference bereits den Nachfolger Spring Crest an. Dieser soll bereits im kommenden Jahr verfügbar werden und die drei- bis vierfache Leistung bieten.

Lake Crest basiert noch nahezu komplett auf den eigenen Entwicklungen von Nervana, die Intel im August 2016 übernahm. Dabei handelt es sich um einen AI-Beschleuniger, der für Großrechner in den Händen von Firmen wie Microsoft, Google und Amazon gedacht ist. In dem Bereich ist er für das sogenannte Training/Deep Learning beispielsweise anhand großer Bildmengen gedacht. Das System lernt dabei, indem Muster und Gesetzmäßigkeiten in den Daten erkannt werden, ohne dass dieser Lernerfolg im Vorfeld explizit programmiert worden ist. Ein Screening-Projekt in Zusammenarbeit mit Nervatis zeigte laut Intel nach erfolgreichem Lernen eine Steigerung der Leistung von zuvor elf Stunden auf nur noch 31 Minuten Dauer.

Intel Spring Crest gegen Nvidia Tesla

Doch Intel ist in dem Bereich nicht allein. Stark vertreten ist dort unter anderem Googles TPU und stets im Rampenlicht Nvidias Tesla mit seinen Tensor Cores, die so etwas wie der Platzhirsch sind und jährlich neue Chipgenerationen zuerst für diesen Bereich ankündigen. Ähnlich sieht die Intel-Karte deshalb auch aus: Bei 210 Watt TDP rangiert das Konstrukt aus großem Chip mit 12 Tensor Cores flankiert von vier Mal 8 GByte HBM2, doch gegen Volta-Teslas von Nvidia hat der Chip aus der 28-nm-Fertigung von TSMC noch keine Chance. Der Fokus bei dem Produkt liegt auf hoher Bandbreite von Chip zu Chip in einem Datacenter, gepaart mit sehr geringer Latenz und hoher Auslastung in der Praxis und nicht nur Theorie – ein Fingerzeig in Richtung Nvidia. Von einem auf zwei Karten soll die Skalierung bei über 96 Prozent liegen, erklärt Intel.

Intel Nervana NNP-L1000 alias Spring Crest soll Lake Crest folgen und neben verbesserter aber noch unbekannter Ausstattung bei deutlich modernerer Fertigungstechnik auch zusätzliche Features bieten. Dazu gehört bfloat16 als einer der numerischen Standard-Formate in der Industrie hinsichtlich neuraler Netzwerke. Diese Befehle sollen in Zukunft auch Xeon SP beherrschen, die FPGA-Lösungen der zugekauften Altera-Sparte sowie Movidius mit eingeschlossen.

Mit Xeon-Prozessoren gehen über die Hälfte aller Unternehmen, die AI ausprobieren wollen, ihre ersten Schritte, erklärte Naveen Rao Chef der Artificial Intelligence Products Group bei Intel. Doch diese sind bisher nur rudimentär dafür ausgelegt, es bedarf neben der Hardware entsprechend großer Anpassungen bei der Software, weshalb Intel die Hand zu Partnern ausstreckt. Weitere Ankündigungen dazu dürften in den kommenden Monaten folgen.