Autonomes Fahren: Als nächstes will Nvidia in die Stadt

Über den Highway fahren Nvidias Testfahrzeuge für autonomes Fahren bereits zuverlässig. In der Bay Area musste zuletzt bei einer 80 km langen Fahrt kein einziges Mal eingegriffen werden. Als nächstes will Nvidia die Erprobung autonomer Fahrzeuge auf Innenstädte erweitern. Hier sind vor allem Kreuzungen eine Herausforderung.

Durch das kalifornische Silicon Valley hat es Nvidias Versuchsträger BB8 bereits ohne Eingriffe des überwachenden Mitarbeiters geschafft. Auf der 80 km langen Strecke, die über Interstates, Highways und State Routes führte, wurden Fahrspuren, andere Fahrzeuge und der freie Raum zum Fahren schnell und zuverlässig erkannt. Im dichten Verkehr kam das Fahrzeug mit auf den Highway auffahrenden anderen Autos zurecht, woraufhin BB8 die Geschwindigkeit zunächst reduziert und bei sicherer Distanz zum Vordermann wieder auf das Ausgangsniveau anhebt. Wird ausreichend Freiraum zwischen Fahrzeugen erkannt, wechselt BB8 ohne Zutun des Fahrers die Spur.

Das Auto sieht immer mehr als der Mensch

Das alles funktioniert, da Nvidia mit Drive AGX Xavier (Level 2+) oder Drive AGX Pegasus (Level 5) leistungsfähige Hardware im Kofferraum verbaut, die die Informationsflut zahlreicher Sensoren wie Kameras, Radar und Lidar verarbeitet. Ein Auto kann dadurch automatisch deutlich mehr sehen als ein Mensch, der stets nur in eine Richtung schauen kann, und ist sich deshalb vollständig über sein Umfeld bewusst. Das Duell der Wahrnehmung haben Autos somit schon jetzt klar für sich entschieden.

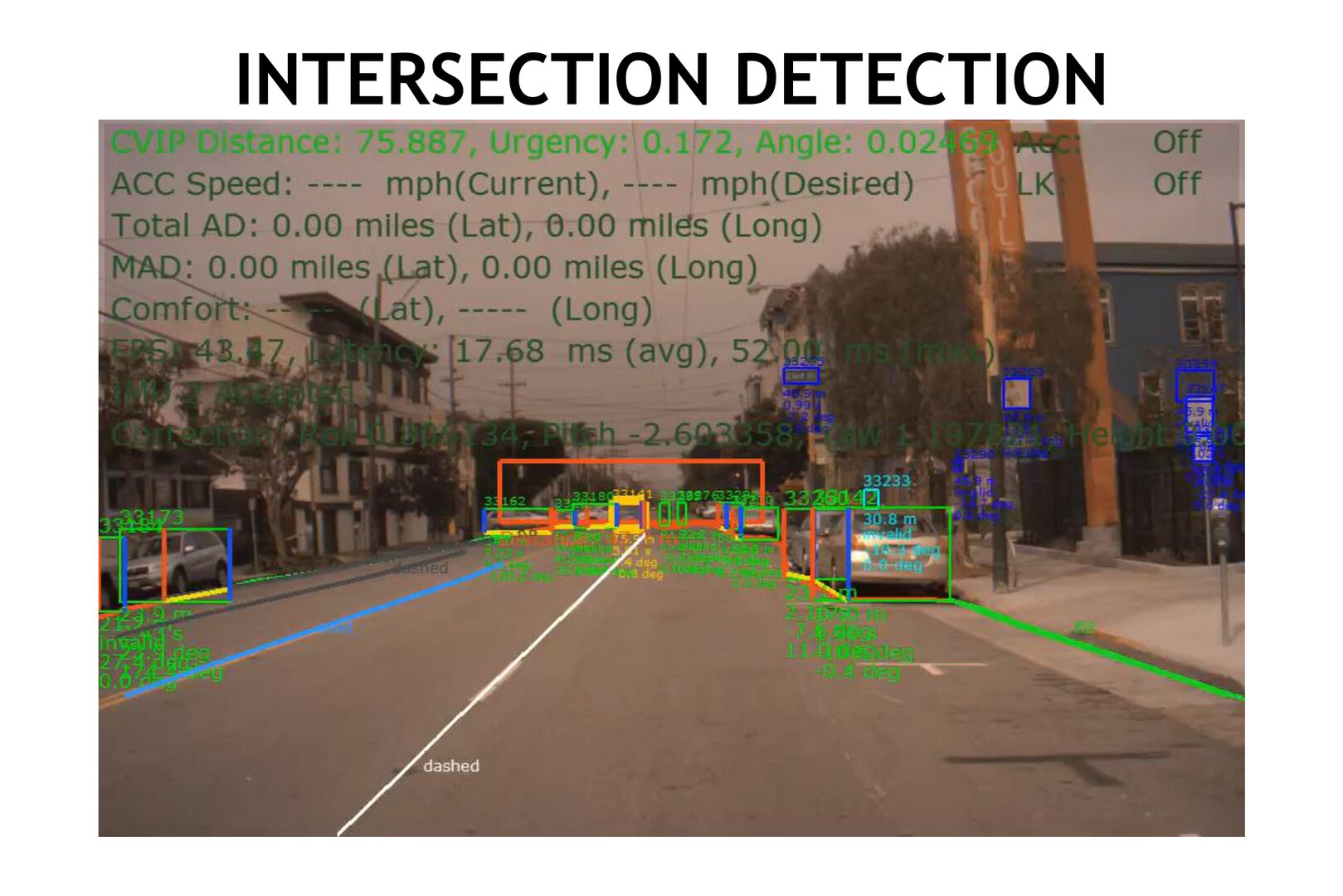

Kreuzungen ohne Ampeln oder Schilder erkennen

Im nächsten Schritt will Nvidia mit seinen autonomen Fahrzeugen in die Stadt und sich dort weiteren Herausforderungen wie Kreuzungen stellen. Die können eindeutige Merkmale haben, die sie als Kreuzung identifizieren, zum Beispiel Ampeln oder Schilder. Nicht jede Kreuzung ist allerdings so eindeutig zu erkennen, häufig muss ein Auto hier auch nach nicht-spezifischen Hinweisen suchen. Das können Einbuchtungen im Straßenverlauf, Zebrastreifen oder unterbrochene Häuserfassaden sein. Es sind aber keine spezifischen Merkmale, die nur auf Kreuzungen zutreffen. Deshalb hat Nvidia hier mit WaitNet ein neuronales Netz trainiert, das auf die Eigenschaften entsprechender Kreuzungen spezialisiert ist und dabei helfen soll, in diesen Situationen die richtige Entscheidung zu treffen. Zuverlässiger anhalten und warten als ein menschlicher Fahrer soll WaitNet schon jetzt, wie Neda Cvijetic, Senior Manager Autonomous Vehicles bei Nvidia, im Rahmen ihres GTC-Talks erläuterte.

WaitNet ist ein kleiner Baustein einer großen Plattform

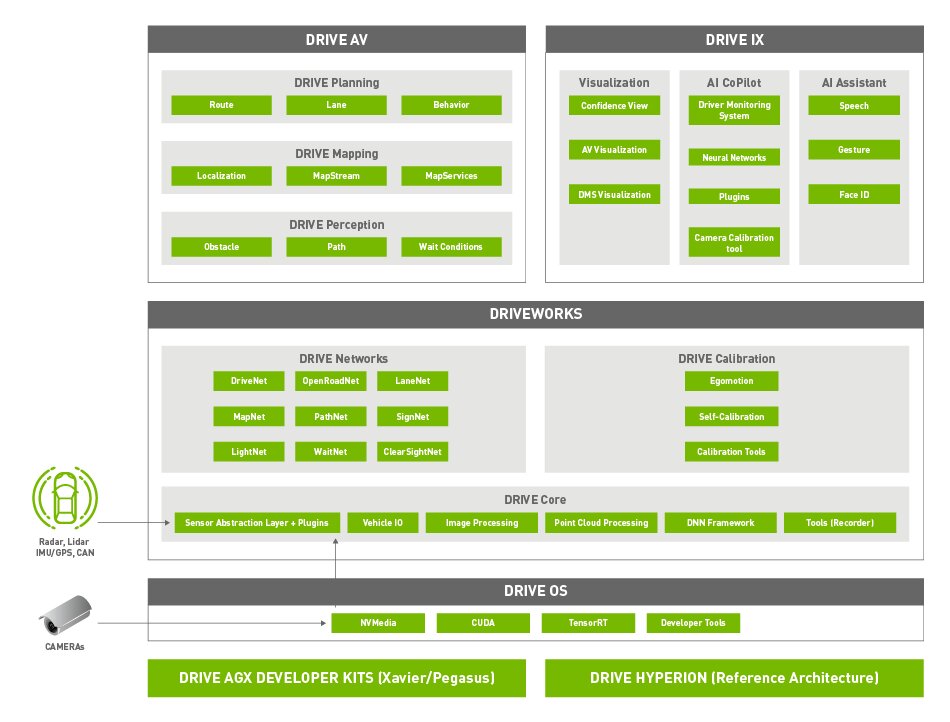

WaitNet ist ein kleiner Teil von Drive AP2X, Nvidias Plattform für autonomes Fahren nach Level 2+, die im zweiten Quartal dieses Jahres hinsichtlich der Software auf Version 9.0 aktualisiert werden soll, die neue Fähigkeiten hinzufügt. Dazu zählen mehr neuronale Netze, Gesichtserkennung und Fahrerüberwachung sowie neue Optionen für die Integration von Sensoren etwa bei schlechtem Wetter. Drive AP2X besteht aus den vier Bausteinen Drive AV für die Software für autonomes Fahren, Drive IX für das Erlebnis im Innenraum, DriveWorks mit den zahlreichen neuronalen Netzen sowie Drive OS als Real-time Operating System (RTOS). Diese Bausteine wiederum laufen auf Drive AGX Xavier und Pegasus sowie Drive Hyperion für die zugehörigen Sensoren.

In Sachen Automotive-Hardware hatte Nvidia zur GTC 2019 allerdings nichts Neues anzukündigen. Das zur letztjährigen GTC kurz auf einer Roadmap gezeigte Orin-SoC, das beim Einsatz von nur zwei Chips die Leistung eines Drive AGX Pegasus mit zwei Xavier-SoCs und zwei TU104-GPUs liefern soll, wurde dieses Jahr kein einziges Mal erwähnt. Nachfragen zum aktuellen Stand der Entwicklung wurden nicht beantwortet. Für das Jahr 2020 hatte Nvidia allerdings bereits zur CES im Januar eine neue Plattform in Kooperation mit Daimler in Aussicht gestellt.

Ihr habt die Wahl: Macht mit bei den Reader's Choice Awards 2025 und bestimmt eure Hersteller des Jahres!

- GTC 2019: Wie Sony Autos sehen lässt

- Nvidia: Creator-Ready-Treiber für Kreative ohne Quadro

- 33 Prozent schneller: Samsung bringt HBM2E an den Start

- +7 weitere News