Raytracing ohne RTX: Nvidia Pascal erhält DXR‑Support per Treiber

Im Rahmen der Game Developers Conference (GDC) hat Nvidia einen neuen Treiber mit DXR-Support jenseits von Turing-Grafikkarten angekündigt. Mit dem Treiber wird Raytracing via Microsoft DXR fortan auch auf Grafikkarten der Pascal-Generation unterstützt.

Nvidia schaltet DXR im Treiber für Pascal frei

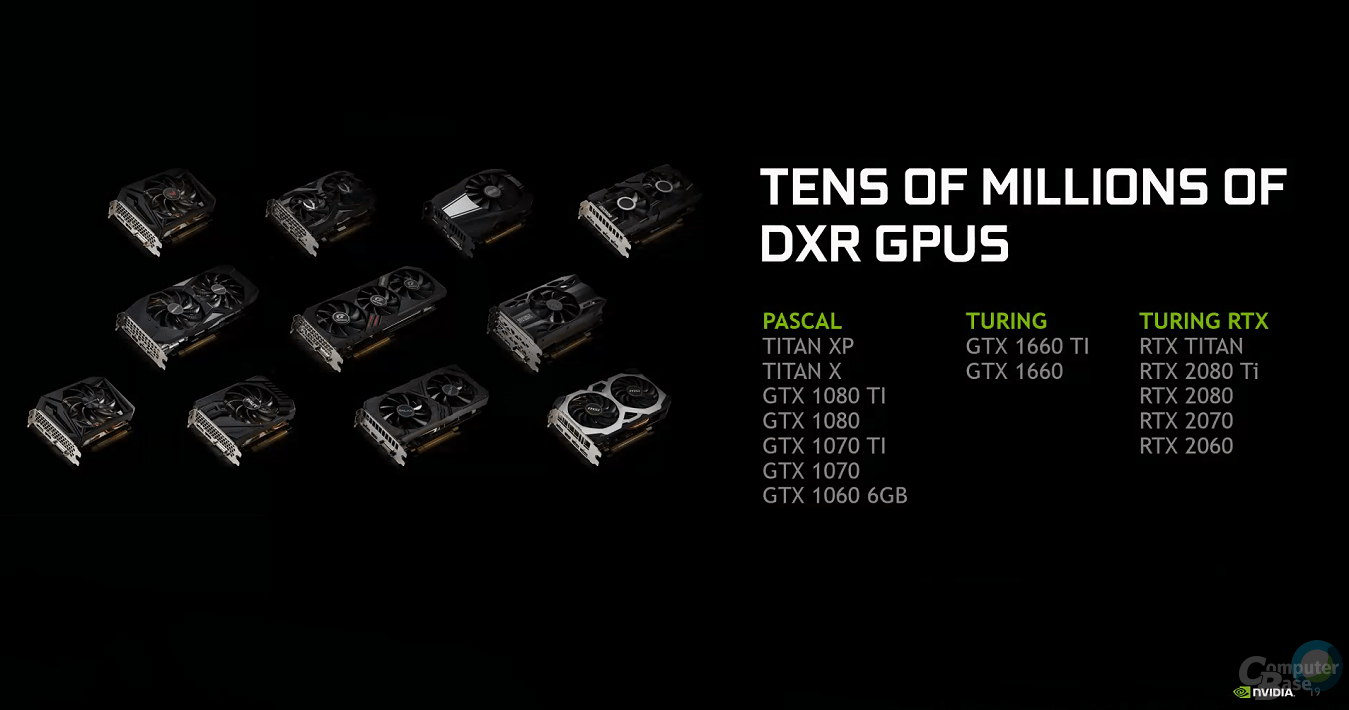

Der neue GeForce-Treiber mit DXR-Support für Pascal-Grafikkarten von GTX 1060 mit 6 GB bis zur GTX 1080 Ti sowie die Workstation-Modelle Titan X und Titan XP soll im April erscheinen. Ein genauer Termin ist noch nicht bekannt. DXR-Unterstützung wird es dann auch für die neuen Turing-Modelle GTX 1660 (Test) und GTX 1660 Ti (Test) geben, die ebenfalls keine speziellen Recheneinheiten (RT Cores) für Raytracing besitzen, die eben nur bei den GeForce RTX zu finden sind.

Der neue Treiber ermöglicht es also, Echtzeit-Raytracing in Spielen über DXR als Teil von DirectX 12 auch ohne exklusive RT-Kerne und somit auf den herkömmlichen Rechenkernen zu nutzen. Die Leistung wird bei aktivierten DXR-Effekten allerdings deutlich niedriger als bei den Turing-Pendants mit darauf spezialisierten RT-Kernen ausfallen – der Sinn und Zweck bleibt also abzuwarten. Auch AMD könnte DXR auf seinen Radeon-Grafikkarten nutzen, sofern dies per Treiber unterstützt wird. Noch hat AMD aber keinen offiziellen Raytracing-Treiber veröffentlicht.

DXR auf immer mehr APIs und Engines

Nvidia geht von einer zunehmenden Verbreitung von Raytracing in Spielen aus. Neben DXR als Teil von Microsoft DirectX 12 soll im Laufe des Jahre auch die Vulkan-API eine DXR-Extension erhalten. Mit der Unreal Engine und der Unity Engine unterstützen zwei Großkaliber der Videospiel-Engines Raytracing. Auch die CryEngine von Crytek oder die Frostbite-Engine von DICE (EA) sind mit von der Partie.

Metro Exodus (Test) von 4A Games ist ein aktuelles Beispiel für umfangreiche Raytracing-Effekte. „In Kürze“ soll laut Nvidia auch Shadow of the Tomb Raider einen Patch für Raytracing via DXR erhalten, wie schon zu erwarten war.

DLSS bleibt exklusiv auf Turing RTX

Fortan wird Raytracing bei Nvidia also nicht mehr nur exklusiv auf GeForce RTX zur Verfügung stehen. Beim DLSS (Deep Learning Super Sampling) sieht es aber anders aus. Die alternative Kantenglättung auf Basis von KI wird weiterhin nur mit den dedizierten Tensor-Kernen der RTX-Familie geboten, bekräftigte Nvidia in der Fragerunde im Anschluss an die GDC-Präsentation vor Medienvertretern.

Zumindest theoretisch bestünde die Möglichkeit, ein Pendant zum proprietären DLSS über die Microsoft-API Windows Machine Learning (WinML) respektive DirectML zu schaffen. DirectML macht sich die universellen Compute-Einheiten von GPUs zu Nutze, womit auch Radeon-Grafikkarten von AMD eine solche Funktion bieten könnten, wie ein AMD-Mitarbeiter bereits in einem Interview angedeutet hatte.

Nvidia begründet Schritt zu RT-Kernen

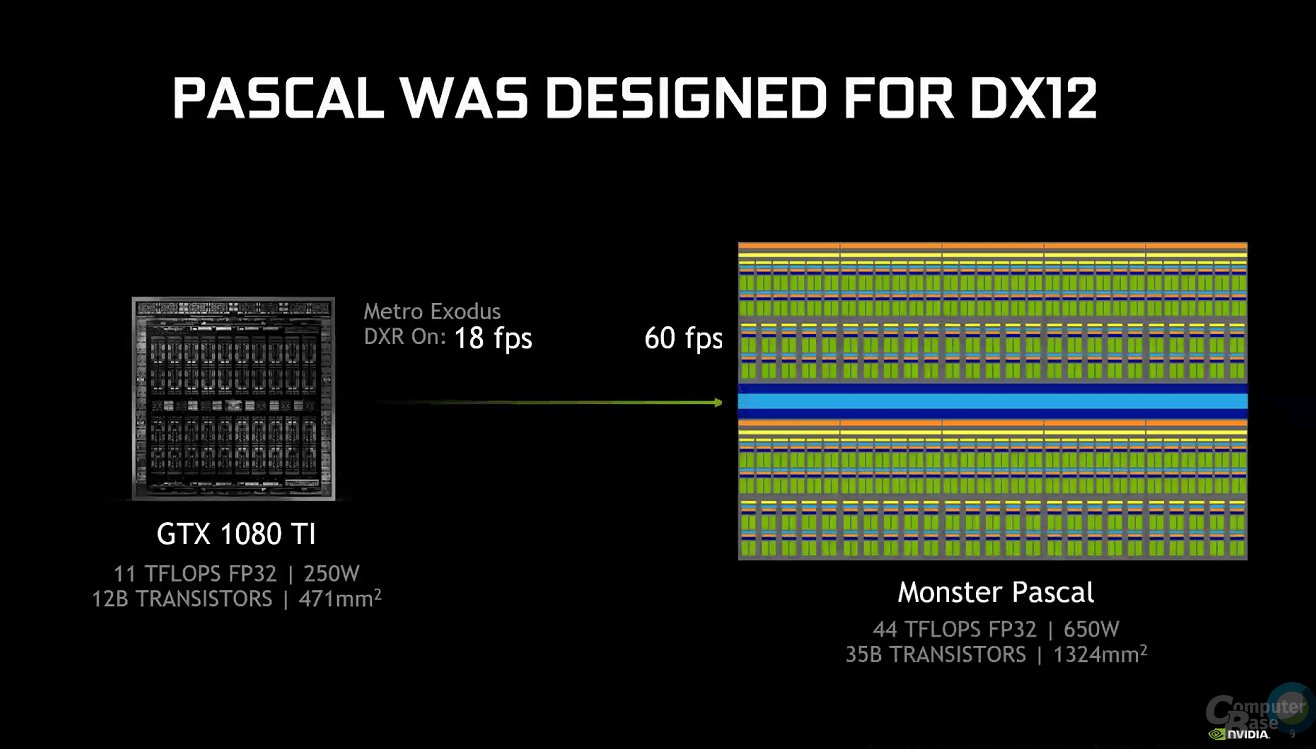

Eine interessante Anekdote lieferte die GDC-Präsentation von Nvidia bezüglich der Entscheidung für dedizierte Raytracing-Kerne bei der Turing-Architektur. Wie die untere Abbildung von Nvidia zeigt, hätte Pascal nur mit herkömmlichen Recheneinheiten ein Monster-Chip werden müssen, um die gleiche Leistung wie eine GeForce RTX 2080 bei Raytracing in Spielen zu erreichen.

Für rund 60 FPS in Metro Exodus mit 1440p-Auflösung und aktiviertem DXR sei ein Pascal-Chip mit 35 Milliarden Transistoren, 44 TFLOPS FP32-Leistung bei einer Chip-Fläche von 1.324 mm² und einer TDP von 650 Watt für die Grafikkarte nötig gewesen. Da dies an technische wie wirtschaftliche Grenzen gestoßen wäre, sah Nvidia die Erschaffung spezialisierter RT- und Tensor-Kerne als besseren Weg. Mit 445 mm² (TU106), 545 mm² (TU104) und 754 mm² (TU102) sind die RTX-GPUs aber dennoch sehr große Halbleiterchips und entsprechend teuer in der Herstellung. Dies macht sich auch bei den vergleichsweise hohen Preisen der GeForce RTX bemerkbar.

ComputerBase hat Informationen zu diesem Artikel von Nvidia unter NDA erhalten. Die einzige Vorgabe war der Veröffentlichungszeitpunkt.