C:\B_retro\Ausgabe_8\: Historische Multi-GPU-Grafikkarten

C:\B_retro\Ausgabe_8\ wirft einen Blick auf die exotischen Multi-GPU-Grafikkarten und ganz besondere Pixelbeschleuniger. Echte Klassiker von ATi und Nvidia geben sich hier die Ehre und zeigen, was in ihrer Epoche möglich – wenn auch nicht immer sinnvoll – gewesen ist. Ein spannendes Kapitel aus der Geschichte der Grafikkarte.

Jeden Sonntag wirft C:\B_retro\ einen unterhaltsamen Blick zurück auf drei Jahrzehnte voller bewegter Geschichten und die Entwicklung der Computerszene: Was geschah in den letzten 30 Jahren zwischen 1980 und 2010 in der Informationstechnik? Geschichten von Mythen, Meilensteinen und Meisterwerken: C:\B_retro\.

C:\B_retro\Ausgabe_8\

Historische Multi-GPU-Grafikkarten

Nachdem sich C:\B_retro\Ausgabe_7\: ganz den Anfängen des legendären MMORPG World of Warcraft gewidmet hat, wird es in C:\B_retro\Ausgabe_8\ ein wenig exotischer. Noch lange vor der pfeilschnellen GeForce RTX 2080 Ti (Test) auf Basis von Turing und der Radeon RX 5700 XT (Test) mit ihrer neuen Mikroarchitektur RDNA kämpften die Hersteller ATi und Nvidia mit SLI, CrossFire und nicht zuletzt mit Multi-GPU-Grafikkarten um die Krone des schnellsten Grafikbeschleunigers seiner Zeit.

C:\B_retro\Ausgabe_8\ geht vor allem auf die Grafikkarten ein, die sich bereits in den letzten zwei Jahrzehnten auf ComputerBase beweisen durften und zu denen auch entsprechendes Bildmaterial und Benchmarks vorliegen. Doch vorab, wie sieht es eigentlich innerhalb der ComputerBase Community aus?

-

Ja, ich habe eine ATi/AMD Radeon Dual-GPU-Grafikkarte besessen

-

Ja, ich habe eine Nvidia GeForce Dual-GPU-Grafikkarte besessen

-

Nein, ich habe nie eine Dual-GPU-Grafikkarte besessen

C:\B_retro\Ausgabe_8\Historische Multi-GPU-Grafikkarten\

Gigabyte GV-3D1 (2005)

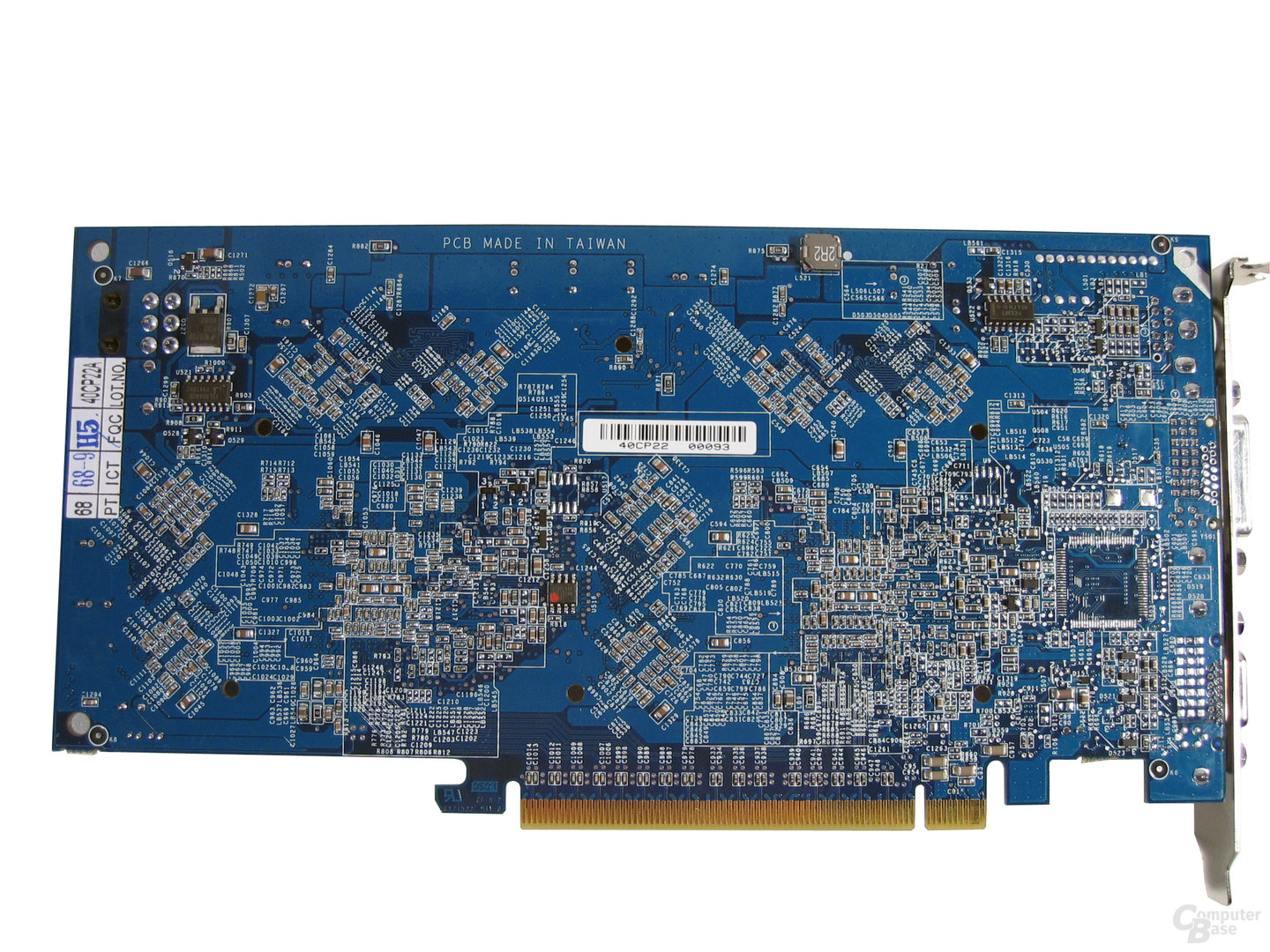

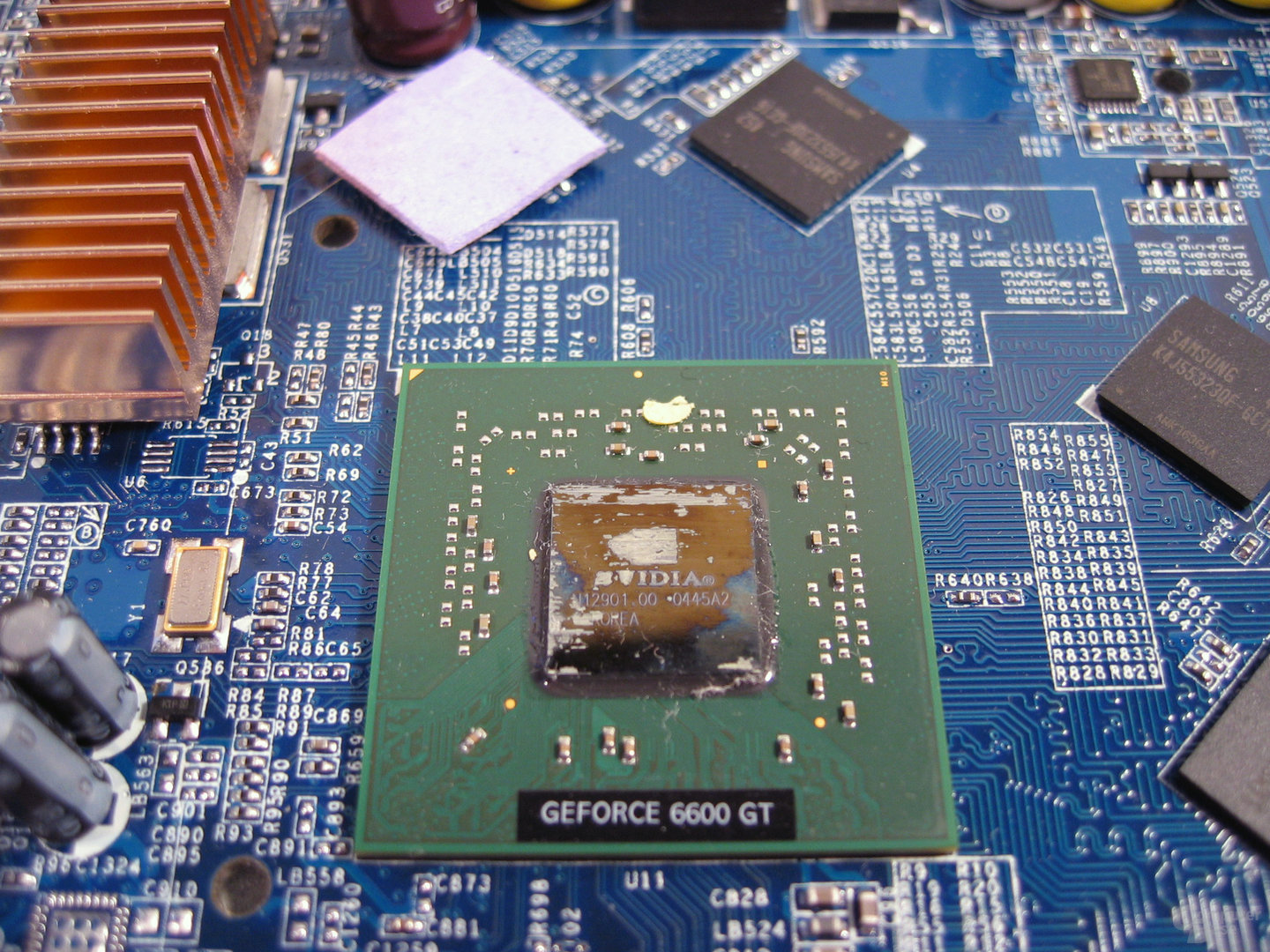

Nachdem Gigabyte bereits Mitte Januar 2005 angekündigt hatte, dass seine hauseigene Dual-GeForce-6600-GT-Karte ab Ende Januar 2005 für rund 500 Euro im Bundle mit der SLI-Platine GV-K8NXP-SLI im Handel erhältlich sein sollte, durfte sich die Grafikkarte am 14. Februar des Jahres 2005 unter der Bezeichnung Gigabyte GV-3D1 (Test) auf ComputerBase beweisen. Um beide Chips auf der Grafikkarte nutzen zu können, ist der Einsatz des GV-K8NXP-SLI zwingend vorausgesetzt.

Mit der GV-3D1 konnte sich Gigabyte seinerzeit rühmen, die erste Multi-GPU-Karte mit zwei GeForce 6600 GT konstruiert zu haben. Die Idee an sich war aber nicht neu, doch dank der Wiederauferstehung der SLI-Technik bot sich nun die Möglichkeit, diese Idee auch mit zwei aktuellen Grafikprozessoren zu realisieren.

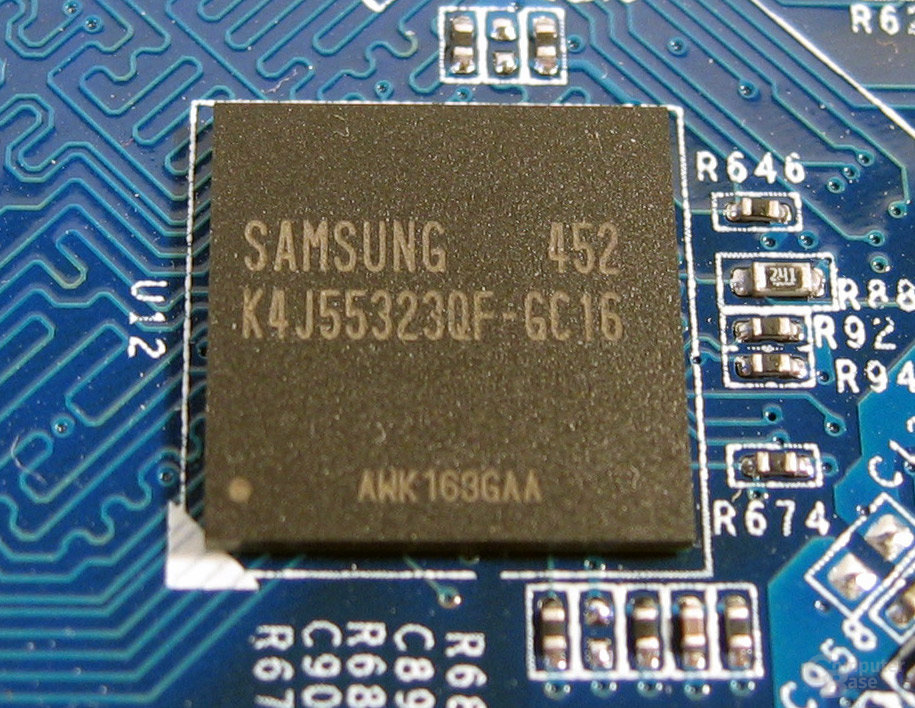

Die beiden Grafikchips vom Typ NV43 aus der Nvidia GeForce-6-Serie takteten mit 500 MHz nach Nvidia-Vorgaben und verfügten über jeweils 128 MB GDDR3-Speicher, der mit einer Bandbreite von 128 Bit angebunden wurde. Der Grafikspeicher wurde von Samsung geliefert und besaß eine Zugriffszeit von 1,6 ns sowie einen Speichertakt von 560 MHz. Hier ließ Gigabyte ein wenig Spielraum, denn Samsung selbst spezifizierte den GDDR3-Speicher offiziell mit bis zu 600 MHz. Auf einer gewöhnlichen GeForce 6600 GT taktete der GDDR3 gar nur mit 500 MHz, weshalb die GV-3D1 neben der Kraft der zwei Herzen auch in Sachen Speichertakt vorne lag.

Anders als eine reguläre GeForce 6600 GT benötigte die Dual-GPU-Grafikkarte einen PCIe-Stromanschluss, um den Strombedarf der beiden GPUs zu decken. Der PCIe x16-Slot lieferte nicht genug Leistung für zwei NV43-Chips.

Mit einem AMD Athlon 3500+ (Test), einem Asus A8N-SLI Deluxe und 2 × 512 MB Crucial Ballistix PC3200 CL2 durfte sich die Gigabyte GV-3D1 dann schlussendlich mit dem ForceWare 66.93 als Treiber den Benchmarks im ComputerBase Test stellen. Die Ergebnisse in den drei am häufigsten vertretenen Auflösungen der damaligen Zeit in Spielen wie Call of Duty, Doom 3, Far Cry, Half-Life 2, Halo, Quake 3 Arena sowie Splinter Cell und Unreal Tournament 2004 ergaben folgendes Bild:

Hier konnte sich die Dual-GPU-Grafikkarte leicht oberhalb eines SLI-Gespanns bestehend aus zwei 6600 GT platzieren, sich allerdings nicht entscheidend absetzen – eine einzelne GeForce 6800 GT oder gar Ultra konnte nicht geschlagen werden – was ComputerBase seiner Zeit wie folgt einordnete:

Sicherlich ist die GV-3D1 in unserem Ranking weiter vorne platziert als die SLI-Kombi aus zwei Asus N6600GT. Nicht vergessen darf man jedoch den mit 60 MHz höher getakteten Speicher der Gigabyte-Karte. Werden die beiden Asus-Karten auf denselben RAM-Takt übertaktet, so zeigt sich ein klares Unentschieden. Einer GeForce 6800 GT kann weder der eine noch der andere SLI-Kandidat das Wasser reichen.

ComputerBase

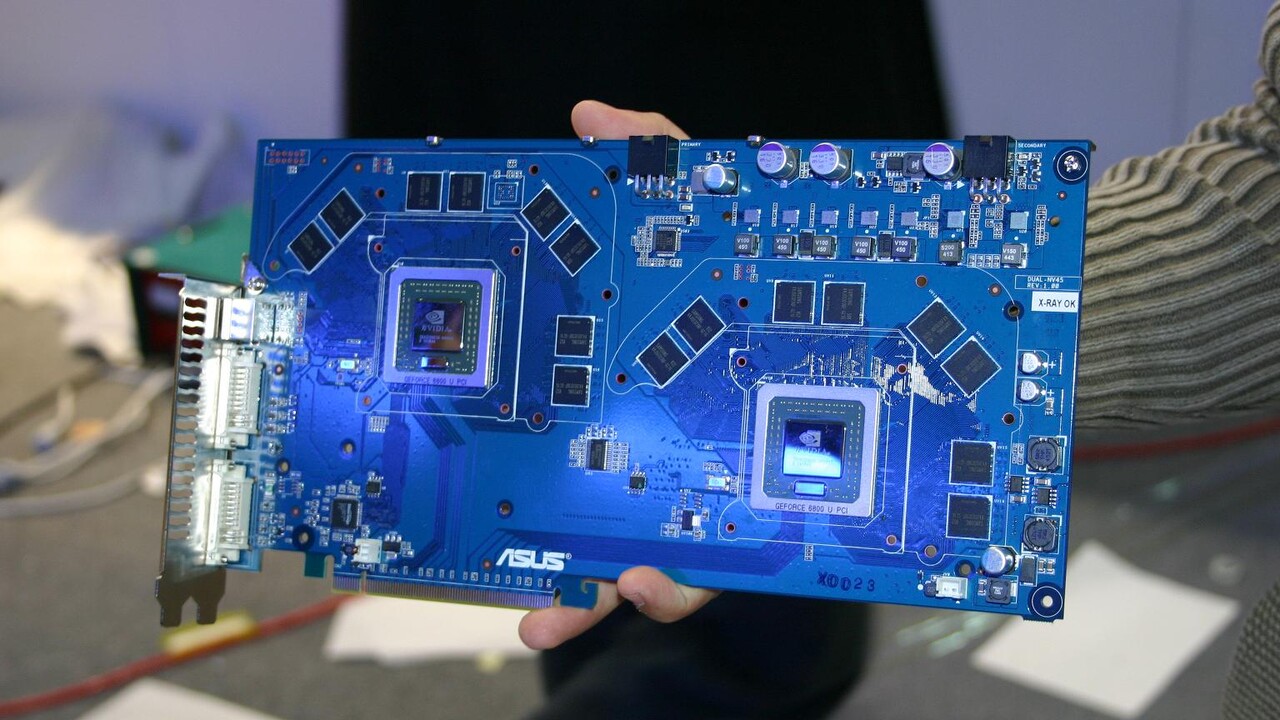

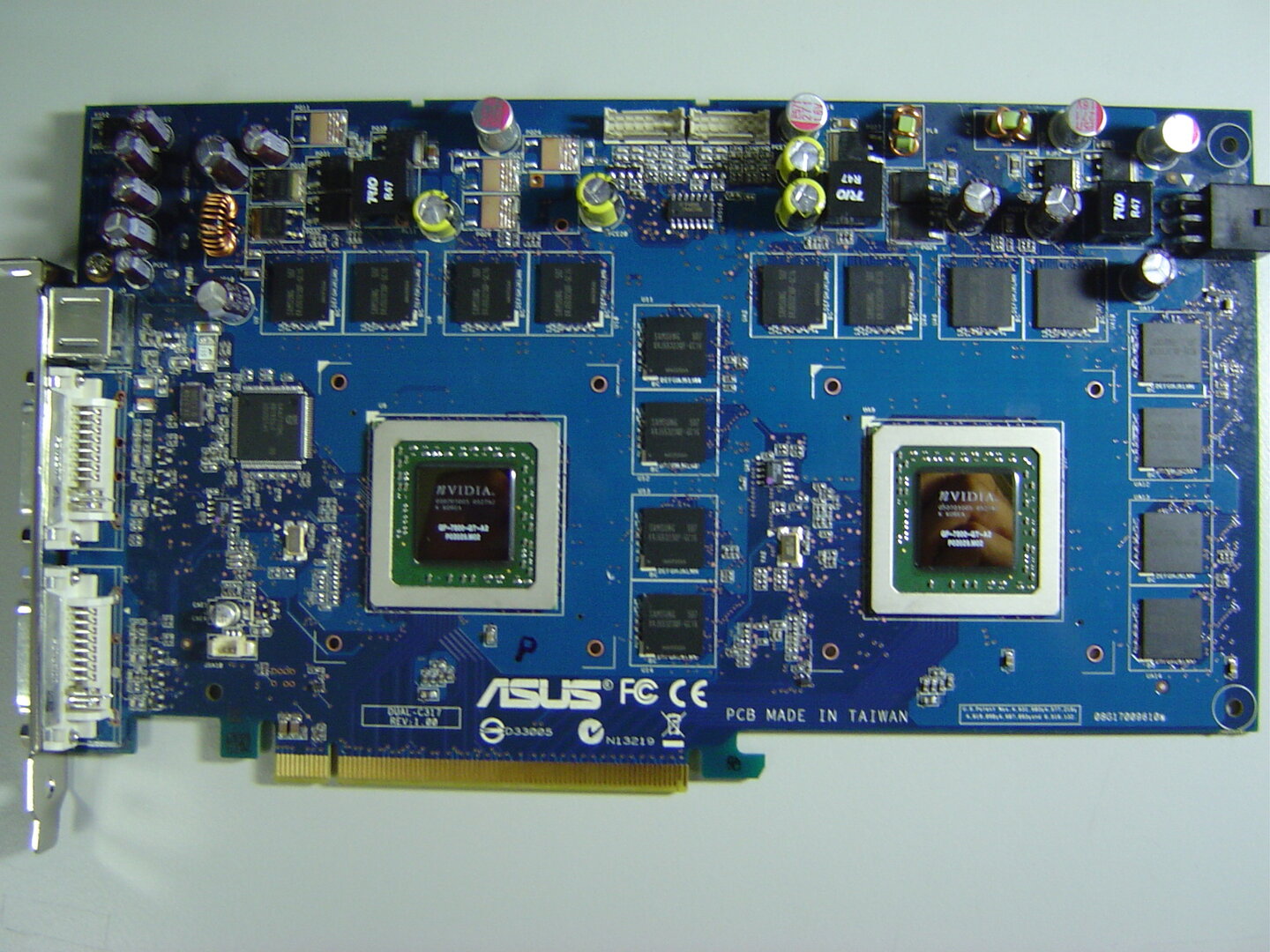

Asus EN7800GT Dual (2005)

Bereits Mitte September 2005 zeigte Asus seine Dual-7800-GT-Karte auf Basis des G70 aus der GeForce-7-Serie von Nvidia und konnte zu diesem Zeitpunkt bereits ein voll bestücktes und seriennahes PCB der Grafikkarte vorweisen.

Viele Informationen wollte und konnte Asus zu diesem frühen Zeitpunkt noch nicht anbieten und es blieb abzuwarten, ob es die Karte, die unterhalb des Preises zweier 7800 GT (Test) angesiedelt sein sollte, denn dieses Mal in den Handel schaffen würde. Die 6800 Ultra Dual bliebt seinerzeit ein Prototyp.

Kurz darauf sickerten neue Details zur EN7800GT Dual durch, die Karte sollte plötzlich für um die 1.000 Euro, also doch teurer als zwei einzelne 7800 GT, in den Handel kommen und lediglich 2.000 Mal produziert werden. Am Ende kam es wiederum doch ein wenig anders.

Ab November 2005 sollte die EN7800GT Dual das schaffen, was dem Vorgängermodell mit zwei 6800-Ultra-Chips nie vergönnt war - sie kam in den Handel. Die mit zwei 7800-GT-Chips bestückte Karte war tatsächlich weltweit auf 2.000 Einheiten limitiert und besaß eine UVP von 869 Euro.

Asus präsentierte zudem eigene Benchmarks, die der EN7800GT Dual bei Taktraten von 489/679 MHz mit dem ForceWare 78.01 im Zusammenspiel mit einem Asus A8N-SLI Premium, einem Athlon 64 4000+ (Test) und 1.024 MB Arbeitsspeicher im 3DMark03 27.203 und im 3DMark05 11.138 Punkte bescheinigten. Eine Besonderheit der Dual-GPU-Grafikkarte war ohne Zweifel das externe 80-Watt-Netzteil, das insbesondere beim Übertakten für einen stabilen Betrieb sorgen sollte. Die offizielle Produktseite der EN7800GT Dual auf der Website des Herstellers ist noch heute online.

Die Asus Extreme N7800GT Dual (Test) bot SLI für High-End-Kunden auf nur einer Grafikkarte und konnte im Test von ComputerBase mit einer sehr hohen Leistung und einer guten Lüftersteuerung überzeugen. Dennoch mutierte die Dual-GPU-Grafikkarte unter Last gerne zum „Krawallmacher“ und hatte zudem mit einer sehr hohen Leistungsaufnahme zu kämpfen.

Nichtsdestotrotz erfüllt die Asus Extreme N7800GT Dual genau den Zweck, für den sie konzipiert worden ist: Einige Grafikkartenfans glücklich zu machen, denen die Lautstärke, die Temperatur, die Stromaufnahme sowie der sehr hohe Preis reichlich egal sind und die gleichzeitig etwas Außergewöhnliches im Rechner werkeln lassen wollen.

ComputerBase

ATi Radeon HD 3870 X2 (2008)

Die Radeon-HD-2000-Serie von 2007 startete mit großen Versprechungen, konnte sich aber gegen die starke Konkurrenz vom Schlage einer GeForce 8800 GTX (Test) mit dem phänomenalen Grafikprozessor G80 nie durchsetzen. Den besten Eindruck hinterließ seinerzeit die Low-End-Karte Radeon HD 2400 XT (Test), die als einzige ihren direkten Gegenspieler größtenteils im Griff hatte.

Die Nachfolger, rund um die Radeon HD 3870 (Test) auf Basis des überarbeiteten RV670-Grafikchips, hinterließen einen weitaus besseren Eindruck und konnten nicht nur mit der Konkurrenz aus dem Hause Nvidia mithalten, sondern boten auch einige Eigenschaften und Fähigkeiten an, die die Konkurrenz bis zu diesem Zeitpunkt vermissen lies. Für die High-End-Käufer hatte ATi aber erneut auch mit der Radeon HD 3870 keine Grafikkarte im Produktportfolio, da sie nur wenig schneller als die ATi Radeon HD 2900 XT (CrossFire-Test) ihren Dienst verrichtete. Es war also höchste Zeit für ATi, in dieser Hinsicht etwas zu unternehmen.

Die passende Antwort hörte gut zwei Monate nach der Vorstellung der HD-3000-Serie auf den Namen „Radeon HD 3870 X2“, die nichts anderes als zwei Radeon-HD-3870-Grafikkarten auf einem PCB darstellte. ATi entwickelte eine Platine, die zwei RV670-GPUs auf sich tragen konnte, modifizierte leicht die Taktraten und hatte im Januar 2008 endlich eine Grafikkarte in petto, die der Nvidia GeForce 8800 Ultra (Test) das Fürchten lehren sollte.

Auf der Radeon HD 3870 X2 verbaute ATi zwei RV670-GPUs, die im CrossFire-Modus miteinander kommunizieren konnten, um so die Leistung der Karte zu erhöhen. Die RV670-Chips, auf der HD 3870 X2 RV680 genannt, waren dabei identisch mit den Rechenwerken auf einer Radeon HD 3850 oder Radeon HD 3870. Die GPU taktete auf der Radeon HD 3870 X2 mit 825 MHz, was spürbar höher lag als die Frequenz auf der Radeon HD 3870 (775 MHz). Das Speicherinterface war auf der Grafikkarte pro Chip 256 Bit breit. Der Speicher taktete mit 900 MHz (Radeon HD 3870: 1125 MHz, GDDR4).

Am 24. Januar 2008 sollte es dann soweit sein und die HD 3870 X2 trat zum mit Spannung erwarteten Test auf ComputerBase an – es sollte der ersehnte Griff nach den Sternen werden.

Die Radeon HD 3870 X2 zeigte eine sehr gute Leistung und wusste die GeForce 8800 Ultra meistens in die Schranken zu weisen. Wenn CrossFire in einem Spiel optimal funktionierte, renderte die Dual-GPU-Karte deutlich schneller als Nvidias Flaggschiff. Ohne CrossFire-Unterstützung lieferte die HD 3870 X2 eine Leistung auf Augenhöhe der HD 3870 ab.

In Anbetracht der überzeugenden Benchmarks und der Rückkehr in das Segment der High-End-Grafikkarte, sprach ComputerBase der ATi Radeon HD 3870 X2 seinerzeit ein entsprechend positives Fazit aus:

Nach einer langen Pause greift ATi mit der Radeon HD 3870 X2 endlich wieder das High-End-Segment an – und bringt es ganz schön durcheinander. Unterm Strich gibt es aber derzeit keine schnellere Grafikkarte als die ATi Radeon HD 3870 X2 auf dem Markt.

ComputerBase

Nvidia GeForce 9800 GX2 (2008)

Eine Radeon HD 3870 X2 auf dem Grafikkarten-Olymp wollte sich Nvidia nicht all zu lange anschauen und so machten bereits im Februar 2008 die ersten Bilder und Benchmarks der neuen Dual-GPU-Grafikkarte im Internet die Runde.

Die GeForce 9800 GX2 wurde mit zwei GPUs vom Typ G92-450 ausgestattet, welche jeweils mit 600 MHz takteten und auf zwei, über Nvidias SLI-Technologie verbundenen, PCBs integriert wurden. Der Shadertakt der insgesamt 256 Shader-Prozessoren (2x 128) lag bei 1.500 MHz. Die zwei mal 512 MB GDDR3 wurden jeweils über ein 256-Bit-Speicherinterface angebunden und takteten real mit 1.000 MHz. Der GDDR3-Speicher stammte einmal mehr von Samsung und besaß eine Zugriffszeit von 0,83 ns. Im Grunde handelte es sich bei der 9800 GX2 um zwei GeForce 8800 GTS 512 MB (Test).

Nachdem die 9800 GX2 ab Mitte März 2008 bei ersten Händlern zu Preisen ab 529 Euro als lieferbar gelistet wurde, durfte sich das Dual-GPU-Flaggschiff am 18. März 2008 auch endlich im Test auf ComputerBase und in damals so beliebten Spielen wie Stalker, F.E.A.R., Call of Duty 4 und Gothic 3 beweisen.

Mit der GeForce 9800 GX2 (Test) hatte Nvidia ohne Zweifel ein beeindruckendes Stück Hardware auf den Markt gebracht, welches schlussendlich gut ein Drittel schneller rechnete als die Radeon HD 3870 X2.

Wenn da nicht das Problem gewesen wäre, dass der Grafikkarte bei extremen Settings des Öfteren der Speicher ausging. Solange vierfaches Anti-Aliasing aktiv war, reichte der Speicher zwar in der Regel noch aus und die GeForce 9800 GX2 war die schnellste Grafikkarte, die sich zu dieser Zeit auf dem Markt befand, bei achtfachem MSAA brach die Dual-GPU-Karte dann aber ganz gerne ein. Hier wäre es sinnvoller gewesen, gleich 2 x 1024 MB auf dem Doppel-PCB zu verbauen. Bereit sein musste man bei der GeForce 9800 GX2 hingegen dazu, unter Last einen recht hohen Geräuschpegel zu akzeptieren. Unter Windows war die Grafikkarte zwar angenehm leise, in einer 3D-Anwendung aber aufdringlich laut.

Für wen all' diese Einschränkungen keine Probleme darstellen, für den gibt es zur Nvidia GeForce 9800 GX2 aktuell keine Alternativen auf dem Markt. Völlig sorgenfrei ist man aber auch mit dieser Grafikkarte nicht.

ComputerBase

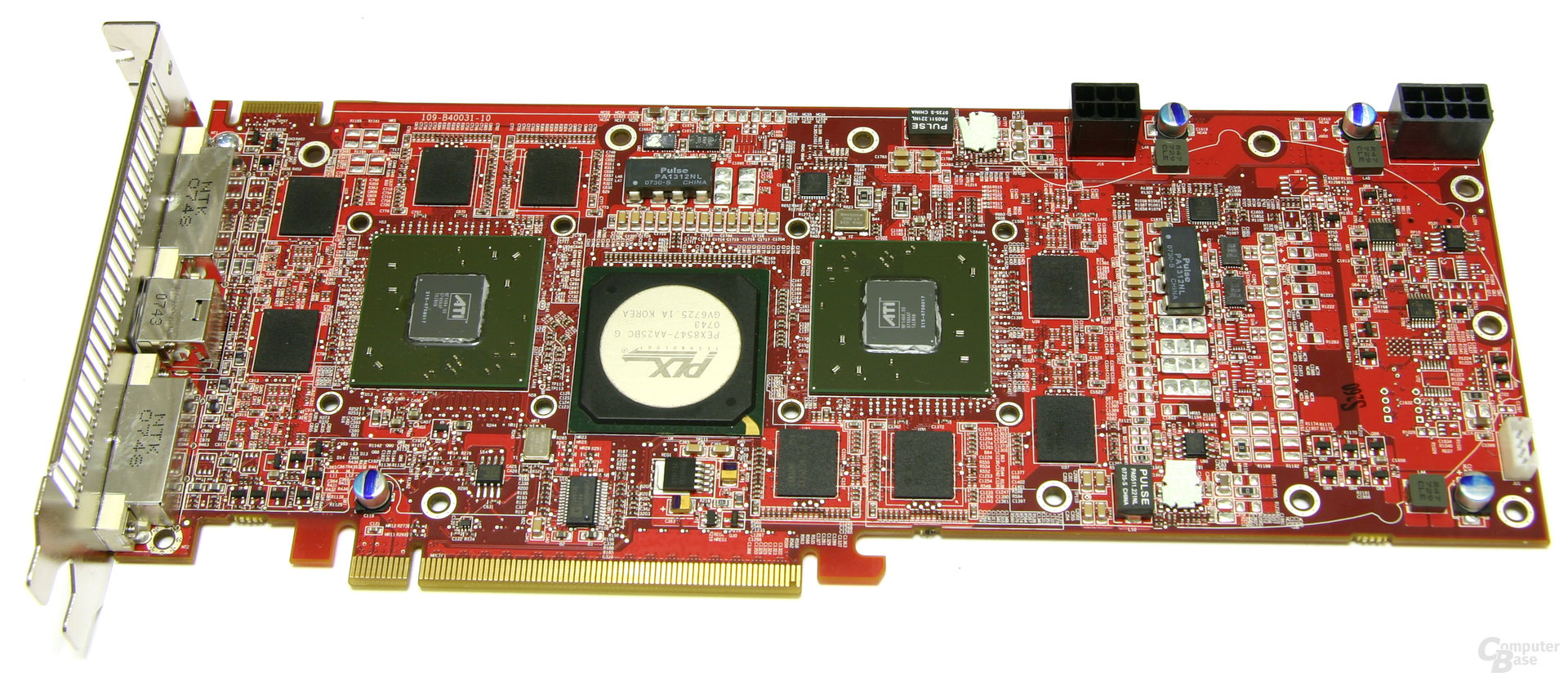

Gainward Rampage 700 GS GLH (2008)

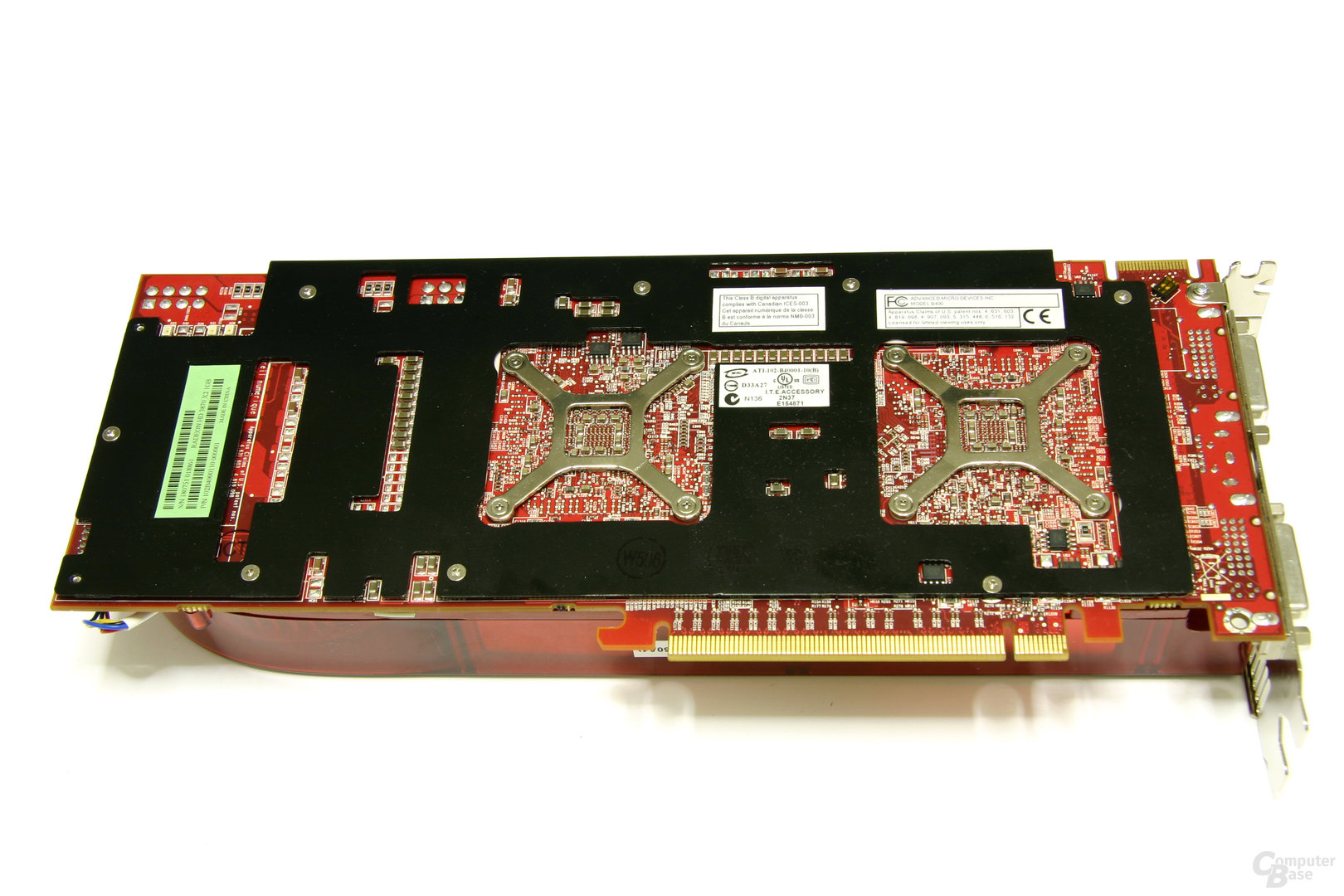

Nachdem sich bereits im August 2008 mit der ATi Radeon HD 4870 X2 (Test) erneut eine Dual-GPU-Grafikkarte den Platz an der Sonne sichern konnte, legte Gainward mit der Rampage 700 GS GLH (Test) auf Basis eben dieser HD 4870 X2 noch einmal nach und brachte das erste Custom Design mit zwei GPUs vom Typ RV770 und werksseitiger Übertaktung auf den Markt.

Gainward schien vom Referenzdesign der Radeon HD 4870 X2 nicht viel zu halten, zumindest gab es optisch zwischen diesem und dem Design der Rampage 700 GS GLH kaum noch Gemeinsamkeiten. Das rot gefärbte PCB maß immer noch eine Länge von 27 cm, sah jedoch um einiges aufgeräumter aus als das Pendant auf dem bekannten Referenzdesign. Davon abgesehen benötigte die Grafikkarte immer noch einen Acht-Pin- sowie einen Sechs-Pin-PCIe-Stromstecker, um den Dienst verrichten zu können.

Als Kühlsystem setzte Gainward auf der Rampage 700 GS GLH erstmals zu dieser Zeit auf einer Desktop-Karte einen schier riesigen und wuchtig wirkenden Triple-Slot-Kühler ein, der dementsprechend gleich die nächsten beiden PCI- oder PCIe-Slots blockierte.

Gainward übertaktete die beiden GPUs auf der Rampage 700 GS GLH von 750 MHz auf 790 MHz und auch der GDDR5-Speicher machte einen Sprung um 100 MHz und wurde mit 1.900 MHz angesteuert. In den folgenden Benchmarks im Test von ComputerBase sollte die außergewöhnliche Dual-GPU-Grafikkarte die neue Referenz darstellen, was allerdings mit einer enormen Leistungsaufnahme einhergehen sollte.

Mit einer im Vergleich zur HD 4870 X2 um 6 Prozent höheren Leistungsaufnahme, konnte das Custom Design von Gainward die Referenzkarte von ATi vom Thron stoßen und war kurz vor Weihnachten 2008 die schnellste Grafikkarte am Markt.

Mit der Rampage 700 GS GLH spricht Gainward die absoluten Enthusiasten an, die nicht nur die höchste Leistung, sondern auch etwas Besonderes beziehungsweise Einzigartiges in der Hand halten möchten. Und beides ist die Grafikkarte alleine durch das erstmals eingesetzte Triple-Slot-Kühlsystem. Zusätzlich erhöht Gainward die Taktraten, womit man die schnellste, aktuell erhältliche Grafikkarte auf dem Markt hat.

ComputerBase

Nvidia GeForce GTX 295 (2009)

Bereits Ende 2008 wurde bekannt, dass die neue Dual-GPU-Speerspitze von Nvidia unter der Bezeichnung GeForce GTX 295 firmieren sollte. Zuvor lautete der Arbeitstitel noch GeForce GTX 260 GX2. Durch den Wegfall des Suffix „GX2“ sollte der Status als Dual-GPU-Grafikkarte nicht mehr explizit in der Bezeichnung ausgewiesen werden.

Kurz nachdem ATi mit HD 4870 X2 Platz 1 im Ranking der Grafikkarten erobert hatte, kündigte Nvidia auch schon die GeForce GTX 295 an, welche zwei GT200b/GT206-GPUs (gefertigt in 55-nm-Technologie) jeweils auf einer einzelnen Platine per SLI miteinander kombinieren sollte. Zwischen den PCBs saß ein Lüfter, der die Chips auf niedrigen Temperaturen hielt. Die GT206-Rechenkerne waren wie auf den Einzelkarten voll ausgestattet und kamen mit jeweils 240 skalaren Shadereinheiten sowie jeweils 80 TMUs daher. Das Speicherinterface hingegen war mit 448 Bit pro GPU leicht beschnitten. Die GeForce GTX 295 besaß einen Chiptakt von 1.242 MHz und der 896 MB große GDDR3-Speicher taktete mit 1.000 MHz. Die maximale Leistungsaufnahme sollte laut Nvidia 289 Watt betragen.

Die Nvidia GeForce GTX 295 (Test) konnte im Test auf ComputerBase nicht vollends überzeugen und war kein eindeutiger Gewinner. Und so stellte sich die Frage: Wer baut also die bessere Multi-GPU-Karte? ATi oder Nvidia? Eine Frage, die äußerst schwer zu beantworten war.

Die Leistung der GeForce GTX 295 lag im Schnitt über der der ATi Radeon HD 4870 X2, ließ in hohen Auflösungen aber deutlich Federn und lag bei hohen Qualitätseinstellungen teilweise gar zurück. Nicht zuletzt deshalb, weil die ATi-Karte durch den neuen Beta-Treiber (Catalyst 9.1) einen ordentlichen Sprung nach vorne gemacht hatte.

ComputerBase urteilte, dass wie so oft – wenn Ziel des Einkaufs nicht ausschließlich der Erwerb der schnellsten Grafikkarte sein sollte – der Preis das Zünglein an der Waage sein könnte. Somit bliebt es abschließend wieder einmal beim Kunden, eine für ihn möglichst optimale Wahl aus zwei nicht optimalen Produkten treffen zu müssen.

Sollte sich die Preisprognose von Zotac mit 460 Euro in Deutschland bewahrheiten, dann dürfte die Nvidia-Karte rund 90 Euro mehr kosten als das ATi-Modell und müsste sich im reinen Preis-Leistungs-Rating, das Mikroruckler außen vor lässt, geschlagen geben.

ComputerBase

Mehr als ein halbes Jahr später, im August 2009, machte es die Zotac GeForce GTX 295 (Test) als „Facelift“ auf Basis des neuen Single-PCBs besser und zeigte, wozu die GeForce GTX 295 von Beginn an hätte im Stande sein können.

Weitere Dual-GPU-Grafikkarten im Test

Über die letzten 15 Jahre hatte ComputerBase noch weitere Dual-GPU-Beschleuniger im Test, hier eine kleine Übersicht:

- Sapphire Radeon HD 2600 XT X2 (2007)

- Sapphire Radeon HD 4870 X2 Atomic (2008)

- XFX Radeon HD 5790 Black Edition (2010)

- AMD Radeon HD 6990 (2011)

- Nvidia GeForce GTX 590 (2011)

- Nvidia GeForce GTX 690 (2012)

- AMD Radeon R9 295 X2 (2014)

Aus der Community

Die Dual-GPU-Grafikkarten der ComputerBase Leser

Wie bereits angekündigt, wird die C:\B_Retro\Ausgabe_8 durch tolle Bilder von Dual-GPU-Grafikbeschleunigern aus der Community ergänzt. Im Laufe der Woche wird diese Galerie nach und nach durch weitere Bilder ergänzt, die im Kommentar-Thread durch die Community-Mitglieder geteilt werden. Weitere tolle Bilder von Retro-Hardware findet sich auch im Retro-Hardware Bilderthread von Community-Mitglied „andi_sco“.

C:\B_retro\Preview\

In der kommenden Ausgabe von C:\B_retro\ dreht sich alles um das Thema, welches es bereits in die aktuelle Ausgabe schaffen sollte, eine besonders erfolgreiche Spielekonsole.

C:\B_retro\Review\

An dieser Stelle finden sich die bisherigen Themen der vorangegangenen Ausgaben von C:\B_retro\ in chronologischer Reihenfolge.

- C:\B_retro\Ausgabe_1\: Der Intel i486, der Creative Sound Blaster 1.0 und die Cebit 1999

- C:\B_retro\Ausgabe_2\: Microsoft Windows 1.0, der Intel Pentium II und die Nvidia GeForce 8800 GTX

- C:\B_retro\Ausgabe_3\: Der Commodore 64, die 3dfx Voodoo Graphics und die Voodoo²

- C:\B_retro\Ausgabe_4\: Die Amiga Story

- C:\B_retro\Ausgabe_5\: Der legendäre AMD Athlon (K7)

- C:\B_retro\Ausgabe_6\: Die legendären Mainboards von Abit

- C:\B_retro}Ausgabe_7\: Die Anfänge von World of Warcraft

C:\B_retro\Feedback\

Was haltet ihr von C:\B_retro\ und welche Themen wünscht ihr euch in der nächsten Ausgabe? Die Redaktion freut sich über konstruktive Kritik, Lob, aber auch Vorschläge, um die neue Serie zukünftig noch stärker an den Wünschen der Leserschaft ausrichten zu können. Mit diesem Lesestoff im Gepäck wünscht die Redaktion einen erholsamen Sonntag!

C:\B_retro\Links\

- Im Test vor 15 Jahren: Die GeForce 6800 GT mit DDR1 von Asus

- Im Test vor 15 Jahren: Der erste Lasernager hieß Logitech MX1000

- Im Test vor 15 Jahren: AGP ohne Nachteile für die GeForce 6600 GT

- Im Test vor 15 Jahren: Der Pentium M machte dem Pentium 4 die Hölle heiß

- Im Test vor 15 Jahren: DDR400 mit hoher Leistung zu noch höheren Preisen

- Im Test vor 15 Jahren: Ein ATi-Chipsatz für den AMD Athlon 64

- Im Test vor 15 Jahren: Intels Pentium 4 Extreme Edition mit schnellerem FSB

- Im Test vor 15 Jahren: Mainboards mit Sockel 775 von Abit hatten das Nachsehen

- Im Test vor 15 Jahren: Athlon 64 4000+ und FX-55 hatten die Nase vorn

- Im Test vor 15 Jahren: Ein Apple-Gehäuse für jedermann

- Im Test vor 15 Jahren: ATi Radeon X700 XT als Konter zur GeForce 6600 GT

Dieser Artikel war interessant, hilfreich oder beides? Die Redaktion freut sich über jede Unterstützung durch ComputerBase Pro und deaktivierte Werbeblocker. Mehr zum Thema Anzeigen auf ComputerBase.