Nvidia Ampere: DGX A100 kommt mit acht A100-GPUs

2/2Passend zur neuen GPU-Architektur Ampere und zur ersten Ampere-GPU A100 hat Nvidia heute mit dem DGX A100 die dritte Generation des eigenen KI-Servers für den Einsatz im Datacenter vorgestellt. Ein einzelner Node des DGX A100 besteht unter anderem aus acht SXM4-Modulen mit A100-GPU, die verbunden über den NVLink eine kombinierte KI-Rechenleistung von in der Spitze 5 PetaFLOPS bezogen auf Half-Precision FP16 zur Verfügung stellen. Bei INT8 sind es 10 PetaOPS, beim neuen eigenen Zahlenformat TF32 sind es 2,5 PetaFLOPS und bei FP64 156 TFLOPS.

Mellanox liefert die Netzwerk-Interfaces

Nvidia stattet das DGX A100 neben acht A100 mit sechs NVSwitches der 3. Generation und neun Mellanox ConnectX-6 VPI Network-Interfaces mit einer Bandbreite von jeweils 200 Gbit/s aus. Nvidia hatte die Übernahme des israelischen Netzwerk-Spezialisten Mellanox im März des letzten Jahres zum Preis von 6,9 Milliarden US-Dollar angekündigt und Ende April dieses Jahres abgeschlossen. Im DGX A100 kommen Mellanox-Produkte aber nicht das erste Mal zum Einsatz, Nvidia hat schon in der Vergangenheit etwa im DGX-1 aus Basis der Volta-Architektur auf Produkte Mellanox gesetzt, damals allerdings noch auf das Mellanox ConnectX-4 VPI Network-Interface mit 100 Gbit/s.

Erfolg für AMD mit Rome alias Epyc 2

DGX A100 ist aber auch für AMD ein großer Erfolg, da Nvidia erstmals nicht mehr auf Prozessoren von Intel für die Server setzt. Auch ein GPU-System wie das DGX A100 benötigt weiterhin klassische Prozessoren und hier kamen bisher im Volta-basierten DGX-1 zwei Xeon E5-2698 v4 mit 20 Kernen zum Einsatz, während das größere DGX-2 auf zwei Xeon Platinum 8168 mit je 24 Kernen setzt. Für das DGX A100 erfolgt der Wechsel zu zwei AMD Rome alias Epyc 7742 mit jeweils 64 Kernen und 128 Threads. Den CPUs stellt Nvidia im DGX A100 1 TB RAM und 15 TB NVMe-SSD-Speicher mit PCI-Express-4.0-Anbindung zur Seite.

Wie „Buy more save more“ funktioniert

199.000 US-Dollar vor Steuern ruft Nvidia für das DGX A100 auf und erklärt, dass Datacenter-Betreiber mehr Geld sparen könnten, umso mehr Systeme sie erwerben. Obwohl dieser Satz von Nvidia und vor allem CEO Jensen Huang immer wieder zu hören ist und dahinter natürlich viel Marketingsprech steckt, ist zumindest der Vergleich aus verfügbarer Rechenleistung und benötigter Fläche im Datacenter beeindruckend.

Als Rechenbeispiel nimmt Nvidia ein Datacenter, das mit 50 DGX-1 und 600 CPU-Servern ausgestattet ist und 25 Racks belegt, 11 Millionen US-Dollar kostet und einen Energiebedarf von 630 kW hat. Ein einziges Rack mit fünf DGX A100 zum Preis von 1 Million US-Dollar könne dieselbe Rechenleistung zur Verfügung stellen, koste in der Anschaffung nur ein Zehntel und verbrauche mit 28 kW nur ein Zwanzigstel dessen.

Ein Supercomputer in 3 Wochen Bauzeit

Mit der Vorstellung des DGX A100 geht die Ankündigung des DGX A100 SuperPOD einher, mit dem sich innerhalb von drei Wochen ein Supercomputer aufbauen lassen soll. Der DGX A100 SuperPOD besteht aus 140 DGX A100 und somit 1.120 A100-GPUs. 170 InfiniBand-Switches von Mellanox mit jeweils 200 Gbit/s Bandbreite sorgen für die Vernetzung untereinander, im gesamten Netzwerk-Fabric sollen 280 TB/s an Bandbreite zur Verfügung stehen, das über 15 km Lichtwellenleiter realisiert wird. Der Netzwerkspeicher des DGX A100 SuperPOD beläuft sich auf 4 PB reinen Flash-Speicher. Für den DGX A100 SuperPOD gibt Nvidia einen Spitzenleistung von 700 PetaFLOPS für KI-Berechnungen an, womit das System auf einen Schlag in den Top-20 des TOP500-Rankings für Supercomputer landen soll. Nvidia hat das eigene Datacenter „SATURNV“ jüngst von 1.800 DGX-Systemen um vier DGX A100 SuperPODs für eine Gesamtkapazität von 4,6 ExaFLOPS erweitert.

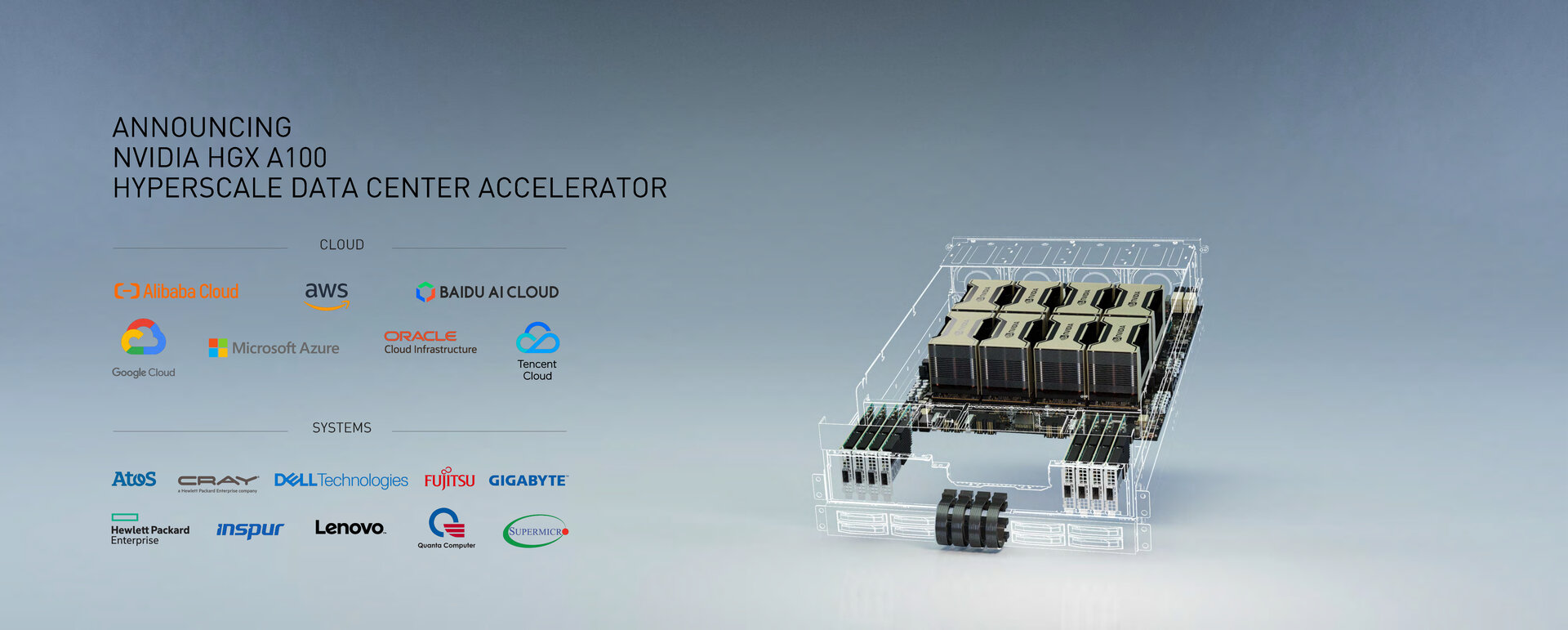

HGX A100 für Server-Anbieter

Neben dem DGX A100, das als fertiges Paket von Nvidia geliefert wird, bietet Nvidia das HGX A100 an, das von der Grundarchitektur her dem DGX A100 entspricht, aber nur aus GPUs, Board und Netzwerk-Interfaces von Mellanox besteht. Das Design des des Nodes ist dem Partner überlassen. Von Nvidia in Aussicht gestellt Anbieter von GPU-Servern auf Basis von HGX A100 sind unter anderem Cray, Dell, Fujitsu, Gigabyte, HP Enterprise, Lenovo und Supermicro. Die neuen System werden in den Cloud-Datacentern von Anbietern wie Amazon, Baidu, Google, Microsoft oder Tencent erwartet.

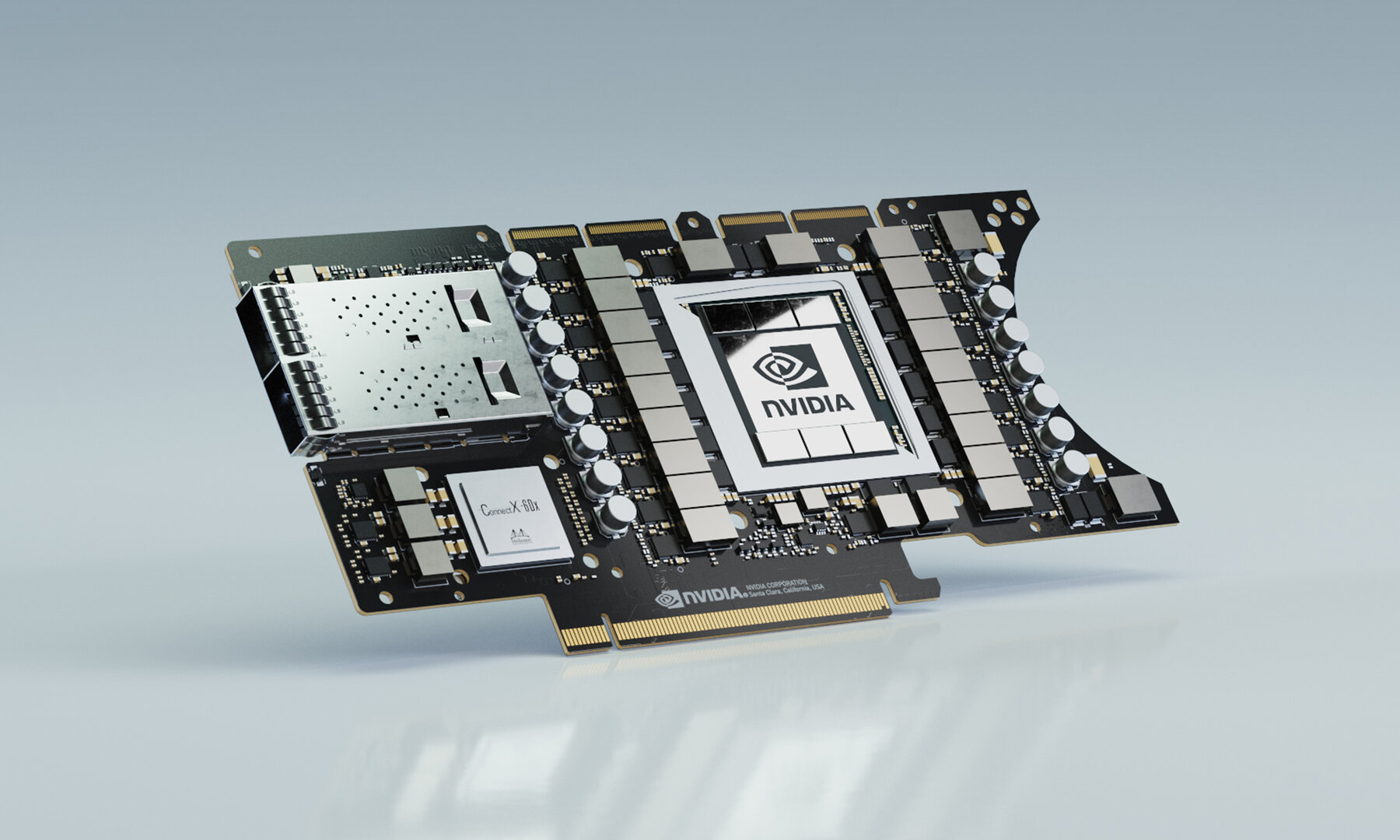

EGX A100 für KI-Leistung in der Edge-Cloud

Doch nicht nur tief in der Cloud im zentralen Datacenter verwurzelt soll Ampere zum Einsatz kommen, sondern auch am Rand der Cloud, um die Rechenleistung punktuell zur Verfügung zu stellen und die Latenzen gering zu halten. Dafür hat Nvidia das EGX A100 mit InfiniBand oder Ethernet von Mellanox vorgestellt. Das Modul mit PCI-Express-Anbindung soll am Rand der Cloud etwa in Nähe eines Mobilfunkmasten, in Fabrikgebäuden zur Steuerung von Robotik oder auch in Krankenhäusern in der Diagnostik zum Einsatz kommen. Nvidia unterteilt diese Aufgabengebiete in Metropolis (Smart City), Clara (Medizin), Aerial (5G), Jarvis (Sprach-KI) und Isaac (Robotik).

Auf der einer klassischen Grafikkarte ähnelnden Steckkarte sitzt die A100-GPU, doch sind beim EGX A100 die Netzwerk-Interfaces gleich mit verbaut. Mellanox stellt über das ConnectX-6 DX zweimal 100 Gbit/s über Ethernet oder InfiniBand zur Verfügung.

Ampere steuert autonome Fahrzeuge

Ein weiteres Anwendungsgebiet für Ampere wird das autonome Fahren, das mit dem neuen Orin-SoC und Ampere-GPUs vom einfachen Assistenzsystem bis zur Level-5-Lösung für vollständig autonomes Fahren in einem Robotaxi skalieren soll. Mit der heutigen Ankündigung bon Ampere hat Nvidia bestätigt, dass das im Dezember 2019 vorgestellte Orin-SoC eine GPU auf Basis der neuen Architektur nutzt. Zur GTC China war noch von einer „Architektur der nächsten Generation“ die Rede.

Orin wurde zur Keynote allerdings nur kurz angeschnitten. In der höchsten Ausbaustufe für Level 5 soll die neuen Nvidia-Drive-Platine mit zwei Orin-SoCs und zwei Ampere-GPUs 2.000 TOPS bei 800 Watt Verbrauch liefern. Weitere Details dürften mit Näherrücken des Marktstarts folgen, der aber erst 2022 erfolgen soll. Weitere Details und ein Deep Dive zur neuen GPU-Architektur Ampere sollen hingegen schon kommende Woche folgen. ComputerBase wird zeitnah alle wichtigen Details vorstellen.

ComputerBase hat Informationen zu diesem Artikel von Nvidia unter NDA erhalten. Die einzige Vorgabe war der frühest mögliche Veröffentlichungszeitpunkt.

Dieser Artikel war interessant, hilfreich oder beides? Die Redaktion freut sich über jede Unterstützung durch ComputerBase Pro und deaktivierte Werbeblocker. Mehr zum Thema Anzeigen auf ComputerBase.