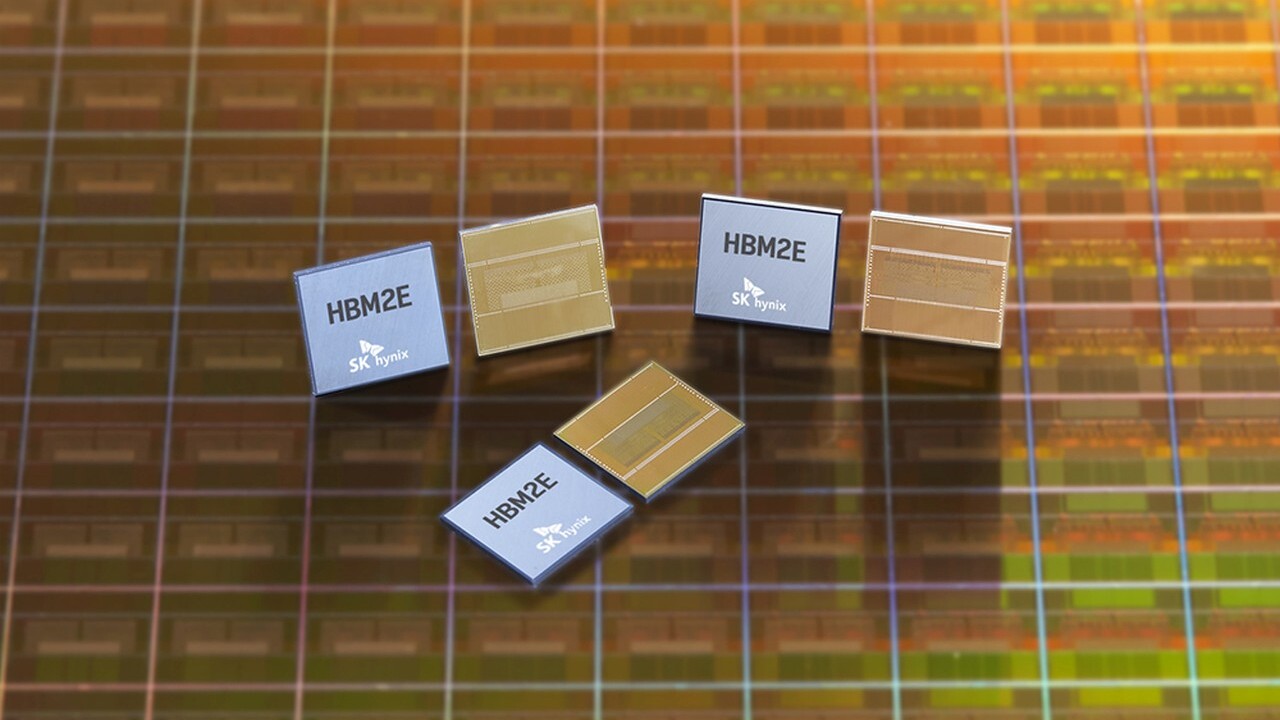

460 GB/s pro Stapel: SK Hynix fertigt HBM2E-Speicher jetzt in Serie

Wie letztes Jahr angekündigt, hat SK Hynix mit der Massenproduktion von HBM2E begonnen. Die neue Generation des High Bandwidth Memory für Grafikkarten und Netzwerklösungen steigert den Durchsatz pro Package auf 460 GB/s gegenüber 307 GB/s bei HBM2. Zudem verdoppelt sich der Speicherplatz auf bis zu 16 GB.

High Bandwidth Memory (HBM) steht für auf hohen Datendurchsatz optimierten Arbeitsspeicher, der aus mehreren übereinander gestapelten und per Silizium-Durchkontaktierung (Through Silicon Via) verbundenen DRAM-Chips besteht. Ein solches HBM-Package (auch „HBM-Stack“ für Stapel) wird etwa auf die Trägerplatine einer GPU gepackt und mittels sogenanntem Interposer mit dieser verbunden. Die Anbindung ist mit 1.024 Bit pro Stack sehr breit aufgestellt und erlaubt einen hohen Datendurchsatz, der beim Einsatz von bis zu vier Stapeln (4.096 Bit) entsprechend steigt.

HBM2E erhöht auf 460 GB/s pro Speicherstapel

War HBM in erster Generation noch mit einer Transferrate von 1 Gbit/s pro Pin und somit 128 GB/s Speicherdurchsatz pro Stack gestartet, wurde dies mit HBM2 auf 256 GB/s verdoppelt. Zwischenzeitlich erreichte HBM2 bis zu 2,4 Gbit/s pro Pin und 307 GB/s pro Stapel. Mit HBM2E steigt der Durchsatz weiter: SK Hynix fertigt nun HBM2E mit 3,6 Gbit/s in Serie, was pro Stack 460 GB/s Durchsatz bedeutet. Konkurrent Samsung hat bisher HBM2E mit 3,2 Gbit/s im Programm. Deshalb spricht SK Hynix jetzt stolz von „der schnellsten DRAM-Lösung der Branche“. Welche Endprodukte den neuen Speicher nutzen werden, wurde aber nicht genannt.

Speicherplatz verdoppelt

Parallel wird mit HBM2E die Speicherkapazität verdoppelt: Fortan werden bis zu acht DRAM-Dies à 16 Gbit (2 GB) gestapelt, womit ein HBM2E-Stack 16 GB Speicherplatz bieten kann. Vor allem für professionelle GPU-Lösungen in den Bereichen AI und High-Performance-Computing, aber auch schnellen 5G-Netzwerklösungen wird der Einsatz von HBM2E erwartet. Werden wie etwa bei der AMD Radeon Instinct MI 60 oder der Nvidia Quadro GV100 erneut vier Stacks eingesetzt, stehen der GPU künftig bis zu 64 GB Speicher mit 1,84 TB/s Speicherbandbreite zur Verfügung.

Das Ende der Fahnenstange ist damit nicht erreicht, denn die Branche plant bereits mit den Nachfolgern HBM3 und HBM4 mit nochmals mehr Duchsatz.