GeForce RTX 3080 FE im Test: Benchmarks in Anwendungen

4/7Warum Tests in Anwendungen?

GPUs können heute mehr als nur (Spiele-)Grafik ausgeben. Seit 2001 ist die Berechnung anderer Aufgaben auf einem extrem parallelisierten Grafikprozessor als GPGPU bekannt. Seit 2007 stellt Nvidia Entwicklern mit CUDA eine Programmier-Technik zur Verfügung, mit der Programmteile standardisiert durch Nvidia-GPUs abgearbeitet werden können. Ein herstellerübergreifendes Pendant wurde mit OpenCL im Jahr 2008 vorgestellt, AMD setzt darauf.

OpenCL und CUDA wurden zu Anfangszeiten vor allem bei wissenschaftlichen und technischen Berechnungen eingesetzt, beschleunigt inzwischen aber immer mehr Anwendungen, die von Kreativen genutzt werden. Mit Nvidia Turing und jetzt auch Ampere stehen über CUDA inzwischen nicht nur die klassischen Shader zur Verfügung, Programme können sich auch der Tensor- und RT-Kerne zur Hardware-Beschleunigung von KI-Algorithmen und Raytracing-Berechnungen bedienen.

Die Bedeutung der GPU im professionellen Umfeld abseits von Rechenzentren und Wissenschaft hat über die letzten Jahre in Folge dessen stetig zugenommen. Aus diesem Grund sind auch Anwendungs-Benchmarks Teil dieses Tests.

Getestet hat ComputerBase in diesem Fall auf einem System mit AMD Ryzen Threadripper 3990X (64K/128T) und 64 GB Corsair Dominator DDR4-3200 auf dem MSI Creator TRx40, um das Spiele-Testsystem nicht doppelt zu belegen.

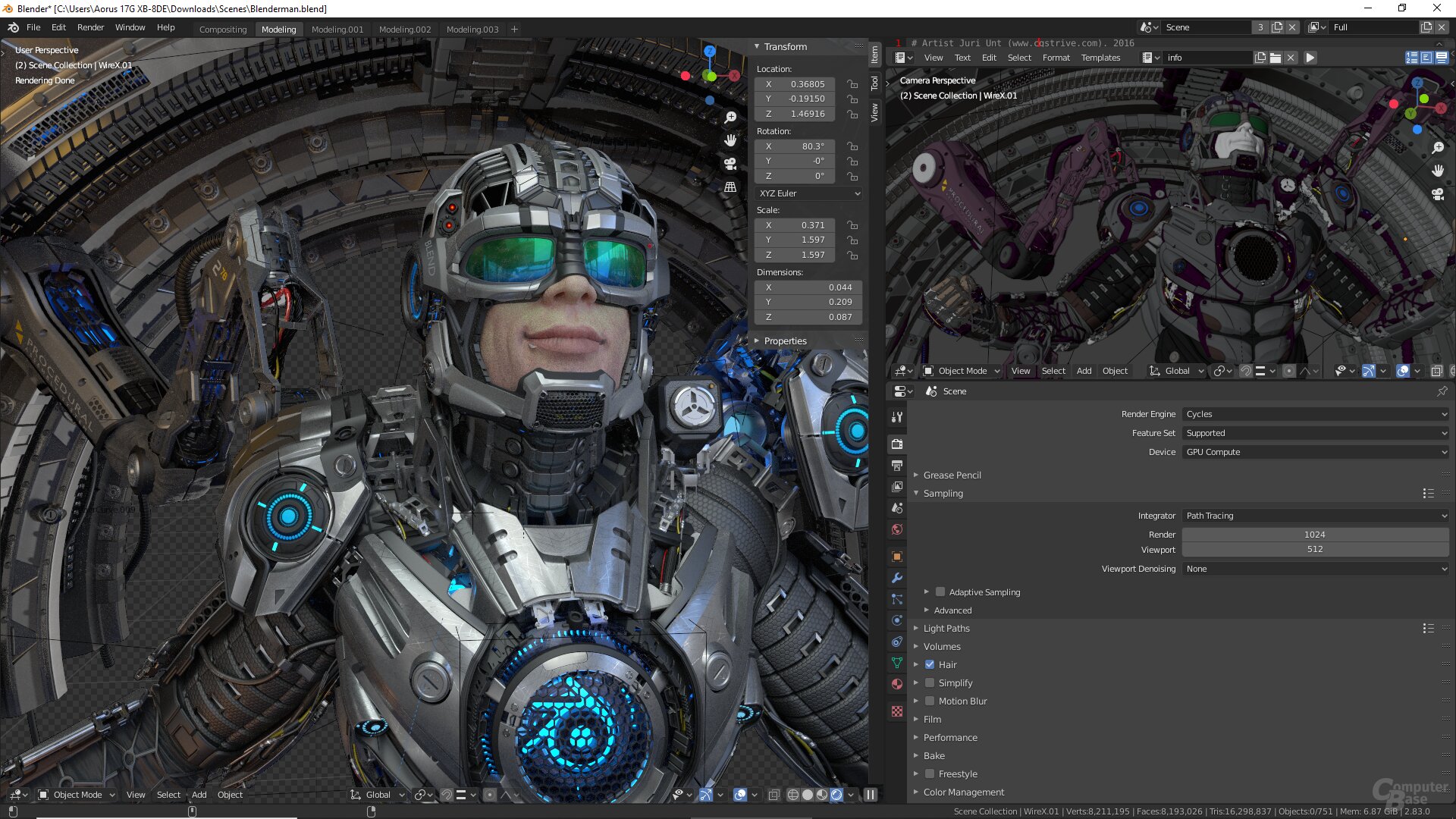

Rendern der Vorschau mit Blender 2.90

Blender ist ein weit verbreitetes Rendering-Programm. Es ist mächtig, frei und für Windows, macOS und Linux verfügbar. Je komplexer das Projekt, desto höher fallen die Anforderungen an die Hardware aus. Und das betrifft nicht nur das finale Rendern beim Projekt-Export, sondern auch die Vorschau.

Neben OpenCL und CUDA steht in dieser Anwendung mittlerweile Nvidias API OptiX zur Verfügung. Mit OptiX lassen sich nicht nur die GPU-Shader, sondern auch die RT- (seit Blender 2.81, zum Rendern) und die Tensor-Kerne (seit Bender 2.83, für Denoising) der Ampere- und Turing-GPUs nutzen. Dabei gilt es allerdings zu bedenken: Die OptiX-Integration ist noch experimentell, noch nicht alle Funktionen der Rendering-Engine Cycles werden unterstützt.

ComputerBase hat für den Benchmark die Zeit gemessen, die bis zum Abschluss der Render-Vorschau im Projekt Blenderman benötigt wird. Grafikkarten von Nvidia wurden mit (Optix) und ohne RT-Kerne (CUDA) getestet. Denoising war im Viewport nicht aktiv. Motion Blur, das die RT-Kerne der Ampere-GPUs jetzt erstmals effizient berechnen können, spielt keine Rolle.

Sowohl mit RT-Kernen als auch ohne erledigt die GeForce RTX 3080 FE die Renderarbeit im Vergleich zur GeForce RTX 2080 Super FE fast doppelt so schnell – die von Nvidia versprochene doppelte Leistung gegenüber einer GeForce RTX 2080 FE wird also erreicht.

Rendern mit OTOY OctaneRender

Das Render-Programm OctaneRender von OTOY, das schon immer für mehr Leistung exklusiv auf GPU-Rendering über CUDA setzte, kann das Rendern durch Nutzung der RT-Kerne der Turing-Architektur inzwischen weiter deutlich beschleunigen. Verfügbar ist die RT-Kern-Unterstützung allerdings weiterhin nur in einer Vorschau auf OctaneRender 2020 sowie einem Benchmark auf Basis von OctaneRender 2019. ComputerBase hat die nicht öffentliche Vorschau OctaneRender 2020.1.5 genutzt.

In OctaneRender legt die GeForce RTX 3080 FE mit RT-Kern-Unterstützung um knapp 50 Prozent gegenüber der GeForce RTX 2080 Ti FE zu, ohne RT-Kerne sind es etwas geringere knapp 40 Prozent. Hier zeigt sich der überproportionale Leistungszugewinn der RT-Kerne von Ampere gegenüber Turing.

Post-Processing und Export in Premiere Pro

Video-Bearbeitung in Adobe Premiere kann an vielen Stellen von der Beschleunigung durch eine GPU profitieren, sei es bei der Anwendung von Effekten in der Live-Vorschau oder beim Export. Seit diesem Frühjahr kann darüber hinaus Nvidias Video-Encoder NVENC zum Exportieren genutzt werden. Eine reine GPU-Anwendung ist Adobe Premiere Pro aber noch lange nicht, die CPU bleibt bei vielen Aufgaben und Filtern noch das Rechenwerk der Wahl.

Um das breite Band an Anforderungen in Adobe Premiere Pro im Test abzubilden, hat ComputerBase auf den PugetBench für Adobe Premiere Pro Version 0.92 Beta (Download und ausführliche Beschreibung) von Puget Systems aus den USA zurückgegriffen.

Der Benchmark ermittelt die Leistung in verschiedenen Export- und Bearbeitungs-Szenarien auf Basis unterschiedlicher Quellmedien. Die gewählten Effekte sind zum Teil stark auf die GPU, zum Teil stark auf die CPU angewiesen. Das zeigt auch das in Punkten gewichtete Endergebnis: Turing und Ampere liegen hier vergleichsweise dicht beieinander.

Werden allerdings die Szenarien herausgegriffen, die die GPU besonders stark fordern, sind auch hier erneut deutliche Vorteile für Ampere sichtbar.

Post-Processing und Export in DaVinci Resolve

Als letzte Anwendung hat ComputerBase das Video-Bearbeitungsprogram DaVinci Resolve getestet. Auch in diesem Fall wurde auf eine Test-Umgebung von Puget Systems zurückgegriffen. Neben dem PugetBench für DaVinci Resolve Version 0.61 Beta (Download und ausführliche Beschreibung) wurden die GPUs im Standard Candle Benchmark von Sascha Haber getestet. Basis war jeweils DaVinci Resolve 16.2

Im Standard-Candle-Benchmark geht die GeForce RTX 3080 FE erneut als Sieger vom Platz, die GeForce RTX 2080 Ti FE wird allerdings nur um 10 bis 30 Prozent geschlagen.

In der Test-Suite von Puget Systems sind es 10 Prozent bei der Nutzung von 8K-Quellmaterial und 21 Prozent bei der Nutzung von 4K-Quellmaterial. Wie bei Adobe Premier Pro gilt, dass viele Szenarien im Test von der CPU abhängig sind, das gleicht die Ergebnisse an. Das Resultat in 8K ist darüber hinaus davon beeinträchtigt, dass der Testlauf nach 20 GB Grafikspeicher verlangt – die GeForce RTX 3090 mit 24 GB sollte hier schon allein deshalb deutlich stärker abschneiden.

AV1-Decoding mit Nvidia NVDEC

Keine klassische Anwendung, aber dennoch ein zukünftiges Alltagsszenario ist das Decoding des zukünftigen Video-Codes AV1. Bisher gelang das nur in Software, was in 8K selbst auf schnellen CPUs und GPUs nicht schnell genug vonstatten ging.

Grafikkarten auf Basis von Nvidia Ampere sind die ersten GPUs, die den neuen Internet-Video-Codec AV1 nativ in Hardware beschleunigen können. Damit können erstmals AV1-8K-Videos mit 60 FPS über YouTube flüssig wiedergegeben werden. Intels Xe-iGPU in Tiger Lake wird es in Kürze ebenfalls können.

GeForce-RTX-3000-Grafikkarten können AV1 über Nvidias Hardware-Decoder (NVDEC) decodieren. Voraussetzung sind aktuell allerdings noch Windows 10, die AV1 Extension aus dem Microsoft Store sowie Chrome 85 oder neuer. Unterstützt wird AV1 Profile 0 (monochrome/4:2:0, 8/10 bit) bis zu 8K mit 60 FPS. Details dazu liefert das Whitepaper zu Ampere GA102 ab Seite 33 (PDF).

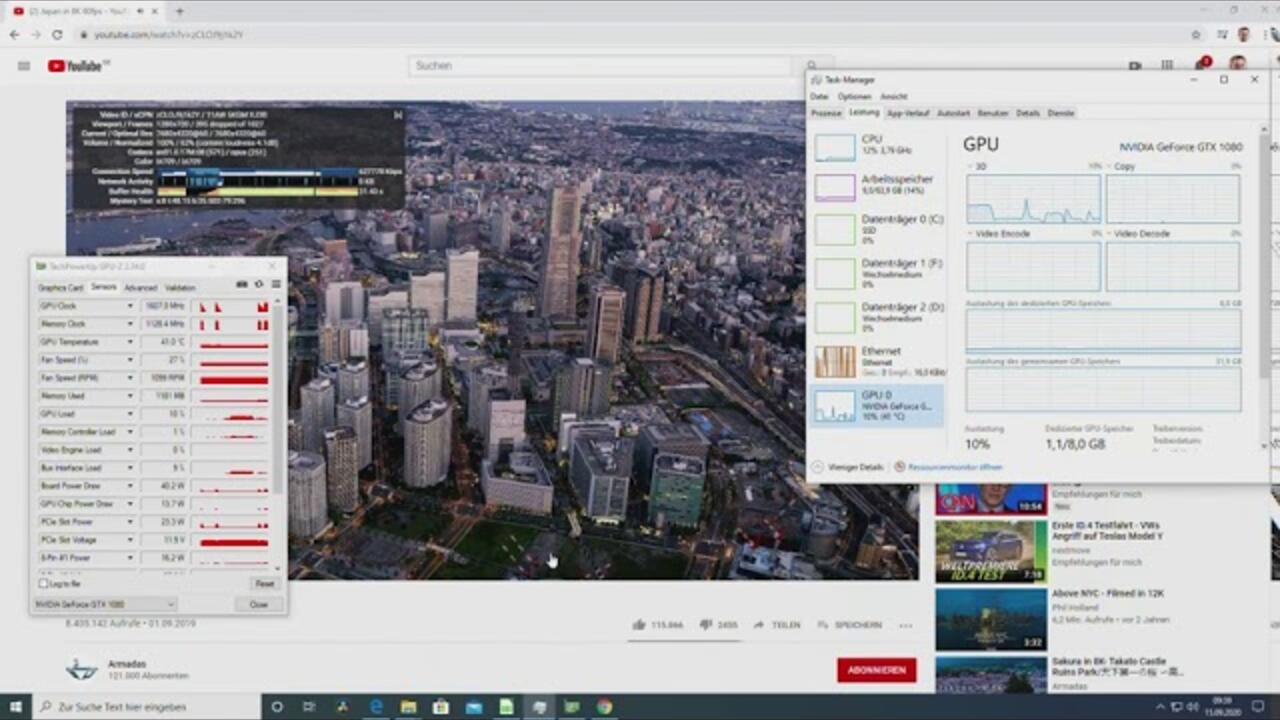

Das nachfolgende Video zeigt die Wiedergabe des Videos „Japan in 8K“ auf YouTube mit AV1-Codec sowohl in 4K als auch 8K auf einer GeForce RTX 3080 (Ampere) im Vergleich zur GeForce RTX 2070 Super (Turing) und GeForce GTX 1080 (Pascal).

Bei der GeForce GTX 1080 und GeForce RTX 2070 Super werden in 8K über die Hälfte der Frames ausgelassen, zu langsam läuft das Decoding über die Shader und die CPU (Ryzen Threadripper 3990X) ab. Die GeForce RTX 3080 schafft die Wiedergabe mit 60 FPS über NVDEC hingegen mit wenigen ausgelassenen Frames. Ein zum Vergleich herangezogenes 8K-Video mit 30 FPS wurde gänzlich ohne „dropped Frames“ abgespielt.