Nvidia GeForce RTX 3090 im Test: Die größte GeForce für eine kleine Zielgruppe

tl;dr: Nach der sehr guten GeForce RTX 3080 schickt Nvidia das Flaggschiff GeForce RTX 3090 ins Rennen, das mit mehr Shadern und 24 GB punkten soll. Im Test bieten Custom-Designs von Gigabyte und MSI mehr Leistung, groß ist der Vorsprung auf die RTX 3080 für 800 Euro Aufpreis aber nicht. Selbst Nvidia nennt die Zielgruppe klein.

Zum Fall des Embargos am 24. September „fehlten“ Benchmarks der GeForce RTX 3090 in den Auflösungen 1.920 × 1.080 sowie 2.560 × 1.440. Nvidias neues Consumer-Flaggschiff kann zwar erst ab Ultra HD die Stärken ausspielen, doch wurde im Forum auch nach Testergebnissen in geringeren Auflösungen gefragt.

ComputerBase hat das zum Anlass genommen und auch Benchmarks der GeForce RTX 3090 in Full HD und WQHD durchgeführt. Ein kurzer Test mit dem neuesten Treiber GeForce 456.55, der die Stabitätsprobleme behebt, hat zudem gezeigt, dass sich an der Performance trotz minimalen Änderungen am Taktverhalten nichts geändert hat.

Marktstart mit geringer Stückzahl

Mit der GeForce RTX 3080 (Test) hat Nvidia vor einer Woche schwere Geschütze aufgefahren. Die im Vergleich zur GeForce RTX 2080 (Super) sehr hohe Performance zum überraschend niedrigen Preis ergab ein beeindruckendes Gesamtpaket, erste Custom-Designs der RTX 3080 von Asus und MSI (Test) schnitten ebenfalls sehr überzeugend ab. Die Ausgangslage für den Start der GeForce RTX 3090 eine Woche später ist vermeintlich gut.

Vermeintlich deshalb, weil seit dem Verkaufsstart der GeForce RTX 3080 nicht die Freude über ausgelieferte Gaming-Ampere-Grafikkarten und deren Leistung, sondern Frust über leergefegte Lager, stornierte Bestellungen, steigende Marktpreise und Abstürze in Spielen herrscht. Dass sich Nvidia einen Tag vor Marktstart der GeForce RTX 3090 schon im Vorfeld für deren zu Anfang schlechte Verfügbarkeit entschuldigt hat, hat die Hoffnung auf Besserung bei diesem Modell im Keim erstickt.

Since we built GeForce RTX 3090 for a unique group of users, like the TITAN RTX before it, we want to apologise upfront that this will be in limited supply on launch day. We know this is frustrating, and we’re working with our partners to increase the supply in the weeks to come.

Dabei ist der Preis der neuen GeForce RTX 3090 mit 1.499 Euro in der Tat schon von Haus aus hoch angesetzt: 800 Euro trennen GeForce RTX 3080 und GeForce RTX 3090 in der Founders Edition für ein – ebenfalls offiziell einen Tag im Vorfeld – in Aussicht gestelltes Leistungsplus von 10 bis 15 Prozent und es stellt sich die Frage, wer hier überhaupt zur von Nvidia als „ganz besondere Gruppe Anwender“ bezeichneten Zielgruppe gehört?

Dieser Artikel wird darauf ebenso eine Antwort finden wie auf die Frage, welche Leistung das neue Topmodell im Alltag wirklich zu bieten hat – in Spielen und in Anwendungen.

Keine Founders Edition zum Testen

Für den Test der GeForce RTX 3090 standen der Redaktion Custom Designs von MSI und Gigabyte zur Verfügung. Eine Founders Edition hat Nvidia in diesem Fall hingegen selbst nicht zur Verfügung gestellt. Und das ging nicht nur der Redaktion, sondern auch vielen weiteren, sonst in der Regel damit bedachten Publikationen so.

Als Grund hat Nvidia eine sehr geringe Anzahl an Mustern genannt. In Anbetracht der auch von CEO Jensen Huang herausgestellten Ingenieurleistung der „FE“, die eine gigantische Grafikkarte mit einem quasi aufgeblasenen GeForce-RTX-3080-Kühler hervorgebracht hat, ist das eine Überraschung – auch wenn die FE nicht in jeden Rechner passt, sie ist aus der Ferne betrachtet definitiv ein Vorzeigeobjekt.

Im Einzelfall sieht das Nvidia auch weiterhin so: Noch vor dem Fall des Embargos für handfeste Tests hat Nvidia beispielsweise die international bekannten YouTube-Tech-Schwergewichte Linus Tech Tips und MKBHD gesponserte Videos auf Basis der Founders Edition zum Thema „8K Gaming“ erstellen und veröffentlichen lassen. Für viele Tester gab es diese Variante aber nicht.

Das ist die GeForce RTX 3090

Die GeForce RTX 3090 setzt wie die GeForce RTX 3080 auf die große GA102-GPU, hat aber deutlich mehr Ausführungseinheiten aktiviert. Sie nutzt sieben statt sechs aktive GPCs und damit 82 anstatt 68 Streaming Multiprocessors. Das ergibt mit 10.496 ALUs 21 Prozent mehr Rechenwerke als auf der GeForce RTX 3080. Der Vollausbau vom GA102 ist dies derweil immer noch nicht, denn physikalisch sind 2 weitere SMs vorhanden.

Mehr Recheneinheiten benötigen aber auch mehr Strom, damit der Takt nicht deutlich niedriger ausfallen muss, zumal auf der GeForce RTX 3090 auch zusätzliche Chips ihren Tribut zollen. Nvidia legt die TDP der GeForce RTX 3090 deshalb bei 350 Watt fest, sodass die Grafikkarte 30 Watt mehr als die RTX 3080 aufnehmen darf. Der durchschnittliche Turbo ist mit 1.700 MHz angegeben, was nur 10 MHz weniger als auf der GeForce RTX 3080 sind.

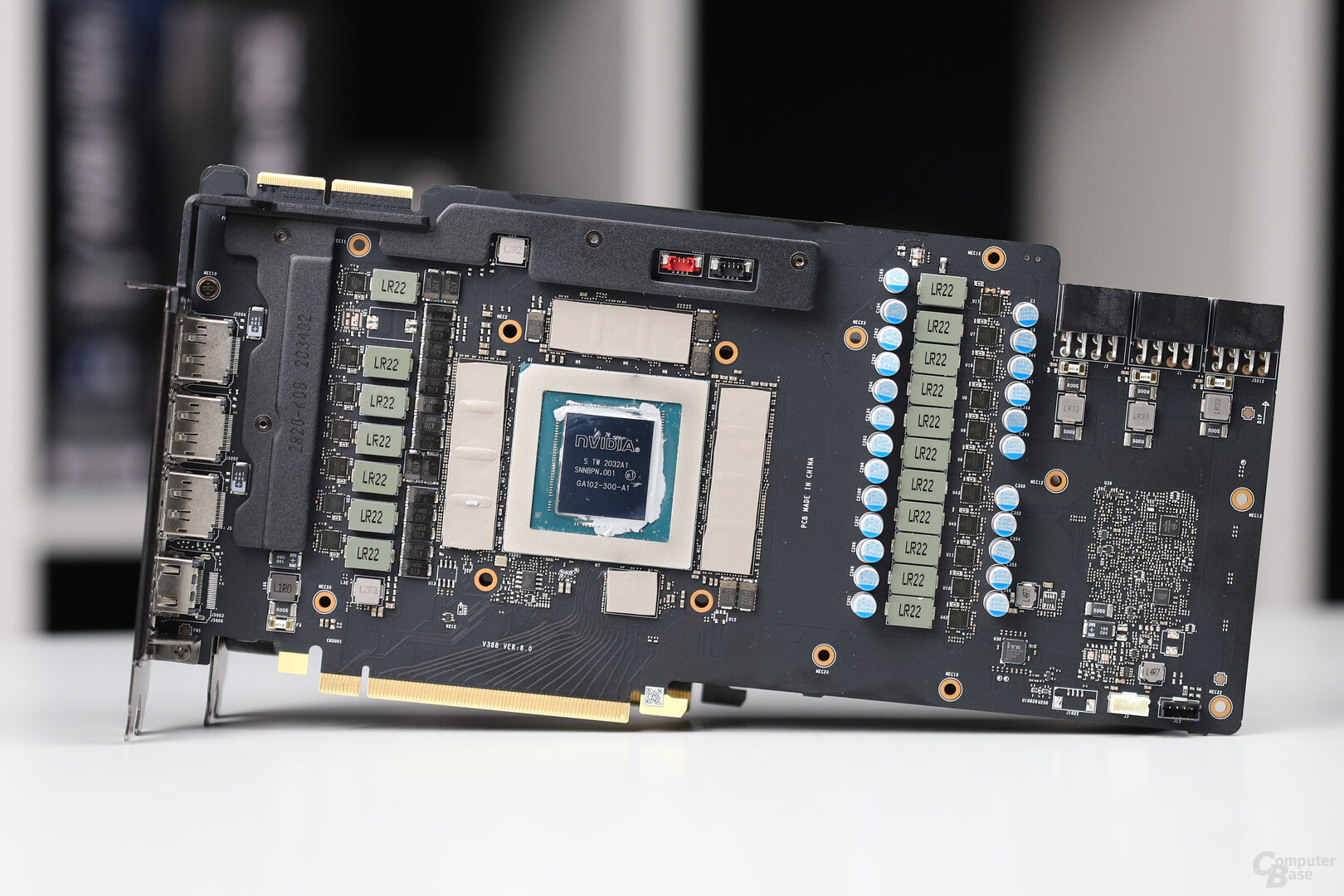

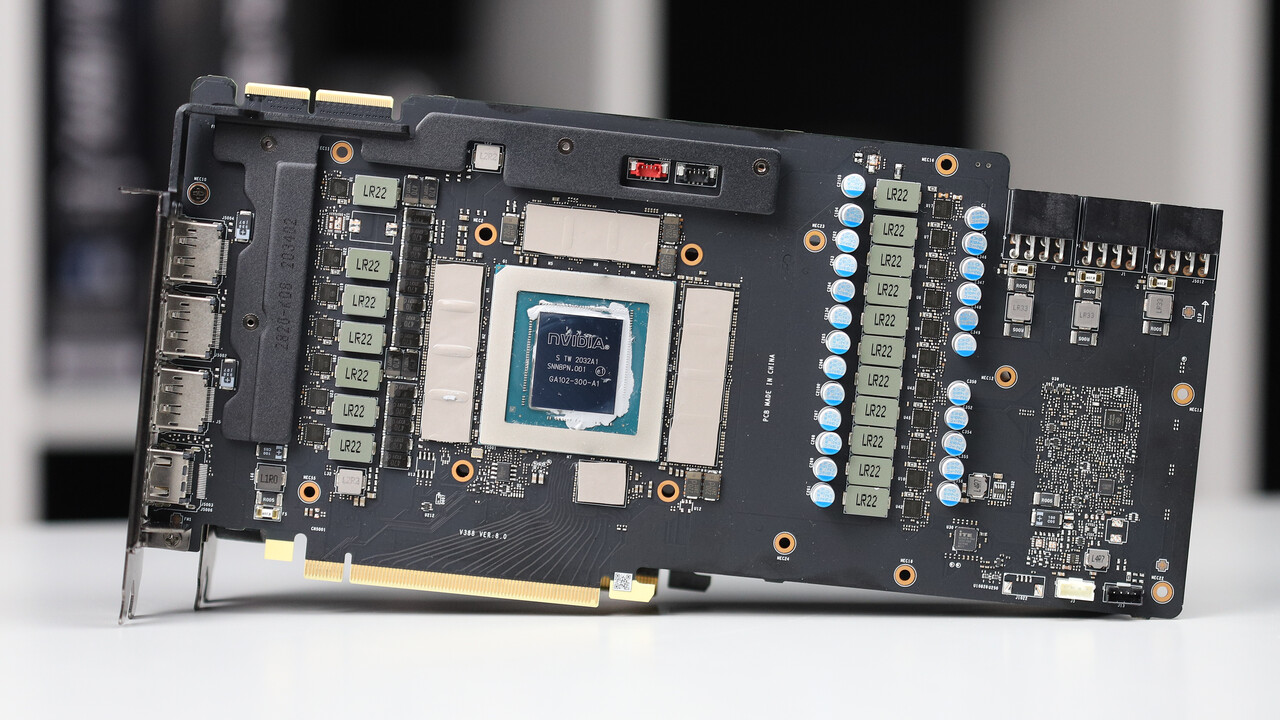

Das zweite, nach elektrischer Leistung gierende und im Endeffekt noch viel wesentlichere Ausstattungsmerkmal der GeForce RTX 3090 ist der Speicher: Satte 24 GB GDDR6X bietet das neue Consumer-Flaggschiff und damit mehr als doppelt so viel wie die GeForce RTX 3080 mit 10 GB. Zu diesem Zweck sind 12 und damit 2 weitere Speichermodule auf der Vorderseite des PCBs angebracht und noch einmal 12 weitere auf der Rückseite. Die 24 Module ergeben bei einer Kapazität von 1 GB pro Modul 24 GB.

Mit zwei weiteren 32-Bit-Speicherchips wächst das Speicherinterface von 320 Bit auf 384 Bit an und der Speichertakt wird von 9.504 MHz auf 9.752 MHz erhöht. Damit ist die Speicherbandbreite mit 936 GB/s noch einmal 23 Prozent höher als auf der GeForce RTX 3080.

Details zur Ampere-Architektur gibt es im Technik-Artikel

Wer genauere Details zur Technik der GeForce RTX 3090 in Erfahrung bringen möchte, sollte einen Blick in den Technik-Artikel zur GeForce RTX 3000 werfen. Dieser behandelt neben der GeForce RTX 3080 auch die GeForce RTX 3070 und das aktuelle Flaggschiff GeForce RTX 3090 in aller Ausführlichkeit.

| RTX 3090 | RTX 3080 | RTX 3070 | RTX 2080 Ti | |

|---|---|---|---|---|

| Architektur | Ampere | Turing | ||

| GPU | GA102 | GA104 | TU102 | |

| Prozess | Samsung 8 nm Custom-Prozess | 12 nm TSMC | ||

| Chipgröße | 628 mm² | 393 mm² | 754 mm² | |

| Transistoren | 28 Mrd. | 17,4 Mrd. | 18,6 Mrd. | |

| GPC | 7 | 6 | 6 | 6 |

| SM | 82 | 68 | 46 | 68 |

| FP32-ALUs pro SM | 128 | 64 | ||

| FP32-ALUs | 10.496 | 8.704 | 5.888 | 4.352 |

| RT-Kerne | 82 2nd Gen | 68 2nd Gen | 46 2nd Gen | 68 1st Gen |

| RT-Kerne + ALUs synchron | Ja | Nein | ||

| Tensor-Kerne | 328 3rd Gen | 272 3rd Gen | 184 3rd Gen | 544 2nd Gen |

| Basis-Takt | 1.400 MHz | 1.440 MHz | 1.500 MHz | 1.350 MHz |

| Boost-Takt | 1.700 MHz | 1.710 MHz | 1.730 MHz | 1.545 MHz |

| FP32-Leistung | 35,7 TFLOPS | 29,8 TFLOPS | 20,4 TFLOPS | 13,4 TFLOPS |

| FP16-Leistung | 35,7 TFLOPS | 29,8 TFLOPS | 20,4 TFLOPS | 26,9 TFLOPS |

| FP16-Leistung über Tensor | 143 TFLOPS 285 TFLOPS (Sparsity) |

119 TFLOPS 238 TFLOPS (Sparsity) |

82 TFLOPS 163 TFLOPS (Sparsity) |

107,6 TFLOPS |

| Textureinheiten | 328 | 272 | 184 | 272 |

| ROPs | 112 | 96 | 96 | 88 |

| Speicher | 24 GB GDDR6X | 10 GB GDDR6X | 8 GB GDDR6 | 11 GB GDDR6 |

| Speicher-Geschwindigkeit | 19,5 Gbps | 19,0 Gbps | 14,0 Gbps | 14,0 Gbps |

| Speicher-Interface | 384 Bit | 320 Bit | 256 Bit | 352 Bit |

| Speicher-Bandbreite | 936 GB/s | 760 GB/s | 448 GB/s | 616 GB/s |

| L2-Cache | 6 MB | 5 MB | 4 MB | 6 MB |

| TDP | 350 Watt | 320 Watt | 220 Watt | 250 Watt |

| Slot-Anbindung | PCIe 4.0 | PCIe 4.0 | PCIe 4.0 | PCIe 3.0 |

| UVP | 1.499 Euro | 699 Euro | 499 Euro | 1.259 Euro |

Warum GeForce und nicht Titan?

Ein fast vollständig aktivierter High-End-Chip und 24 Gigabyte Speicher zum Spitzenpreis, das erinnert nicht nur an die Titan RTX (Test) auf Basis von Turing, Nvidia selbst nennt beide in einem Atemzug und sieht im Titan-RTX-Kunden den typischen RTX-3090-Käufer: Professionelle Kreative, Wissenschaftler auf dem Gebiet der künstlichen Intelligenz, aber – und das wieder deutlicher hervorgehoben als zuletzt – auch „Extreme Gamer“, die die neue Welt des „8K Gamings“ erleben möchten. Im Blog-Beitrag zu den Lieferschwierigkeiten einen Tag vor dem Start ist dieser Punkt den professionellen allerdings nachgestellt. Warum also GeForce RTX 3090 und nicht wieder ohne GeForce einfach „Titan“?

Ein Blick in die Historie der Titan-Modelle zeigt: Die Frage stand mit Ausnahme der 1. Version und bei den letzten drei Generationen ganz besonders immer im Raum.

Ein Ausflug in die Geschichte der Titan

Die erste Titan überhaupt war im Jahr 2013 ganz klar als High-End-Gaming-Grafikkarte für Enthusiasten gedacht und hieß mit Nvidia GeForce GTX Titan auch genau so. Sie brachte erstmals die ganz große GPU auf eine Grafikkarte für Spieler und bot mehr Leistung, Speicherbandbreite und Speichervolumen als die GeForce-GTX-Konkurrenz. Die Nachfolger GeForce GTX Titan Black, GeForce GTX Titan Z und GeForce GTX Titan X liefen ebenfalls in der Gaming-GPU-Sparte, waren den Aufpreis gegenüber den jeweils aktuellen Topmodellen in der Regel aber nicht mehr wert, zumal der Preis stetig stieg. Titan-Grafikkarten verirrten sich im Niemandsland zwischen Gaming und Arbeit.

Mit Pascal erfolgte der Abschied aus der GeForce-Serie, Titan X, Titan Xp, Titan V und zuletzt Titan RTX liefen zwischen GeForce und Quadro als eigene Serie. Sie boten stets die schnellste GPU und den meisten Speicher, GeForce-Custom-Designs waren in Spielen jedoch ab und zu noch eine Ecke schneller und deutlich günstiger. Von Generation zu Generation stellte Nvidia dann auch deutlich klar: Titan ist in erster Linie eine günstige Quadro-Alternative für Profis und die kauften sie am Ende auch.

Mit Ampere hat sich Nvidia nun wieder dazu entschieden, eine Grafikkarte mit großem Chip und viel Speicher, deren Zielgruppe in öffentlichen Blog-Posts zuvorderst aus Profis besteht, als GeForce zu vermarkten. Der Anspruch, 8K Gaming für absolute Enthusiasten möglich zu machen, und ein gegenüber der Titan RTX fast halbierter Preis, füttern diesen Wechsel mit Argumenten. Auf der anderen Seite grenzt Nvidia die potentielle Zielgruppe derart stark ein, dass sich der Konzern ob der sich anbahnenden Nachfrage nicht in der Lage sieht, die Nachfrage zum Start zu befriedigen – gesponsorte 8K-Gaming-Videos auf YouTube und der zwar immer noch hohe, aber gegenüber der Titan RTX deutlich gesenkten Preis trugen mit hoher Wahrscheinlichkeit auch dazu bei.

Langer Ausflug, kurzer Sinn: Die GeForce RTX 3090 könnte auch eine Titan sein. Ob sie es eher hätte sein sollen, stellt dieser Test fest.

GeForce RTX 3090 von Gigabyte & MSI im Test

Getestet hat ComputerBase die GeForce RTX 3090 zum Start mit zwei Custom Designs. Gigabyte schickt die eher schlicht gehaltene GeForce RTX 3090 Gaming OC ins Rennen, während MSI das derzeitige Top-Modell GeForce RTX 3090 Gaming X beisteuert – das Schwestermodell der bereits getestete MSI GeForce RTX 3080 Gaming X Trio (Test). Beide Grafikkarte versuchen mit klarem Fokus auf das eigene Kühlsystem um die Gunst der Käufer zu werben.

Gigabyte RTX 3090 Gaming OC im Detail

Gigabyte schickt mit der GeForce RTX 3090 Gaming OC kein Premium-Design ins Rennen, auch wenn es sich nicht um das Einstiegsmodell handelt. Haptik und Optik halten dann auch beide nicht mit dem Wettbewerber mit. Dafür sollte die Variante günstiger sein, doch eine UVP konnte der Hersteller im Vorfeld nicht nennen.

Der Kühler der Grafikkarte ist ausladend, was sowohl Länge, Breite als auch Höhe betrifft. Zwei Alu-Kühler, die über gleich 7 Heatpipes miteinander und mit der GPU in Verbindung stehen, sorgen für die Verteilung der Wärme auf eine möglichst große Fläche. Auffällig sind die Lühler, denn der vorderste hat nur einen Durchmesser von 80 mm, während die zwei anderen im 90-mm-Design gehalten sind. Das hat den Vorteil, dass der Kühler vorne nicht so breit ausfallen muss, weswegen sich die Grafikkarte ungewöhnlich einfach im Gehäuse verschrauben lässt. Viele andere moderne Grafikkarten sind vorne so hoch, dass die Schraube an der Slotblende kaum noch zu erreichen ist – das Problem gibt es bei der Gigabyte nicht.

Die Stromstecker sind „innovativ“

Das selbst entwickelte PCB ist recht kurz gehalten, der Kühler steht ein ganzes Stück über. Ein bereits im Vorfeld im Netz diskutiertes Kuriosum zieht auf der Rückseite seine Blicke auf sich: Die zwei 8-Pin-PCIe-Anschlüsse sind nicht klassisch an das PCB gelötet, sondern enden nach einem „Verlängerungskabel“ in zwei flachen Steckern, die nicht dem neuen 12-Pin-Standard bei der Founders Edition entsprechen. Möglich, dass Gigabyte es bei dem kurzen PCB vermeiden wollte, die 8-Pin-Anschlüsse schon weiter vorne aus der Karte zu führen. Funktional hat das keine Auswirkungen.

Gigabyte gibt für die GeForce RTX 3090 Gaming OC eine durchschnittliche Taktraten von 1.755 MHz an, die GA102-GPU ist also um 55 MHz übertaktet. Mit 370 Watt darf der 3D-Beschleuniger zudem 20 Watt mehr als Nvidias Founders Edition aufnehmen, maximal 390 Watt sind einstellbar. Der 24 GB große GDDR6X-Speicher von Micron taktet mit den normalen 9.752 MHz.

Bei der RGB-Beleuchtung gibt es wenig spektakuläres zu berichten. Sie besteht aus dem beleuchteten Schriftzug und einer kleinen RGB-Leiste. Das Wechseln der Farben verläuft nicht perfekt stufenlos. Monitore können an der Gigabyte GeForce RTX 3090 Gaming X über zwei DisplayPort-1.4- oder zwei HDMI-2.1-Anschlüsse angesteuert werden.

Mit 1.372 g wiegt die Gigabyte GeForce RTX 3090 Gaming OC etwas mehr als die Founders Edition der RTX 3080, aber weniger als deren bisher getestete Custom-Designs. Die MSI GeForce RTX 3090 Gaming X Trio ist deutlich schwerer.

| Angabe in Gramm | |

|---|---|

| Asus GeForce RTX 3080 TUF OC | 1.387 g |

| MSI GeForce RTX 3080 Gaming X | 1.557 g |

| Nvidia GeForce RTX 3080 Founders Edition | 1.348 g |

| Gigabyte GeForce RTX 3090 Gaming OC | 1.372 g |

| MSI GeForce RTX 3090 Gaming X Trio | 1.569 g |

MSI GeForce RTX 3090 Gaming X Trio im Detail

Die MSI GeForce RTX 3090 Gaming X Trio gleicht der GeForce RTX 3080 Gaming X enorm, optisch sind die Grafikkarten abseits des NVLink-Anschlusses kaum zu unterscheiden. Damit handelt es sich auch bei Nvidias Flaggschiff-Adaption um eine Premium-Karte, nicht aber zwangsweise um das Spitzenmodell. Der Hersteller fährt gewöhnlich zu einem späteren Zeitpunkt noch eine Lightning-Variante auf. Die UVP der GeForce RTX 3090 Gaming X Trio beträgt 1.589 Euro. Das sind 90 Euro mehr als bei der FE.

Auch auf der GeForce RTX 3090 Gaming X Trio schickt MSI den 14 cm hohen sowie 32 cm langen Tri-Frozr-2-Kühler in den Einsatz. Er besteht aus zwei Alu-Kühlern, die mittels 7 Heatpipes miteinander verbunden sind und die Grafikkarte auf ein Gewicht von über 1,5 kg bringen. Abgerundet wird der Kühler durch eine Graphen-Kunststoff-Verbundmaterial-Backplate, die sich durch ihre hohe Stabilität und Wärmeleiteigenschaft auszeichnen soll. Drei im Durchmesser 90 mm breite Axial-Lüfter sorgen für die nötige Frischluft. Bei niedrigen Temperaturen halten diese für einen lautlosen Betrieb an.

Ein zweites BIOS gibt es nicht

Das auch von MSI selbst entwickelte PCB bietet 11 Spannungswandlerkreise und ungewöhnlich viel Freiraum, ist in diesem Fall aber auch fast genauso lang wie der Kühler. Ein zweites BIOS gibt es nicht, obwohl es offenbar einmal vorgesehen war: Es gibt sowohl die Lötstellen als auch die Bezeichnung (Silent und Gaming), einzig der Schalter selbst fehlt. Das PCB entspricht dem der RTX 3080 Gaming X Trio, es gibt jedoch einen zusätzlichen Spannungswandlerkreis.

Die GeForce RTX 3090 Gaming X taktet mit einem durchschnittlichen Turbo von 1.785 MHz und damit 85 MHz höher als die Founders Edition (+30 MHz ggü. Gigabyte Gaming OC). Der 24 GB große GDDR6X-Speicher arbeitet mit den normalen 9.752 MHz. Mit 370 Watt darf auch die Grafikkarten 20 Watt mehr aufnehmen als Nvidia für die GeForce RTX 3090 eigentlich vorsieht. Das Tuning-Potenzial bei der Grafikkarte ist aber gering, das Power-Limit lässt sich nur auf 380 Watt hochschrauben. Drei 8-Pin-Stromstecker sind für den Betrieb notwendig.

RGB fällt auf der Gaming X qualitativ ab

Die GeForce RTX 3090 Gaming X bietet wie das kleinere Schwestermodell eine RGB-Beleuchtung, zum restlichen Auftritt passen will sie aber nicht. Neben zwei Mal drei kurzen Streifen auf der Kühleroberseite gibt es am Rand der Backplate eine Lichtleiste, in der die jeweilige Position der sechs LEDs allerdings sehr gut zu sehen ist – und ihr Abstand ist nicht immer gleich. Das trübt den Auftritt, der insgesamt nicht stimmig wirkt, weiter. Monitore können mit drei DisplayPort-1.4-Schnittstellen und einem HDMI-2.1-Anschluss angesteuert werden.

Technische Eckdaten im direkten Vergleich

Wie die nachfolgende direkte Gegenüberstellung nach dem jeweiligen Vergleich mit der Founders Edition abschließend verdeutlicht, ist die Gaming (X) Trio kürzer, aber höher als die Gigabyte Gaming (OC).

Für den Vergleich mit der Founders Edition muss in diesem Fall die GeForce RTX 3080 herhalten, eine GeForce RTX 3090 Founders Edition lag der Redaktion nicht vor.

Beide Grafikkarten sind deutlich ausladender als das im direkten Vergleich fast schlank wirkende RTX-3080-FE-Modell. Mit 32,5 Zentimetern Länge überragen sie die FE in dieser Dimension um ganze vier Zentimeter.

| Merkmal | Gigabyte RTX 3090 Gaming OC |

MSI RTX 3090 Gaming X Trio |

|

|---|---|---|---|

| Karte | PCB-Design | Gigabyte | MSI |

| Länge, Breite | 32,5 cm, 13,0 cm | 32,5 cm, 14,0 cm | |

| Stromversorgung | 2 × 8-Pin | 3 × 8-Pin | |

| Kühler | Design | 2,8 Slots | Tri Frozr II, 2,7 Slots |

| Kühlkörper | Alu-Kern/Radiator 7 Heatpipes |

Alu-Kern/Radiator 6 Heatpipes |

|

| Lüfter | 2 × 85 mm (axial) 1 × 80 mm (axial) |

3 × 90 mm (axial) | |

| Lüfter abgeschaltet (2D) | Ja | ||

| Anlaufdrehzahl | 1.000 rpm ab 58°C | 700 rpm ab 65°C | |

| Takt (Stromsparmodus) |

GPU-Basis | 1.395 (210) MHz | |

| GPU-Durchschnitt | 1.755 MHz | 1.785 MHz | |

| GPU-Maximum | 1.980 MHz | 2.025 MHz | |

| Speicher | 9.752 (405) MHz | ||

| Speichergröße | 24 GB GDDR6X, Micron | ||

| Leistungsaufnahme | Standard TDP | 370 Watt | |

| Maximale TDP | 390 Watt | 380 Watt | |

| Anschlüsse | 2 x DisplayPort 1.4 DSC 2 x HDMI 2.1 |

3 x DisplayPort 1.4 DSC 1 x HDMI 2.1 |

|

Die Taktraten unter Last

In Spielen taktet die Gigabyte GeForce RTX 3080 Gaming OC maximal mit 1.920 MHz, die MSI GeForce RTX 3080 Gaming X dagegen mit 1.965 MHz. Dies ist aber nur der Fall, solange das Power Limit nicht limitiert – was quasi immer der Fall ist. Beide Grafikkarten rennen durchweg in diesen Begrenzer, der bei 370 Watt gesetzt ist. Die GeForce RTX 3090 tut das mit mehr Vehemenz als die GeForce RTX 3080, was zur Folge hat, dass die Taktraten allgemein stark schwankend ausfallen.

MSI hat auf der GeForce RTX 3090 Gaming X offenbar eine gut funktionierende GA102-GPU erwischt, oder eine effizientere Stromversorgung umgesetzt, denn trotz identischem Power Limit sind die Frequenzen durchweg höher als bei dem Konkurrenzmodell. Der höchste Takt liegt in COD: Modern Warfare an, dort arbeitet die Grafikkarte mit 1.800 bis 1.965 MHz. Der niedrigste Takt lässt sich dagegen in The Division 2 mit 1.545 bis 1.830 MHz messen. In den meisten Spielen liegt der Wert irgendwo dazwischen. Die Gigabyte GeForce RTX 3090 Gaming OC taktet durchweg niedriger. In COD liegen bei der Grafikkarte 1.755 bis 1.920 MHz an, in The Division 2 sind es noch 1.620 bis 1.740 MHz.

Je höher der aktuelle Takt, desto niedriger der Folgetakt

Wie bei der GeForce RTX 3080 zeigt sich auch bei der GeForce RTX 3090, dass auf einen kurzfristig erreichten hohen eine umso geringere Frequenz folgt, damit das Power Limit im Schnitt gehalten wird. Und die Hersteller gehen hier offensichtlich anders vor. So taktet die MSI GeForce RTX 3090 Gaming X im Maximum durchweg höher als die Gigabyte GeForce RTX 3090 Gaming OC, im Minimum daher aber oft, wenn auch nicht immer, niedriger. Je deutlicher eine Ampere-Grafikkarte ins Power Limit läuft, desto größer ist die Spanne zwischen höchster und niedrigster Frequenz in einem Spiel.

| Spiel (3.840 × 2.160) | MSI GeForce RTX 3090 Gaming X |

Gigabyte GeForce RTX 3090 Gaming OC |

|---|---|---|

| Maximaler Takt in Spielen | 1.965 MHz | 1.920 MHz |

| Anno 1800 | 1.815-1.920 MHz [PT] | 1.815-1.875 MHz [PT] |

| Borderlands 3 | 1.665-1.920 MHz [PT] | 1.725-1.785 MHz [PT] |

| COD: Modern Warfare | 1.800-1.965 MHz [PT] | 1.755-1.920 MHz [PT] |

| Control | 1.605-1.965 MHz [PT] | 1.620-1.740 MHz [PT] |

| Death Stranding | 1.845-1.920 MHz [PT] | 1.785-1.860 MHz [PT] |

| Doom Eternal | 1.725-1.860 MHz [PT] | 1.620-1.740 MHz [PT] |

| F1 2020 | 1.740-1.905 MHz [PT] | 1.740-1.800 MHz [PT] |

| Gears Tactics | 1.620-1.875 MHz [PT] | 1.710-1.755 MHz [PT] |

| Ghost Recon Breakpoint | 1.770-1.905 MHz [PT] | 1.770-1.815 MHz [PT] |

| Horizon Zero Dawn | 1.845-1.920 MHz [PT] | 1.815-1.875 MHz [PT] |

| Metro Exodus | 1.590-1.875 MHz [PT] | 1.665-1.770 MHz [PT] |

| Red Dead Redemption 2 | 1.860-1.950 MHz [PT] | 1.785-1.860 MHz [PT] |

| Resident Evil 3 | 1.770-1.875 MHz [PT] | 1.740-1.830 MHz [PT] |

| Shadow of the Tomb Raider | 1.815-1.905 MHz [PT] | 1.755-1.830 MHz [PT] |

| The Division 2: Warlords of New York | 1.545-1.830 MHz [PT] | 1.620-1.740 MHz [PT] |

| Trackmania | 1.740-1.935 MHz [PT] | 1.785-1.860 MHz [PT] |

| Wolcen: Lords of Mayhem | 1.680-1.965 MHz [PT] | 1.725-1.845 MHz [PT] |

| [P] = Power Target limitiert, [T] = Temperature Target limitiert | ||

Das Power-Limit lässt sich auf der GeForce RTX 3090 in den beiden getesteten Varianten nur marginal erhöhen. Auf der GeForce RTX 3090 Gaming X ist bereits bei 10 zusätzlichen Watt und damit bei 380 Watt Schluss, bei der GeForce RTX 3090 Gaming OC sind es immerhin plus 20 Watt und damit 390 Watt. Das ändert in beiden Fällen nichts daran, dass die Grafikkarten immer noch ins Power-Limit laufen – die Frequenz fällt nur ein paar MHz höher aus. Das Temperature-Target spielt bei beiden Custom-Modellen der GeForce RTX 3090 dagegen keine Rolle.

Ihr habt die Wahl: Macht mit bei den Reader's Choice Awards 2025 und bestimmt eure Hersteller des Jahres!