Nvidia Reflex (Analyzer) im Test: Testergebnisse, Benchmarks und Fazit

2/2Testergebnisse und Benchmarks

ComputerBase stand für einen Test der 360-Hz-Monitor Alienware AW2521H mit neuem G-Sync-Modul inklusive Reflex Latency Analyzer sowie GeForce Experience 3.20.6.5 vorab zur Verfügung. Erste Eindrücke und Benchmarks zu Nvidia Reflex wurden auf einem AMD Ryzen 5 3600 mit 16 GB DDR4-3200 und den Grafikkarten Asus GeForce RTX 3080 TUF Gaming, MSI GeForce GTX 1650 Gaming X sowie Asus Radeon RX 5600 XT TUF Gaming gesammelt. Die beiden GeForce setzen das GPU-Limit an ganz unterschiedlichen Punkten. Die Radeon wiederum zeigt, dass der Reflex-Analyzer nicht nur im Zusammenhang mit einer GeForce zum Einsatz kommen kann.

Darüber hinaus stand der Redaktion die Logitech G Pro Wireless mit experimenteller Firmware zur Verfügung, die es der Maus erlaubt, ihre interne Latenz zu melden. Logitechs erste marktreife Reflex-Maus soll gegen Ende 2020 aber auf einem anderen Modell basieren.

Nvidias Reflex Latency Analyzer im Einsatz

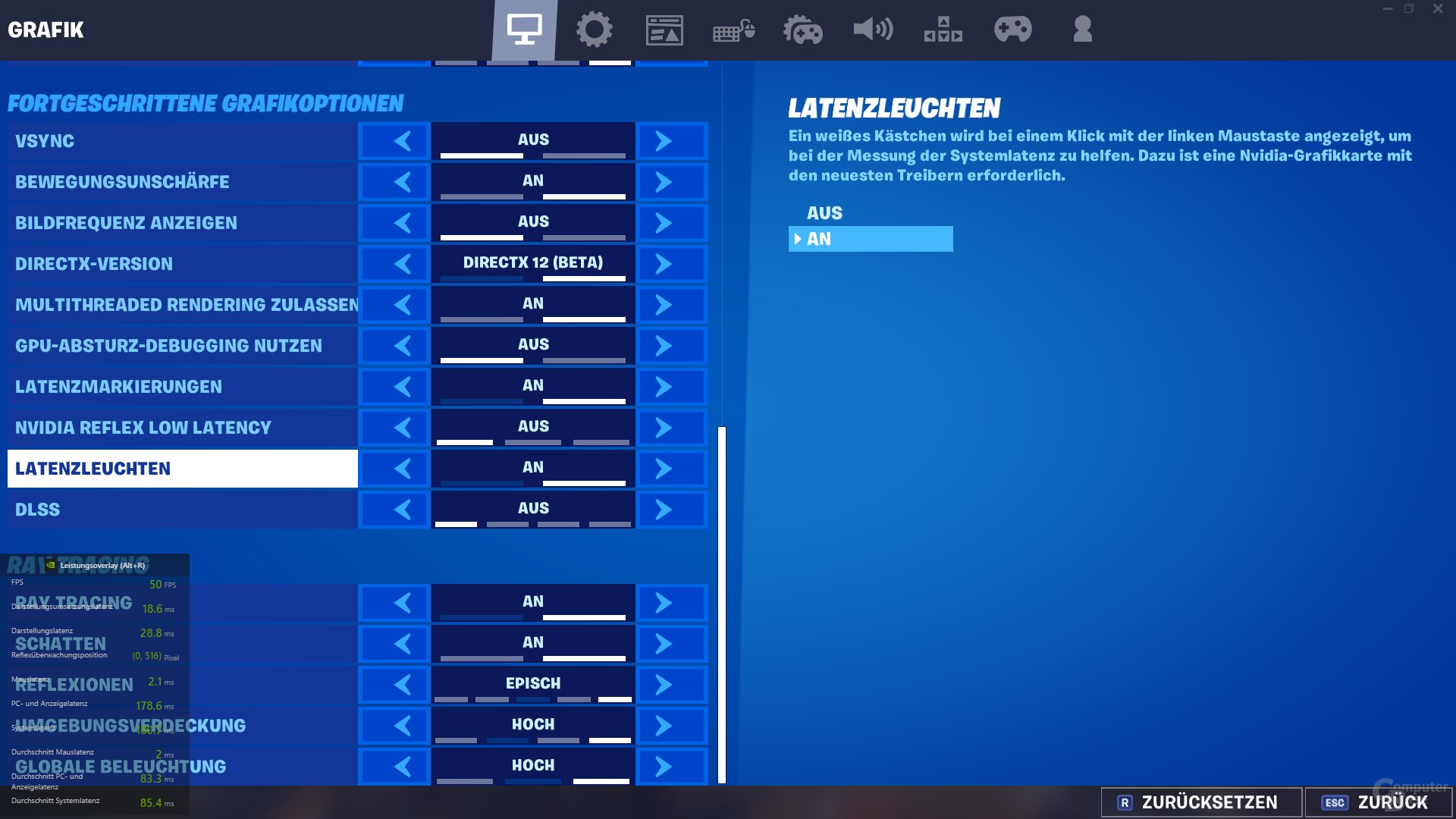

Die Einrichtung des Alienware AW2521H für die Messung der Systemlatenz geht leicht von der Hand. Nachdem die Maus an den rechten der beiden USB-Ports angeschlossen und der Monitor per USB mit dem PC verbunden wurde, kann der Reflex Latency Analyzer über das On-Screen-Display (OSD) aktiviert werden. Neben An/Aus gibt es Optionen für die Position und Größe des zu überwachenden Bereiches auf dem Bildschirm, die Sensibilität der Erkennung und ob das „Monitoring Rectangle“ sichtbar oder unsichtbar ist. Immer oben links auf dem Bildschirm findet sich bei aktiviertem Analyzer die native Latenzanzeige des Monitors (PC+Display-Latenz: von Eingang Mausklick bis Darstellung Reaktion).

Dieselbe PC+Display-Latenz findet sich im neuen Performance-Overlay „Latenz“ in GeForce Experience wieder. Das Tool gibt darüber hinaus die aktuellen FPS, die Render-Latenz („Darstellungslatenz“) sowie – in diesem Fall mit der experimentellen Logitech G Pro Wireless möglich – die Mauslatenz aus und bildet aus der Kombination von Maus- und PC+Display-Latenz die Gesamtlatenz. Die Darstellungslatenz wird kontinuierlich über den Treiber ermittelt, die PC+Display- sowie die Mauslatenz und deren Summe nur bei jedem Mausklick. Aus den letzten 20 Messungen wird der Durchschnitt gebildet.

Auf den Messpunkt kommt es an

Nicht ohne Grund geht Nvidia im der Presse zur Verfügung gestellten Reviewer's Guide im Detail darauf ein, wie und in welchem Spiel am besten die Latenz gemessen werden sollte. In der Praxis erweist sich dieser Punkt in der Tat als nicht immer leicht umzusetzen.

Am einfachsten gelingt es in Fortnite: Der Titel bietet nicht nur bereits den Nvidia-Reflex-Low-Latency-Modus, sondern optional auch ein weiß aufleuchtendes Quadrat am linken Bildschirmrand als Reaktion auf jeden Mausklick. Wird dem Reflex Latency Analyzer dieser Bereich zur Überwachung gegeben, dann liegt der Messung immer die direkte grafische Reaktion auf die Mauseingabe zugrunde.

Viele Waffen, nicht nur in Fortnite, zeigen nämlich nur eine schwache oder sogar eine verzögerte grafische Reaktion auf den Input, was die Messung verfälscht. In Counter-Strike: Global Offensive bietet es sich beispielsweise an, mit der AWP in den Zoom zu gehen und den schwarzen Bereich beobachten zu lassen, weil dieser beim Schuss direkt verschwindet, während die Waffe selber keine perfekt messbare Reaktion zeigt.

Für die nachfolgenden Messungen wurde das Display immer mit 360 Hertz und im E-Sport-Modus mit minimaler Latenz betrieben.

Nvidia Reflex SDK im Benchmark

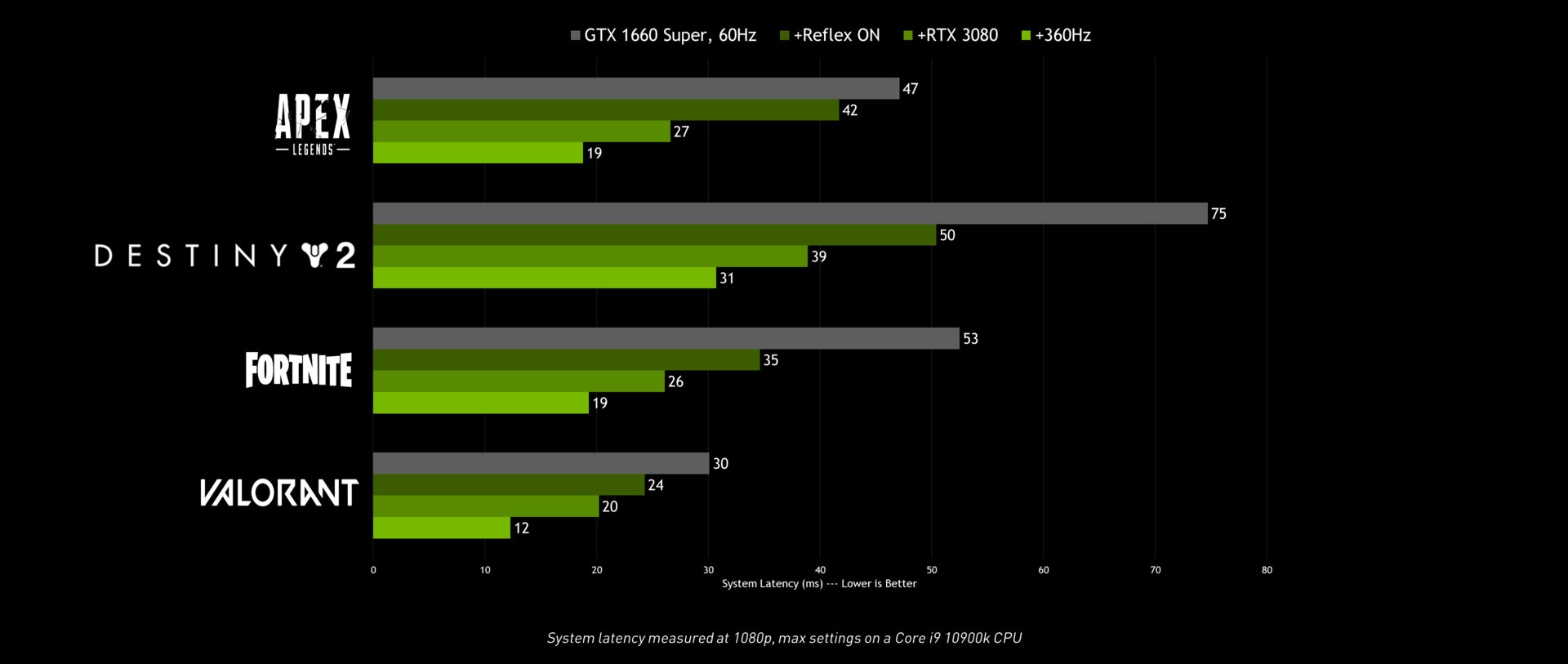

Fortnite ist auch in Bezug auf die Wirkung des Nvidia-Reflex-SDKs der Vorzeigetitel im Testparcours. In Full HD bei epischen Details fällt die Systemlatenz (beim Mausklick auf der Maus bis zur Ausgabe) im GPU-Limit auf einer GeForce GTX 1650 (52,5 FPS in der Testsequenz) von 74 ms auf 44 ms ab. Damit liegt die Latenz nur noch 30 Prozent höher als mit einer GeForce RTX 3080, die mit denselben Einstellungen 115 FPS erreicht und in dieser Disziplin doppelt so schnell rendert. Dass der eigentliche Render-Vorgang nur einen geringen Einfluss auf die Latenz hat, wird hier sehr deutlich.

Ebenso deutlich wird, dass die viel schnellere GeForce RTX 3080 in dem Szenario jedwede Verzögerung vor dem eigentlichen Rendering im Keim erstickt, denn auf dieser Grafikkarte bringt das Aktivieren von Reflex im Spiel keinen signifikanten Vorteil mehr. Anders sieht es aus, wenn Raytracing ohne DLSS in maximaler Stufe aktiviert und die Last auf der GPU so deutlich erhöht wird (45 FPS). In diesem Fall senkt Reflex die Gesamtlatenz abermals um über 30 Prozent. Der von Nvidia seit Sommer 2019 im Treiber integrierte Ultra-Low-Latency-Modus zeigt ebenfalls eine Wirkung bei der Latenz, sie fällt allerdings viel kleiner aus.

Interessant ist, dass die von GeForce Experience gemeldete Render-Latenz, die die Verzögerung der „Render Queue“ enthalten soll, nicht von Reflex beeinflusst wird. Dabei war genau in diesem Punkt die eigentliche Verbesserung zu erwarten.

Kleiner, aber immer noch vorhanden sind die Auswirkungen in den drei anderen von ComputerBase bisher getesteten Spielen mit Reflex-Integration. Das liegt vermutlich auch daran, dass Apex Legends und Valorant die GPU in der nativen Auflösung der ersten Reflex-Displays nicht wesentlich fordern. Von der Engine respektive der CPU bereitgestellte Render-Aufgaben bleiben deshalb kaum in der Warteschlange liegen. In Ultra HD dürfte es anders aussehen – je langsamer die GPU, desto deutlicher. Messen lässt sich das mit den neuen Reflex-Displays allerdings nicht, denn sie setzen alle auf Full HD bei 360 Hertz. Dem Ultra-Low-Latency-Modus im Treiber ist Reflex in jedem Fall überlegen.

Nvidia hat auch in diesen Titeln teils wesentlich stärkere Effekte gemessen, allerdings war das System ein anderes und der Vorteil aus Reflex oft nur in Teilaspekt der im Diagramm aufgezeigten positiven Latenz-Entwicklung. Das Schöne ist: Mit einem Monitor mit Reflex Latency Analyzer werden alle diese Schritte messbar.

Weitere Latenz-Messungen

Wie wäre es beispielsweise damit, den Latenzvorteil einer höheren Bildwiederholfrequenz des Displays zu messen? Rein rechnerisch und „fühlbar“ war das schon immer möglich, auf einem der neuen Monitore kann man den Effekt aber auch messen. Die Erwartung: Durch den Wechsel von 60 auf 360 Hertz sinkt die Gesamtlatenz im Durchschnitt um 7 ms. Warum?

Im Durchschnitt wartet ein fertig gerendertes Bild an einem 60-Hertz-Monitor 8,3 ms auf seine Darstellung – im Optimalfall 0 ms, im schlechtesten Fall genau 16,7 ms. Auf einem 360-Hertz-Display wird hingegen alle 2,8 Millisekunden ein neues Bild dargestellt, die durchschnittliche Wartezeit beträgt also 1,4 Millisekunden – zum 60-Hz-Display ist das eine Differenz von 6,9 ms.

Und siehe da: Fortnite – als Beispiel – zeigt diese rund 7 ms im Schnitt über 20 Messungen auch auf. Der Effekt durch das Reflex SDK ist in diesem Titel am Ende aber noch wesentlich größer. Und auch an anderer Stelle erscheint das Einspartpotential größer zu sein, nur kann der Spieler es (Engine) nicht selber nutzen.

Auch die Auswirkungen des Zusammenspiels aus VSync, Bildwiederholfrequenz und FPS in der Testsequenz lässt sich mit einem Reflex-Display jetzt messen, nachfolgend beispielhaft erneut in Fortnite mit einer Szene, die einmal mehr und einmal weniger als 60 FPS liefert. Der potentiell gravierende Einfluss auf VSync auf einem 60-Hertz-Display wird sichtbar.

Das GeForce-Experience-Overlay und G-Sync-Funktionalitäten bleiben Spielern mit Radeon RX auf einem der neuen Reflex-Displays zwar verborgen, der Monitor kann aber weiterhin die Latenz zwischen Eingang des Mausklicks und Ausgabe des Resultates messen. Mit dem Display von Alienware lässt sich so beispielsweise auch AMDs Low-Latency-Modus „Anti Lag“ testen.

In Summe über alle Benchmarks wird deutlich, welches Potential die Latenzmessung für die weitere Analyse von Abläufen beim Berechnen von Spielen bietet. Die Latenz in Teilstücke zerlegen zu können, deckt wesentliche Einflussfaktoren auf. In der Regel ist ihre Summe viel bedeutender als die Berechnung des Bildes durch die GPU an sich.

Fazit

360-Hertz-Displays mit dem Nvidia Reflex Latency Analyzer gewähren völlig neue Einblicke in das Zusammenspiel aus CPU, GPU, Display, Treiber und Spiele-Engine. Für den Heimanwender war es bis dato so gut wie unmöglich, die Verzögerung zwischen Input an der Maus und Output auf dem Display zu messen. Mit Nvidias Plattform ändert sich das.

Warum fühlt sich das eine Spiel bei 120 FPS und guten Frametimes auf demselben System viel flüssiger an als das andere mit vergleichbaren Eckdaten? Ein Blick auf die gemessene Verzögerung vom Klick zur Ausgabe liefert die Antwort und zugleich weitere Details. Denn auch wenn der Nvidia Reflex Latency Analyzer nur die gesamte Latenzkette und die darin enthaltene Render-Latenz ermitteln kann, wird deutlich, was schon immer auf der Hand lag: Die GPU ist nur zum Teil für die Latenz verantwortlich – je schneller sie ist, desto deutlicher spielen CPU, Display, aber auch die Spiele-Engine eine Rolle.

Auch den Einfluss von VSync oder G-Sync respektive FreeSync in Abhängigkeit von FPS im Spiel oder des Displays lässt sich mit Reflex-Monitoren in Zukunft ohne sündhaft teures Equipment exakt herausarbeiten, Optimierungen im Treiber oder Spielen besser nachvollziehen.

Den Einflussfaktor Spiel bzw. Spiele-Engine geht Nvidia mit dem Reflex SDK zum Start von Reflex selbst an und Fortnite zeigt im Testparcours, welchen Unterschied der Fokus auf die Latenz machen kann, wenn die GPU das Limit in der Pipeline bildet. In anderen getesteten Titeln ist der Unterschied mit dem genutzten System zwar nicht so groß, aber immer noch vorhanden.

Nvidia begründet den Einsatz der Technologie in 360-Hertz-Displays mit der Ausrichtung auf den E-Sport-Einsatz, nirgendwo sonst seien minimale Latenzen so wichtig wie in diesem Metier. Auch erste 8.000-Hertz-Mäuse zielen nicht ohne Grund auf dieselbe Zielgruppe.

Das macht den Reflex Latency Analyzer allerdings nicht minder spannend für Enthusiasten, die ihr System verstehen und auf Basis dieses Verständnisses optimieren möchten. Die verstehen wollen, warum das eine Spiel sich so, das andere Spiel sich aber ganz anders anfühlt. Oder noch besser nachvollziehen wollen, welche Auswirkungen ein Upgrade auf das eigene System hatte.

Diese Zielgruppe dürfte sich ebenfalls über einen UHD-Bildschirm mit Reflex Latency Analyzer freuen, zumal in dieser Auflösung viel häufiger ein GPU-Limit vorliegt, von dem Spiele mit Reflex-Integration profitieren können. Dass es diese Displays geben wird, will Nvidia nicht ausschließen, schließlich sei die neue Funktion Teil des G-Sync-Moduls. Mit der E-Sport-Ausrichtung ist die Vorstellung entsprechender Produkte aber zurzeit sehr unwahrscheinlich.

Eine Reflex-Maus braucht es wiederum den ersten Eindruck nach nicht. Die Latenz der Maus ist mit um die 2 ms derart gering, dass sie im Gesamtbild untergeht. Da Nvidia bekannte E-Sports-Mäuse und deren Latenz per Datenbank in die Systemlatenz mit einfließen lassen will, dürften die meisten Spieler die „Gesamtlatenz“ auch ohne Reflex-Maus treffsicher abbilden können.

ComputerBase hat das Display, die Maus sowie die Vorabversion von GeForce Experience von Nvidia unter NDA zum Testen erhalten. Die einzige Vorgabe war der frühestmögliche Veröffentlichungszeitpunkt. Eine Einflussnahme der Hersteller auf den Testbericht fand nicht statt, eine Verpflichtung zur Veröffentlichung bestand nicht.

Dieser Artikel war interessant, hilfreich oder beides? Die Redaktion freut sich über jede Unterstützung durch ComputerBase Pro und deaktivierte Werbeblocker. Mehr zum Thema Anzeigen auf ComputerBase.

Downloads

-

Nvidia App Download

3,6 SterneNvidia App ermöglicht die automatische Optimierung von PC-Spielen und Updaten der Treiber.

- Version 11.0.1.184 Deutsch

- Version GeForce Experience 3.28.0.417 Deutsch