Zweiphasen-Tauchkühlung: Microsoft kühlt Server mit bei 50 °C kochender Flüssigkeit

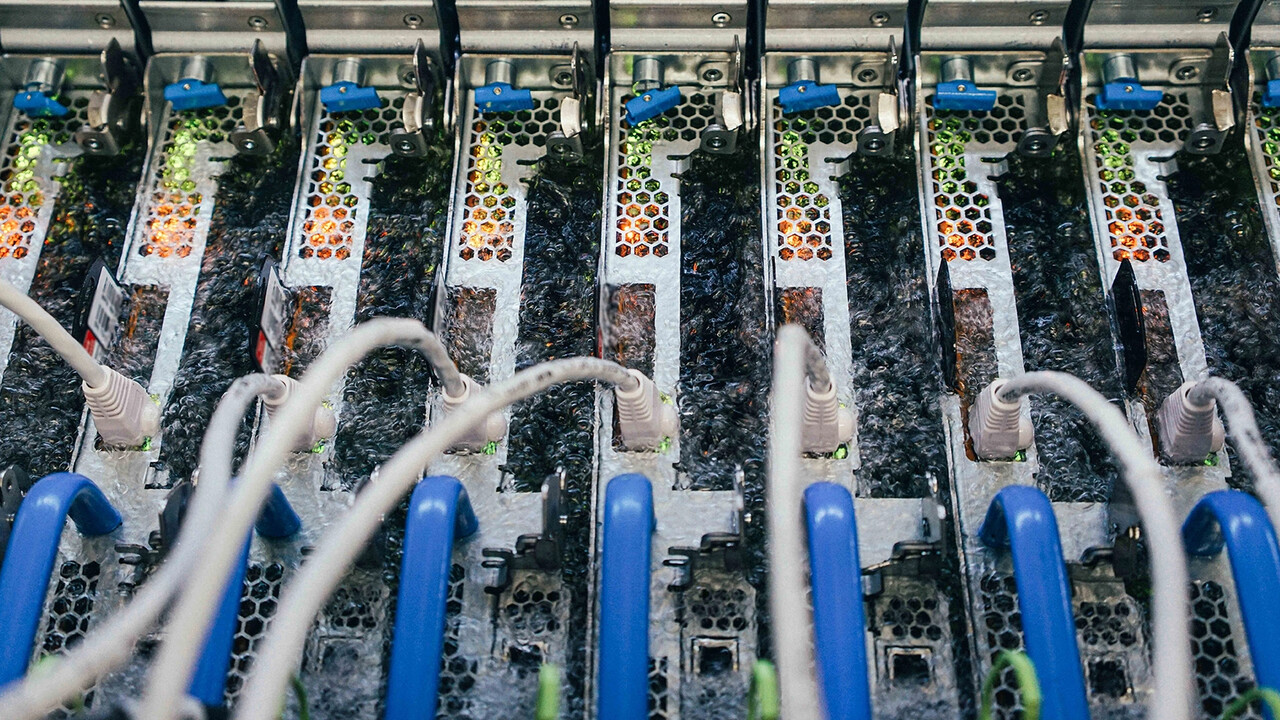

Microsoft berichtet von Erfolgen mit einer Zweiphasen-Tauchkühlung für Azure-Server, die in Zukunft breit zum Einsatz kommen könnte. Das so genannte „Two-Phase Immersion Cooling“, nutzt eine bereits ab 50 Grad Celsius kochende Flüssigkeit, der Siedepunkt von Wasser liegt unter Normaldruck auf Meereshöhe bei 100 Grad Celsius.

Siedende Flüssigkeit hält Server auf Temperatur

Wie das Unternehmen in einem Bericht seiner Serie Innovation Stories unter dem Titel To cool datacenter servers, Microsoft turns to boiling liquid erläutert, liegt der große Vorteil der Zweiphasen-Tauchkühlung in der schnellen Abfuhr der Wärme direkt an den Komponenten. Beim Verdampfen der nicht näher benannten Flüssigkeit wird – wie bei Wasser – am meisten Energie aufgenommen. Auf die nicht leitende Flüssigkeit statt Wasser zu setzen hat neben dem Kurzschluss-Aspekt damit noch einen Vorteil: Der Hauptteil der Abwärme kann effizient schon bei 50 °C „abgekocht“ werden, was auf den Komponenten noch keine kritische Temperatur zur Folge hat. Ganz im Gegenteil: In Microsofts Test hätte die Ausfallrate der Hardware niedriger gelegen als bei klassischer Luftkühlung.

Im Inneren des Tanks trifft der Dampf, der von der kochenden Flüssigkeit aufsteigt, auf einen aktiv gekühlten Kondensator im Tankdeckel, der den Dampf wieder in Flüssigkeit umwandelt und auf die eingetauchten Server zurück regnen lässt, wodurch ein geschlossener Kühlkreislauf entsteht. Es bedarf also weiterhin eines zweiten Kühlkreislaufes für den Kondensator.

Erstmals in einer Produktivumgebung

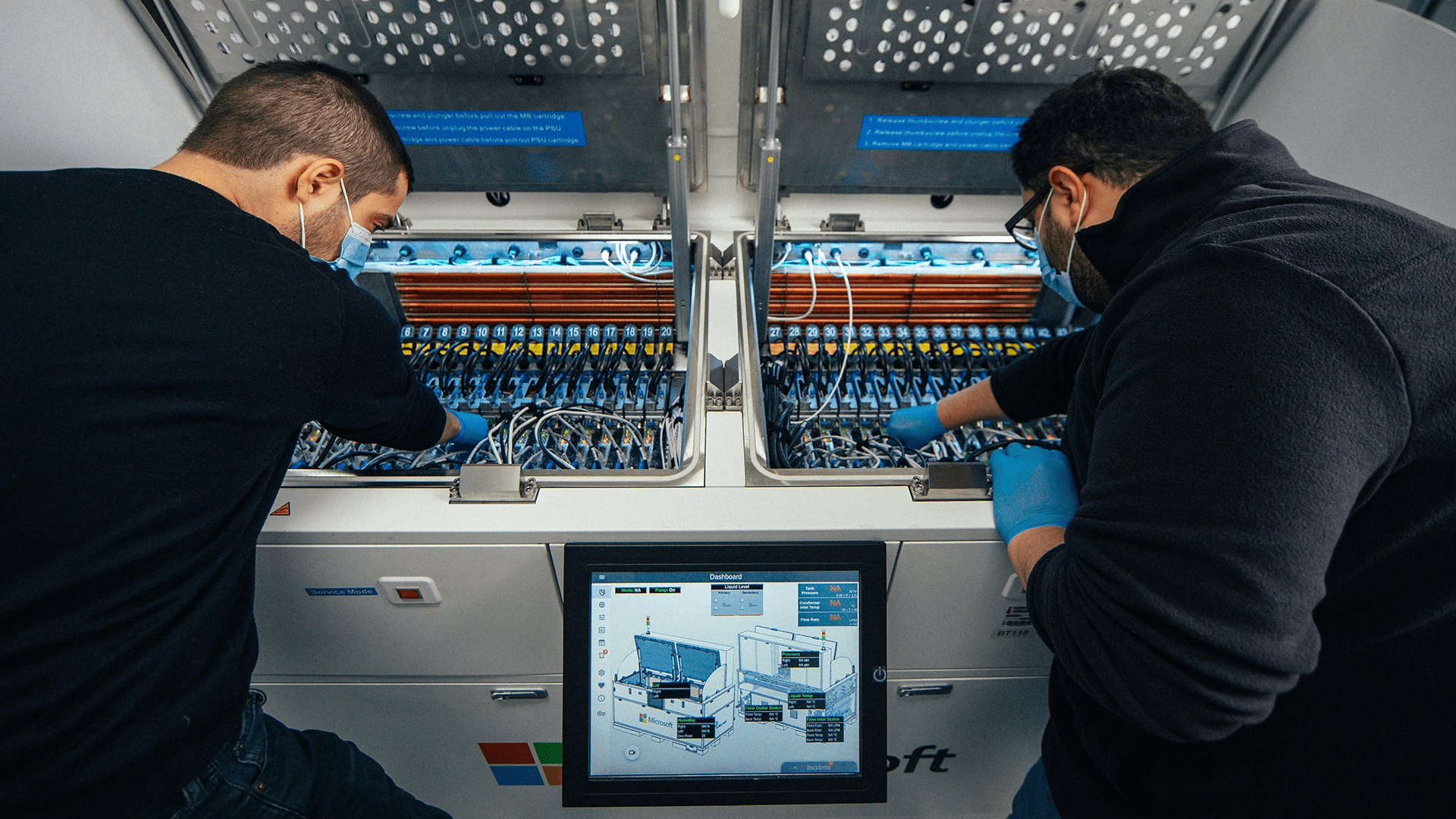

„Wir sind der erste Cloud-Anbieter, der die Zweiphasen-Tauchkühlung in einer Produktionsumgebung einsetzt“, erklärt Husam Alissa, einer der beiden leitenden Ingenieure der Abteilung „Datacenter Advanced Development“ von Microsoft in den Rechenzentren in Redmond, Washington.

Der Einsatz von Zweiphasen-Tauchkühlungen in der Produktionsumgebung ist für Microsoft der nächste Schritt in einem langfristigen Plan, um mit der stark steigenden Nachfrage nach immer schnelleren und leistungsfähigeren Computern und Servern in Rechenzentren Schritt zu halten, während sich der Fortschritt mit der konventionell luftgekühlter Hardware stetig verlangsamt. Das Unternehmen spricht in diesem Zusammenhang bereits von „Moore's Law für das Rechenzentrum“.

Effizientere Kühlung für immer mehr Leistung

Da die Transistorbreiten so immens geschrumpft und physikalische Grenzen erreicht seien, hat sich der Trend von Moore's Law, benannt nach dem Intel-Mitbegründer Gordon Moore, deutlich verlangsamt. Gleichzeitig habe sich aber die weltweite Nachfrage nach schnelleren Computern für Hochleistungsanwendungen wie beispielsweise der Berechnung von künstlicher Intelligenz beschleunigt.

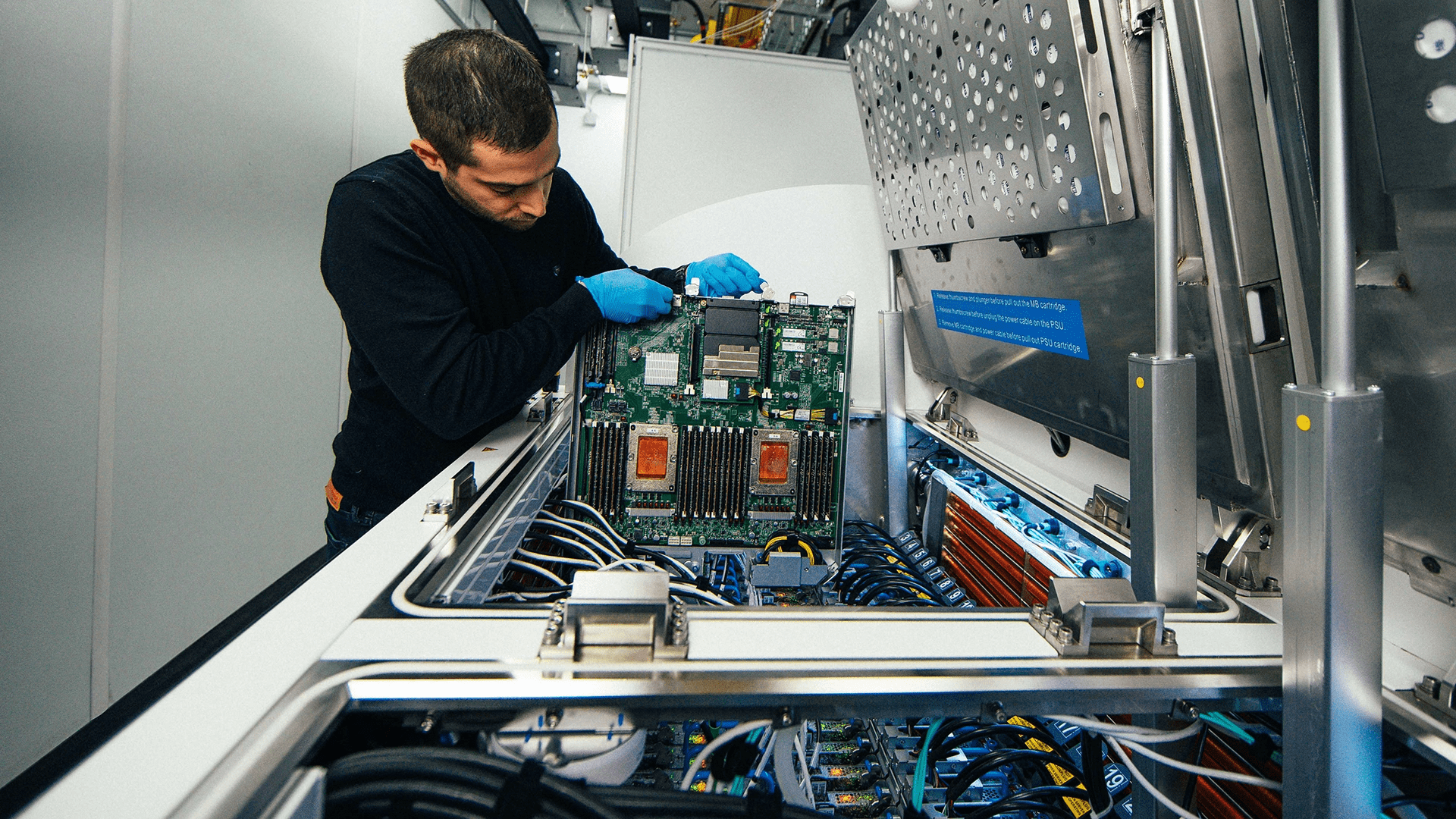

Um dem gesteigerten Bedarf an Leistung gerecht zu werden, hat sich die Computerindustrie Chip-Architekturen zugewandt, die mehr elektrische Leistung verarbeiten können. Die Leistungsaufnahme von Prozessoren (CPUs) sei zum Beispiel von 150 Watt auf mehr als 300 Watt pro Chip gestiegen und Grafikprozessoren (GPUs) sowie Beschleuniger (GGPUs) für das Hochleistungsrechnen und das maschinelle Lernen seien bei mehr als 700 Watt angekommen, so Husam Alissa weiter.

Luftkühlung ist nicht genug

„Luftkühlung ist nicht genug. Das treibt Microsoft zu einer Zweiphasen-Tauchkühlung, bei der die Oberflächen des Chips direkt abgekocht werden kann“, ergänzt Christian Belady, Vizepräsident der Microsoft-Entwicklungsgruppe für Rechenzentren.

Die Wärmeübertragung in Flüssigkeiten sei um Größenordnungen effizienter als in Luft und bringt laut Chrstian Belady auch Moore's Law wieder ein Stück weit in die Rechenzentren.

Der Wechsel zur Flüssigkeitskühlung bringt eine dem Moore'schen Gesetz ähnliche Denkweise für das gesamte Rechenzentrum mit sich und ermöglicht es uns, so den Trend des Moore'schen Gesetzes auf der Ebene des Rechenzentrums fortzusetzen.

Chrstian Belady, Microsoft

Zukunftsprojekt hat Project Natick als Vorbild

Die Zweiphasen-Tauchkühlung ähnele dem Project Natick, das das Potenzial von Unterwasser-Rechenzentren erforscht, die schnell einsatzbereit sind und jahrelang auf dem Meeresboden versiegelt in U-Boot-ähnlichen Röhren ohne jegliche Wartung durch Menschen vor Ort betrieben werden können, so Microsoft. Sollte sich bestätigen, dass so gekühlte Hardware länger hält, wäre das neue Zweiphasen-Tauchkühlsystem prädestiniert für den Einsatz in abgelegenen respektive schwer zugänglichen Servern.

Die ersten Server mit Zweiphasen-Tauchkühlung laufen bereits in einem Hyperscale-Rechenzentrum und führen komplexe Berechnungen durch. Zukünftig soll ein solcher Tank beispielsweise auch unter einem 5G-Mobilfunkmast mitten in einer Stadt für hochtechnisierte Anwendungen wie selbstfahrende Autos eingesetzt werden.

Für Endkunden hatte vor Jahren Roman „der8auer“ Hartung an einer All-in-One-Wasserkühlung mit Zweiphasen-Kühler gearbeitet, nachdem er mit einer Zweiphasen-Tauchkühlung für Aufsehen gesorgt hatte. Über einen Messeaussteller kam die Entwicklung aber nie hinaus. Das Projekt wurde nach großer Ankündigung kommentarlos eingestellt.