KIaaS: Nvidia macht KI-Hard- und Software einfacher zugänglich

Nvidia stellt sich im Bereich KI noch breiter bei Hardware und Software auf und bietet Zugriff auf die eigenen Lösungen über den Partner Equinix zum Sommer innerhalb weniger Minuten und auch für sehr kurze Zeiträume an. Darüber hinaus geht Fleet Command als Remote-Management-Software für KI an der Edge in den Regelbetrieb.

Musste die Hardware vor einigen Jahren noch direkt bei Nvidia gekauft oder geleast werden, kann diese mittlerweile auch bei Partnern erworben oder auch nur für kürzere Zeiträume von diesen oder Nvidia gemietet werden, um den Zugang einer breiteren Masse zu ermöglichen. Zuletzt kam zur Computex der DGX SuperPOD hinzu, den Nvidia über den Partner NetApp in einer kleineren Konfigurationen mit nur 4 und maximal 20 Nodes zur monatlichen Miete von 90.000 US-Dollar netto anbietet.

Zum Vergleich: Zuvor konnte der KI-Supercomputer nur in größeren Konfigurationen von 20 bis 140 DGX A100 bei Nvidia erworben oder geleast werden, sprich mit 160 bis 1.120 KI-Beschleunigern des Typs A100. Die finanzielle Hürde für ein solches System war mit mindestens 4 Millionen US-Dollar Kaufpreis nur für die 20 DGX A100 sehr hoch für Forschungseinrichtungen und Unternehmen gesteckt.

KI-Hard- und Software in wenigen Minuten

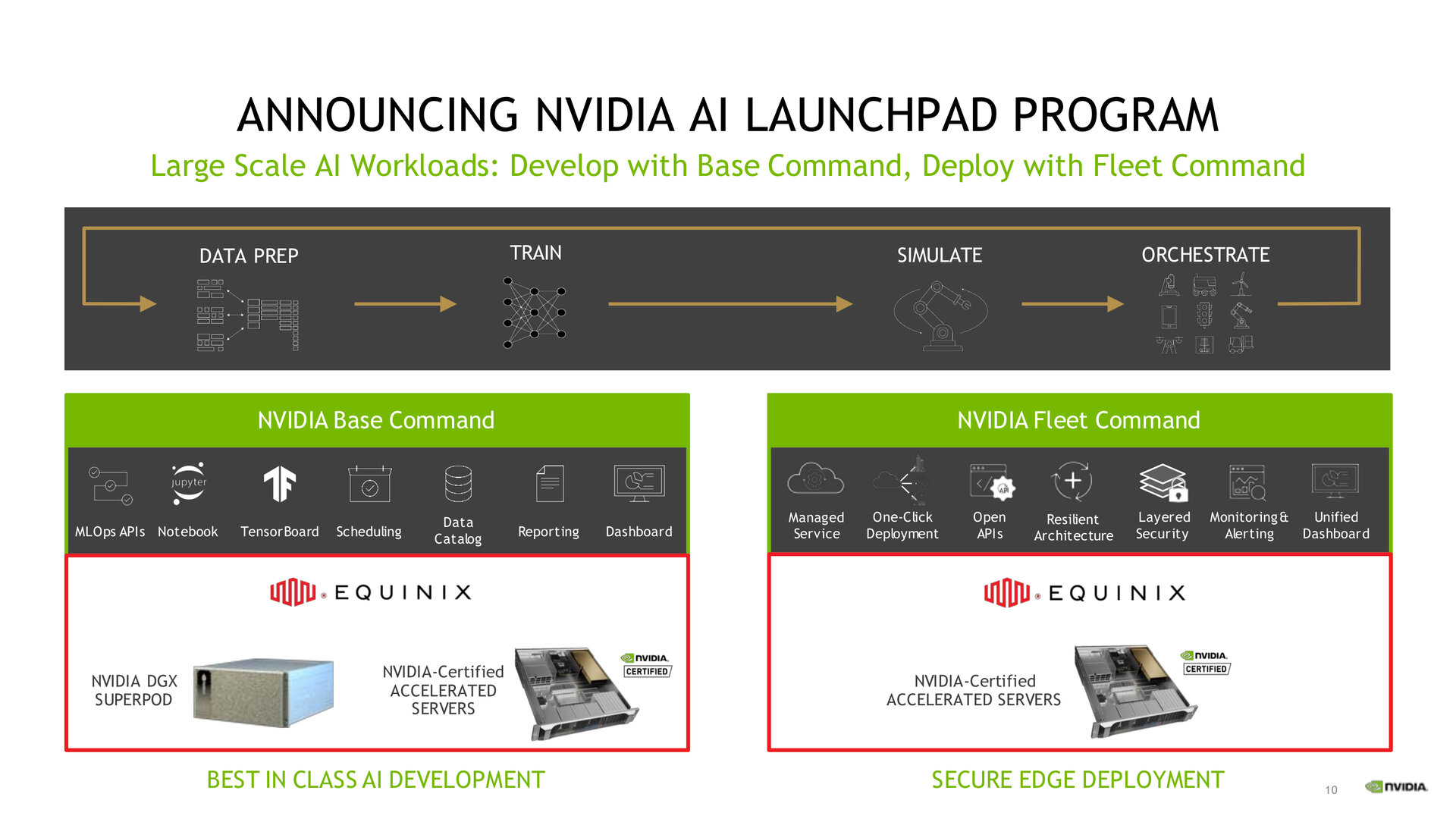

Mit dem heute angekündigten „AI LaunchPad“, das im weiteren Verlauf des Sommers an den Start gehen soll, will Nvidia den Zugriff auf KI-Hard- und Software weiter vereinfachen und auch in noch kleineren Instanzen für entsprechend geringere Kosten anbieten. Erster Partner ist dabei Equinix mit über 220 Rechenzentren in mehr als 60 Metropolregionen auf fünf Kontinenten. Innerhalb von Minuten sollen Interessenten Zugriff auf das gesamte Spektrum an Hard- und Software von Nvidia erhalten. Die Preisstruktur wurde noch nicht bekannt gegeben, in Aussicht gestellt wurde aber ein Preisrahmen von „ein paar US-Dollar pro Stunde“.

Auf den von Equinix angebotenen DGX SuperPODs können Kunden auch die zur Computex vorgestellte Base-Command-Plattform nutzen. Dabei handelt es sich um eine Software für die Koordination des KI-Trainings und von Workloads auf der Infrastruktur. Die Plattform ist für groß angelegte Multiuser- und Multiteam-Projekte in der KI-Entwicklung ausgelegt und kann auf Servern vor Ort und in der Cloud ausgeführt werden. Auch die unter „AI Enterprise“ zusammengefassten Frameworks wie Metropolis, Clara oder Jarvis lassen sich unter Verwendung von VMware vSphere ausführen.

Fleet Command geht in den Regelbetrieb

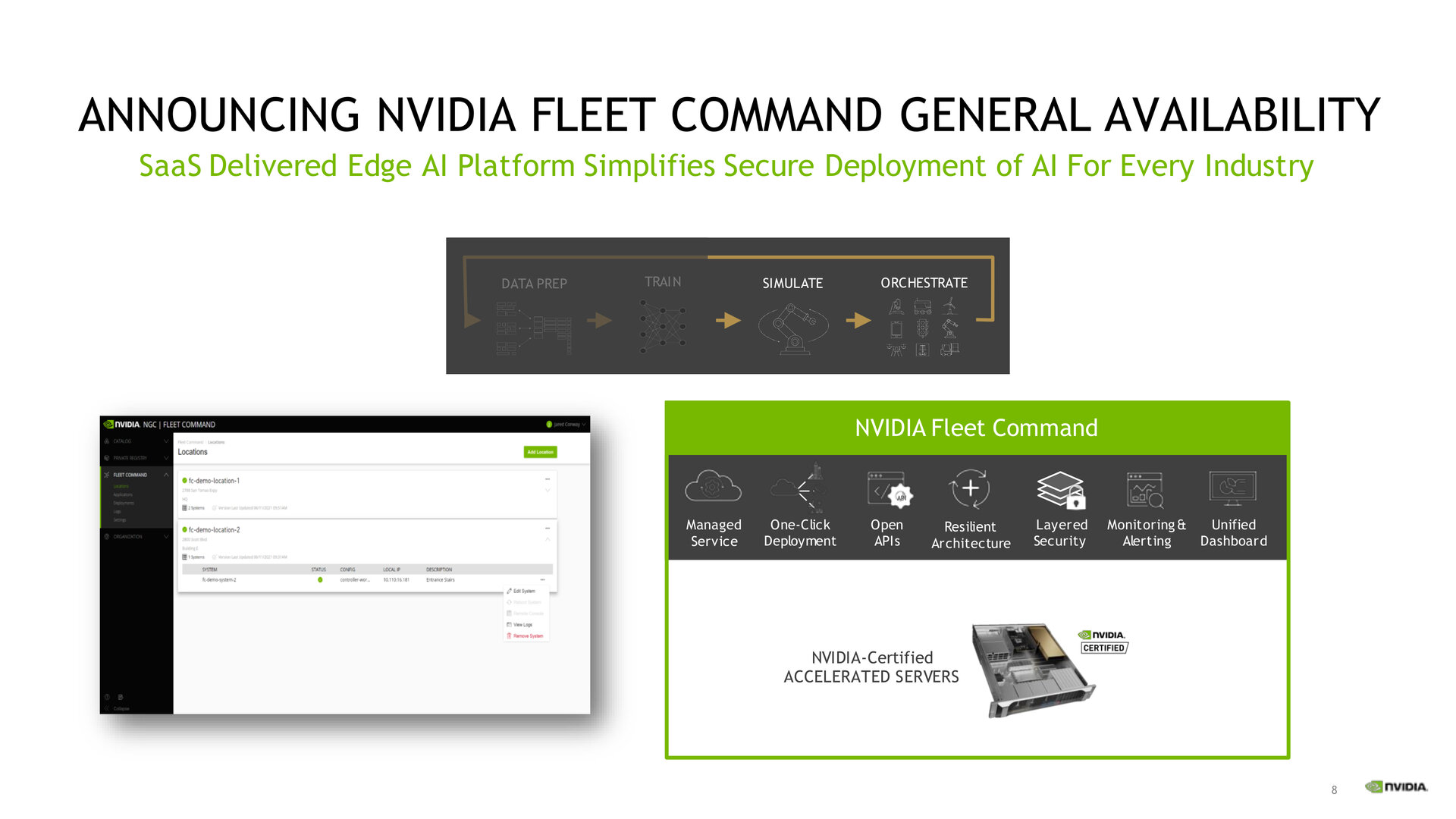

Base Command ist die eine Seite der KI-Bereitstellung, auf der die Projekte angelegt, Daten vorbereitet und das KI-Training ausgeführt werden. Die andere Seite für den Rollout am tatsächlichen Einsatzgebiet an der Edge, etwa in Bereichen wie Fertigung oder Einzelhandel, nennt sich Fleet Command und geht heute in den Regelbetrieb über. Die Remote-Management-Software soll es Unternehmen ermöglichen, Software schnell zu installieren, zu aktualisieren und zu managen. Die Verwaltung der laufenden KI-Applikationen an der Edge soll so simpel ausfallen wie die Steuerung eines smarten Thermostats.

ComputerBase hat Informationen zu diesem Artikel von Nvidia unter NDA erhalten. Die einzige Vorgabe war der frühestmögliche Veröffentlichungszeitpunkt.