Nvidia DGX SuperPOD: 20 PetaFLOPS für 90.000 US-Dollar im neuen Monatsabo

Nvidia erweitert das Enterprise-Geschäft um ein Mietmodell für den Supercomputer DGX SuperPOD, der bisher nur gekauft oder geleast werden konnte. Neue Partner für „Nvidia Certified“-Systeme gibt es ebenfalls, außerdem stehen Systeme mit BlueField-2 zur Auswahl. Das Programm wird zudem um ARM und ein Development Kit ergänzt.

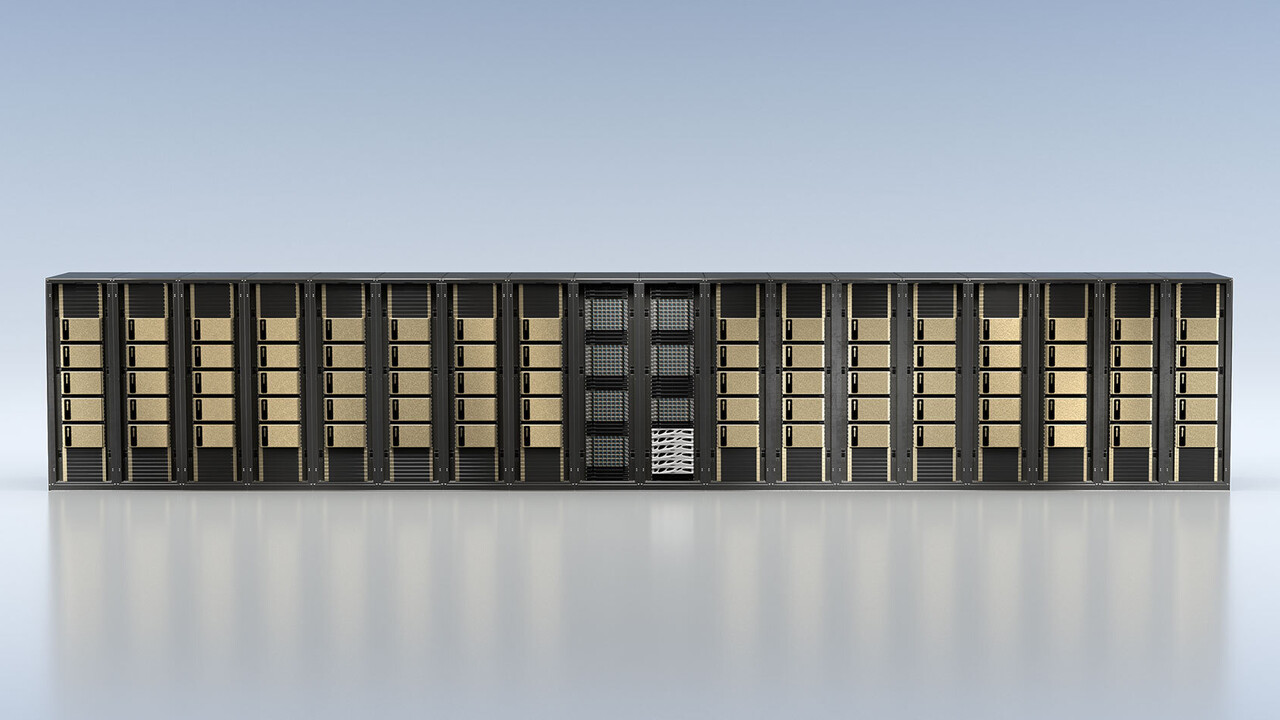

Das ist der DGX SuperPOD mit bis zu 1.120 A100-GPUs

Den DGX SuperPOD hatte Nvidia zur GTC 2020 in einer Konfiguration mit 140 DGX A100 vorgestellt. In einem DGX A100, den Nvidia für 199.000 US-Dollar vor Steuern anbietet, stecken acht SXM4-Module mit je einer A100-GPU, die verbunden über den NVLink eine kombinierte KI-Rechenleistung von in der Spitze 5 PetaFLOPS bezogen auf Half-Precision FP16 zur Verfügung stellen. Bei INT8 sind es 10 PetaOPS, beim Zahlenformat TF32 sind es 2,5 PetaFLOPS und bei FP64 156 TFLOPS. Außerdem sind zwei AMD Epyc 7742 mit jeweils 64 Kernen und 128 Threads, 1 TB RAM und 15 TB NVMe-SSD-Speicher mit PCI-Express-4.0-Anbindung verbaut. Zusätzlich finden sich sechs NVSwitches der 3. Generation und neun Mellanox ConnectX-6 VPI Network-Interfaces mit einer Bandbreite von jeweils 200 Gbit/s in dem HPC-System.

Wie aus dem Datenblatt des DGX SuperPOD (PDF) hervorgeht, bietet Nvidia den Supercomputer in Konfigurationen von 20 bis 140 DGX A100 an, sprich mit 160 bis 1.120 KI-Beschleunigern des Typs A100. Solche Systeme ließen sich bisher bei Nvidia kaufen oder leasen und wurden zur GTC mit einer Bauzeit von lediglich drei Wochen beworben.

DGX SuperPOD ab vier Nodes mieten

Die finanzielle Hürde für ein solches System ist mit mindestens 4 Millionen US-Dollar Kaufpreis nur für die 20 DGX A100 allerdings sehr hoch für Forschungseinrichtungen und Unternehmen gesteckt, weshalb Nvidia zur Computex ein Mietmodell für kleinere Konfigurationen anbieten. In Kooperation mit NetApp bietet Nvidia den DGX SuperPOD jetzt auch mit nur 4 Nodes und maximal 20 Nodes an. Damit steht je nach Szenario eine Rechenleistung von 20 PetaFLOPS für die kleinste bis 100 PetaFLOPS für die größte Miet-Konfiguration zur Verfügung. Nvidia versteht das Angebot nicht als kostenpflichtige Demo, sondern als Möglichkeit, KI-Projekte möglichst schnell vom Prototypenstadium zur Serie zu entwickeln. Wer langfristig die Leistung eines DGX SuperPOD benötige, sei weiterhin besser mit dem Kauf oder Leasing eines solchen Systems beraten, so Nvidia.

Nvidia bietet den DGX SuperPOD mit vier Nodes zum Preis von 90.000 US-Dollar netto pro Monat zur Miete an. Im Preis enthalten ist ein Abonnement für Nvidia Base Command, eine Software für die Koordination des KI-Trainings und von Workloads auf der Infrastruktur. Die Plattform ist für groß angelegte Multiuser- und Multiteam-Projekte in der KI-Entwicklung ausgelegt und kann auf Servern vor Ort und in der Cloud ausgeführt werden. Neben NetApp sollen auch AWS für ML-Workloads auf Amazon SageMaker und Google auf dem Google Cloud Marketplace demnächst Base Command anbieten.

BlueField-2 DPU bei Drittanbietern

Zur Computex erweitern Nvidia und Partner außerdem das Angebot an „Nvidia Certified“-Systemen, also zum Beispiel Server, für die Nvidia Blaupausen liefert und die Partner mit gewissen Workloads testen und bei Nvidia zertifizieren lassen müssen. HGX A100, also ein DGX A100 von einem Drittanbieter statt Nvidia, oder EGX für die Edge-Cloud sind nur zwei Beispiele dafür. Zur taiwanischen Messe umfasst das Programm auch Systeme mit BlueField-2, wobei Asus, Dell, Gigabyte, QCT und Supermicro die ersten Partner für Systeme mit DPU sind.

Kurzer Rückblick: Im Datacenter ist eine CPU mittlerweile auch für viele kritische Aufgaben im Bereich Netzwerk, Speicherverwaltung und Sicherheit zuständig – wichtige Aufgaben, die zwar nicht vernachlässigt werden dürfen, aber kostbare Rechenleistung der CPU in Anspruch nehmen, die nicht mehr für die eigentlichen Prozesse zur Verfügung steht. Die Data Processing Unit (DPU) soll exakt diese zwischenzeitlich immer mehr auf die CPU ausgelagerten Aufgaben in einer neuen Komponente übernehmen und im Datacenter bis zu 30 Prozent Leistung der CPU zurückführen.

Zur diesjährigen GTC hatte Nvidia die neue BlueField-3 DPU mit 16 ARM Cortex-A78-Kernen vorgestellt, die im ersten Quartal 2022 als Sample verfügbar sein soll. Für den regulären Marktstart gibt es noch keinen Termin. Server mit BlueField-2 von Drittanbietern sollen zum Herbst verfügbar werden.

ARM Development Kit mit Ampere Altra Q80-30m

Darüber hinaus wird das Programm im kommenden Jahr um Server auf ARM-Basis erweitert, wobei es dafür noch keinen konkreten Termin gibt. Dass Nvidia sich im ARM-Umfeld breiter aufstellen wird, war spätestens mit der geplanten Übernahme von ARM zu erwarten. Zur diesjährigen GTC hat Nvidia mit Grace eine eigene ARM-CPU für das HPC-Segment im Jahr 2023 vorgestellt. Auch mit dem Nachfolger „Grace Next“ plant Nvidia bereits für Drive AGX Atlan, wo auch „Ampere Next“ zum Einsatz kommen wird, das 2022 noch vor „Ampere Next Next“ voraussichtlich im Jahr 2024 geplant ist.

Erste ARM-Server mit einer auf der Neoverse-Architektur basierenden CPU, Beschleunigern mit Ampere-Architektur und/oder BlueField-2 DPU mit Nvidia-Zertifizierung sollen von Gigabyte und Wiwynn kommen. Von Gigabyte ist in Kooperation mit Nvidia zudem ein Development Kit für die KI-Entwicklung unter ARM geplant – Preis bisher unbekannt. Dieses setzt sich aus dem 2U-Server Gigabyte G242-P32, dem ARM-Prozessor Ampere Altra Q80-30m, zwei Nvidia A100, 512 GB DDR4, 6 TB SAS/SATA Storage und zwei BlueField-2 zusammen. Zum Lieferumfang gehört zudem Nvidias HPC SDK.

ComputerBase hat Informationen zu diesem Artikel von Nvidia unter NDA erhalten. Die einzige Vorgabe war der frühest mögliche Veröffentlichungszeitpunkt.

- ROG Strix G15/G17 Advantage: Asus' Gaming-Notebook mit RX 6800M und 5900HX

- MSI: Details zum SSD-Debüt mit M480, M470 und M370

- ASRock DeskMini Max: Ein DeskMini X300 mit Platz für diskrete Grafikkarten

- +26 weitere News