AMD Instinct MI200: Multi-Chip-GPUs mit bis zu 47,9 TFLOPS, 128 GB und 560 W

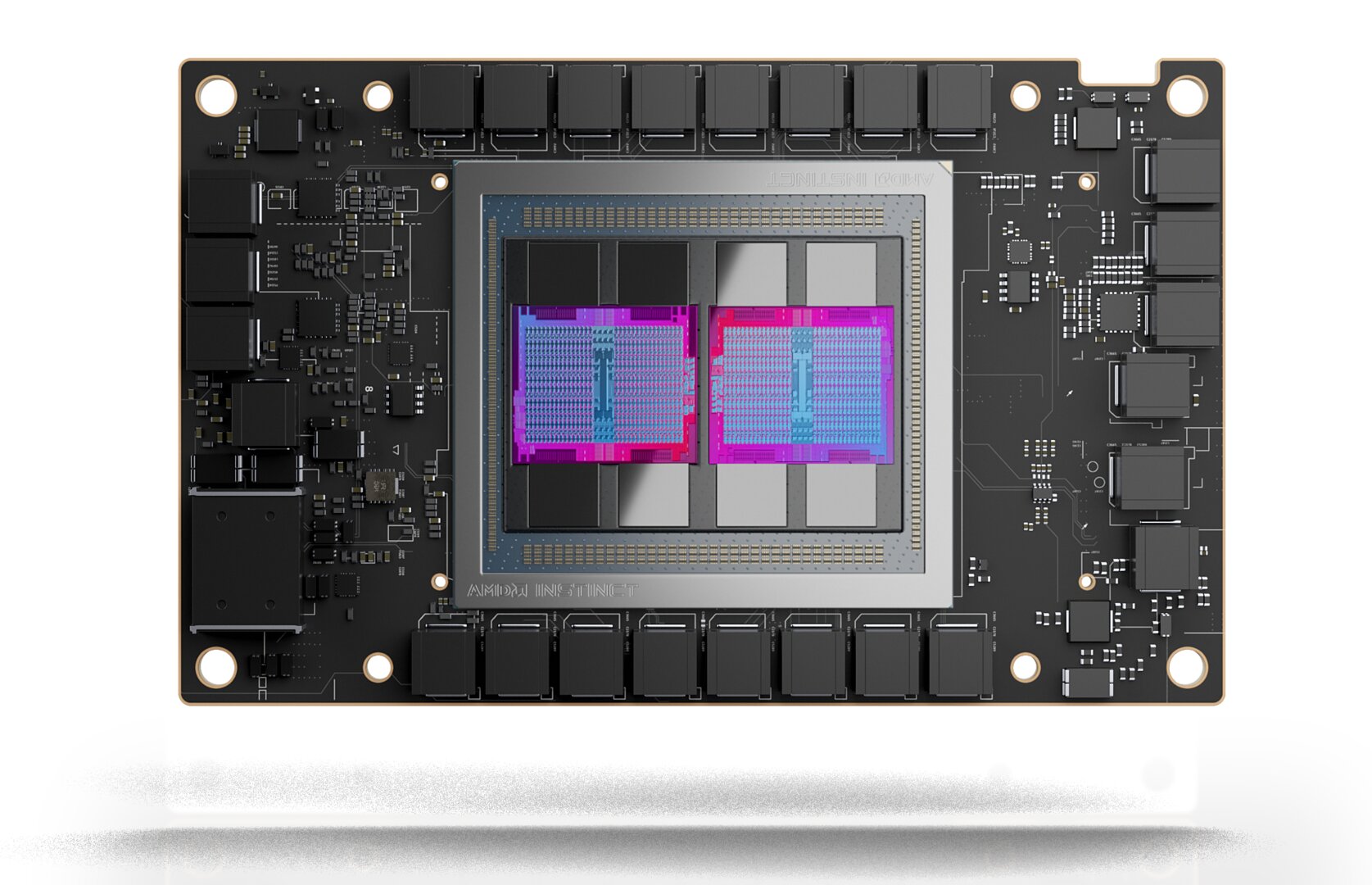

AMD hat die nächste Generation der auf High-Performance-Computing (HPC) ausgelegten Instinct-Grafikkarten vorstellt: die Serie Instinct MI200. Sie nutzt die 2. Generation der CDNA-2-Architektur, die AMDs Multi-Chip-Ansatz von der CPU- in die GPU-Serie überführt. Zwei GPU-Dies auf einem Package versprechen Leistungsrekorde.

CDNA vs. RDNA

CDNA ist eine reine Compute-GPU-Architektur und verzichtet vollständig auf die sogenannte fixed-function hardware, hat deshalb unter anderem keine Textureinheiten, Rasterizer oder überhaupt nur Monitorausgänge. Auch der mit RDNA 2 in Gaming-GPUs eingeführte Infinity Cache fehlt. Dafür gibt es schnelleren Grafikspeicher vom Typ HBM2 am breiten Speicher-Interface direkt auf dem Package und noch ein paar wesentliche Unterschiede mehr. Der größte betrifft den Multi-Chip-Ansatz.

CDNA 2 ist eine Multi-Chip-Architektur

Mit CDNA 2 portiert AMD den mit Zen bei den CPUs eingeführten Multi-Chip-Ansatz ins GPU-Segment und alle Gerüchte deuten darauf hin, dass RDNA 3 bei den Gaming-Grafikkarten denselben Weg beschreiten wird.

Bei der Instinct MI200, die es zum Start in den drei SKUs MI250X, MI250 und MI210 geben wird, bedeutet das konkret: Auf dem gigantischen Package reihen sich acht HBM2-Stapel nicht um einen, sondern um gleich zwei GPU-Dies, deren Basis weiterhin Graphics Core Next (GCN) ist. Der für RDNA 3 in der Gerüchteküche gehandelte dritte Die, der den Infinity Cache enthalten soll, kommt bei CDNA 2 nicht zum Einsatz. Beide GPU-Dies kommunizieren über einen „Ultra High Bandwith Die Interconnect“ miteinander.

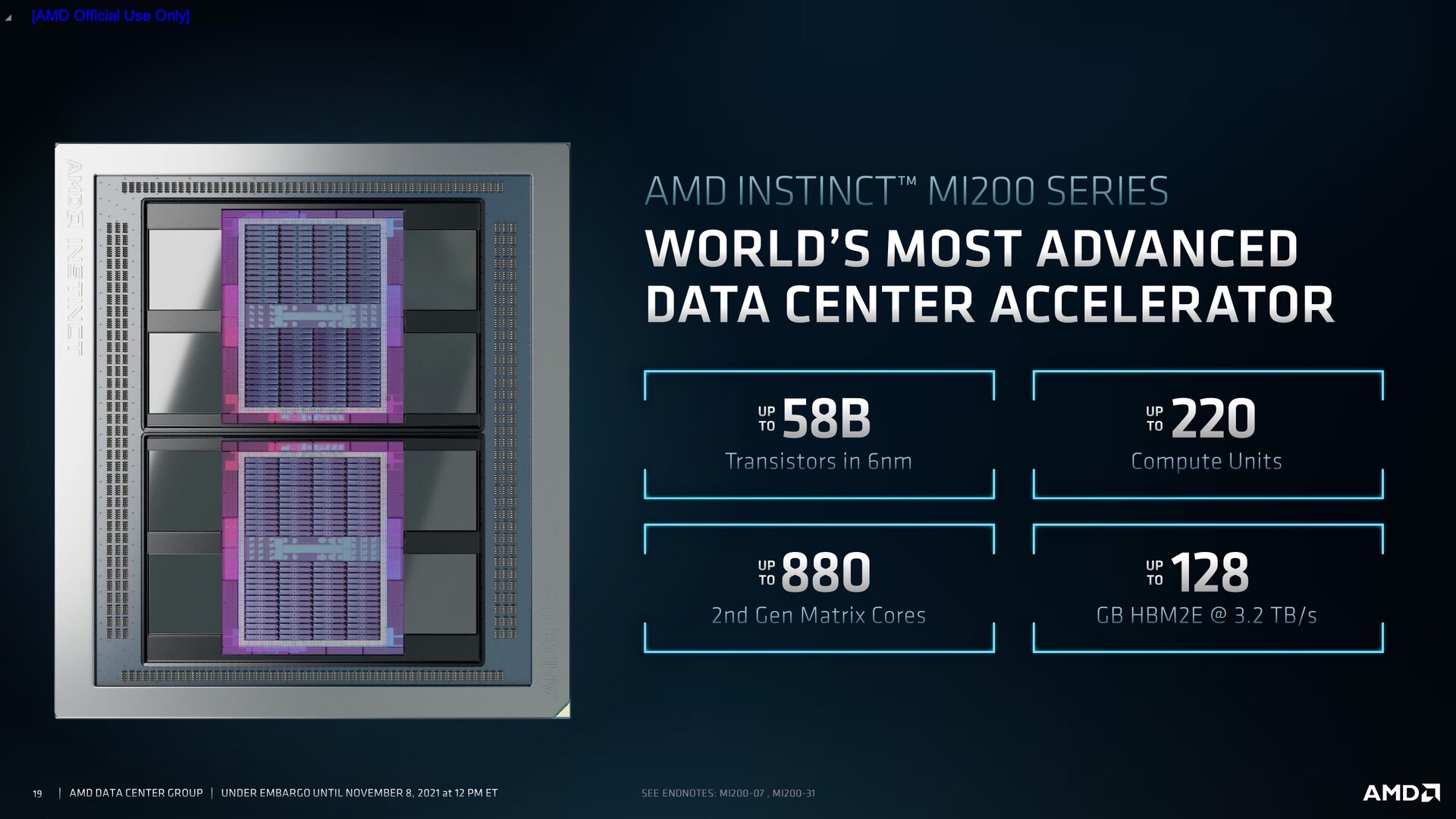

Jeder CDNA-2-Chip beinhaltet 110 CUs respektive 7.040 Shader und setzt sich aus 29 Milliarden Transistoren (Navi 21: 26,8 Mrd.) zusammen, in Summe ergeben sich bis zu 220 CUs respektive 14.080 Shader und 58 Milliarden Transistoren. Ob das dem Vollausbau entspricht, ist nicht bekannt. Dass die Arcturus-GPU der 1. Generation CDNA bereits 120 CUs bot, legt ein leicht beschnittenes Design nahe.

Schnellere Matrix-Kerne und schnellerer Speicher

Deutlich ausgebaut hat AMD die Fähigkeit der GPU mit Matrizen umzugehen, wie sie insbesondere in AI-Anwendungen zum Einsatz kommen: Bis zu 880 so genannte Matrix-Kerne der 2. Generation, die jetzt auch zu FP64 kompatibel sind, werden geboten.

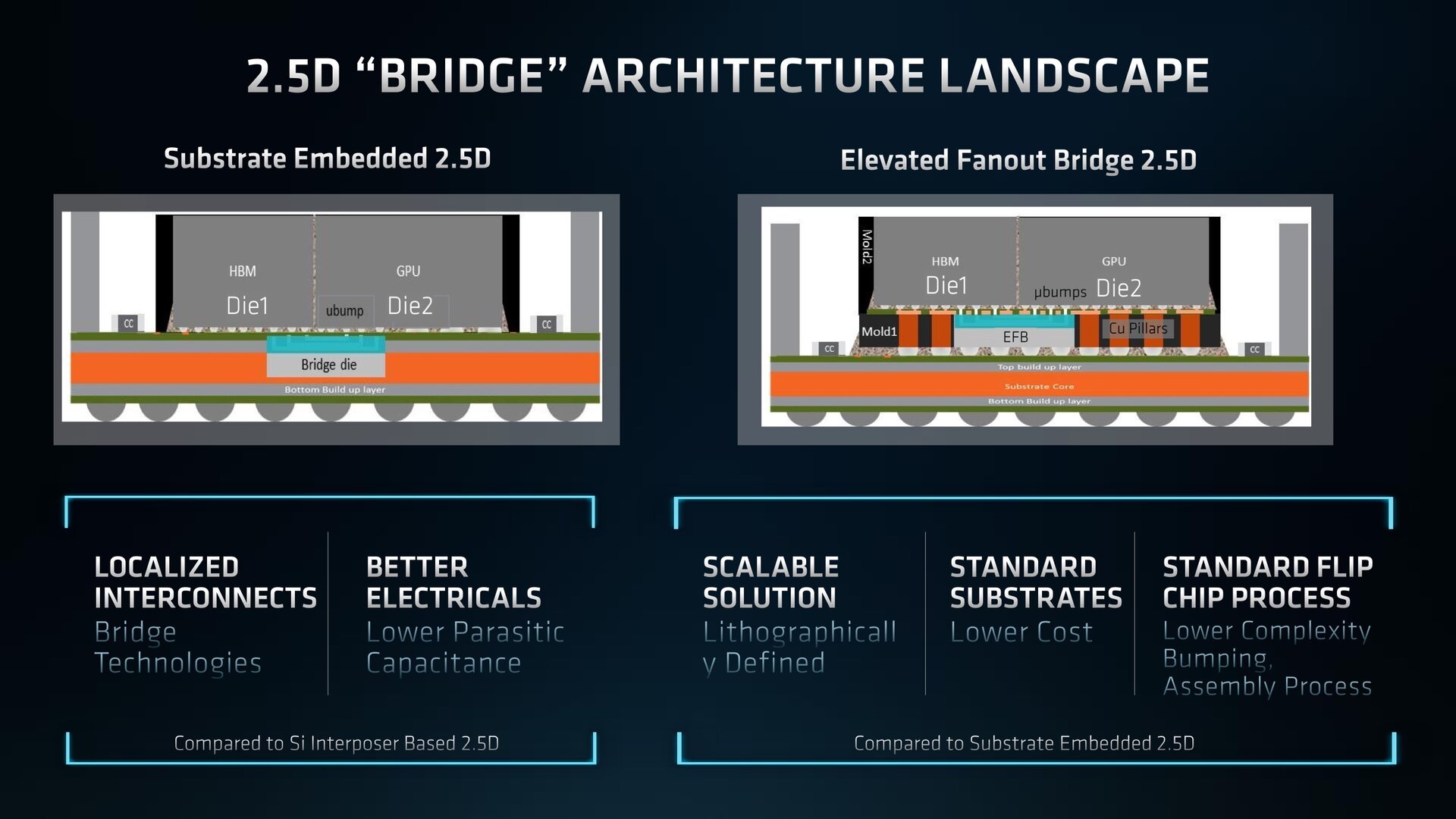

Mit HBM2e kommt bei Aldebaran auch schnellerer Speicher zum Einsatz. Mit 1,6 statt 1,2 GHz Taktfrequenz über ein jetzt 8.096 Bit breites Interface wird eine Speicherbandbreite von 3,2 TB/s erreicht. Das ist mehr, als der Infinity Cache in Navi 21 erreicht (2,0 TB/s). Auch die Anbindung vom Speicher an die GPU ist neu: Die so genannte 2,5D Elevated Fan-Out Bridge (EFB) erleichtert das Packaging und senkt dessen Kosten, weil der Bridge-Chip nicht mehr im speziell angepassten Basis-Substrat sitzt, sondern in einer eigens eingezogenen weiteren Ebene. Dieser Ansatz lässt sich auch besser skalieren.

AMDs erster Chip aus der 6-nm-Fertigung

Die neue Multi-Chip-GPU Codename „Aldebaran“ ist AMDs erster Chip, der im 6-nm-Fertigungsverfahren bei TSMC produziert wird. Auch für RDNA 3 (5 nm sowie 6 nm) und die APU Rembrandt, die Zen-3-Kerne mit einer RDNA-2-GPU kombinieren wird, sollen im Jahr 2022 auf dieser Basis erscheinen. Selbst von Zen 3+ in 6 nm war bereits die Rede, der die Gerüchteküche aber nicht verlassen wird.

Instinct MI250X und MI250 im OAM-Design

Als zwei erste Produkte auf Basis von CDNA 2 präsentiert AMD heute Instinct MI250X und Instinct MI250. Beide kommen im Formfaktor OCP Accelerator Module (OAM), den das Open Compute Project standardisiert hat. Nvidia nutzt bei A100 wiederum einen proprietären Standard.

Bis zu 560 Watt TDP

MI250X und MI250 unterscheiden sich lediglich in der Anzahl der aktiven Compute Units, der maximale Takt und die maximale Board Power sind mit 1.700 MHz respektive 560 Watt gleich. Die 560 Watt setzen voraus, dass die Kühlung im Server-Rack über eine Wasserkühlung erfolgt, bei passiver Kühlung sind es jeweils 500 Watt – bei welchem Takt, sagt AMD nicht.

Beide SKUS nutzen 128 GB HBM2e mit 1,6 GHz Taktfrequenz. Dass AMD von bis zu 128 GB in Bezug auf die Serie spricht, könnte aber auch noch andere Varianten in Aussicht stellen.

| Instinct MI200 | Instinct MI100 | ||

|---|---|---|---|

| Ausprägung | MI250X | MI250 | MI100 |

| Eckdaten | |||

| Architektur | CDNA 2 | CDNA | |

| Fertigung | „6 nm“ | 7 nm TSMC FinFET | |

| Compute Units | 220 | 208 | 120 |

| Shader | 14.080 | 13.312 | 7.680 |

| max. Takt | 1.700 MHz | 1.502 MHz | |

| Speicher | 128 GB HBM2e, 8.092 Bit (1,6 GHz, 3,2 TB/s) |

32 GB HBM2, 4.096 Bit (1,2 GHz, 1,2 TB/s) |

|

| Infinity Fabric Links | 8 | 6 | 3 |

| max. Board Power | 500 (passiv) oder 560 Watt (Wakü) | 300 Watt (passiv) | |

| Leistung* | |||

| FP64/FP32 Vektor | 47,9/47,9 TFLOPS | 45,3/45,3 TFLOPS | 11,5/23,1 TFLOPS |

| FP64/FP32 Matrix | 95,7/95,7 TFLOPS | 90,5/90,5 TFLOPS | –/46,1 TFLOPS |

| * MI200 bei 560 Watt. Die Eckdaten und Leistungswerte der MI200 im PCIe-Steckkarten-Format sind noch nicht bekannt | |||

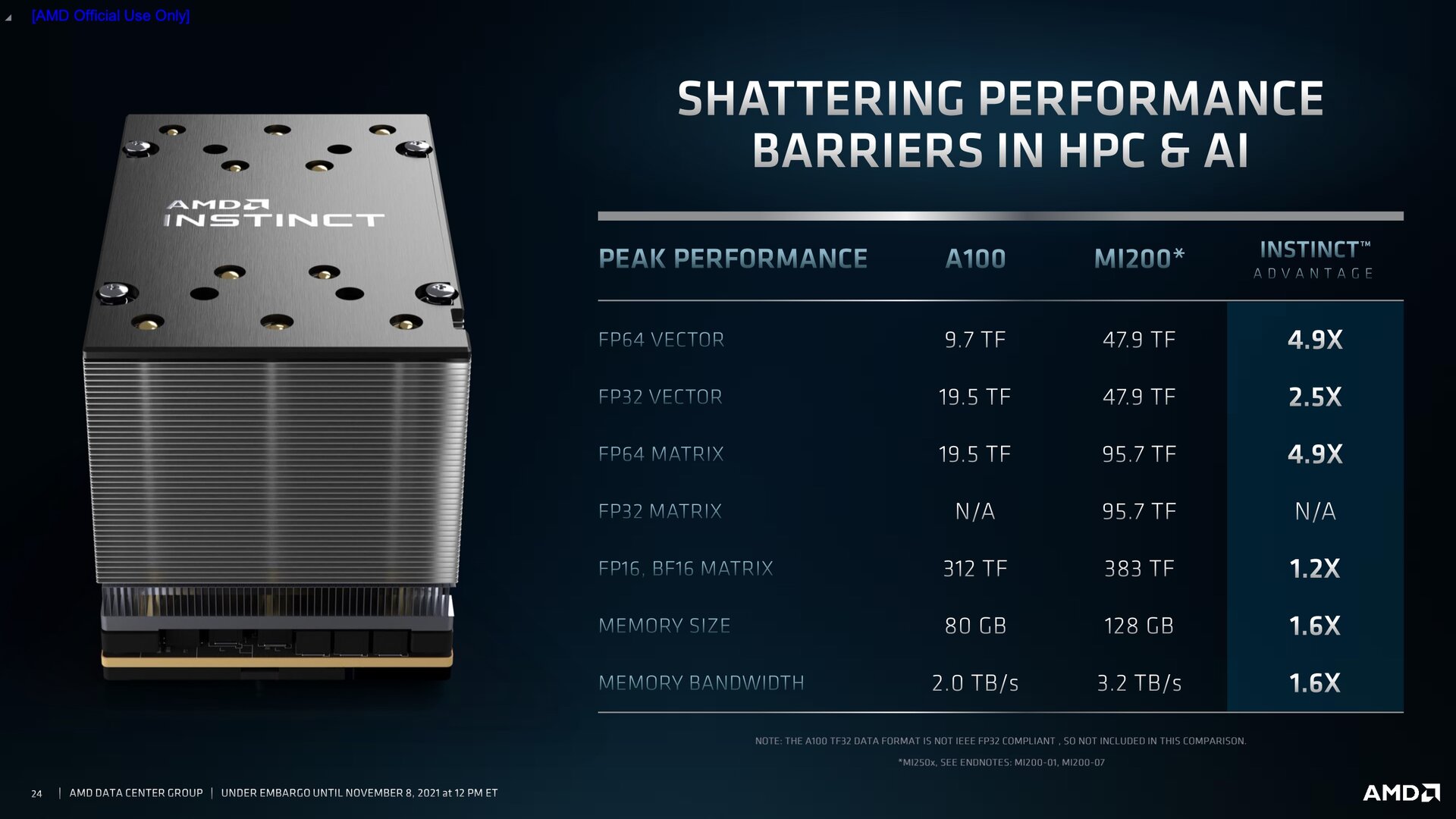

Die versprochene Leistung ist enorm

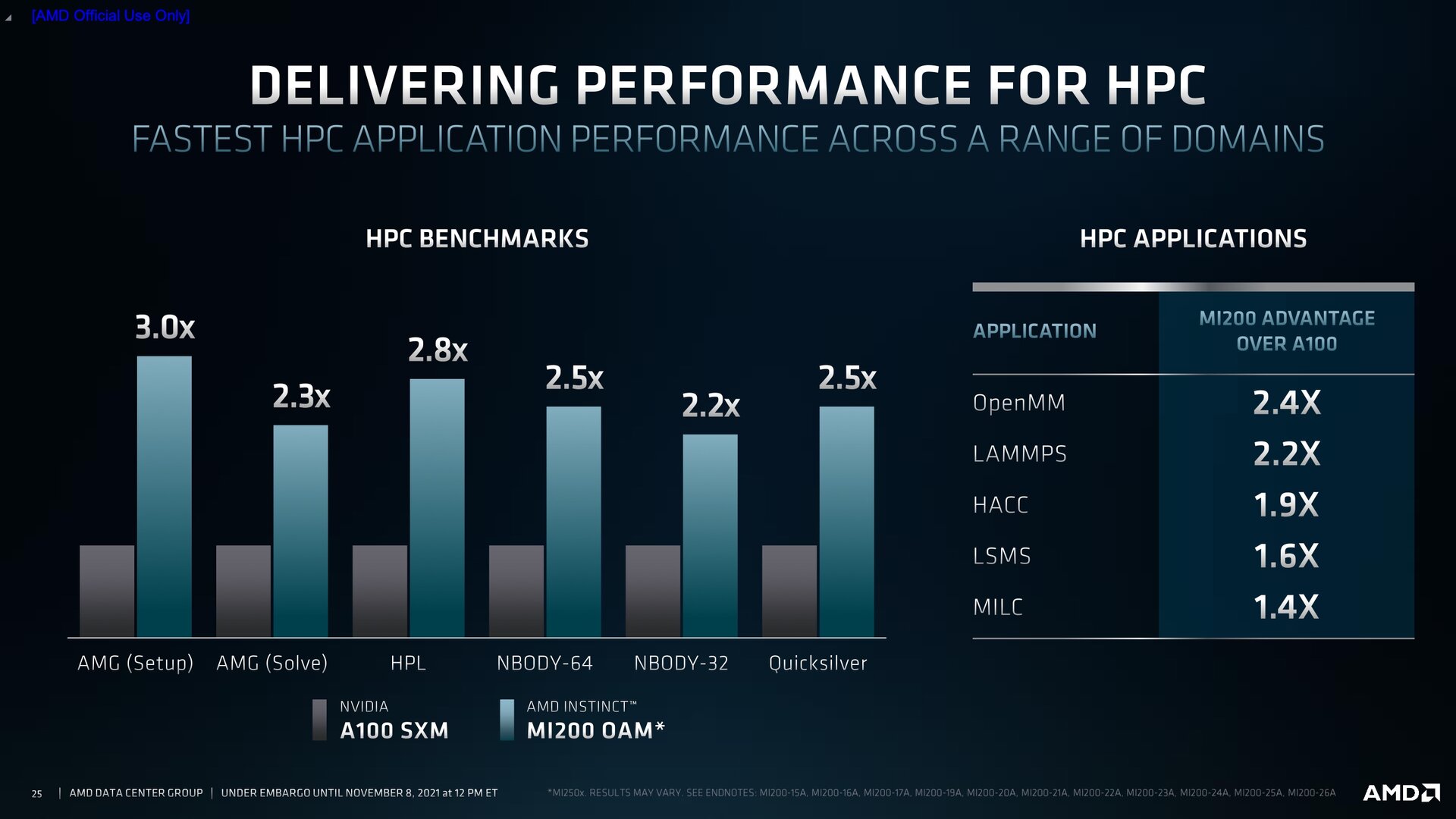

Anhand eigener Benchmarks der Instinct MI250X mit 560 Watt TDP stellt AMD eine gegenüber MI100 in klassischen Vector-Lasten mit einfacher Präzision (FP32) mehr als verdoppelte Leistung in Aussicht. Bei „nur“ um 87 Prozent gestiegener Leistungsaufnahme steigt die Effizienz. Deutlicher ist das bei doppelter Präzision (FP64) der Fall, die die neue GPU erstmals in einem Durchgang ausführen kann: Hier steigt die Leistung um mehr als den Faktor vier. Auch bei der Berechnung von Matrizen geht es gegenüber MI100 um den Faktor zwei nach oben, FP64 ist mit MI200 erstmals überhaupt möglich.

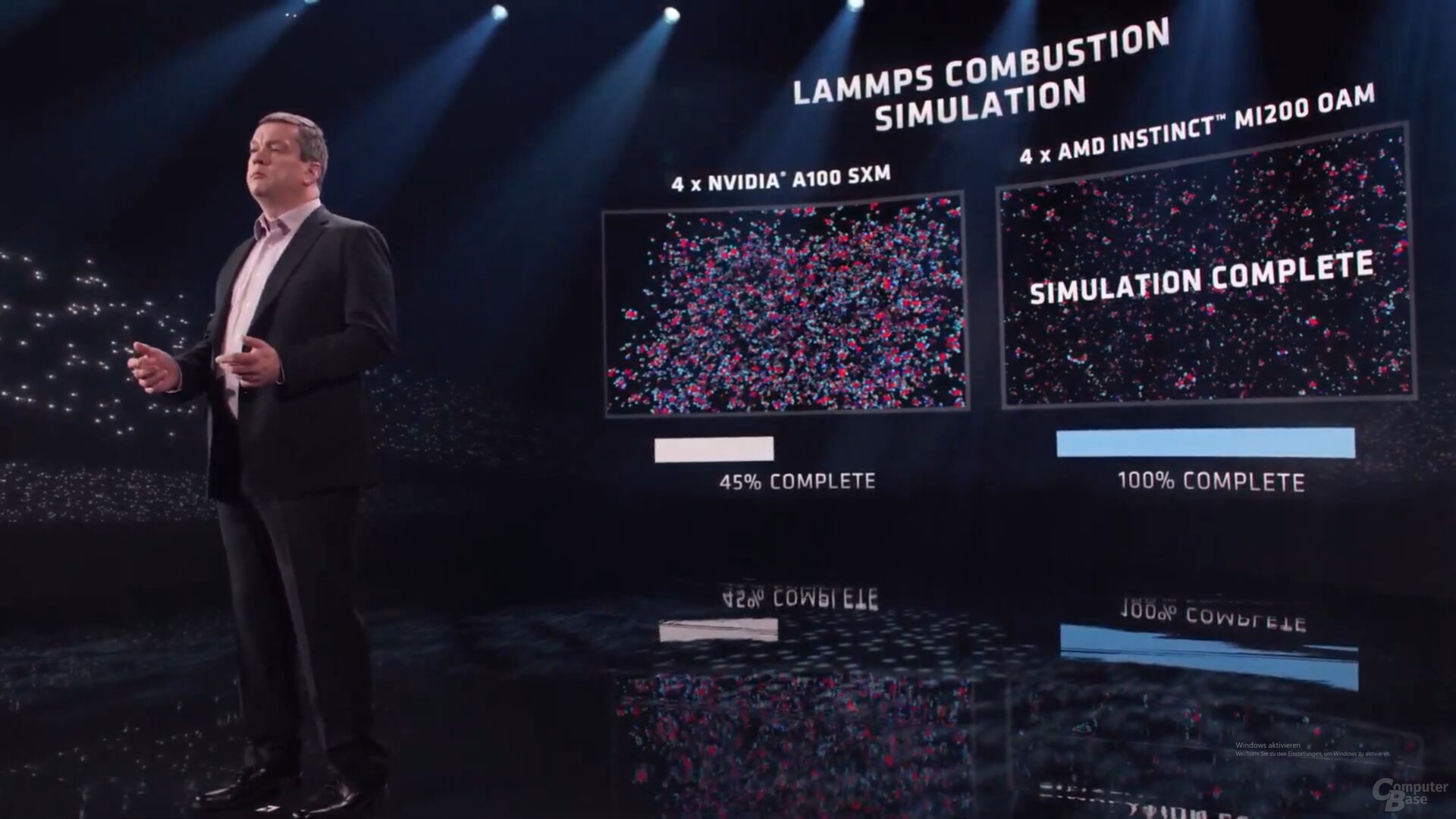

Die MI100 in den Schatten zu stellen, ist für AMD allerdings nur die 2. Priorität. Die ganze Vorstellung der neuen Serie macht deutlich: Im Kern geht es um Nvidias A100, den AMD in HPC-Lasten klar und dank brachialer Multi-GPU-Leistung selbst noch in Anwendungen wie AI Training schlagen will, obwohl Nvidia Ampere mit den Tensor-Cores die darauf besser optimierten Einheiten bietet.

Die ersten Chargen sind für Frontier

AMD Instinct MI200 wird ab sofort ausgeliefert, zuerst aber nur an einen Kunden: HP. Der Hersteller installiert derzeit in den USA den Supercomputer Frontier, der der erste Exascale-Supercomputer außerhalb Chinas werden soll. Erste Wissenschaftler sollen den Rechner, der am Oak Ridge National Laboratory steht, im Jahr 2022 nutzen können.

Instinct MI210: In Kürze auch im Steckkarten-Format

Ebenfalls bereits angekündigt, aber noch nicht im Detail vorgestellt, hat AMD die Instinct MI210. Sie kommt wie die MI100 im klassischen PCIe-Steckkarten-Format (PCIe 4.0) daher und soll „in Kürze“ Anfang 2022 erscheinen. Zu den Eckdaten verrät AMD noch nichts. Gut möglich, dass sich die „bis zu 128 GB HBM2e“ auf dieses Modell der Serie beziehen und es hier (auch) weniger Speicher gibt.

Ebenfalls offiziell vorgestellt hat AMD am Abend die neuen Epyc-CPUs von Typ „Milan X“ mit 768 MB L3-Cache dank gestapelten 3D-V-Cache-Chips.

ComputerBase hat Informationen zu diesem Artikel von AMD unter NDA erhalten. Die einzige Vorgabe war der frühestmögliche Veröffentlichungszeitpunkt.