God of War im Test: Benchmarks und DLSS/FSR-Vergleich zur PC-Version

God of War ist 2018 als Vorzeigetitel auf der PlayStation 4 erschienen, am Freitag folgt eine optisch aufgehübschte Version für den PC. ComputerBase hat bereits vorab einen ausführlichen Blick auf die Technik inklusive Nvidia DLSS und AMD FSR geworfen und zahlreiche Grafikkarten-Benchmarks erstellt.

Wie mehrfach von der Community gewünscht, hat ComputerBase weitere Grafikkarten-Benchmarks mit der original PlayStation-Grafik durchgeführt. Wenig verwunderlich zeigt sich, dass diejenigen, die auf die verbesserte PC-Grafik verzichten, keinen High-End-Beschleuniger für hohe Frameraten benötigt. Selbst mit einer GeForce GTX 1060 oder Radeon RX 580 ist God of War dann noch spielbar, wenn auch nicht optimal.

Bei den neu hinzugefügten Grafikkarten handelt es sich um:

- AMD Radeon RX 580

- AMD Radeon RX Vega 64

- AMD Radeon RX 5700 XT

- AMD Radeon RX 6700 XT

- Nvidia GeForce GTX 1060

- Nvidia GeForce GTX 1080

- Nvidia GeForce RTX 2060

- Nvidia GeForce RTX 2070 Super

Nachdem Sony jahrelang ausschließlich Exklusiv-Spiele für die eigene PlayStation entwickelt hat, kamen sie in letzter Zeit immer mit etwas Abstand auch auf den PC. Den Anfang machte Horizon Zero Dawn, gefolgt von Days Gone. Und nun folgt mit God of War ein weiterer großer Titel, den es bis jetzt ausschließlich auf der PlayStation 4 und PlayStation 5 gegeben hat, und damit gleich eines der bestbewerteten Singleplayer-Games mit einer großen Kampagne überhaupt.

Mehrere kleine Verbesserungen für den PC

Für die PC-Version von God of War ist dabei nicht der eigentliche Entwickler Santa Monica Studio, sondern Jetpack Interactive verantwortlich. Dabei gibt es nicht nur die üblichen Anpassungen an den PC wie eine Maus- und Tastatursteuerung, freie Auflösungswahl und unlimitierte Frameraten. Auch bei der Grafikqualität hat es einen Schritt nach vorne gegeben. Darüber hinaus wird Nvidias intelligentes KI-Upsampling DLSS 2.0 unterstützt, dasselbe gilt für AMDs Konkurrenztechnologie FidelityFX Super Resolution (FSR). Nvidia Reflex hat es ebenfalls in das Spiel geschafft, ebenso Ultrawide-Auflösungen im 21:9-Format. Raytracing gibt es dagegen nicht.

Auch wenn die Grafik einige Updates erfahren hat, mehr dazu auf der dritten Seite des Artikels, sieht man der von Santa Monica Studio eigens entwickelten Engine an, dass sie mittlerweile mehr als dreieinhalb Jahre auf dem Buckel hat. Das hat zur Folge, dass die Optik natürlich nicht mit aktuellen Grafik-Schwergewichten wie Marvel's Guardians of the Galaxy, Call of Duty: Vanguard oder Forza Horizon 5 mithalten kann.

Das hohe Entwicklungsbudget erkennt man immer noch

Das ist aber Meckern auf durchaus ziemlich hohem Niveau, denn in Sachen Artwork und Produktionsdesign ist God of War immer noch absolut erstklassig – man merkt dem Spiel einfach überall an, dass es mit einem hohen Budget und von talentierten Entwicklern produziert worden ist. Vor allem die durch die Optik erzeugte Atmosphäre, die Animationen und die Detaildichte sind nach wie vor sehr gut. Damit spielt God of War nicht mehr in der ersten Grafik-Garde, für einen Platz im oberen Mittelfeld reicht es aber weiterhin – was nach fast vier Jahren ein absolut respektables Ergebnis ist.

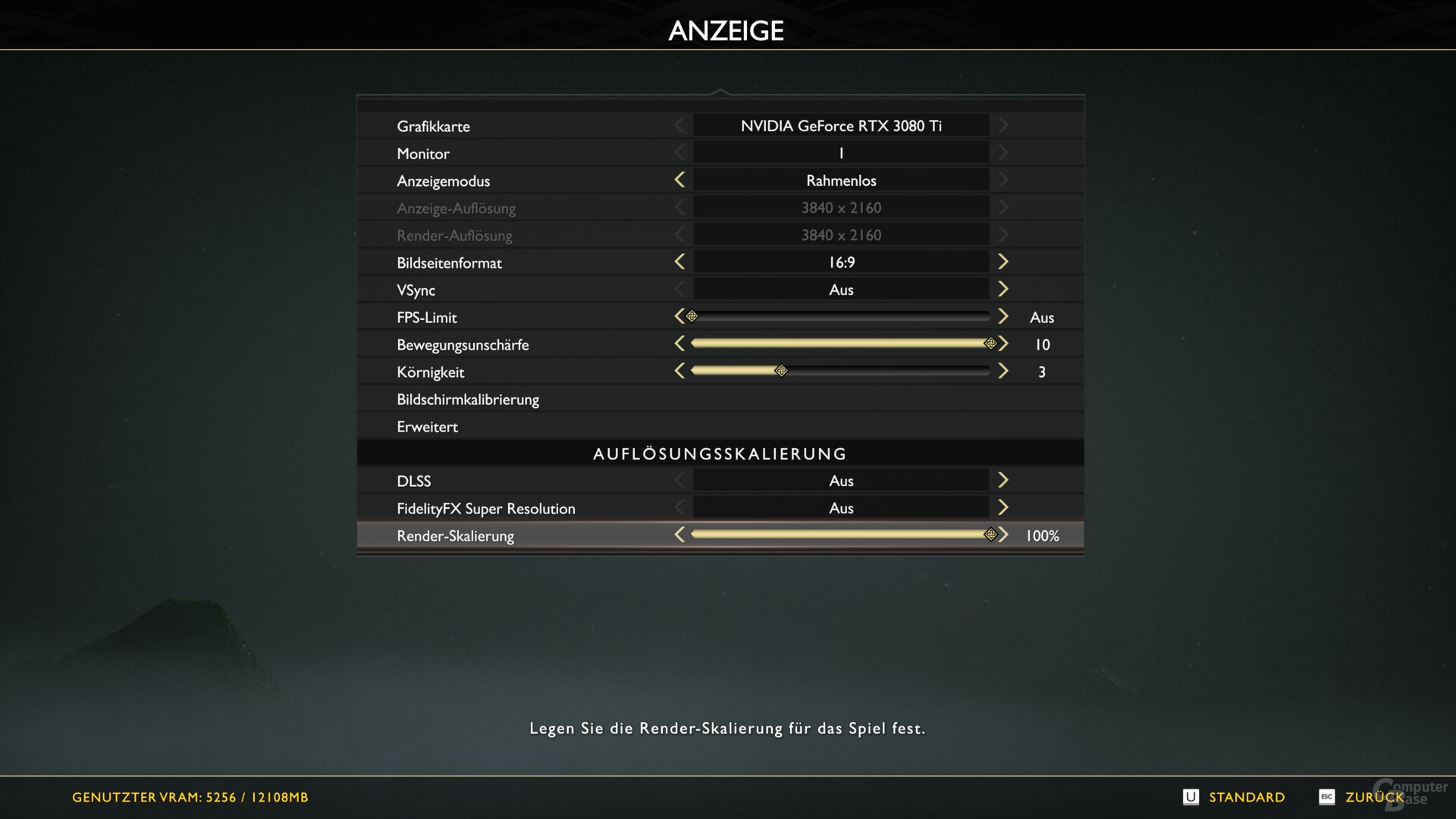

Ein Grafikmenü, das mehr als das Notwendigste bietet

God of War hat auf dem PC ein ordentliches Grafikmenü erhalten. So gibt es neben den gewohnten Detailoptionen mit „Niedrig“, „Original“ (das die originale PlayStation-Grafik nutzt), „Hoch“ und „Ultra“ vier verschiedene Grafik-Presets, wobei sich die Reflexionen noch um eine Stufe weiter auf „Ultra+“ stellen lassen.

Darüber hinaus gibt es einen FPS-Limiter, der sich zwischen 30 und 120 FPS in 10-FPS-Schritten konfigurieren lässt. Es lässt sich AMD FSR oder Nvidia DLSS einschalten. Ein manuelles Nachschärfen des Bildes ist aber mit beiden Methoden nicht möglich. Solch eine Funktion gibt es ebenso wenig, wenn keine der beiden Optionen benutzt wird. Darüber hinaus zeigt das Grafikmenü Beispiel-Screenshots zu den Auswirkungen der einzelnen Einstellmöglichkeiten. Beschreibungen fehlen allerdings. Abgerundet wird das Ganze durch eine VRAM-Auslastungsanzeige.

Einen richtigen Fullscreen-Modus gibt es nicht

Eine Besonderheit gibt es noch bei der Auflösung zu beachten. Denn God of War bietet auf dem PC keinen richtigen exklusiven Fullscreen-Modus, stattdessen läuft das Spiel immer in der eingestellten Auflösung des Windows-Desktops. Alternativ ist nur ein Fenster-Modus vorhanden. Das ist für mancherlei Dinge zwar sinnvoll, hat aber zum Beispiel den Nachteil, dass bei Nutzung von AMDs oder Nvidias Downsampling die höhere Auflösung bereits auf dem Windows-Desktop eingestellt werden muss. Denn das Spiel selber bietet kein Downsampling an.

Upscaling dagegen schon und das ist dann auch die Art und Weise, wie eine geringere Renderauflösung in God of War eingestellt wird. Denn so gibt es einen Regler, der die Renderauflösung in 10-Prozent-Schritten auf 50 bis 100 Prozent der Desktop-Auflösung konfiguriert. Der Vorteil der Methode ist, dass das HUD des Spiels durchweg in der bestmöglichen Qualität dargestellt wird. Allerdings zeigt sich mit dem Fenster-Modus im Vergleich, dass durchaus zwischen 5 und 10 Prozent an Performance-Gewinn bei einer niedrigeren Auflösung verloren gehen. Warum der Wert so ungewöhnlich hoch ist, bleibt unklar.

Alternativ lassen sich AMDs FSR oder Nvidias DLSS nutzen. Beides ist qualitativ dem spieleigenen Upscaling vorzuziehen, jedoch stehen einem dann weniger Auflösungsstufen zur Verfügung, da FSR und DLSS mit fest vorgegebenen Auflösungen arbeiten.