Zen 4 + CDNA 3 + 128 GB HBM3: AMD Instinct MI300 stapelt Chiplets für AI und HPC

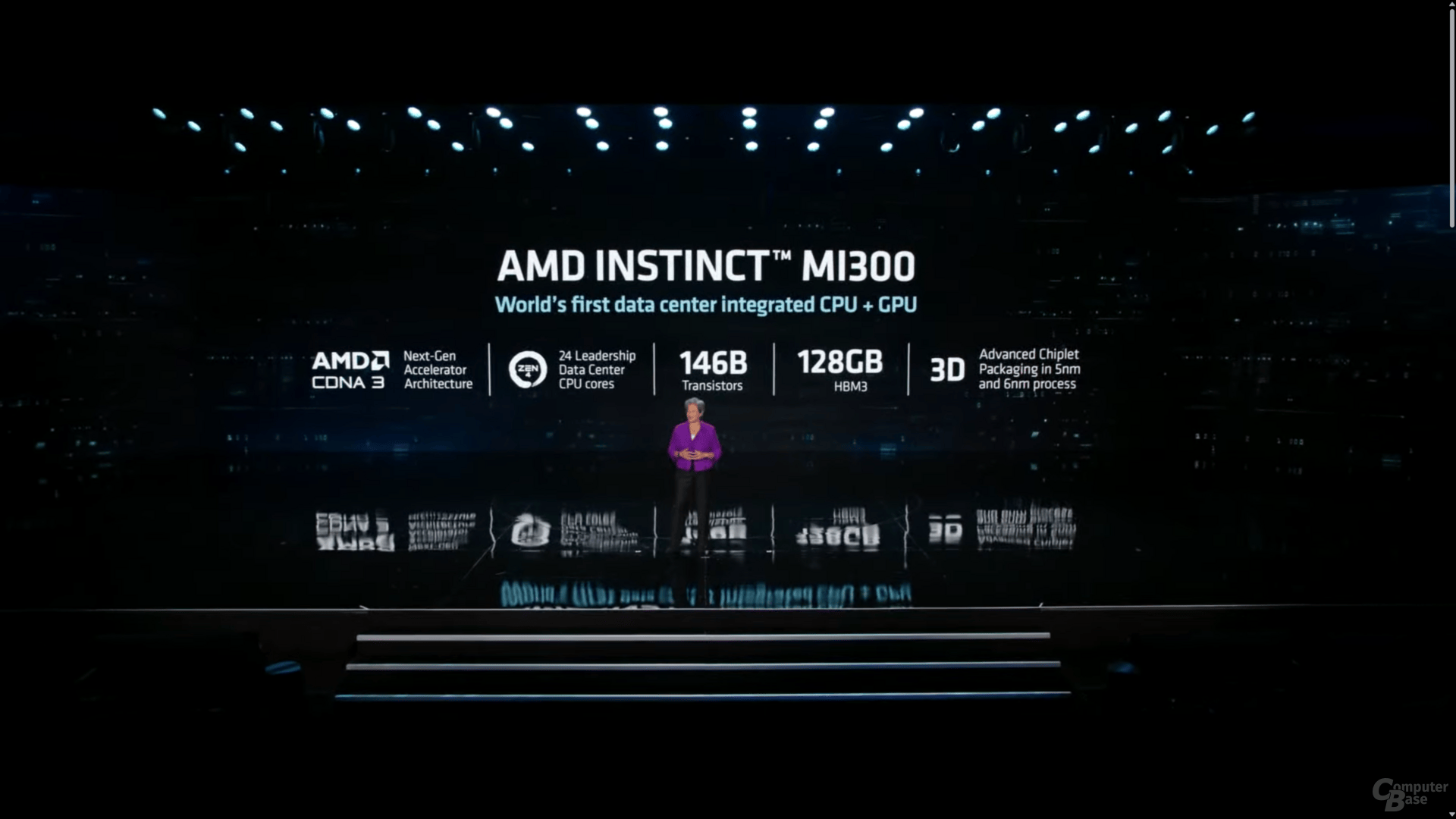

AMD Instinct MI300 stapelt insgesamt 24 Prozessorkerne auf Basis von Zen 4, eine auf CDNA 3 basierende Grafikeinheit sowie 128 GB HBM3 und den Infinity Cache erstmals mit Hilfe von „3D-Chiplet-Packaging“ sowie eines „Unified-Memory-Interface“ auf einem „Multi-Chip-Package“ zu einer 146 Milliarden Transistoren starken „HPC-APU“.

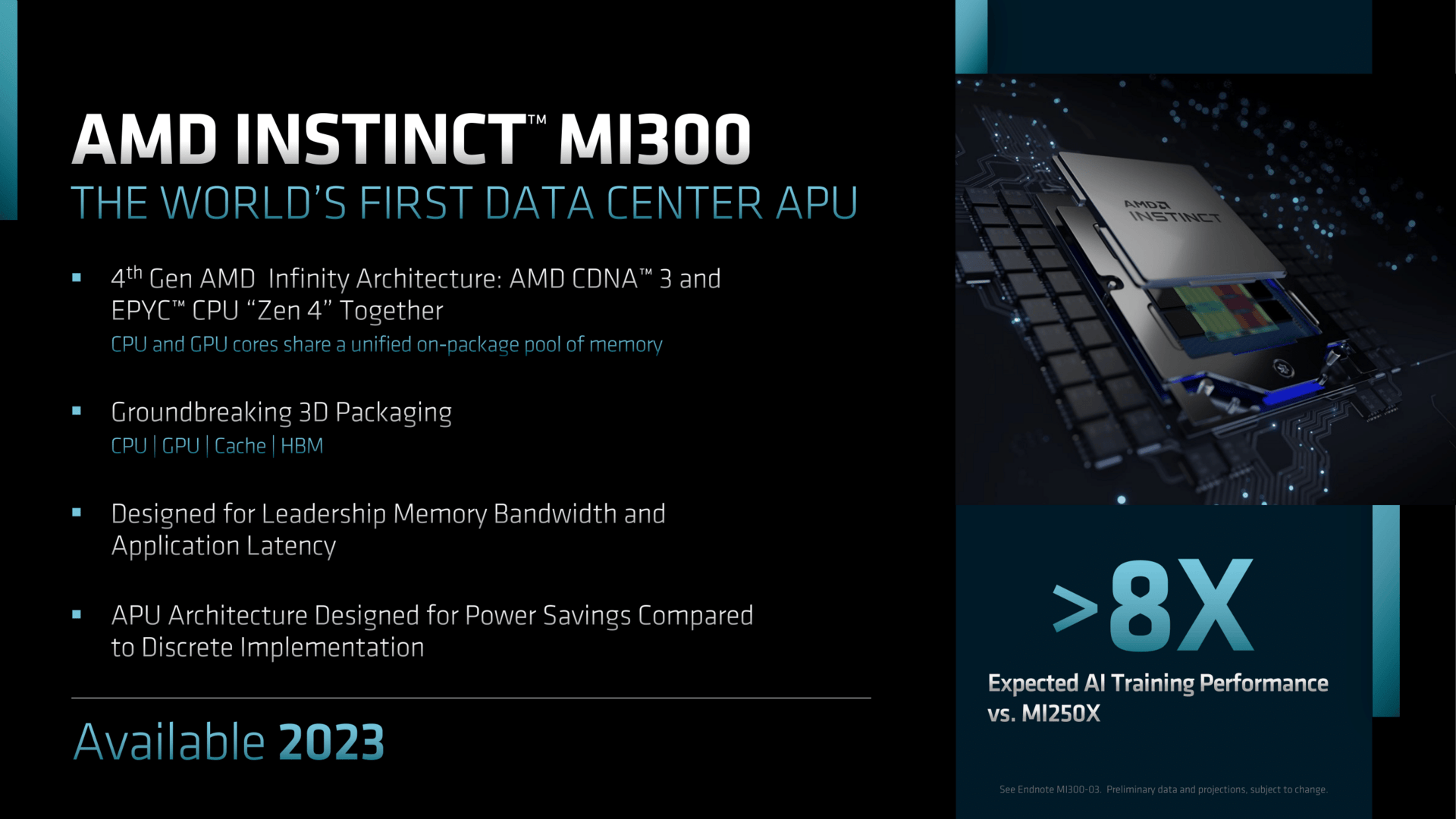

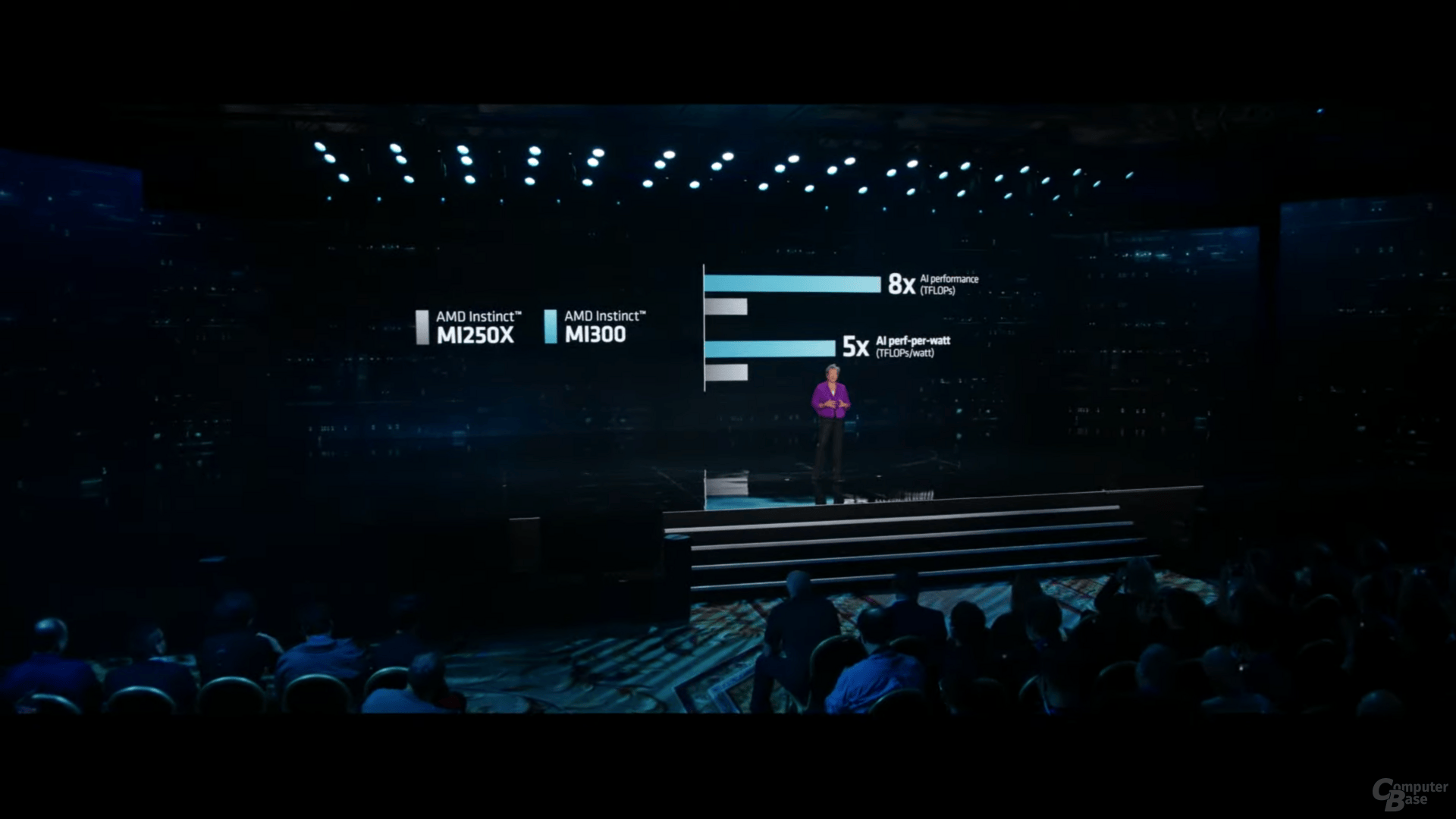

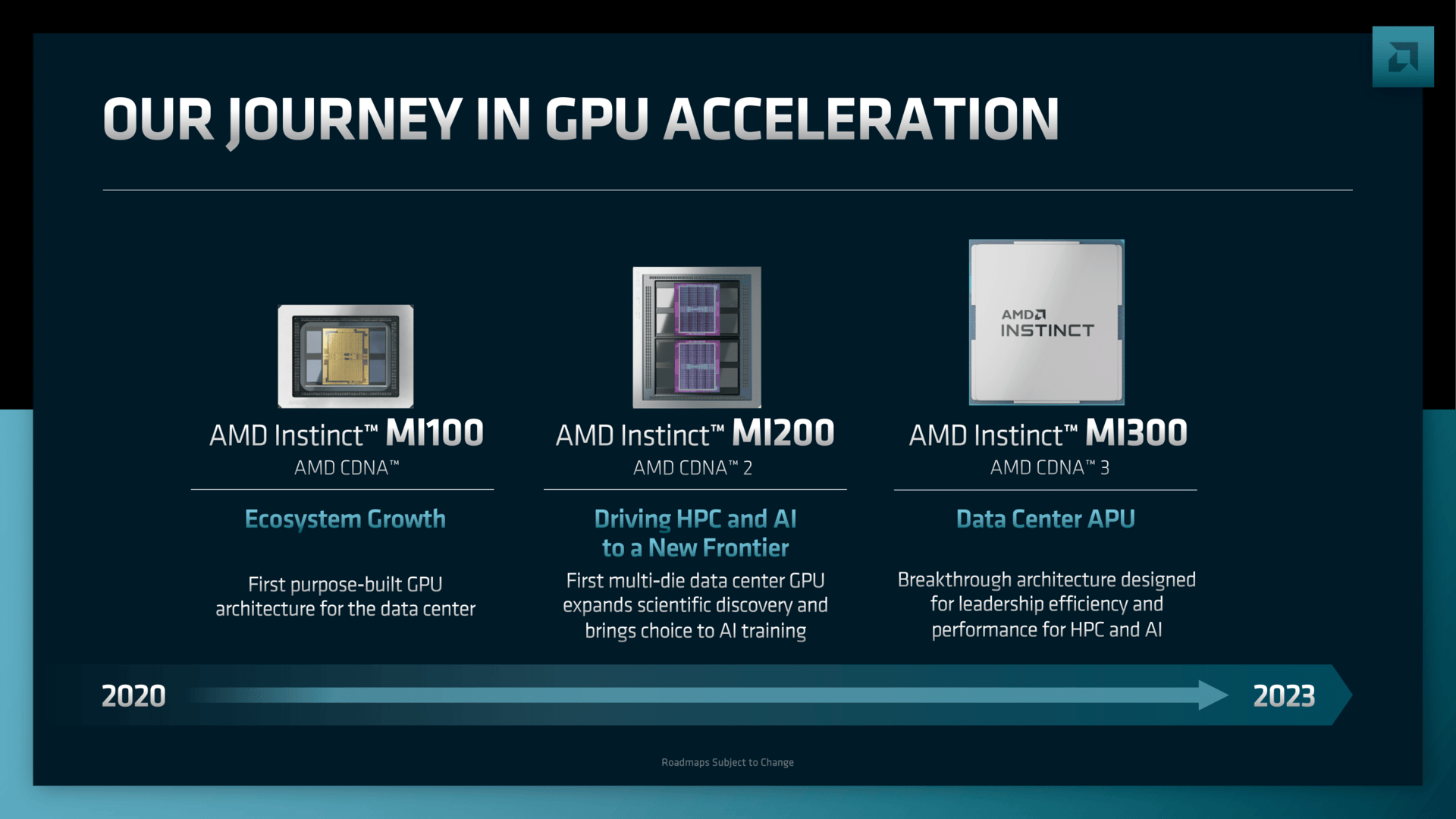

Abseits kommender Consumer-Hardware wie den drei Ryzen 7000X3D, insgesamt fünf Serien von Ryzen 7000 Mobile sowie den ersten Radeon RX 7000M hat AMD die CES 2023 dazu genutzt, neue Enterprise-Hardware für HPC und Data Center vorzustellen. Wie im Vorfeld bereits erwartet wurde, kündigte der Hersteller die AMD Instinct MI300, eine HPC-APU auf Basis von Zen 4, CDNA 3 und HBM3-Speicher an, welche 8 Mal mehr Leistung im Bereich AI bieten soll als die Vorgänger Instinct MI200 und MI250.

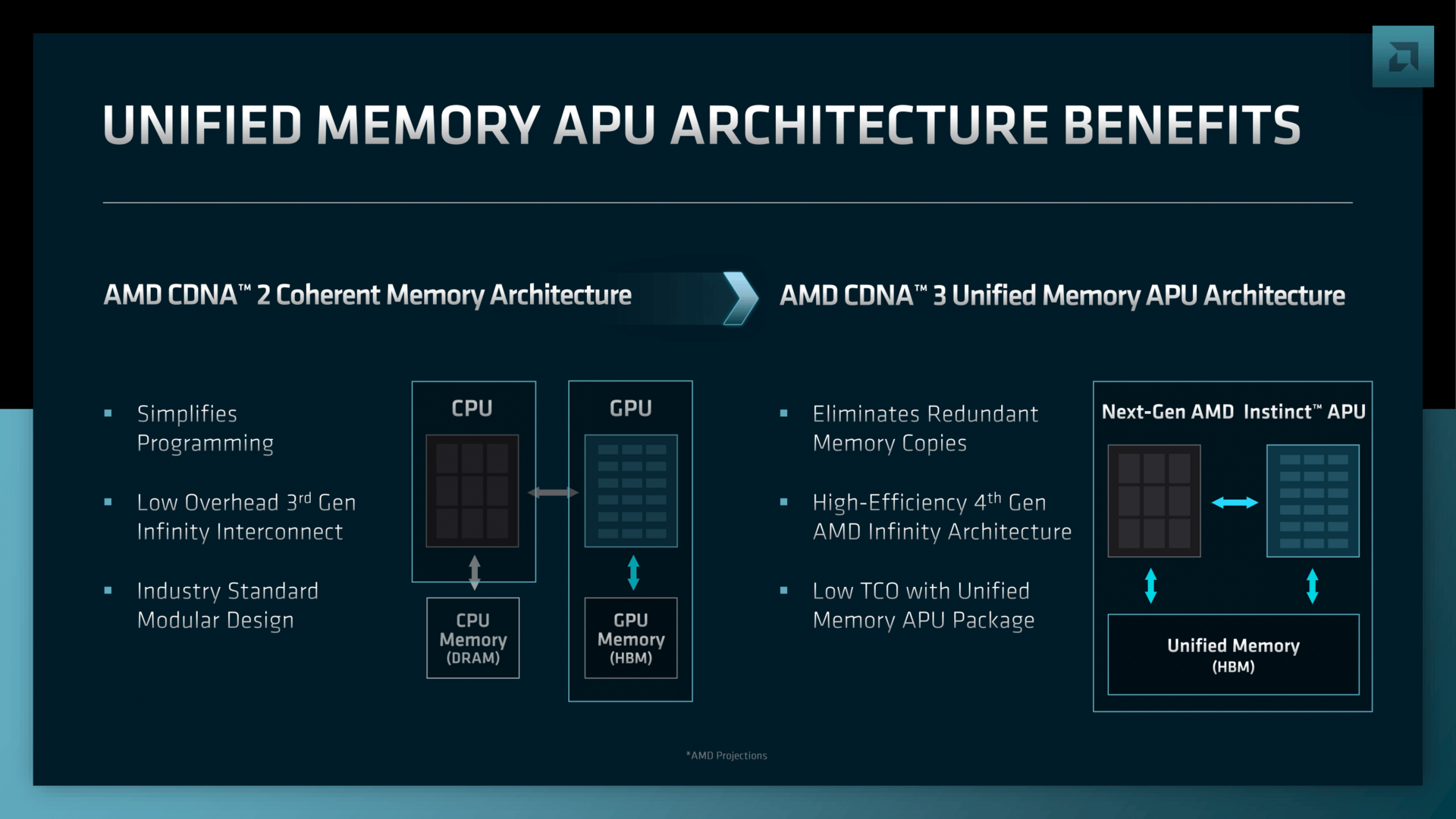

Die High-End-APU setzt bereits auf die vierte Generation der AMD Infinity Architecture und kombiniert erstmals eine Zen-4-CPU und eine CDNA-3-GPU sowie 128 GB HBM3 und den Infinity Cache auf einem Multi-Chip-Package. Der HBM3-Speicher kann dabei über ein 8.192-Bit breites Unified-Memory-Interface von der CPU und GPU genutzt werden.

Zum Einsatz kommen soll zudem eine neue Generation des AMD Infinity Caches sowie 24 „Zen 4 Leadership Data Center Cores“, die auch für AMD Epyc 9004 („Genoa“) Verwendung finden.

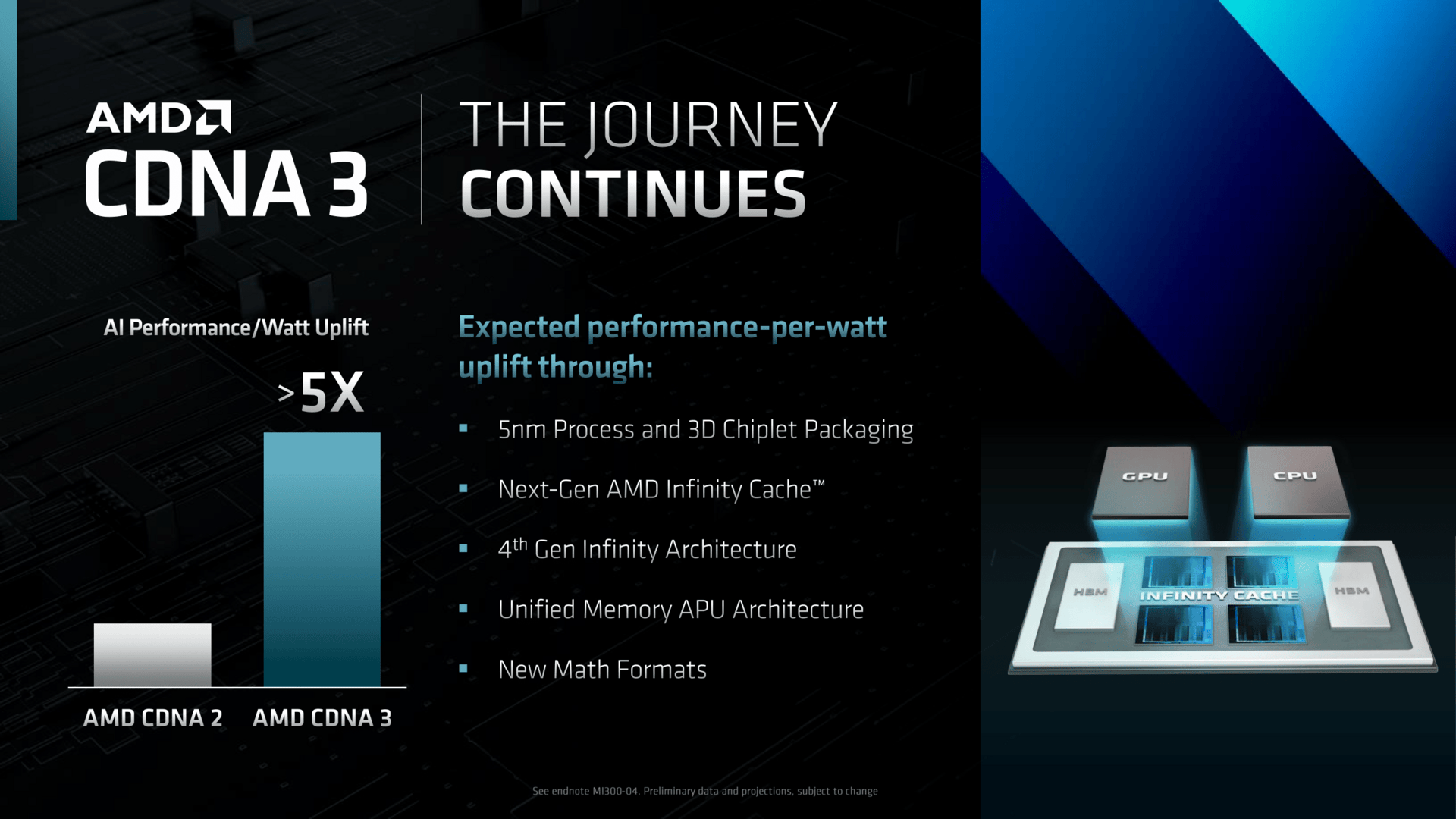

- Der Infinity Cache und der HBM3-Speicher werden auf dem „Base Layer“ platziert.

- Die CPU mit insgesamt 24 Zen-4-Prozessorkernen und die CDNA-3-Grafikeinheit sitzen darüber.

- Die Chips auf dem „Base Layer“ werden dabei in einer 6-nm-Node gefertigt.

- Die CPU und GPU nutzen hingegen bereits einen fortschrittlicheren 5-nm-Fertigungsprozess.

- Die 4. Generation der AMD Infinity Architecture soll vollen Support für CXL 3.0 bieten.

- AMD verspricht 8 mal mehr Leistung für AI (TFLOPS) sowie 5 mal mehr Leistung pro Watt für AI (TFLOPS/W) im direkten Vergleich mit der Vorgängergeneration auf Basis von CDNA 2.

Komplexe APU soll HPC effizienter machen

AMD-CEO Lisa Su sprach in diesem Zusammenhang von dem komplexesten Chip, den der Hersteller jemals entwickelt habe und der durch seine Kombination aus CPU, GPU, Infinity Cache und HBM3 die Programmierung für HPC-Workloads im Umfeld HPC und Data Center signifikant vereinfachen und Kosten einsparen soll.

Als eines der ersten (Prestige-)Projekte wird der Supercomputer El Capitan, welcher unter anderem auch Nuklearwaffen simulieren und im ersten Halbjahr 2024 an den Start gehen soll, auf die MI300-APU setzen.

Ob es die AMD Instinct MI300 neben der riesigen sockelbaren LGA-Lösung auch als PCIe-Ableger und/oder Varianten nur mit CDNA-3-GPU geben wird, blieb bei der Vorstellung auf der CES 2023 noch offen.

Verfügbarkeit ab dem 2. Halbjahr 2023

Die HPC-APU soll Enterprise-Kunden ab dem zweiten Halbjahr 2023 zur Verfügung stehen. Angaben zur TDP-Einstufung und den zu erwartenden Preisen machte der Hersteller, typisch für Enterprise-Produkte, bislang nicht.

- Asus ROG Swift Pro PG248QP: Erster Gaming-Monitor mit 540 Hz nutzt „E-Sport-TN“

- Nanoleaf 4D: Ambilight für den Fernseher mit Kamera und Matter

- Lenovo Yoga Book 9i: Zwei OLED-Displays bilden ein flexibles Notebook

- +99 weitere News