SK Hynix HBM3: 12 DRAM-Stapel liefern 24 GB in einem Package

Der auf schnelle Datentransfers und hohe Speicherdichte ausgelegte High Bandwidth Memory (HBM) mit gestapelten DRAM-Chips liefert bei SK Hynix jetzt noch mehr Speicherplatz. Der Hersteller hat die ersten HBM3-Packages mit 24 GB angekündigt. Darin werden 12 DRAM-Chips gestapelt.

Zuvor hatte SK Hynix maximal acht DRAM-Chips zu je 2 GB in seinem jüngsten HBM3 untergebracht und somit 16 GB geboten. Jetzt folgt die Steigerung der DRAM-Schichten um 50 Prozent mit entsprechender Kapazitätssteigerung beim Gesamtprodukt. Der Stapel soll dank TSV-Technik (Through Silicon Via) dabei nicht höher als beim 16-GB-Produkt ausfallen. Für mehr Effizienz bei der Herstellung sowie eine stabilere Leistung soll zusätzlich Advanced Mass Reflow Molded Underfill (MR-MUF) sorgen, eine Technik, die SK Hynix wie folgt beschreibt:

MR-MUF (Mass Reflow Molded Underfill): A method of placing multiple chips on the lower substrate and bonding them at once through reflow, and then simultaneously filling the gap between the chips or between the chip and the substrate with a mold material.

SK Hynix

Künftig geht noch deutlich mehr

Das Ende der Fahnenstange ist damit aber nicht erreicht, denn für die Zukunft werden DRAM-Chips mit 3 GB (24 Gbit) erwogen, sodass acht Stapel bereits 24 GB und zwölf Stapel 36 GB bieten würden. Außerdem hatte SK Hynix auch schon von einer Erhöhung auf 16 Stapel sowie dem Einsatz von 4-GB-DRAM-Chips gesprochen, was 64 GB pro HBM-Package bedeuten würde.

Während letztere Überlegungen noch in der (fernen) Zukunft liegen, ist HBM3 mit 24 GB nun Realität. Laut SK Hynix werden Muster an Kunden ausgeliefert und deren Leistung geprüft. Die Vorbereitungen für die Massenproduktion werden voraussichtlich innerhalb des ersten Halbjahres abgeschlossen sein.

Bis zu 819 GB/s

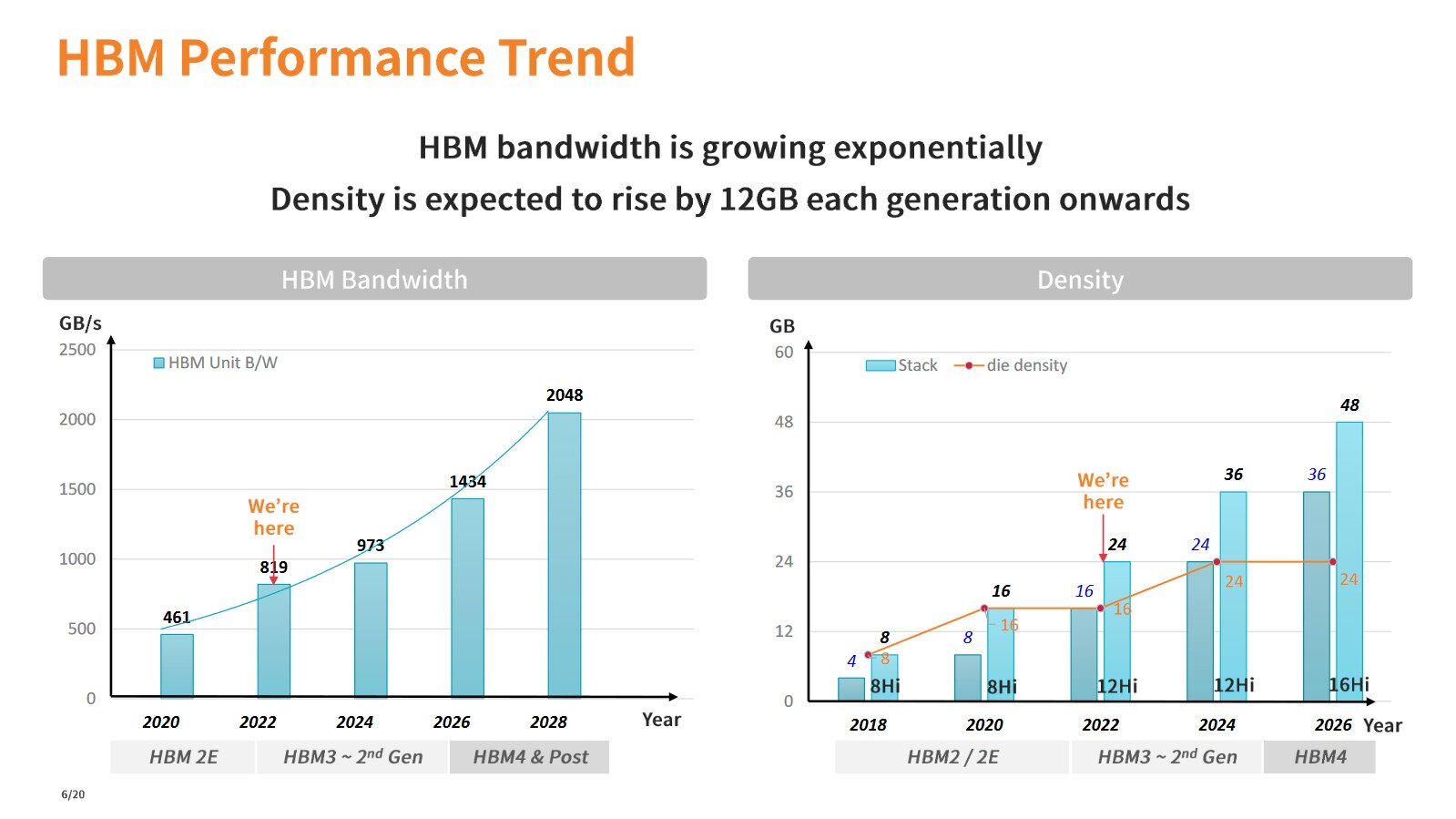

Für den HBM3-Standard ist ein Durchsatz von bis zu 819 GB/s pro Stapel spezifiziert. Bei HBM2 waren es anfangs noch 256 GB/s und bei HBM2E dann 460 GB/s. Für nächstes Jahr wird die zweite HBM3-Generation mit bis zu 973 GB/s erwartet. Mit HBM4 und über 1 TB/s wird nicht vor 2026 gerechnet.

Zu den jüngsten Abnehmern von HBM3 zählt etwa Nvidia mit seinen GPU-Beschleunigern Nvidia H100 NVL, die auf den Einsatz von Large Language Models (LLM) abzielen. Auch AMD setzt bei den HPC-Beschleunigern der Serie Instinct MI300 auf HBM3.