hessian.AI fortytwo: KI-Supercomputer mit 8 PFLOPS steht in Darmstadt

Das Hessische Zentrum für Künstliche Intelligenz (hessian.AI) hat den Supercomputer fortytwo vorgestellt, der im GSI/FAIR-Campus bei Darmstadt steht. Das mit Komponenten von HPE und Nvidia entworfene System ist für maschinelles Lernen und Trainieren großer KI-Modelle ausgelegt und soll komplexe Forschungsfragen beantworten.

Als hochschulübergreifendes KI-Zentrum mit Hauptsitz an der Technischen Universität Darmstadt will hessian.AI mit dem Superrechner fortytwo einen Grundstein für leistungsfähige KI-Anwendungen von Unternehmen und Forschungseinrichtungen schaffen. Als „Eckpfeiler für Grundlagenforschung“ in diesem Bereich soll fortytwo dabei helfen, „neue Erkenntnisse und Antworten auf komplexe Fragen in den Bereichen der künstlichen Intelligenz und des maschinellen Lernens zu finden“.

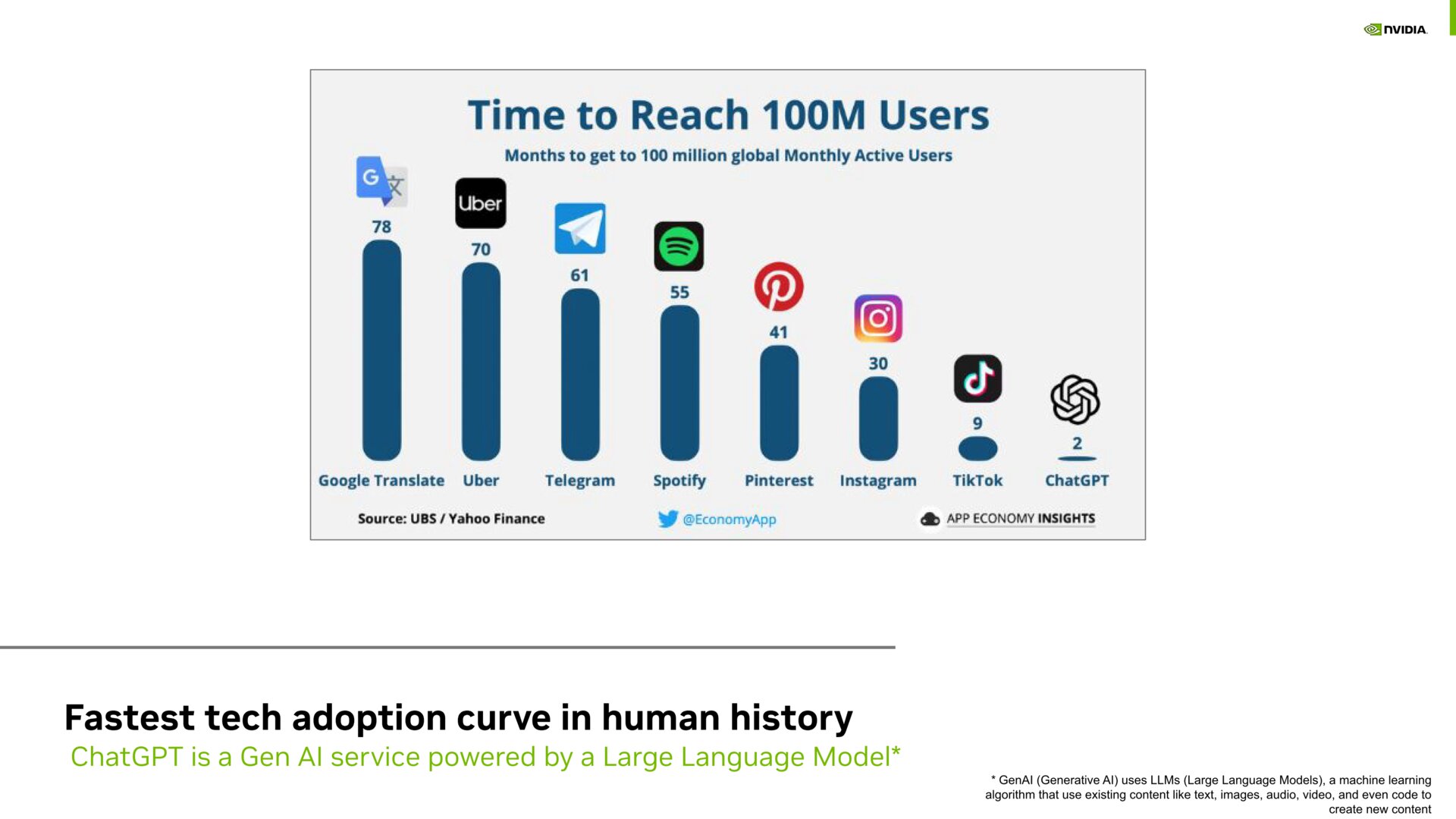

Nach dem Vorbild von OpenAI (ChatGPT) oder Hugging Face sei ein Large Language Model zur freien Nutzung geplant. Firmen könnten wiederum Projekte auf Anfrage auf dem System durchführen. Ohnehin sind Dienste wie ChatGPT das schlagkräftige Argument für die Relevanz solcher KI-Systeme: In der Präsentation von hessian.AI wurde das rasante Wachstum hervorgehoben, denn ChatGPT habe bereits innerhalb von 2 Monaten einer Nutzerbasis von 100 Millionen erreicht. Das habe bisher kein anderes Online-Angebot geschafft.

Hintergrund zur Namensgebung

Beim Namen haben sich die Betreiber von Douglas Adams Klassiker „Per Anhalter durch die Galaxis“ inspirieren lassen, in dem die Zahl 42 von einem Computer als Antwort auf „die Ultimative Frage des Lebens, des Universums und dem ganzen Rest“ genannt wurde.

Standort und Förderung

Das schon betriebsbereite System ist im Green IT Cube auf dem GSI/FAIR-Campus im Norden Darmstadts untergebracht. Das Rechenzentrum besitzt ein effizientes Kühlsystem, mit dem lediglich 7 Prozent des gesamten Energieaufwands für die Kühlung benötigt werden.

Das Land Hessen sowie das Bundesministerium für Bildung und Forschung (BMBF) stellen für fortytwo 14,5 Millionen Euro bereit und werden in den kommenden Jahren rund 40 Millionen Euro in das gesamte KI-Projekt fließen lassen. Beteiligt sind 13 hessische Hochschulen sowie 22 Wissenschaftler, 22 neue Professuren sollen hinzu kommen.

Die Hardware mit 632 Nvidia A100

Auf insgesamt 18 Serverschränke (Racks) mit jeweils 4 oder 5 Rechenknoten (Nodes) verteilen sich 632 GPUs vom Typ Nvidia A100 mit je 80 GB Speicher (HBM2e). Jeder der insgesamt 79 AI-Compute-Nodes basiert auf Nvidias SuperPod-Platinen der HGX-A100-Serie und beherbergt acht Nvidia A100, die in Paaren angeordnet untereinander mit jeweils 600 GB/s via NVLinks kommunizieren. Hinzu kommt 1 TB Arbeitsspeicher pro Node.

In einem weiteren Node stecken vier IPUs (Intelligence Processing Unit) des Typs M2000 der britischen Firma Graphcore. IPUs sind auf paralleles Rechnen ausgelegte Prozessoren, die speziell für KI-Workloads entworfen sind.

Das gesamte System verfügt zudem über 1,2 PetaByte (1.200 Terabyte) nutzbaren Flash-Speicher. Die Basis des Supercomputers bildet das Apollo-6500-System von HPE.

8 PetaFLOPS im Linpack-Benchmark

Im Linpack-Benchmark wurde eine maximale Rechenleistung von rund 8 PetaFLOPS ermittelt, womit das System unter den 100 schnellsten Supercomputern in der Top500-Weltrangliste liegen würde. Doch erst in einer kommenden Ausgabe der Top500 und der Green500 wird fortytwo in die Ranglisten aufgenommen. Da für den Benchmark nur 72 der 79 Compute-Nodes genutzt wurden, besteht noch etwas Luft nach oben. Doch wurde angemerkt, dass Linpack, der Gleitkommaoperationen nutzt, für einen KI-Rechner nicht der relevante Maßstab sei.