Ratchet & Clank: Rift Apart im Test: Benchmarks (FHD, WQHD & UHD), Frametimes und VRAM

3/5Das Testsystem und die Benchmark-Szene

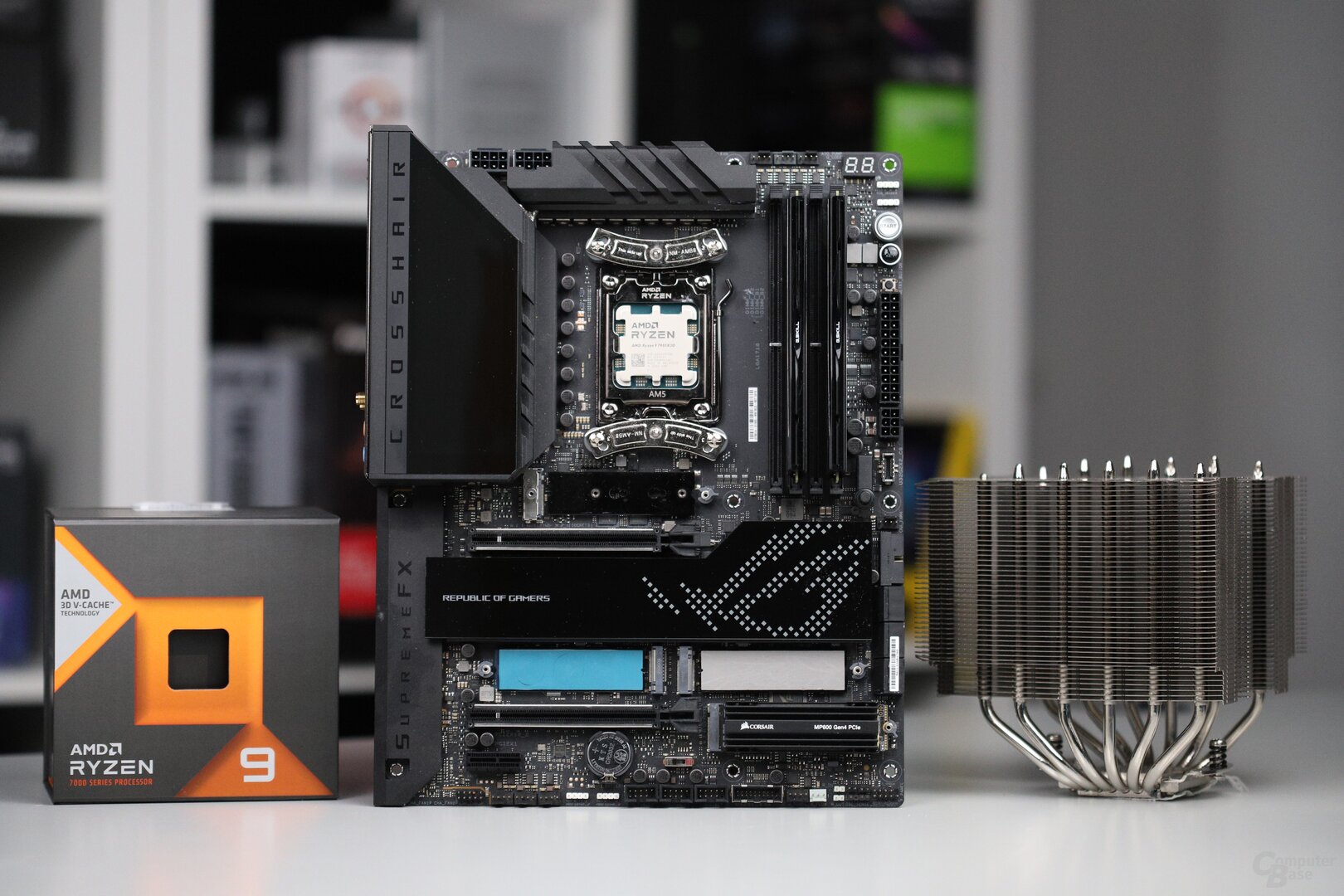

Alle Benchmarks wurden auf einem AMD Ryzen 9 7950X3D (Test) durchgeführt, der mit den Standardeinstellungen betrieben wurde. Als Mainboard war das Asus ROG Crosshair X670E Hero (BIOS 1415) verbaut.

Die CPU wurde von einem Noctua NH-D15S mit zentral installiertem 140-mm-Lüfter gekühlt. 32 GB Speicher (G.Skill TridentZ Neo, 2 × 16 GB, DDR5-6000, CL30-38-38-96) standen dem Prozessor zur Verfügung. Windows 11 22H2 mit sämtlichen Updates und aktiviertem HVCI war auf einer NVMe-M.2-SSD mit PCIe 4.0 installiert. Dasselbe galt für das Spiel. Resizable BAR wurde auf unterstützten Grafikkarten sowohl bei AMD als auch bei Nvidia genutzt.

| Treiberversion | Game Ready | |

|---|---|---|

| AMD Radeon | Adrenalin 23.7.2 | Nein |

| Nvidia GeForce | GeForce 536.67 | ✓ |

| Intel Arc | 4576 | Nein |

Die 25 Sekunden lange Testsequenz spielt auf Cordelion in der Kedaro-Station. Die Testszene findet in einer geschlossenen, leicht unter Wasser stehenden Unterwasserstation statt. Entsprechend gibt es eine Menge Reflexionen und kleine Details in der Testsequenz zu sehen, dasselbe gilt für Partikeleffekte. Die Szene erzeugt eine hohe GPU-Last – sowohl mit als auch ohne Raytracing. Die Framerate ist verhältnismäßig niedrig, vergleichbare Sequenzen gibt es aber immer mal wieder im Spiel.

| Auflösung | Grafikdetails |

|---|---|

| 1.920 × 1.080 | Sehr-hoch-Preset, Schattenqualität „Ultra“, Detailstufe „Ultra“, 16-faches AF |

| 2.560 × 1.440 | Sehr-hoch-Preset, Schattenqualität „Ultra“, Detailstufe „Ultra“, 16-faches AF |

| 3.840 × 2.160 | Sehr-hoch-Preset, Schattenqualität „Ultra“, Detailstufe „Ultra“, 16-faches AF, Upsampling „Quality“ |

| Bei Raytracing | RT-Reflexionen „Sehr hoch“, RT-Schatten „Sehr hoch“, RT-AO „Sehr hoch“, RT-Detailstufe 10 |

Benchmarks in Full HD, WQHD und Ultra HD (Update)

Ratchet & Clank: Rift Apart zeigt in der Testsequenz interessante und ungewöhnliche Ergebnisse. Radeon-Grafikkarten drehen regelrechte Kreise um die Konkurrenzmodelle von Nvidia – ob es sich dabei um die neuen Generationen Ada Lovelace und RDNA 3 oder um die älteren Ampere- und RDNA-2-Modelle handelt, spielt keine Rolle. Vor allem bei den Perzentil-Messungen liegen die Grafikkarten von AMD weit vorne.

Darüber hinaus ist auffällig, dass der Unterschied immer kleiner wird, je höher die Auflösung liegt. AMD bleibt zwar auch in Ultra HD durchweg vorne, der Vorsprung schmilzt aber zusammen. So liefert die Radeon RX 7900 XTX in 1.920 × 1.080 18 Prozent mehr Durchschnitts-FPS als die GeForce RTX 4080, in 2.560 × 1.440 sind es dann noch 11 Prozent und in 3.840 × 2.160 mit Upsampling auf „Quality“ 6 Prozent. Um ein Problem mit einem niedrigeren CPU-Limit handelt es sich bei den Nvidia-Karten dabei nicht, denn selbst eine GeForce RTX 4090 wird in der Testsequenz in 1.280 × 720 mit DLSS „Performance“ immer noch zu mehr als 95 Prozent ausgelastet.

Noch größer sind die Unterschiede bei den Perzentil-FPS. Dort schneidet die Radeon RX 7900 XTX in Full HD mal eben 33 Prozent besser als die GeForce RTX 4080 ab. Wird nun die Anzahl der Renderpixel erhöht, sinkt auch dort der Vorsprung. In WQHD beträgt dieser noch 28 Prozent und in Ultra HD sind es 15 Prozent. Ein Blick auf die Frametime-Messung zeigt, warum dies so ist.

Auch die Radeon RX 6800 XT hat die Nase klar vor der GeForce RTX 3080 und liefert in Full HD 14 Prozent mehr FPS. In den höheren Auflösungen bleibt sie 11 respektive 2 Prozent vorne. Ähnliches gilt für die Radeon RX 6700 XT im Vergleich zur GeForce RTX 3060 Ti, die um 30, 23 respektive 14 Prozent vorne liegt.

Intels Arc-Grafikkarten scheint Ratchet & Clank: Rift Apart nicht sonderlich zu schmecken. In Full HD wird die 60-FPS-Marke denkbar knapp verfehlt, sodass die GeForce RTX 3060 Ti 22 Prozent und die Radeon RX 6700 XT 59 Prozent mehr FPS liefert.

Die Anforderungen sind gering

60 FPS sind in Ratchet & Clank: Rift Apart kein großes Problem, wenn Raytracing abgeschaltet bleibt. In 1.920 × 1.080 gelingt dies bereits einer GeForce RTX 3060, während die Radeon RX 6650 XT und die Arc A750 an dem Ziel scheitern. Intel-Grafikkarten sind nicht sonderlich schnell in dem Spiel und der kleinen Radeon tut die Kombination aus 8 GB VRAM und halbiertem Speicherinterface überhaupt nicht gut. Auch die neue Radeon RX 7600 kann die Zielmarke deswegen nicht überspringen, Rechenleistung gibt es eigentlich genug dafür. Die GeForce RTX 4060 schafft das trotz derselben Problematik, ihr hilft Nvidias besseres Speichermanagement.

In 2.560 × 1.440 steigen die Anforderungen moderat ab. 60 Bilder pro Sekunde wird ab einer GeForce RTX 3070, GeForce RTX 4060 Ti (mit einem zugedrückten Auge) und einer Radeon RX 6700 XT erreicht. Für 3.840 × 2.160 mit Upsampling auf der Stufe Quality muss es nicht viel schneller werden, 60 FPS werden ab der GeForce RTX 3080, GeForce RTX 4070 und der Radeon RX 6800 erreicht.

Benchmarks in Full HD, WQHD und Ultra HD mit Raytracing (Update)

Mit Raytracing fallen alle AMD-Grafikkarten weg, denn sie unterstützen in Ratchet & Clank: Rift Apart die Strahlen aus unerklärlichen Gründen noch nicht bzw. das Spiel lässt das Feature auf Radeon RX nicht zu. Entsprechend fällt das Testfeld deutlich kleiner als gewohnt aus und die GeForce RTX 4080 kann sich klar an die Spitze setzen.

Bereits in Full HD liefert die GeForce RTX 4080 68 Prozent mehr FPS als die GeForce RTX 3080. In WQHD sind es dann noch höhere 103 Prozent und in Ultra HD gar satte 142 Prozent – im Wesentlichen deshalb, weil der GeForce RTX 3080 ab WQHD der Speicher ausgeht. Die GeForce RTX 3060 Ti hält den zuvor gezeigten Rückstand in Full HD, in höheren Auflösungen geht dann beiden Grafikkarten der Speicher aus. Die Arc A770 schafft es, den Rückstand zur GeForce RTX 3060 Ti von 18 Prozent auf 14 Prozent bei aktiviertem Raytracing zu reduzieren.

Mit Raytracing benötigt es deutlich schnellere GPUs

Vor allem mit den vollen Raytracing-Details benötigt Ratchet & Clank: Rift Apart eine schnelle Nvidia-Grafikkarte. AMD-Grafikkarten beherrschen in dem Spiel noch kein Raytracing, Intel-GPUs haben schon ohne zu kämpfen. In Full HD werden 60 FPS ab einer GeForce RTX 3080 und einer GeForce GeForce RTX 4070 erreicht. Für WQHD muss es dann eine GeForce RTX RTX 3080 Ti oder eine GeForce RTX 4070 TI sein, während für Ultra HD mit DLSS Quality mindestens eine GeForce RTX 3090 Ti oder eine GeForce RTX 4070 Ti benötigt wird.

Mit dem Framepacing gibt es Probleme – vor allem bei Nvidia

Das Framepacing ist in Ratchet & Clank: Rift Apart aktuell wenig gelungen – und das ganz unabhängig von irgendwelchen Rift-Problemen. Bereits beim normalen Herumlaufen in der Spielwelt ist die Bildausgabe unregelmäßig. Immerhin: Große Abstände gibt es zwischen den einzelnen Frames nicht, aber viele kleine und vor allem mittelgroße Ausreißer. Und das lässt sich spüren, unter 60 FPS fühlt sich das Spiel schnell unrund an. Dort sollten die Entwickler noch einmal ran.

Generell sind alle Grafikkarten von dem Problem betroffen, Nvidia-Beschleuniger haben aber deutlich mehr Probleme damit als die Radeon-Kollegen. So zeigt die GeForce RTX 4080 während der Testsequenz ein andauerndes Auf und Ab ohne eine einzige Pause. Dabei macht es auch keinen Unterschied, ob Raytracing an- oder abgeschaltet ist.

Auch die Radeon RX 7900 XTX hat das Problem, allerdings sind nicht nur die Abstände zwischen den Frames an sich etwas geringer, es gibt obendrein immer mal wieder kurze Sequenzen, in denen die Bildausgabe normal ist. Das ist auch der Grund, warum Radeon-Grafikkarten bei den Perzentil-Messungen deutlich besser abschneiden als die GeForce-Modelle. Dabei macht es auch keinen Unterschied, ob es sich um die aktuelle oder die vorherige Generation handelt.

VRAM ist ein Thema in Ratchet & Clank

Ratchet & Clank: Rift Apart benötigt eine ordentliche Portion Grafikspeicher, jedoch versteckt das Spiel dies ganz gut. Das fängt damit an, dass es bei größeren Grafikkarten nie so viel Speicher adressiert, wie vorhanden ist – stattdessen werden frühzeitig Daten aus dem VRAM geschmissen. Darüber hinaus reagiert das Game sehr unterschiedlich auf Speichermangel. Manchmal bricht die Performance völlig ein, in der Regel ist sie aber nur sehr inkonsistent. Bei Letzterem bleibt Ratchet & Clank spielbar, die Framerate schwankt allerdings deutlich.

Ohne Raytracing hält sich der VRAM-Hunger des Spiels in Grenzen. 8 GB sind bereits genug, jedoch muss dafür das volle PCIe-Interface vorhanden sein. Bei der Radeon RX 6650 XT mit dem halbierten PCIe-Interface sind 8 GB zum Beispiel zu wenig, hier muss die Texturstufe reduziert werden. Bei dem vollen Interface läuft das Spiel selbst in Ultra HD noch ordentlich, ist allerdings am Limit. Wenn dann zum Beispiel eine Grafikoption geändert wird, läuft der Speicher schnell über. Das kann sogar erst nach längerer Spielzeit passieren.

Mit Raytracing steigen die Anforderungen an den Speicher deutlich an. Wirklich sorgenfrei ist man erst ab 20 GB – dann gibt es selbst mit der nativen Ultra-HD-Auflösung keine Probleme mehr. Bei 16 GB heißt es hingegen wieder „Leben am Limit“. Bereits eine Änderung der Grafikoption ohne Neustart kann die Performance zum Einsturz bringen, was zeigt, dass der vorhandene VRAM komplett ausgereizt wird. Bei Ultra HD inklusive Upsampling gibt es keinerlei Probleme mehr bei 16 GB.

Mit 12 GB läuft wiederum Ultra HD mit Upsampling auf der Quality-Stufe noch gut, doch gilt auch dann, dass der Grafikspeicher vom Spiel immer wieder richtig geleert werden muss, ansonsten gibt es sofort Probleme.

Für einen problemlosen Betrieb in Full HD inklusive Raytracing und schönster Texturen muss die Grafikkarte mindestens über 10 GB verfügen. Mit 8 GB läuft die Auflösung auch noch gut, nur darf dann wieder keinerlei Option geändert werden, ohne dass das Spiel im Anschluss neu gestartet wird.