Arbeitsspeicher: GDDR7, HBM3E und LPDDR5X werden weiter beschleunigt

Zu den Themen der diesjährigen ISSCC gehören Neuheiten aus dem DRAM-Bereich. Während Samsung seinen GDDR7 mit 37 Gbit/s näher vorstellen wird, steht bei SK Hynix LPDDR5 mit 10,5 Gbit/s auf dem Programm. Und auch HBM3E mit noch mehr Durchsatz ist ein Thema.

GDDR7 mit 37 Gbit/s

Die neue Grafikspeichergeneration GDDR7 wird voraussichtlich mit 32 Gbit/s den Anfang machen, solche Chips hat Samsung bereits letzten Sommer fertig entwickelt. Auf der am 18. Februar startenden ISSCC 2024 wird Samsung aber über „A 16Gb 37Gb/s GDDR7 DRAM with PAM3-Optimized TRX Equalization and ZQ Calibration“ sprechen, so der Name der für den 20. Februar angesetzten Session.

Im Vorfeld waren schon 36 Gbit/s in Aussicht gestellt worden, was also noch nicht das Ende der Fahnenstange ist. Mit 16 Gbit besitzt der GDDR7-Speicher umgerechnet 2 GByte Speicherkapazität. Eine Grafikkarte mit 16 GB würde also acht Chips benötigen, das ist also kein Fortschritt gegenüber GDDR6.

Doch der Durchsatz steigt enorm, denn GDDR6 kommt derzeit auf maximal 24 Gbit/s, der GDDR7 mit 37 Gbit/s wäre also über 50 Prozent schneller. Dies ermöglicht bei gleichem Speicherinterface einen entsprechend höheren Durchsatz, allgemein als „Speicherbandbreite“ bezeichnet, oder aber einen schmaleren Speicherbus bei ähnlichem Durchsatz wie mit GDDR6.

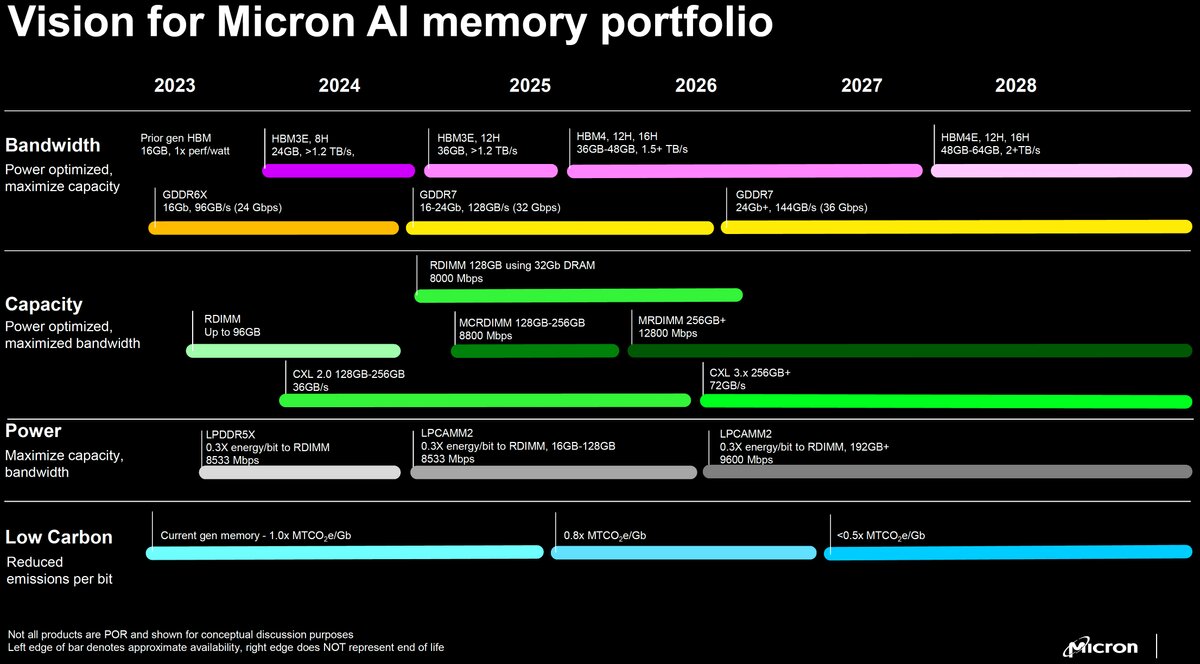

Die Serienfertigung von Samsungs GDDR7 mit 32 Gbit/s wird für dieses Jahr erwartet und auch bei Micron steht GDDR7 für Ende 2024 auf der Roadmap. Dass kommende GeForce- und Radeon-Grafikkarten den Speicher nutzen werden, davon ist auszugehen. Doch auch bei Netzwerklösungen kommt GDDR-Speicher zum Einsatz.

LPDDR5 Turbo mit 10,5 Gbit/s

Von einem „1a-nm 1.05V 10.5Gb/s/pin 16Gb LPDDR5 Turbo DRAM with a WCK-Correction Strategy, a Voltage-Offset-Calibrated Receiver and Parasitic Capacitance Reduction“ wird SK Hynix auf der ISSCC sprechen. Vor einem Jahr hatte das Unternehmen schon seinen LPDDR5T (T für Turbo) mit einer auf 9,6 Gbit/s beschleunigten Datenrate vorgestellt. Jetzt geht es hoch auf 10,5 Gbit/s für noch mehr Durchsatz. Gefertigt wird der Speicher im sogenannten 1a-nm-Verfahren. 16 Gbit bedeuten auch hier 2 GByte Speicherkapazität pro Chip.

LPDDR5-Speicher wird bisher vor allem bei Smartphones, Tablets und sehr kompakten Notebooks respektive 2-in-1 eingesetzt. Bisher stets direkt verlötet ermöglicht der neue Formfaktor LPCAMM2 austauschbare Module. Samsung hatte bereits LPCAMM auf Basis von LPDDR5X gezeigt und den Marktstart für 2024 angekündigt.

HBM3E mit 1,28 TB/s

Beim High Bandwidth Memory (HBM) gibt es bevor HBM4 erscheint noch einmal beschleunigte HBM3-Versionen. Sowohl SK Hynix als auch Samsung sprechen dabei von HBM3E und wollen mit einem Turm aus gestapelten DRAM-Dies Transferraten von mehr als 1,2 TB/s erreichen. Das ist aktuell vor allem für den Bereich der KI-Beschleunigerkarten interessant. Sowohl AMD als auch Nvidia bestücken diese mit schnellen HBM-Chips.

Der als Thema für die ISSCC angekündigte „48GB 16-High 1280GB/s HBM3E DRAM with All-Around Power TSV and a 6-Phase RDQS Scheme for TSV Area Optimization“ basiert also auf 16 gestapelten Chips, die zusammen 48 GByte Speicherplatz und einen Durchsatz von 1,28 TB/s erreichen. Hier dürften sich die Hersteller ein Wettrennen um die letzten MB/s hinter dem Komma liefern, zumindest ähnlich wird das Niveau bei Micron und Samsung ausfallen.

| max. Durchsatz pro Pin | max. Durchsatz pro Stack | max. Kapazität pro Stack | |

|---|---|---|---|

| HBM1 | 1,0 Gb/s | 128 GB/s | 1 GB |

| HBM2 | 2,0 Gb/s | 256 GB/s | 8 GB |

| HBM2E | 3,6 Gb/s | 461 GB/s | 16 GB |

| HBM3 | 6,4 Gb/s | 819 GB/s | 24 GB |

| HBM3 Gen2 (Micron) | 9,2 Gb/s | 1.178 GB/s | 36 GB |

| HBM3E (Samsung) | 9,8 Gb/s | 1.254 GB/s | ? |

| HBM3E (SK Hynix) | 10,0 Gb/s | 1.280 GB/s | 48 GB |

| HBM4 | ? | 1.500+ GB/s | 48 GB |

| HBM4E | ? | 2.000+ GB/s | 64 GB |

Micron ist erst kürzlich in das HBM-Geschäft eingestiegen, hat aber bereits HBM4 mit über 1,5 TB/s und später sogar mehr als 2 TB/s bei HBM4E auf der Roadmap stehen.

Ihr habt die Wahl: Macht mit bei den Reader's Choice Awards 2025 und bestimmt eure Hersteller des Jahres!

- Arbeitsspeicher: GDDR7, HBM3E und LPDDR5X werden weiter beschleunigt

- 28,5 Gbit/mm²: Samsungs 280-Layer-NAND schlägt bei Flächendichte alles