Serienfertigung gestartet: Micron bestückt Nvidias H200 mit 144 GB HBM3E

Der globale KI-Boom sorgt für steigende Nachfrage nach besonders schnellem Arbeitsspeicher wie den High Bandwidth Memory (HBM). Micron ist erst neu in diesem Geschäft, will mit seinem jetzt in die Massenfertigung gebrachten HBM3E aber direkt die Konkurrenz ausstechen. Einen Großabnehmer hat Micron mit Nvidias H200 gefunden.

Micron ist spät dran, aber direkt auf Nvidias H200

Erst letzten Sommer sprang Micron auf den HBM-Zug auf, während Samsung und SK Hynix schon lange im Geschäft sind. Dafür steigt Micron gleich in die dritte Generation respektive deren Weiterentwicklung HBM3E ein und verspricht eine Datenrate von 9,2 Gbit/s pro Pin respektive einen Speicherdurchsatz von rund 1,2 TB/s für einen ganzen Stapel. Dieser besteht aus acht übereinander geschichteten und mittels TSV verbundenen DRAM-Dies mit je 3 GB Speicherkapazität, sodass insgesamt 24 GB in einem Stack zur Verfügung stehen.

| max. Durchsatz pro Pin | max. Durchsatz pro Stack | max. Kapazität pro Stack | |

|---|---|---|---|

| HBM1 | 1,0 Gb/s | 128 GB/s | 1 GB |

| HBM2 | 2,0 Gb/s | 256 GB/s | 8 GB |

| HBM2E | 3,6 Gb/s | 461 GB/s | 16 GB |

| HBM3 | 6,4 Gb/s | 819 GB/s | 24 GB |

| HBM3E (Micron) | 9,2 Gb/s | 1.178 GB/s | 36 GB |

| HBM3E (Samsung) | 9,8 Gb/s | 1.254 GB/s | ? |

| HBM3E (SK Hynix) | 10,0 Gb/s | 1.280 GB/s | 48 GB |

| HBM4 | ? | 1.500+ GB/s | 48 GB |

| HBM4E | ? | 2.000+ GB/s | 64 GB |

Den schnellsten HBM3-Speicher hat Micron damit inzwischen nicht mehr, denn Samsung hat bereits HBM3E mit 9,8 Gbit/s und SK Hynix stellte jüngst sogar 10 Gbit/s in Aussicht. Allerdings müssen diese Lösungen auch erst einmal die Serienfertigung erreichen.

Angeblich sparsamer als die Konkurrenz

Bei Microns HBM3E mit 9,2 Gbit/s ist dies nun geschehen. Der in den USA ansässige Speicherhersteller rühmt sich mit einer 30 Prozent geringeren Leistungsaufnahme als bei Lösungen der Konkurrenz, ohne diesen Vergleich jedoch näher aufzuschlüsseln. Der DRAM stammt aus der eigenen 1-Beta-Fertigung.

Nvidia wählt Micron für seine H200

Zumindest Nvidia hat Micron aber überzeugt, denn bereits im zweiten Quartal 2024 sollen die GPU-basierten Rechenbeschleuniger der H200-Serie mit Microns HBM3E ausgeliefert werden – H200 setzt auf 144 GB HBM3E pro GPU, wobei davon nur 141 GB aktiv sind.

Der Einsatz in Systemen mit KI-Anwendungen ist das Hauptziel und die Nachfrage nach solchen Lösungen wächst rasant – Nvidia vermeldet ein Rekordquartal nach dem nächsten. Dass Micron so spät überhaupt noch auf den HBM-Zug aufgesprungen ist, ist ein strategisch wichtiger Schritt für das Unternehmen.

Überraschend kommt dies aber nicht, denn Micron und Nvidia arbeiten schon seit vielen Jahren eng zusammen und so bietet Micron etwa seinen schnellen GPU-Speicher GDDR6X nur exklusiv für GeForce-Grafikkarten an. Noch hinzu kommt, dass der HBM3E von SK Hynix praktisch ausverkauft ist. Erst 2025 sollen wieder neue Bestellungen möglich sein, hieß es im Oktober.

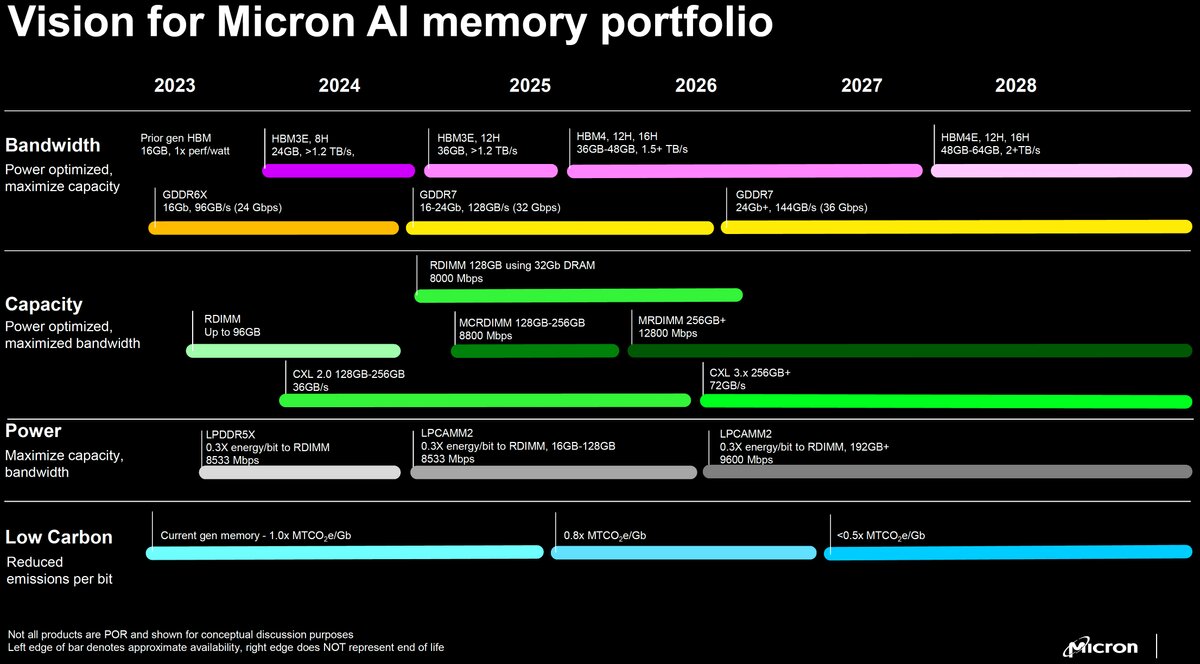

Schon im März soll HBM3E mit 36 GB folgen

Micron gibt Vollgas, denn schon ab März soll HBM3E mit 36 GB auf 12 Ebenen bemustert werden. Hier stellt das Unternehmen mehr als 1,2 TB/s und ebenfalls einen Vorsprung bei der Leistungsaufnahme in Aussicht. Auf der jüngsten Roadmap hat Micron auch schon HBM4 und HBM4E stehen.