Alone in the Dark im Test: Benchmarks (FHD, WQHD & UHD), Frametimes und VRAM

2/3Das Testsystem und die Benchmark-Szene

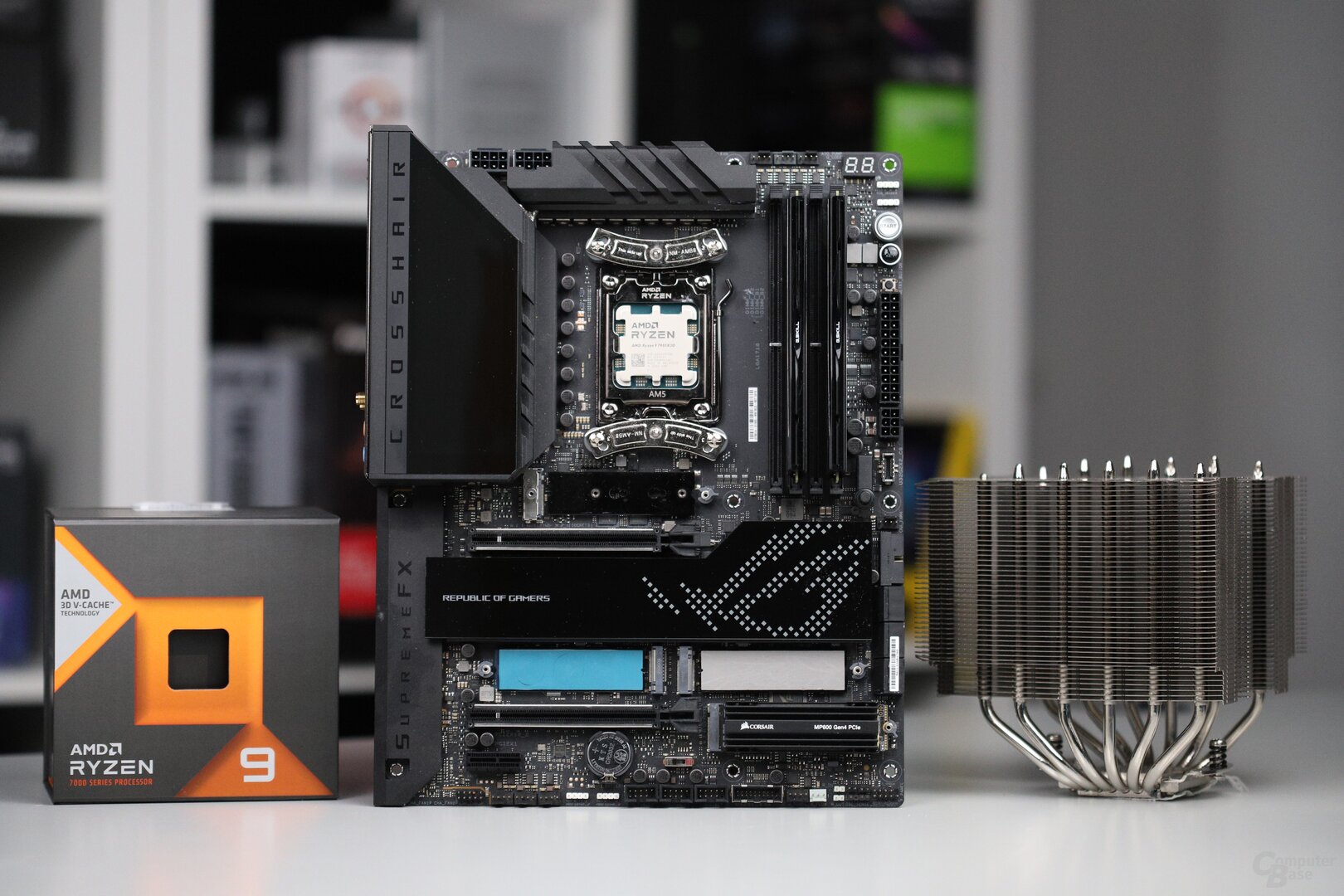

Alle Benchmarks wurden auf einem AMD Ryzen 9 7950X3D (Test) durchgeführt, der mit den Standardeinstellungen betrieben wurde. Als Mainboard war das Asus ROG Crosshair X670E Hero (BIOS 1415) verbaut.

Die CPU wurde von einem Noctua NH-D15S mit zentral installiertem 140-mm-Lüfter gekühlt. 48 GB Speicher (G.Skill TridentZ Neo, 2 × 24 GB, DDR5-6000, CL36-36-36-72) standen dem Prozessor zur Verfügung. Windows 11 23H2 mit sämtlichen Updates und aktiviertem HVCI war auf einer NVMe-M.2-SSD mit PCIe 4.0 installiert. Dasselbe galt für das Spiel. Resizable BAR wurde auf unterstützten Grafikkarten sowohl bei AMD als auch bei Nvidia und Intel verwendet.

| Treiberversion | Game Ready | |

|---|---|---|

| AMD Radeon | Adrenalin 24.2.1 | Nein |

| Nvidia GeForce | GeForce 551.76 | Nein |

| Intel Arc | 5333 | Nein |

Die 20 Sekunden lange Testsequenz findet im ersten Kapitel im Unterabschnitt „Das Französische Viertel“ statt. Der Marsch durch die Stadt zeigt die übliche Dunkelheit des Spiels gepaart mit der Darstellung von volumetrischem Nebel, der die Grafikkarte stark belastet. Darüber hinaus sind Häuser und Autos zu sehen. Es handelt sich nicht um ein Worst-Case-Szenario, meist läuft Alone in the Dark etwas schneller.

| Auflösung | Grafikdetails |

|---|---|

| 1.920 × 1.080 | Cineastisch-Preset |

| 2.560 × 1.440 | Cineastisch-Preset |

| 3.840 × 2.160 | Cineastisch-Preset, Episch-Preset (zusätzlich) |

Benchmarks in Full HD, WQHD und Ultra HD

Alone in the Dark ist ein sehr langsames und gemächliches Spiel, hohe Frameraten sind für ein gutes Spielgefühl also nicht notwendig – wenn auch hilfreich. Die 60-FPS-Marke muss in diesem Fall nicht unbedingt anvisiert werden, 50 FPS sind eigentlich ausreichend, um nur geringe Einschränkungen beim Spielerlebnis zu haben. Und diese Marke wird in einer geringen Auflösung wie Full HD schnell erreicht, sowohl die GeForce RTX 3060 als auch die Radeon RX 6650 XT und die Arc A770 haben damit kein Problem – die Nvidia-Grafikkarte überschreitet sogar die 60-FPS-Grenze.

In WQHD steigen die Anforderungen an, bleiben aber noch moderat. Die GeForce RTX 3060 Ti erreicht das Ziel knapp, die konkurrierende Radeon RX 6700 XT dagegen nicht. Im Hause AMD ist eine Radeon RX 6800 XT oder Radeon RX 7800 XT nötig.

Plötzlich richtig fordernd wird Alone in the Dark in Ultra HD, Renderpixel kosten in dem Spiel extrem viel Performance. Einzig die GeForce RTX 4080 Super und die Radeon RX 7900 XTX schaffen 50 FPS im Testfeld, 60 FPS würde es erst mit der hier nicht getesteten GeForce RTX 4090 geben.

Upsampling ist für Ultra HD also entscheidend und auf einer GeForce-Grafikkarte kann problemlos DLSS SR „Quality“ genutzt werden, das eine gute Bildqualität bietet, die von der nativen Auflösung nicht zu unterscheiden ist. Auf einer Radeon-Grafikkarte schaut man dagegen in die Röhre: FSR Super Resolution wird nur als qualitativ minderwertiges FSR 1 und das Unreal-Engine-eigene TSR gar nicht unterstützt. So etwas darf es heutzutage eigentlich nicht mehr geben. Auf Radeon-Grafikkarten müssen daher die Grafikdetails reduziert werden, mehr Informationen dazu weiter unten.

RDNA 3 ist klar schneller als RDNA 2

Während sich Nvidia-Grafikkarten verschiedener Generationen (Ampere und Ada Lovelace) so verhalten wie in anderen Spielen, gilt dies für AMD-Modelle nicht. Die neuere RDNA-3-Architektur ist in Alone in the Dark deutlich schneller als die ältere RDNA-2-Technik. So ist die Radeon RX 7800 XT für gewöhnlich nur 4 Prozent flotter als die Radeon RX 6800 XT, hier sind es aber plötzlich viel höhere 15 Prozent. Eventuell kann das Spiel die Dual-Issue-ALUs von RDNA 3 besser auslasten als andere Games, was den Unterschied erklären könnte. Die besseren Raytracing-Fähigkeiten können es nicht sein, denn Hardware-RT gibt es in Alone in the Dark nicht.

Intels Arc-Grafikkarten präsentieren sich in Alone in the Dark ziemlich unspektakulär. Die GeForce RTX 3060 Ti und die Radeon RX 6700 XT sind in Full HD weit entfernt. Auch von einer GeForce RTX 3060 wird die Intel-GPU geschlagen, einzig gegen die Radeon RX 6650 XT gibt es einen kleinen Sieg – allerdings nur bei den AVG-FPS, denn bei den Perzentil-FPS liegt Arc weit zurück, da das Framepacing schlechter als auf einer AMD- oder Nvidia-Grafikkarte ist. In WQHD kann die Arc A770 den Rückstand auf die Radeon RX 6700 XT und die GeForce RTX 3060 Ti um etwa 10 Prozentpunkte reduzieren, was zeigt, dass die GPU in Full HD die vorhandenen FP32-ALUs nicht schnell genug mit Daten versorgen kann – ein bekanntes Problem bei Arc.

Die RTX 4070 ist in Ultra HD merkwürdig langsam

Völlig überraschend sind die Benchmark-Ergebnisse der GeForce RTX 4070 in Ultra HD. Dort dümpelt die Grafikkarte mit nur 15 FPS herum, die Radeon RX 7800 XT ist mal eben mehr als doppelt so schnell, obwohl die GeForce die Radeon in Full HD und WQHD noch im Griff hat. Speichermangel ist hier ein denkbares Szenario, doch deutet nichts darauf hin. Denn laut Telemetrie benötigt das Spiel noch nicht mal 10 GB und die GeForce RTX 3080, die eben nur über 10 GB verfügt, hat dieses Problem nicht und rendert ebenso mehr als doppelt so schnell. Es ergibt keinen Sinn, dass die GeForce RTX 4070 in Ultra HD derart wegbricht. Dies passiert aber reproduzierbar. Vermutlich handelt es sich um einen Bug im Treiber oder Spiel.

Benchmarks in Ultra HD mit dem Episch-Preset

Auf einer Radeon-Grafikkarte bleibt einem in Alone in the Dark nur übrig, die Grafikdetails zu reduzieren, wenn die Performance nicht ausreicht – temporales Upsampling gibt es dort nicht. Mit dem Episch- anstelle des Cineastisch-Presets leidet die Grafik jedoch nur minimal, beim Spielen wird dies kaum bis gar nicht auffallen.

50 FPS werden dann in Ultra HD von mehreren Grafikkarten erreicht, bereits die GeForce RTX 4070 und auch die Radeon RX 7800 XT überschreiten diese Marke. Mit dem Episch-Preset wird der GeForce RTX 4070 also plötzlich wieder Leben eingehaucht, irgendetwas stimmt allerdings immer noch nicht. Denn die Grafikkarte ist in dem Szenario 8 Prozent langsamer als die Radeon RX 7800 XT, auch dann fehlt also immer noch Leistung.

An den Abständen zwischen den Grafikkarten ändert sich wenig. Die Radeon RX 7800 XT ist nach wie vor ein gutes Stück schneller als die Radeon RX 6800 XT, wenn auch nicht mehr ganz so performant wie mit dem Cineastisch-Preset. Die GeForce RTX 4080 Super kann ihren Vorsprung zur Radeon RX 7900 XTX ein klein wenig ausbauen, 10 statt 9 Prozent lautet nun das Plus. Generell gibt es aber keine größeren Verschiebungen zwischen den Presets.

Das Framepacing und kleinere Probleme

Alone in the Dark hat keine Probleme mit Shader-Kompilierungsrucklern, Traversal-Stottern gibt es aber schon. Der Vorteil in dem Game ist, dass es einen langsamen Spielablauf hat, spielerische Auswirkungen haben die Haker daher nicht. Doch trotz des langsamen Pacings und der dunklen Optik lassen sich die Ruckler beim Nachladen spüren und erkennen.

Genau dieses Nachladen findet auch während der Testsequenz statt und ist ab etwa Sekunde 17 im Frametime-Verlaufsdiagramm zu erkennen. Die ab diesem Zeitpunkt zu sehenden Frametime-Spikes entstehen nicht durch schlechtes Framepacing, sondern durch das Traversal-Nachladen.

Auf AMD Radeon läuft das Spiel etwas unrunder

Auf der GeForce RTX 4080 Super zeigt Alone in the Dark in Ultra HD ein sehr gutes Framepacing, es gibt eigentlich nichts zu kritisieren. Auf der Radeon RX 7900 XTX läuft das Spiel dagegen unrunder. Nicht generell, jedoch gibt es immer mal wieder auftretende, mittelgroße Schwankungen bei der Bildausgabe, die es so eigentlich nicht geben sollte.

Darüber hinaus ist erwähnenswert: Je höher die Framerate wird bzw. je größer die CPU-Last im Spiel ist, desto unrunder wird das Framepacing – völlig gleich, welche Grafikkarte im Rechner steckt. Das Verlaufsdiagramm zeigt daher den Idealzustand in Ultra HD, in WQHD und vor allem Full HD gibt es größere Probleme beim Framepacing.

Der Speicherverbrauch ist gering

Alone in the Dark ist ein sehr dunkles Spiel, detailreiche Texturen würden entsprechend wenig auffallen und gibt es in dem Spiel auch nicht. Der VRAM-Verbrauch ist daher gering, in Full HD und WQHD sind zum Beispiel bereits Grafikkarten mit 8 GB ausreichend. Erst in Ultra HD steigt der Bedarf ein Stück an, bleibt schlussendlich jedoch noch gering. 10 GB auf der GPU sollten genug für alle Lebenslagen sein.