AI-Benchmarks: Snapdragon X Elite vs. AMD Ryzen 8000 vs. Intel Core Ultra

Die neuen Windows-on-Arm-Notebooks mit Snapdragon X Elite (Test) sind die ersten PCs mit einer „Neural Processing Unit“ (NPU) zur AI-Beschleunigung von über 40 TOPS. Microsoft spendiert diesen Systemen das Copilot+-Siegel und exklusive AI-Zusatz-Features. ComputerBase hat die AI-Leistung gemessen – was gar nicht so einfach war.

AI-Benchmarks mit der UL Procyon und via Geekbench ML

Die Benchmarks wurden mit dem „AI Computer Vision Benchmark“ aus der Procyon Benchmark Suite von UL Solutions und via Geek Bench Machine Learning erstellt.

Bereits im April hatte ComputerBase im Procyon-Benchmark die AI-Leistung eines Core Ultra mit der eines Ryzen 8000 und der einer mobilen GeForce RTX verglichen. Jetzt kam der Snapdragon X Elite aus dem Asus VivoBook S 15 hinzu.

Neue Ergebnisse auf aktueller Basis

Alle Benchmark-Ergebnisse wurden für diesen neuen Vergleich neu erstellt, denn in der Tat hat sich inzwischen einiges getan. Nicht am Benchmark, aber alle damals verwendeten Produkte konnten höchstwahrscheinlich durch optimierte Software/Treiber inzwischen deutlich zulegen.

Gänzlich identisch war das Testfeld dabei nicht: Anstelle des damals verwendeten Intel Core Ultra 7 155H im Notebook kam der Core Ultra 7 165H aus dem Asus NUC 14 Pro (Test) mit höherer TDP zum Einsatz, da der Redaktion das Notebook nicht mehr vorlag.

Der AMD Ryzen 8000 Mobile war wiederum weiterhin durch den AMD Ryzen 9 8945HS im Razer Blade 14 (2024), optional mit Nvidia GeForce RTX 4070 Laptop GPU, vertreten. Windows 23H2 lag auf dem Asus NUC und auf dem Razer Blade in der aktuellsten Version vor, alle Treiber waren auf dem neuesten Stand. Auf dem Vivobook mit Snapdragon X Elite (X1E-78-100) kam hingegen bereits das für Arm-Systeme seit Dienstag, den 18. Juni verfügbare Windows 11 24H2 zum Einsatz.

Die nachfolgende Liste gibt Auskunft über die Leistung der jeweils verbauten NPU und die AI-Leistung gemessen in TOPS (INT8) des Gesamtsystems bestehend aus CPU, iGPU und NPU. Der Gesamtwert ist allerdings ein rein theoretischer, weil Anwendungen über die bekannten APUs immer nur gezielt eine Einheit ansprechen können.

- Intel Core Ultra 100 „Meteor Lake“: 11 TOPS (NPU), 34 TOPS (NPU+CPU+GPU)

- AMD Ryzen 8000 Mobile „Hawk Point“: 16 TOPS (NPU), 39 TOPS (NPU+CPU+GPU)

- Qualcomm Snapdragon X Elite/Plus: 45 TOPS (NPU), ? TOPS (NPU+CPU+GPU)

- Nvidia GeForce RTX 4070 Laptop GPU: 321 TOPS (GPU)

UL Procyon AI Computer Vision Benchmark

Der AI Computer Vision Benchmark der Procyon Suite kann Hardware auf verschiedene Wege mit den AI-Lasten adressieren. Neben Windows ML stehen Intels OpenVINO, Nvidias TensorRT (das auch die Tensor-Kerne anspricht und nicht wie Windows ML nur die ALUs der GPU) und Qualcomms SNPE für die NPU der Qualcomm-SoC zur Verfügung. Für AMD steht keine derartige Auswahl bereit.

Auf die Software kommt es an

Getestet wurde, was möglich ist. Mit dem Intel Core Ultra waren es Microsoft Windows ML und Intel OpenVINO, mit dem Ryzen 8000 lediglich Windows ML. Die NPU im Snapdragon X konnte wiederum über Qualcomm SNPE angesprochen werden, die Tensor-Kerne der mobilen GeForce über TensorRT, alternativ die Shader der GPU über Windows ML.

Die Ergebnisse im Überblick

Die Windows-ML-Ergebnisse sind mit Blick auf die Zukunft der NPU in Windows-PCs derzeit noch wenig hilfreich, denn die NPUs von Intel und AMD werden dabei noch gar nicht genutzt – für Intel gibt es eine Developer-Preview für den NPU-Support, für AMD noch gar keine Informationen. Beim Snapdragon verweigert wiederum der Benchmark die Arbeit, weil er Windows ML nur auf einer x86-Plattform verwenden will.

Mit der Leistung einer NPU haben damit alle Windows-ML-Testergebnisse nichts zu tun. In Windows ML zeigt sich allerdings, wie viel Leistung die GeForce RTX von Nvidia bereitstellt, wenn sie über Windows ML als klassische GPU angesprochen wird – und wie es sich bei Intel Core Ultra und AMD Ryzen 8000 zwischen CPU und iGPU verhält. Es gilt: AMD liegt jeweils vor Intel und die GeForce ist knapp viermal so schnell wie AMDs Radeon 780M. Effizient ist die Nutzung von Windows ML am Ende nicht.

| Benchmark | API | Intel Core Ultra 7 165H Arc Graphics (iGPU) Asus NUC 14 Pro |

AMD Ryzen 9 8845HS Radeon 780M (iGPU) Razer Blade 14 |

AMD Ryzen 9 8845HS RTX 4070 Laptop Razer Blade 14 |

Snapdragon Elite X Asus Vivobook S 15 |

|

|---|---|---|---|---|---|---|

| UL Procyon AI Computer Vision |

Windows ML | NPU | NPU noch nicht unterstützt | Benchmark nur auf x86 | ||

| CPU | 131 | 176 | – | – | ||

| GPU | 85 | 90 | 354 | – | ||

| Intel OpenVINO | NPU | 358 | – | – | – | |

| CPU | 233 | – | – | – | ||

| GPU | 600 | – | – | – | ||

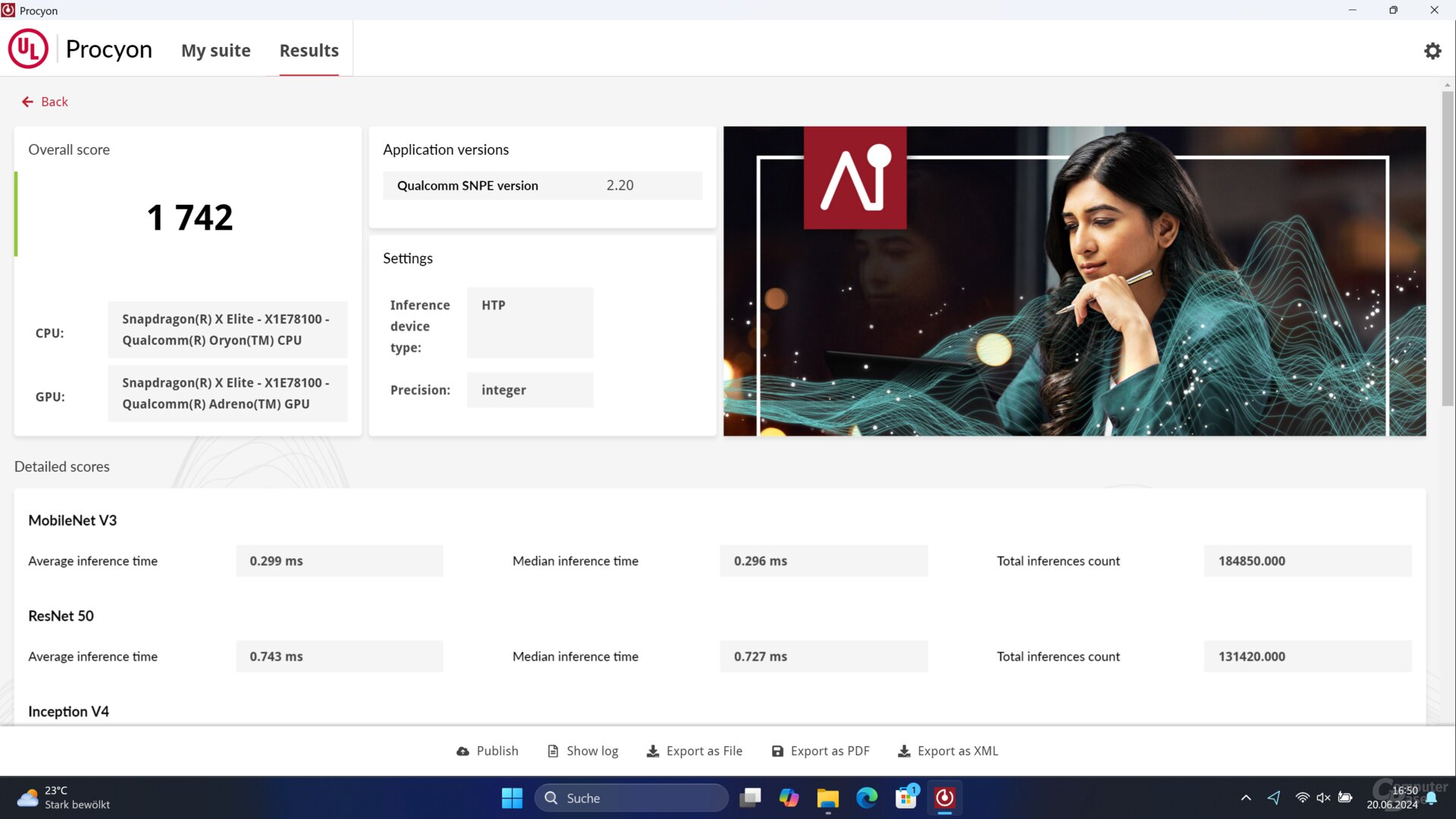

| Qualcomm SNPE | NPU | – | – | – | 1.742 | |

| Nvidia TensorRT | Tensor Cores | – | – | 2.473 | – | |

| Benchmark: UL Solutions Procyon Suite, AI Computer Vision, Datenformat „Integer“ | ||||||

Wird der Intel Core Ultra über OpenVINO adressiert, steigt die Leistung deutlich. Am schnellsten ist die Xe-iGPU, was interessanterweise vor zwei Monaten mit dem Core Ultra 7 155H noch nicht der Fall gewesen ist – der NPU-Score ist deutlich gefallen.

Viel mehr Leistung liefert wiederum die Ausführung des Benchmarks auf der NPU von Qualcomm. Die 45 zu 11 TOPS des Snapdragon X im Vergleich zum Intel Meteor Lake finden sich hier sogar überdeutlich wieder. Am schnellsten ist die GeForce RTX 4070 Laptop GPU (+41 Prozent), wenn ihre Tensor-Kerne genutzt werden. Dafür benötigt sie jedoch auch deutlich mehr elektrische Leistung. Welchen Vorteil entsprechende AI-Anwendungen aus einer NPU ziehen können, wird an dieser Stelle klar.

Geek Bench ML Benchmark

Am Geek Bench ML zeigt sich die aktuelle „NPU-Baustelle“ noch deutlicher. Der Benchmark kann auf keiner der Plattformen die NPU respektive die Tensor-Kerne ansprechen – weder über die Frameworks der Hersteller noch über Windows ML. Der Machine-Learning-Benchmark misst damit zwar die Leistung der CPUs und (i)GPUs in den AI-Szenarien, nicht aber die der NPUs.

Fazit

Die Leistung der in Prozessoren von AMD, Intel und Qualcomm inzwischen integrierten NPUs zu messen, fällt derzeit noch gar nicht so leicht, weil Windows oder Benchmarks diese AI-Beschleuniger-Einheiten oftmals noch gar nicht nutzen können.

DIe NPU hilft nur, wenn sie auch verwendet wird

Selbst unter Windows 11 on Arm 24H2, das für die Copilot+-Features die NPU des Snapdragon X nutzt, will Geek Bench ML nur auf der CPU und auf der iGPU des SoC laufen. In Ermangelung einer Windows-ML-Integration der NPUs von AMD und Intel in Windows 11 23H2 läuft auch die Procyon Benchmark Suite in diesem Framework ins Leere. Wie sehr AI-Anwendungen von einer (starken) NPU profitieren können, zeigt der AI Computer Vision Benchmark der UL Solutions Procyon Suite.

Dass es dauern wird, bis Anwendungen die NPU respektive verschiedene NPUs auch wirklich nutzen können werden, ist dabei keine Überraschung: Bis heute ist die Möglichkeit, Lasten, die sich dafür anbieten, auf einer GPU auszuführen, nicht in jeder Software verankert oder nicht mit jeder Hardware verfügbar. Der vormals kleinste gemeinsame Nenner, OpenCL, ist dabei heute kaum noch von Relevanz. Zu stark ist die viel mächtigere Nvidia-Cuda-Plattform, die wiederum GPUs der Konkurrenz außen vor lässt.

Intel Lunar Lake und AMD Ryzen AI 300 folgen

Ab Juli folgen dem Snapdragon X die neuen Strix-Point-APUs von AMD der Serie Ryzen AI 300 mit 50 TOPS starker NPU. Fürs 3. Quartal steht Intel Lunar Lake alias Intel Core Ultra 200V mit 48-TOPS-NPU auf der Agenda.

Diese Plattformen werden wie Snapdragon X Elite und Snapdragon X Plus ebenfalls das Copilot+-Siegel tragen und neben dem Copilot (inzwischen eine Windows-App) auch die lokal ausgeführten Copilot+-Funktionen erhalten – allerdings erst dann, wenn Windows 24H2 für x86-Systeme fertig ist, was im 2. Halbjahr der Fall sein soll. Ryzen AI 300 wird demzufolge zweifelsfrei zum Start noch keine Copilot+-Funktionen aufweisen. Bei Intel Core Ultra 200V wird es davon abhängen, wie sich Windows und die CPUs terminlich eintakten. Ob Windows 24H2 dann auch generell Windows-ML-Support für die NPUs der Plattformen mit sich bringt, bleibt abzuwarten. Wie schnell es dann wäre, ebenfalls.

Copilot (Cloud) vs. Copilot+ (lokal)

Zum Abschluss noch einmal ein Überblick zum Copilot+. In einem Copilot+-PC kommen exklusiv die Features Recall, das jedoch von Microsoft verschoben wurde, sowie Cocreator, Studio Effects, Echtzeit-Untertitel und Auto SR hinzu. Sie alle werden vollständig lokal ausgeführt, während der Copilot auf Chat-GPT-Basis ein Cloud-Feature ist.

- Recall (verschoben)

- Cocreator

- Studio Effects

- Echtzeit-Untertitel

- Auto SR

Dieser Artikel war interessant, hilfreich oder beides? Die Redaktion freut sich über jede Unterstützung durch ComputerBase Pro und deaktivierte Werbeblocker. Mehr zum Thema Anzeigen auf ComputerBase.