Im Zeitalter von AI und Hyperscalern: Welche Probleme Deutschland beim Bau von Rechenzentren hat

„Bigger is better“ lautet die Formel für die Rechenzentren-Entwicklung in den USA, die die Grundlagen für die KI-Entwicklung in den nächsten Jahren schaffen soll. Deutschland hinkt bei den Hyperscalern hinterher, es mangelt an Platz, Strom, Geld – und Interesse. Es gibt aber vielversprechende Entwicklungen.

Infrastruktur als Voraussetzung für AI-Entwicklung

Gigantomanisch sind die AI-Infrastrukturprojekte in den USA, dreistellige Milliarden-Beträge wollen Unternehmen und Staaten in Rechenzentren und Supercomputer investieren. Tech-Konzerne wie Microsoft, OpenAI, Meta und Google wollen so die Grundlage schaffen, um die KI-Modelle der Zukunft zu entwickeln. Was aber interessant ist: Von dieser Diskussion überträgt sich kaum etwas auf Deutschland. Intels (mittlerweile verschobene) Chipfabrik in Magdeburg ist als Großprojekt relevant, über Chipfabriken hinaus ist es still.

Infrastructure is destiny when it comes to AI.

(...)

If we want a more democratic world, history tells us our only choice is to develop an AI strategy that will help create it, and that the nations and technologists who have a lead have a responsibility to make that choice — now.

Sam Altman

Rechenzentren-Power als geopolitische Komponente, wie es OpenAI-Chef Sam Altman in einem Beitrag für die Washington Post beschreibt, wird so nicht diskutiert. Ohnehin ist es ein gravierender Unterschied. Denn Befürworter der Ausbaupläne wie Altman sprechen im Kontext von AI nicht nur von Software und Produkten. Sie heben die KI-Entwicklung auf eine geopolitische Stufe, der Westen müsse Fortschritte machen, um etwa im Wettstreit mit autoritären Staaten mithalten zu können. KI ist die Zukunftstechnologie, womöglich bedeutender als das Internet.

- Projekt „Stargate“: Microsoft und OpenAI planen Supercomputer für 100 Mrd. Dollar

- AI-Wettrüsten: Google will über 100 Mrd. USD für Rechenzentren ausgeben

- Zweistellige Milliarden-Beträge: OpenAI-Chef plant Mega-Rechenzentren für KI-Entwicklung

- Rechenzentren-Betreiber: Nachfrage nach Cloud-Computing für AI ist „absurd“

Ob aus geopolitischen Überlegungen oder schlicht Gewinnstreben, in den USA setzen sich enorme Investitionen und Bauvorhaben in Gang. Rechenzentren-Kapazitäten könnten in den nächsten Jahren also ein Thema werden, wie es die Chip-Fabriken spätestens seit der Corona-Pandemie sind. Bei KI allgemein ist man in Deutschland zumindest in Sonntagsreden ambitioniert, Vertreter der Bundesregierung wie Digitalminister Volker Wissing erklärten auf dem Digitalgipfel 2024: „Wir wollen Deutschland zum führenden KI-Land in Europa machen.“ Doch im Alltag ist davon vergleichsweise wenig zu erkennen, es besteht Nachholbedarf. Interessant ist daher, wo konkret die Probleme liegen – und welche Chancen sich durch die AI-Entwicklung für Rechenzentren in Deutschland bieten.

Blackwell erhöht Anforderungen an Hyperscaler-Rechenzentren

Was sich mit der KI-Entwicklung bereits ändert, sind die Anforderungen an Rechenzentren. Das gilt allein schon für den Betrieb der generativen KI-Systeme, so soll etwa eine ChatGPT-Anfrage um das 24-fache bis 236-fache mehr Energie verbrauchen als eine Google-Suche. Die Inferenz – also das Berechnen der Nutzer-Eingaben, um eine Antwort zu generieren – ist aufwändig. Noch extremer wird es, wenn neue KI-Modelle mit Top-Hardware trainiert werden. Metas kommendes Llama-4-Modell wird auf Clustern trainiert, in denen mehr als 100.000 Nvidia H100-GPUs verbaut sind.

Nvidias Blackwell-Chips verschärfen die Anforderungen nochmals. Wie SemiAnalysis in einem Report beschreibt, soll die GB200-Familie im Vergleich zu den H100-Chips zwar eine 9-fache Leistung bei der Inferenz und eine 3-fache Leistung beim Training liefern, benötigt dafür aber eine leistungsfähigere Flüssigkeitskühlung, um das volle Potenzial abrufen zu können.

This all changes with the upcoming Blackwell ramp. Nvidia’s GB200 family requires direct to chip liquid cooling and has up to 130kW rack power density delivering ~9x inference and ~3x training performance improvements over the H100. Any datacenter that is unwilling or unable to deliver on higher density liquid cooling will miss out on the tremendous performance TCO improvements for its customers and will be left behind in the Generative AI arm’s race.

SemiAnalysis

Mit der neuen GPU-Generation ändern sich also auch die Vorgaben für das Design von Rechenzentren. Konsequenzen hat das bereits für den Bau: Laut SemiAnalysis hatte Meta Anfang 2023 ein Rechenzentrum mit einem alten Design fast schon fertiggestellt. Weil es aber den Anforderungen der aktuellen Hardware-Generation nicht entspricht, wurde es wieder abgerissen und neu aufgebaut. Das ursprüngliche System war veraltet, bevor es in Betrieb ging.

Stromversorgung ganzer Landstriche kommt ans Limit

Was dieser Maßstab verrät: Ist in den USA von einem Ausbau der AI-Infrastruktur die Rede ist, geht es vor allem um Hyperscaler. Gemeint sind damit besonders große Cloud-Anbieter, die laut einer IDC-Definition mindestens 5.000 Server auf mindestens 930 Quadratmeter einsetzen. Zu den klassischen Hyperscalern zählen vor allem die Big-Tech-Konzerne. Es sind also allen voran die üblichen Verdächtigen wie Amazon mit AWS, Microsoft mit Azure, Google sowie IBM und Oracle, die Dienste anbieten, die insbesondere bei der KI- und Machine-Learning-Entwicklung im Mittelpunkt stehen.

Selbst in den USA stößt der Ausbau aber an Grenzen, denn solche Rechenzentren benötigen Platz und vor allem Energie. Der Norden des Bundesstaats Virginia zählt ohnehin zu den führenden Standorten für Rechenzentren und es laufen weitere Bauvorhaben, Amazon will drei weitere Rechenzentren errichten. Doch selbst dort gehen die Ausbaupläne so weit, dass Landstriche sich komplett wandeln und die lokalen Stromnetze an ihre Grenzen kommen, wie Bloomberg berichtet. Virginia zählt daher auch zu den Orten, in denen Amazon auf Atomkraft als Energiequelle setzt.

Was bei all dem KI-Hype aber nicht unter den Tisch fallen darf: Hyperscale-Cloud-Computing ist nicht alles. Der Rechenzentren-Markt ist sehr heterogen, es gibt sehr unterschiedliche Geschäftsmodelle, für die Angebote machen lassen. Wer sich für Definitionen und Abgrenzungen von Rechenzentren-Typen interessiert: Heise bespricht dieses Thema in einer Ausgabe des Bitrauschen-Podcasts.

Deutschland und Europa hinken hinterher

Allein die Vorgänge in Virginia zeigen bereits den Unterschied zu Europa. Wie Heise berichtet, entstehen allein in dieser Region im Jahr 2024 neue Server-Kapazitäten von knapp 400 MW. Das entspricht laut dem CBRE einem Plus der fünf größten Standorte in Europa, Frankfurt soll in diesem Jahr bei den Server-Kapazitäten um rund 130 MW zulegen.

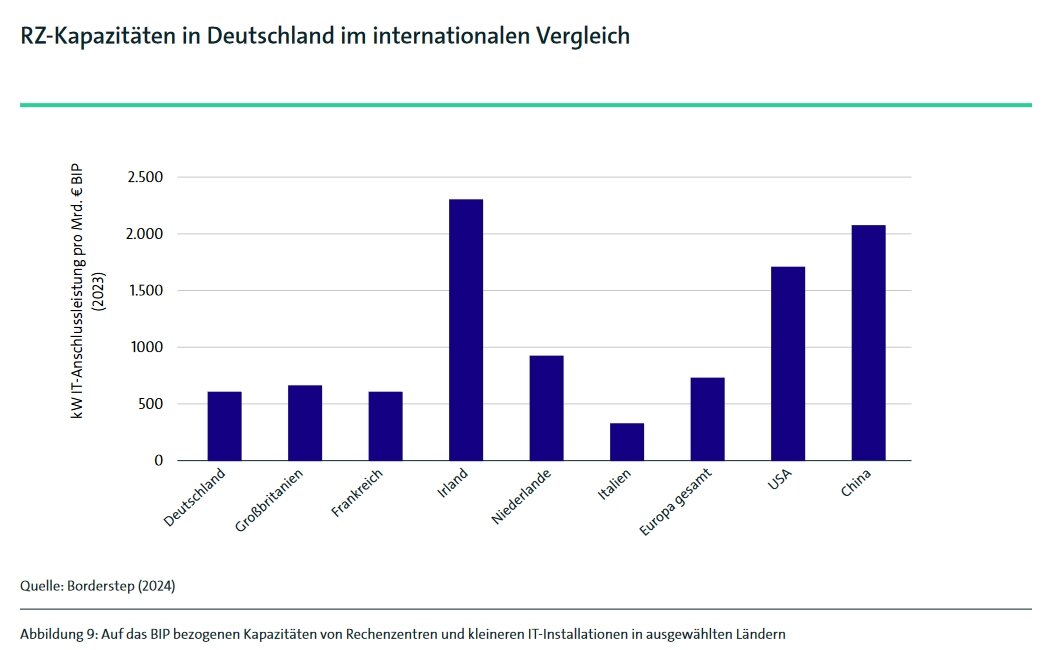

Deutschland und Europa haben Nachholbedarf, lautet daher auch das Fazit in einer aktuellen Rechenzentren-Studie des IT-Branchenverbands Bitkom. Grundlage für diese Analyse ist die IT-Anschlussleistung, die die maximale Leistungsaufnahme aller in Rechenzentren betriebenen IT-Geräte beschreibt – diese umfasst also Server, Speicher und Netzwerktechnik. Nimmt man auf Länderebene die absolute Leistung (gemessen in Gigawatt) als Maßstab, sind die USA im Jahr 2024 mit einer Gesamtleistung von 48 GW weltweit führend. Dahinter folgt China mit 38 GW, Europa kommt auf 16 GW – und Deutschland auf 2,7 GW. Interessanter ist indes, wenn man die Leistung ins Verhältnis zum Bruttoinlandsprodukt setzt. China liegt dann mit 2.100 Kilowatt pro Milliarde Euro vor den USA mit 1.700 Kilowatt/Milliarde Euro. Deutschland hängt immer noch hinter her, mit einem Wert von 610 KW/Milliarde Euro fällt der Rückstand aber weniger deutlich aus.

| USA | China | Europa | Deutschland | |

|---|---|---|---|---|

| Leistung 2024 | 48 | 38 | 16 | 2,7 |

| Prognose 2030 | 95 | 64 | 28 | 4,8 |

| KW/Mrd. EUR BIP | 1.700 | 2.100 | 720 | 610 |

| IT-Anschlussleitung in Gigawatt (GW) Quelle: Bitkom-Studie Rechenzentren in Deutschland: Aktuelle Marktentwicklungen 2024 |

||||

Damit liegt man aber noch unter dem europäischen Durchschnitt und hinter Ländern wie Großbritannien (670) und die Niederlande (900). Den Spitzenplatz in Europa nimmt Irland ein (2.310). Aufgrund der großen Anzahl an (Big-)Tech-Unternehmen, die dort ansässig sind, ist Irland aber eher vergleichbar mit amerikanischen Rechenzentren-Regionen wie Virginia.

Rechenzentren-Kapazitäten sind so gemessen zunächst eine abstrakte Größe. Wie diese sich jedoch in der Praxis auswirken, hat der Internetwirtschaftsverband Eco in einer Spillover-Effekt-Studie untersucht. Das Ergebnis: Die Wirtschaft wird immer abhängiger. Laut der Studie sind 2024 rund 5,9 Millionen Erwerbstätige in Deutschland in Unternehmen tätig, deren Geschäftsmodell ohne Cloud nicht möglich wäre. Vor zwei Jahren lag dieser Wert noch bei 2,8 Millionen Erwerbstätige. Diese Tendenz lässt sich auch in den Bitkom-Zahlen erkennen. Demnach haben sich die Kapazitäten von Cloud-Rechenzentren in den vergangenen fünf Jahren praktisch verdoppelt: von 630 MW in 2019 auf 1.240 MW in 2024. Aktuell machen Cloud-Rechenzentren 45 Prozent des Marktes aus, 2019 waren es noch 29 Prozent.

AI-Entwicklung befeuert die Cloud-Nachfrage

Während die Nachfrage nach Cloud-Diensten also ohnehin steigt, erhöht das KI-Wettrennen diese nochmals exponentiell. Um ein Gespür für die Größenordnung zu bekommen: 2022 lag der Energieverbrauch für AI laut den Zahlen der Internationale Energieagentur (IEA) bei 460 Terawattstunden (TWh), bis 2026 soll dieser auf 1.000 TWh ansteigen (via FAZ).

Investitionen sind nötig. „Wir werden extrem viel mehr Kapazitäten brauchen“, sagt daher auch Kai Wawrzinek, Gründer und CEO von dem deutschen Start-up Impossible Cloud, im Gespräch mit ComputerBase. Das gelte sowohl für den Computing- als auch den Storage-Bereich – denn im KI-Zeitalter wird auch deutlich mehr Speicherplatz benötigt. Wawrzinek: „Wenn man früher im Krankenhaus die Röntgenaufnahme eines Patienten hatte, wurde diese irgendwann nach dem Tod entsorgt. Heutzutage ist es so, dass man mit solchen Aufnahmen noch Jahre später ein AI-Modell trainieren kann.“ Es lohnt sich künftig also, möglichst viele Daten langfristig zu behalten.

In Frankfurt nur noch 4 Prozent an freien Server-Kapazitäten

Wie die CBRE-Studie verdeutlicht, hinkt das Angebot in Europa und insbesondere Deutschland aber schon heute hinterher. Frankfurt erhält dieses Jahr zwar 130 MW an Server-Kapazitäten, die Leerstandskapazitäten sinken aber trotzdem auf unter 4 Prozent – 2017 lag die Quote (damals ein Höchststand) bei 25 Prozent. Neue Rechenzentren müssten also entstehen. Würde man aber Pläne in einem Ausmaß umsetzen, die vergleichbar mit den Projekten in den USA sind, wäre in Frankfurt die komplette Innenstadt belegt, so Wawrzinek. Und das gelte nur für die Fläche, die Energiefrage ist nochmals eine weitere Baustelle.

Weil das Stromnetz in der Rhein-Main-Region an Grenzen kommt, sei es mittlerweile schwierig, dort Ausbauprojekte zu realisieren. Bitkom-Mitarbeiter Kilian Wagner sagt dem RedaktionsNetzwerk Deutschland (RND): „Wer dort ein größeres Rechenzentrum bauen möchte, muss mindestens bis 2030 warten“. Perspektivisch könnten die norddeutschen Bundesländer als Standorte in Frage kommen, heißt es in der Studie. Aufgrund der erneuerbaren Energiequellen wie Windkraft sind diese Regionen attraktiv. Großprojekte wurden dort aber noch nicht umgesetzt.

Profitieren könnten noch weitere Standorte. Jens-Peter Feidner, Geschäftsführer für das Deutschland-Geschäft des Rechenzentren-Betreibers Equinix, nennt noch Berlin, München und künftig eventuell auch das Rheinische Revier als Orte, die Potenzial haben. Hindernisse sieht aber auch er. „Ein hohes Maß an Bürokratie, dadurch gestiegene Kosten (Zeitaufwand, Baudauer, Technikkosten) und im weltweiten Vergleich hohe Energiekosten haben einen nicht außer Acht zu lassenden Einfluss auf Investitionen“, so Jens-Peter Feidner.

Platz, Strom, Bürokratie und am Ende auch Geld – Baustellen gibt es, Unterstützung aus der Politk wird gefordert. So lauten etwa die politischen Empfehlungen in der Spillover-Effekt-Studie des Eco, neue Gewerbe- und Industrieflächen auszuweisen, Investitionen zu erleichtern und dezentrale Strukturen zu stärken. Diese würden eher zur mittelständischen Wirtschaft passen.

Wenn Großvorhaben lanciert werden, sind es allerdings eher die Big-Tech-Konzerne, die im Mittelpunkt stehen. 13 Milliarden Euro wollen Microsoft, Amazon und Google laut der Eco-Studie in den nächsten Jahren investieren. Allein 3,2 Milliarden Euro lässt sich Microsoft die neuen Rechenzentren im Rheinischen Revier kosten, die die Grundlage für ein KI-Ökosystem in der Region sein sollen. Amazon plant derweil Projekte in Brandenburg.

Auch außerhalb der Big-Tech-Welt ist aber Bewegung im Markt. Interessant ist ein Blick in die Start-up-Landschaft.

StackIT – Lidl geht den AWS-Weg

Wenn es im deutschen Cloud-Geschäft jemanden gab, der in den letzten Jahren über die Fachpresse hinaus medial für Aufsehen sorgte, war es StackIT. Das Bemerkenswerte an dem Anbieter: Es handelt sich um die Cloud-Sparte der Schwarz Gruppe, man betreibt also die digitale Infrastruktur für den Lidl-Konzern – und bietet darüber hinaus noch zusätzliche Cloud-Dienste an. Mit diesem Geschäftsmodell geht die Schwarz Gruppe den Amazon-Weg: Infrastruktur für das eigene Handelsgeschäft aufbauen und die überschüssigen Kapazitäten auf dem Markt anbieten.

Wie Lidl das Handelsgeschäft digitalisiert, schildert der YouTube-Kanal Was kostet die Welt in einem Video. Relevant bei der Cloud-Sparte ist, dass Datensouveränität den Ausschlag für eine Entwicklung gab, die im Jahr 2018 startete. Man will unabhängig von den Big-Tech-Anbietern sein, sensible Daten sollen über die eigenen Server laufen. Und Datensouveränität ist auch für den Datenschutz relevant. Inwieweit die Big-Tech-Dienste mit der DSGVO vereinbar sind, ist vor allem bei sensiblen Daten immer wieder ein Streitpunkt.

Harter Konkurrenzkampf mit Microsoft und Co.

Microsoft hatte deswegen bereits kurz nach den NSA-Enthüllungen im Jahr 2013 eine Deutschland-Cloud angekündigt. Der Clou bei diesem Vorstoß: Microsoft stellte zwar die Infrastruktur, T-Systems sollte aber als Datentreuhänder fungieren, um den Zugang zu kontrollieren. So wollte man sicherstellen, dass US-Behörden nicht auf Daten zugreifen können, selbst wenn es rechtlich so vorgeschrieben ist. Das Modell scheiterte in der Praxis, gemeinsam mit SAP wagt Microsoft aktuell aber einen neuen Anlauf. Die SAP-Tochter Delos soll Microsofts Azure-Dienste und Office-Lösungen in eigenen Rechenzentren und mit eigenem Lizenzierungsverfahren betreiben. Ein deutsches Unternehmen kontrolliert also nicht nur den Zugang, sondern das komplette System. Losgehen soll es ab dem kommenden Jahr.

Die Schwarz Gruppe nutzt den Datenschutz ebenfalls als Verkaufsargument, deutsche Unternehmen und Verwaltungen sind der potenzielle Kundenkreis. So bietet StackIT sowohl Cloud- als auch Colocation-Lösungen, die auf Rechenzentren laufen, die allesamt in Deutschland und Österreich stehen. Bei Cloud-Diensten bleibt man dabei nicht stehen. Durch die Übernahme des israelischen Unternehmens XM Cyber ist man auch im Bereich Cyber-Sicherheit vertreten, zudem investiert man in das deutsche KI-Start-up Aleph Alpha. Das eröffnet eine Zweigstelle im Heilbronner KI-Campus Ipai, der maßgeblich von der Schwarz Gruppe aufgebaut wird.

Umtriebigkeit ist das Schlagwort, mit dem sich die digitalen Aktivitäten des Lidl-Konzerns zusammenfassen lassen. Geld verdient man aber auch schon. Erst 2023 wurde Schwarz Digits als Geschäftssparte gegründet, der Umsatz belief sich im letzten Jahr auf 1,9 Milliarden Euro. Noch ist das Digitalgeschäft also ein Nischen-Business für den Handelskonzern, der 2023 insgesamt auf 167,5 Milliarden US-Dollar Umsatz kam. Doch es ist ein Wachstumsmarkt, der hohe Profitmargen verspricht.

Impossible Cloud – Airbnb für Rechenzentren

Während StackIT von den Ressourcen der Schwarz Gruppe profitiert, ist es für deutsche Unternehmen generell schwierig, mit den Big-Tech-Angeboten zu konkurrieren. „Als Start-up kann man da normalerweise nicht mithalten. Genauso wenig können da aber auch die größten deutschen und europäischen Anbieter mithalten“, sagt Kai Wawrzinek im Gespräch mit ComputerBase. Sein Cloud-Start-up Impossible Cloud wählt daher einen anderen Ansatz. Die Idee ist nicht, selbst massive Rechenleistung zur Verfügung zu stellen, sondern vorhandene Kapazitäten zu verwenden.

„Es gibt weltweit Tausende Rechenzentren, die einen hervorragenden Job machen“, so Wawrzinek. Und diese Zahl umfasse noch nicht einmal die On-Premise-Rechenzentren, die Firmen selbst betreiben. So eine Struktur hat aber Konsequenzen. „Diese siloartige Betreiberart führt dazu, dass Ressourcen nicht effizient genutzt werden“, sagt Wawrzinek. Das Ziel von Impossible Cloud ist nun, bestehende Infrastruktur zu nutzen, die derzeit nicht verwendet wird. Praktisch will man also eine Art Airbnb für Rechenzentren betreiben.

Mit dem 2021 gegründet Start-up versucht Wawrzinek, eine europäische Alternative zu den Big-Tech-Anbietern zu schaffen. Neu ist er nicht im Server-Geschäft, er zählte zu dem Gründer-Team des Hamburger Mobile-Spieleentwicklers Goodgame und leitete das Unternehmen bis 2015 gemeinsam mit seinem Bruder. Skalierende Infrastruktur war damals schon ein Thema, nun will man die Erfahrungen aus dem Gaming-Bereich in das Cloud-Geschäft übertragen – und die Lücken im Markt nutzen. „Nach dem was wir wissen, hat man im Compute-Bereich freie Kapazitäten von 60, 70, 80 Prozent. Im Storage-Bereich ist es bisschen weniger, aber im Prinzip ist es viel, was nicht genutzt wird“, so Wawrzinek. Zahlen im Compute-Bereich wären jedoch deutlich schwieriger zu bekommen als die im Storage-Bereich.

Gespräche hat man bereits mit rund 200 Rechenzentren-Betreibern geführt, derzeit befinde sich das 2023 gegründete Start-up auf einem guten Weg. Technisch nutzt man Web3-Technologie, im Hintergrund läuft also tatsächlich eine Blockchain. Über die laufen aber Protokolle, die etwa regeln, wie Teilnehmer am Netzwerk teilnehmen (Details dazu bietet ein Whitepaper (PDF)). „Daten werden nicht auf der Blockchain gespeichert, das wäre wirtschaftlich völlig ineffizient“, so Wawrzinek. Nutzer sollen davon ohnehin nicht viel mitbekommen, für Kunden soll der Umstieg so einfach wie möglich sein. Kleine Änderungen im Code sollen ausreichen, um etwa den Wechsel von AWS zu vollziehen.

Rechenzentren-Kapazitäten ohne Atomkraft?

Im Hintergrund würde die dezentrale Netzwerk-Architektur aber Vorteile bieten. Vor allem, weil sich mit so einem Ansatz eine Größenordnung erreichen lässt, die bei den Hyperscalern nicht möglich ist. Das Bitcoin-Netzwerk zählt zu den größten der Welt. Und zudem bieten diese Strukturen auch Lösungen für Probleme, mit denen die Hyperscale-Betreiber derzeit kämpfen. Ein wesentliches ist die Energiefrage. Nicht nur in Virginia und der Rhein-Main-Region kommt die Strominfrastruktur ans Limit, anderswo ist die Lage ähnlich. Praktisch alle Big-Tech-Konzerne setzen daher auf Atomkraft. Microsoft reaktiviert das bereits stillgelegte AKW Three Miles, Google will Mini-Reaktoren nutzen, Amazon ist ebenfalls mit an Bord.

- Gigantischer Energiebedarf: Microsoft holt stillgelegtes AKW für AI wieder ans Netz

- Stromverbrauch durch AI: Google sichert sich Atomstrom aus „einer Flotte“ Mini-AKW

- Amazon goes nuclear: Das nächste Big-Tech-Unternehmen setzt auf neue AKW

- KI-Blase vor dem Platzen?: Warum Big Tech weiter Milliarden in die KI-Infrastruktur investiert

- CB-Funk-Podcast #85: AI verschlingt Milliarden und lässt AKW auferstehen

Meta musste laut einem Financial-Times-Bericht zuletzt einen Rückschritt bei den eigenen Atomkraft-Plänen hinnehmen, doch auch hier ist die Strategie klar. Präzise dargestellt hat sie Metas KI-Chefwissenschaftler Yann LeCun in einem X-Beitrag: AI-Rechenzentren würden demnach in der Nähe von Energieerzeugern entstehen, die Strom kontinuierlich im Gigawatt-Bereich zu geringen Kosten und mit niedrigen Emissionen produzieren. So könnte man auf eine teure Infrastruktur verzichten, die den Strom über lange Strecken hinweg transportiert. Das sind die Bedingungen, die Atomkraft einen Vorteil gegenüber den Erneuerbaren verschaffen. Solar- und Windenergie, so LeCun, würden viel Platz benötigen und zudem seien massive Speichersysteme erforderlich, weil diese nicht dauerhaft in derselben Menge Strom erzeugen.

Eine Reaktivierung von Atomkraftwerken scheint für Deutschland wenig plausibel, Strompreise sind ebenfalls vergleichsweise hoch. Rein von den Rahmenbedingungen her erscheint es also naheliegend, einen anderen Ansatz zu wählen. Die Frage, die sich aber für Start-ups wie Impossible Cloud oder StackIT stellt: Warum sollten Kunden wechseln? Datenschutz nennt auch Impossible Cloud als Vorteil. Mittels Geofencing-Verfahren könnten Kunden auch bei einem dezentralen System auswählen, ob Daten etwa in der EU oder ausschließlich in Deutschland gespeichert werden sollen. Je strikter die Bedingungen, desto höher die Kosten – die Wahl ist aber möglich. Zudem soll es keine Lock-in-Effekte wie bei AWS oder Azure geben, langfristig verspricht das Start-up also auch geringere Kosten.

Wo die Chancen für den deutschen Markt liegen ... und wo die Risiken

Schwer wird der Konkurrenzkampf mit den Big-Tech-Anbietern dennoch. Vor allem der AI-Bereich fokussiert sich bislang auf die USA. Damit das Pariser KI-Start-up seine Modelle trainieren konnte, war eine Kooperation mit Microsoft erforderlich. Kein Anbieter in Europa könne Mistral ausreichend Rechenpower bereitstellen, sagte der Gründer und CEO Arthur Mensch im Mai im Gespräch mit dem Spiegel.

Selbst beim AI-Computing gibt es aber Möglichkeiten. „Die großen Sprachmodelle werden (aufgrund der benötigten Rechenpower) sicherlich vorrangig dort gerechnet, wo die Rechenpower in der geforderten Größe und auch zu bezahlbaren Energiepreisen zur Verfügung steht“, teilt der Internetwirtschaftsverband Eco auf Anfrage von ComputerBase mit. Profitieren könnten deutsche Anbieter aber bei den Inferenz-Berechnungen, also dem Betrieb der KI-Modelle. Statt Highend-Hardware an einem Ort benötigen diese eher eine dezentrale Cloud-Struktur, die auf einen kosteneffizienten Betrieb niedrige Latenzen ausgelegt sind. „Unternehmen benötigen niedrige Latenzzeiten, um KI-Inferenzen nach dem Trainingsprozess zu optimieren. Colocation-Rechenzentren spielen hier die entscheidende Rolle, indem sie die benötigten Kapazitäten mit moderner Infrastruktur sowie Zugang zu einer umfassenden globalen Plattform bereitstellen, die Hyperscaler, Unternehmen und Serviceanbieter direkt miteinander verbindet“, erklärt Equinix-Geschäftsführer Jens-Peter Feidner gegenüber ComputerBase.

Künftig könnten die Inferenz-Berechnungen sogar noch wichtiger werden, im Markt deutet sich ein Paradigmenwechsel an. Selbst führende KI-Entwickler kommen laut Medienberichten bei der Entwicklung der nächsten Modellgeneration kaum vom Fleck. OpenAIs kommendes Orion-Modell soll in den internen Tests kaum besser abschneiden als der Vorgänger, KI-Forscher wie Ilya Sutskever sprechen bereits von einem Ende des Scaling-Zeitalters. Das besagte vereinfacht formuliert: Modelle werden grundsätzlich leistungsfähiger, wenn man diese mit mehr Rechenpower und Daten trainiert. Laut Sutskever erreiche man nun aber ein Plateau, neue Ansätze seien erforderlich.

Eine potenzielle Lösung lieferte OpenAI bereits mit den o1-Modellen, die den Fokus auf die Inferenzphase verlagern. ChatGPT benötigt mit dem o1-Modell also mehr Zeit, um eine Antwort zu generieren. Bei komplexeren Logikaufgaben sind es teils mehr als 100 Sekunden. Auf diese Weise ist es aber möglich, mehrere Lösungswege durchzuspielen, um so bessere und zuverlässigere Ergebnisse zu erhalten. Sollte sich dieser Trend bestätigen, verändern sich die Anforderungen an die Hardware. „Diese Verschiebung wird uns von einer Welt mit massiven Pre-Training-Cluster zu Inferenz-Clouds führen, also dezentralen, Cloud-basierten Servern für Inferenz“, sagt die Sequoia-Capital-Partnerin Sonya Huang der Nachrichtenagentur Reuters. Es wäre also ein Paradigmen-Wechsel, der europäischen und deutschen Anbietern in die Karten spielen würde.

Platzhirsche wie Equinix und T-Systems profitieren vom AI-Boom

Die Platzhirsche im Rechenzentren-Geschäft profitieren ohnehin von der Nachfrage nach generativen AI-Diensten. Das gilt etwa für T-Systems, dort hat man mit der Open Telekom Cloud ein Angebot, das explizit auf KI-Projekte ausgelegt ist. Von einer wachsenden Nachfrage berichtet auch Equinix-Geschäftsführer Feidner gegenüber ComputerBase. Ausgehend vom Cloud-Trend erfolgt ein Wandel hin zu digitalen Geschäftsmodellen, durch den immer mehr IT-Hosting-Dienste ausgelagert werden. Das KI-Geschäft kommt nun nochmals oben drauf.

In Deutschland baut Equinix unter anderem xScale-Rechenzentren aus. Diese darauf ausgelegt sind, große Cloud-Anbieter zu unterstützen. Der Trend geht also eher in Richtung der dezentralen Cloud-Struktur. Insbesondere an Hotspots wie Frankfurt habe Deutschland mit fehlender Infrastruktur wie ausreichend dimensionierten Stromnetzen zu kämpfen. „Deswegen verschieben sich auch erste Investitionen in andere Orte und dieser Trend wird weitergehen“, so der Equinix-Geschäftsführer Feidner.

In Paris geht es schneller. Die französische Hauptstadt ist ohnehin der wichtigste EU-Standort für generative KI, dort ist etwa auch Mistral ansässig – das KI-Start-up ist der europäische Anbieter mit den leistungsfähigsten Large Language Models (LLM). Tätig sind aber noch weitere KI-Firmen. Equinix hat in seinem Pariser Rechenzentren etwa einen Supercomputer für den KI-Entwickler Instadeep eingerichtet, für das Cloud-Unternehmen Nebius wurde ein Cluster mit Nvidia-GPUs aufgebaut.

Optimiert werden zudem bestehende Standorte. Aktuelle und zukünftige Anforderungen wie Flüssigkeitskühlung müssen erfüllt werden, so Feidner. Weitere Themen sind Nachhaltigkeit und Energieeffizient. Entsprechende Vorgaben ergeben sich auch aus der europäischen Regulierung.

Es fehlt die Strategie

Spitzenprojekte wie KI-Supercomputer entstehen nicht in Deutschland, sondern in Paris. Was in diesem Fall ein einzelnes Beispiel ist, sehen Analysten wie Marcel Weiß als potenziell problematischen Trend. Denkt man KI als neue Querschnittstechnologie mit überragender Bedeutung und nicht als verbessertes Cloud-Computing, müsse eine Infrastruktur entstehen, die mehr als Rechenpower bietet. Es ist eine „Infrastruktur, zu der Datencenter neben anderen Dingen wie Energieversorgung, Grundlagenforschung oder ein die Entwicklung unterstützender regulatorischer Rahmen gehören“, so Weiß in der FAZ-Digitalwirtschaft. In dieser Hinsicht passiere in Deutschland aber zu wenig. Es mangele am Willen, die Rahmenbedingungen zu schaffen, die große Würfe ermöglichen.

Dieser Artikel war interessant, hilfreich oder beides? Die Redaktion freut sich über jede Unterstützung durch ComputerBase Pro und deaktivierte Werbeblocker. Mehr zum Thema Anzeigen auf ComputerBase.