Bright0001

Commander

- Registriert

- Juli 2011

- Beiträge

- 2.655

Moin zusammen,

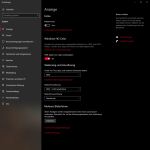

ich hab da eine eher ungewöhnliche Frage: Ich nutze schon seit 2015 nen 4K Fernseher als Monitor, und hab es damals irgendwie geschafft Dinge so einzustellen, dass ich 4K@60Hz ohne Chroma Subsampling (oder zumindest ohne sichtbare Artefakte) nutzen konnte und auch genutzt habe. Jetzt bin ich auf nen LG C9 gewechselt und hatte gleiches Spiel: Chroma Subsampling machte Texte recht hässlich (mit fuzzeligem gelben Rand), doch nach einigem Ausprobieren läuft mein Windows jetzt in 4K mit 60Hz + HDR über eine 1080, ohne dass es (scheinbar) zu Chroma Subsampling kommt (siehe Bild). Meine Frage ist jetzt: Warum funktioniert das überhaupt über HDMI 2.0? Ich dachte das wäre allein wegen der Bandbreite nicht möglich?

Mir ist klar, dass es am einfachsten wäre in alle Einstellungen einzusteigen und diese zu überprüfen, aber davor ich hab ich scheu, weil ich die Befürchtung habe, dass ich es dann nicht mehr hierher "zurück schaffe". Vielleicht hat ja jemand ähnliches Bild.

EDIT: Noch ein paar Bilder hinzugefügt.

ich hab da eine eher ungewöhnliche Frage: Ich nutze schon seit 2015 nen 4K Fernseher als Monitor, und hab es damals irgendwie geschafft Dinge so einzustellen, dass ich 4K@60Hz ohne Chroma Subsampling (oder zumindest ohne sichtbare Artefakte) nutzen konnte und auch genutzt habe. Jetzt bin ich auf nen LG C9 gewechselt und hatte gleiches Spiel: Chroma Subsampling machte Texte recht hässlich (mit fuzzeligem gelben Rand), doch nach einigem Ausprobieren läuft mein Windows jetzt in 4K mit 60Hz + HDR über eine 1080, ohne dass es (scheinbar) zu Chroma Subsampling kommt (siehe Bild). Meine Frage ist jetzt: Warum funktioniert das überhaupt über HDMI 2.0? Ich dachte das wäre allein wegen der Bandbreite nicht möglich?

Mir ist klar, dass es am einfachsten wäre in alle Einstellungen einzusteigen und diese zu überprüfen, aber davor ich hab ich scheu, weil ich die Befürchtung habe, dass ich es dann nicht mehr hierher "zurück schaffe". Vielleicht hat ja jemand ähnliches Bild.

EDIT: Noch ein paar Bilder hinzugefügt.