Was 3Dfx mit Multi-Chip-Lösungen bereits erreicht hatte kann man an Lösungen wie Quantum3D oder den VSA-100-Karten der Voodoo5-Reihe sehr gut erkennen. Eine Technik wird nicht gleich nur wegen ihrem Alter schlecht. Nvidias SLI hat aber dennoch nicht viel mit 3Dfx' Scan-Line-Interleave zu tun, dass irgendwie eine Verbindung zwischen den Karten geschaffen werden muss ist was anderes. Klar ist, dass Nvidia von den drei Großen der letzte war, der so eine Technologie entwickelte.

Und was das kopieren anbelangt:

Sowohl Nvidia als auch ATI setzen auf den Kartenlayouts auf "Hyper-Transport"; haben sie jetzt von AMD kopiert? Nicht wirklich.

@Geschichte

Ob Nvidia wirklich der erste Entwickler eines 3D/2D-Combi-Chips war ist mir nicht bekannt, allerdings konnte man die ersten zwei 3D-Chips komplett vergessen. Erst nachdem ein neuer Chefentwickler eingekauft wurde, der das Konzept, wie bei Nvidia die Texturen verkleistert wurden, komplett verwarf, ja tatsächlich eine konzerninterne, technologische Revolution auslöste, in der das alte Design wirklich komplett in die Tonne getreten wurde, wurde man langsam konkurrenzfähig. PowerVR und Rendition waren früher nicht zu unterschätzende Größen - zu einer Zeit als an der Leistungs- und Kosten-Spitze sowieso nur Platz für 3Dfx Voodoo Graphics war.

Viele meinen Nvidia wäre bereits mit der RivaTNT der ultimative Schlag gegen ATI gelungen, allerdings verhält es sich rein technisch gesehen genau umgekehrt, denn der Rage128 ließ Nvidia auf technischer Ebene nicht viel Luft. ATI hatte damals ein riesiges Problem, es gab einen Umstand, der, als er bei 3Dfx auftrat, 3Dfx in den unausweichlichen Bakrott trieb (was aber auch nur möglich war, weil die Marktentwicklung um 3Dfx jahrelang gute Vorarbeit für einen Untergang geleistet hatte): ATI verkaufte alle Karten unter eigenem Label und das eigene Label konnte eben nie den Stellenwert erlangen den Markennamen wie "Diamond" (die sich mit der "Diamond Monster 3D" auf ewig ins Gedächtnis der Voodoo1-Jugend brannten) trugen. Man erkannte diesen Umstand, der allein Marketing betrifft (denn unter eigenem Label zu vermarkten bedeutet lange nicht selbst zu produzieren, das übernahmen damals schon andere, bei ATI allen voran Sapphire, heute weiß auch jeder dass die Chipentwickler auch die Chips bei anderen Firmen produzieren lassen), zum Glück gerade noch rechtzeitig um den Karren nicht an die Wand fahren zu lassen und vergab auch Kartenlizenzen für Rage Fury an andere Labels. Zu dieser Zeit war aber der Rage128 schon mächtig gealtert und Nvidia stand kurz davor die TNT2 zu veröffentlichen, deren Ultra-Variante nun auch "endlich" die Rage Fury besiegen konnte. Guillemot meldete sich zum Vermarkten von ATI-Chips an und kaufte den Namen der damals seit langem untergegangenen Firma "Hercules", die dem Markt immernoch in guter Erinnerung war und als TNT2 auf dem Markt war verkaufte Hercules Rage-Fury-Karten (Rage128) mit leicht erhöhten Chip- und Speicher-Frequenzen ("Taktraten") und machte damit immernoch ganz gut dampf, nun, dem guten Label wegen, auch in der Kasse, da man gegen die nagelneue TNT2-Ultra aber immernoch nicht ankam und wegen dem schlechten Management der Vorjahre nicht sonderlich viel Geld für schnelle Neuentwicklungen hatte wollte man einen halbwegs Konkurrenzfähigen Zwischenschritt um eine Generation zu überbrücen und entwickelte, in fester Erinnerung an die Voodoo-2-SLI-Bundles die enorme Performance für die verwendete Technologie boten, eine Lösung zur Verwendung zweier Chips für eine 3D-Anwendung, die Rage Fury MAXX kam noch lange vor Geforce auf den Markt und war ertsmal deutlich schneller als die TNT2, erinnerte aber nicht nur in der Performance an alte 3Dfx-Zeiten, denn bei Release kostete eine Hercules Rage Fury MAXX nach Liste DM799,-, die letzte Karte die bei Markteinführung die 700 Märker überschritt hieß Voodoo2 und seither war man leicht moderatere Preise gewohnt gewesen.

ATI konnte sich immer eine Finanzsicherheit bewahren, die in der hervorragenden Videobeschleunigung der Karten, dank einem guten, zusätzlichen Videochip auf den Karten begründet war, nun aber brachten auch andere im 3D-Grafik-Segment bekannte Hersteller - vor allem 3Dfx - eine gute Videobeschleunigung, die Voodoo3 3500 hatte sogar einen Mpeg-2-Decoder auf der Platine. ATI wusste dass man was tun musste und erinnerte sich daran bereits in der Rage-II-Serie (Vorgänger der Rage-Pro) einmal eine Karte die einen TV-Tuner mit auf der Platine hatte in der Schublade gehabt zu haben, das Projekt scheiterte damals an den hohen Kosten, nun aber war man bereit dieses Schritt zu vollziehen und nannte die erste Massenmarkttaugkliche Alleskönnerkarte All-In-Wonder, sie hatte nur einen Rage128-Chip (ein zweiter hätte schlicht nicht mehr auf die Platine gepasst) und war damit selbst der TNT2 unterlegen, dennoch wurde die Karte sehr häufig verkauft. Als Nvidia die Geforce256 auf den Markt warf, hatte ATI die Radeon noch lange nicht fertig entwickelt, aber dennoch wurde die All-In-Wonder Rage Fury immernoch relativ gut verkauft, es gab keinen Elektronikladen der die All-In-Wonder nicht im Regal hatte, obwohl ihre 3D-Fähigkeiten nun, in Anbetracht der Geforce, überaltert waren. Die Rage Fury MAXX, deren 3D-Leistung deutlich besser war und zumindest die Rücklichter der Geforce noch sehen konnte, solange die Anwendungen kein T&L unterstützten spielte nun keine Rolle mehr.

ATI entwickelte die Radeon so schnell es nur ging (was wie gesagt aufgrund der schlechten Marketing-Politik zum Launch des guten Rage128 eben nicht besonders schnell war) und um überhaupt mit Leistung anstinken zu können wurde dann erstmals Texturqualität beschränkt. Nach dem R100 konnte sich ATI langsam wieder erholen und konnte den Chips auch genügend Fähigkeiten geben mit besserer Texturqualität noch konkurrenzfähige Leistung zu bieten. Erst der R300 hat sich fast von allen Texturschlampereien des R100 befreit, dafür aber brachte er eine neue Schmiererei: Der beim R300 endlich auch trilinear anwendbare Anisotrope Filter wurde in verschiedenen Winkeln verschieden stark berechnet. Diese "Optimierung" ist auch in der aktuellen Chipserie fest in Hardware verankert und mit der Geforce6 auch von Nvidia übernommen worden, ebenfalls in Hardware verankert.

Nvidia bot das letzte mal mit der Geforce 3 "unoptimierte" Texturqualität, die Qualität der Geforce4 (Titanium) war aber sehr deutlich besser als das was ATI bot, die optimierung hielt sich noch in Grenzen und die GeforceFX übernahm die Qualität ihres Vorgängers. Warum also ist die GeforceFX dennoch wegen der Bildqualität in Verruch? Gan einfach:

1. Während der NV35, der GeforceFX-Refresh-Chip, veröffentlicht wurde ließ man sich bei Nvidia einfallen den trilinearen Filter per Treiber (also rein per Software, dennoch nicht leicht zu umgehen) nicht mehr über die volle MipMap-Länge trilinear anzuwenden sondern lediglich an den Kanten. Das Resultat waren zwar "weiche" Übergänge, wie bei echtem Trilinearen Filtern zwischen den Detailstufen, was bei Standbildern, die üblicher Weise in Qualitätstests bei Tom's Hardware uä. angewendet wurden kaum einen sichtbaren Unterschied machte, aber in der Bewegung doch wieder zu erkennbaren "Bugwellen" führte, die einige Spieler doch sehr stören können, auch wenn es nicht so schlimm wie rein bilineares Filtern ist. Dieser Effekt ist für die meisten weit nerviger als eine Winkeloptmimierung, die im schlimmsten Winkel auf 2x AF zurückfällt, besonders weil hohe AF-Modi ab 8x eh kaum gespielt wurden. Nvidia hatte hier bereits seinen Pluspunkt, wenn auch rein auf Treiberebene, die bessere Texturqualität voll verspielt; umgangssprachlich nennt man soetwas wohl "Managementfehler".

2. ATI bot mit dem R300 eine Sparsed-Grid-Multi-Sampling-Maske die bei 4x derart gute und angenehme Resultate förderte, dass selbst Matrox mit seinem 16x AA auf der Parhelia Angst bekam und Nvidia bot damals noch ausschließlich Ordered-Grid-AA. Erst mit Geforce6 bietet Nvidia eine Multi-Sampling-Maske die zu ATI konkurrenzfähig ist.

Diese zwei Punkte in Kombination brachten viele, auch mich dazu, als eigentlich bildqualitätliebende Spieler eine Radeon 9700 oder 9800 zu kaufen. Hätte Nvidia damals bereits, wie heute in Forceware üblich, wenigstens den "bri"linearen Mist abschaltbar gemacht hätte ich vermutlich zur Geforce FX gegriffen.

So jetzt ist dem ein oder anderen vielleicht die Geschichte der beiden aktuellen Marktführer etwas klarer.

Ich schreib zu viel.

XTR³M³ schrieb:

nö, aber wie wäre es mit schlchtem treiber support, miese treiber qualität, noch schlechteres treiber menü...

dann schafft ATI es netmal in 2 jahre einen neuen chip zu launchen, imme rwieder der selbe aufgegohrende shice, nur mal ein bisschen takt und nen paar pipes mehr, der rest ist der gleiche müll wie beim R300.

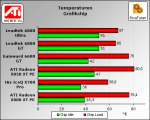

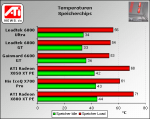

und ATI sollte auchmal richtige kühler bauen, nicht den müll den sie einem da immer andrehn wollen der nach 2-5 wochen laut anfängt zupfeifen weil der lüfter billigste billig ware ist(passend zu den karten), und vorallendingen sollten die mal kühler bauen die auch kühlen, keine karten werden heißer als die ATI karten, hier mal nen paar nette bildchen von einer ATI seite.

und der stromverbrauch der ATI karten ist ja auch jeseits von gut und böse, ich bleibe da lieber bei den sparsamen und schnelleren NV lösungen mit mehr technologie und wiederverkaufswert.

Bessere Linuxtreiber könnten sie machen, auf Windows haben sie aber nicht den geringsten Rückstand, auch Nvidia-Treiber haben Probleme, aber als Fan mit grünen Augen ist man vielleicht blind für grüne Fehler.

Nvidia hat nur aus einem einzigen Grund ein sehr gut ausgebautes Linux-Treiber-Team:

Ihre Workstation-Karten statten Märkte aus die erstklassige 3D-Performance auf Linux erfordern, wie etwa große Film-Studios.

Braucht also bitte kein Linux-Gamer glauben Nvidia würde die Treiber gerade für ihn so gut machen.

Dennoch darf man gern die schlechte Performance der ATI-Linux-Treiber anprangern, es ist immerhin ein echter Makel.

Was die "Neuheit" der Chips, die angeblich schlechten Kühler und den Stromverbrauch anbelangt fasse ich mich kurz:

<°)))><(