Sandolo

Lt. Junior Grade

- Registriert

- Okt. 2023

- Beiträge

- 329

In einem anderem Thread hatte ich eine Diskussion bezüglich der Auslagerungsdatei. Dies war aber Off-Topic (eigentlich anderes Thema) und deshalb nicht wirklich zu Ende diskutiert.

So gab es einige, die diese unangetastet und von Windows verwalten lassen. Und es gab welche, die diese auf eine feste Größe einstellen.

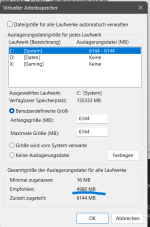

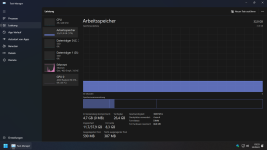

Ich selbst habe eine feste Größe eingestellt, weil es etwas mehr Performance bringt, sowie die SSD etwas schonender behandelt. Dazu habe ich eine bei 32 GB RAM eine relativ kleine Größe eingestellt (6144 MB). Mir ist aber bewusst, dass je Anwendungen auch eine größere Menge erforderlich ist und diese daher nicht auf jeden zutrifft.

Jetzt würde ich gern mal wissen, wie ihr das handhabt und vor allem warum ihr eure Methode bevorzugt und die andere ablehnt.

So gab es einige, die diese unangetastet und von Windows verwalten lassen. Und es gab welche, die diese auf eine feste Größe einstellen.

Ich selbst habe eine feste Größe eingestellt, weil es etwas mehr Performance bringt, sowie die SSD etwas schonender behandelt. Dazu habe ich eine bei 32 GB RAM eine relativ kleine Größe eingestellt (6144 MB). Mir ist aber bewusst, dass je Anwendungen auch eine größere Menge erforderlich ist und diese daher nicht auf jeden zutrifft.

Jetzt würde ich gern mal wissen, wie ihr das handhabt und vor allem warum ihr eure Methode bevorzugt und die andere ablehnt.