Dieser Thread ist ein Ableger eines großen Anno 1800 Benchmarks, der aufgeteilt werden musste.

Der Hauptthread mit den Inhaltsverzeichnis bietet Erläuterungen die vorher gelesen werden sollten.

Es ist viel Zeit vergangen, nachdem ich die ursprünglichen Messungen gemacht hatte und damals fehlten dem Spielstand den ich getestet hatte noch die letzten drei großen DLCs aus 2022(Hacienda, Luftschiffe/Post und größere Neue Welt+Artistas).

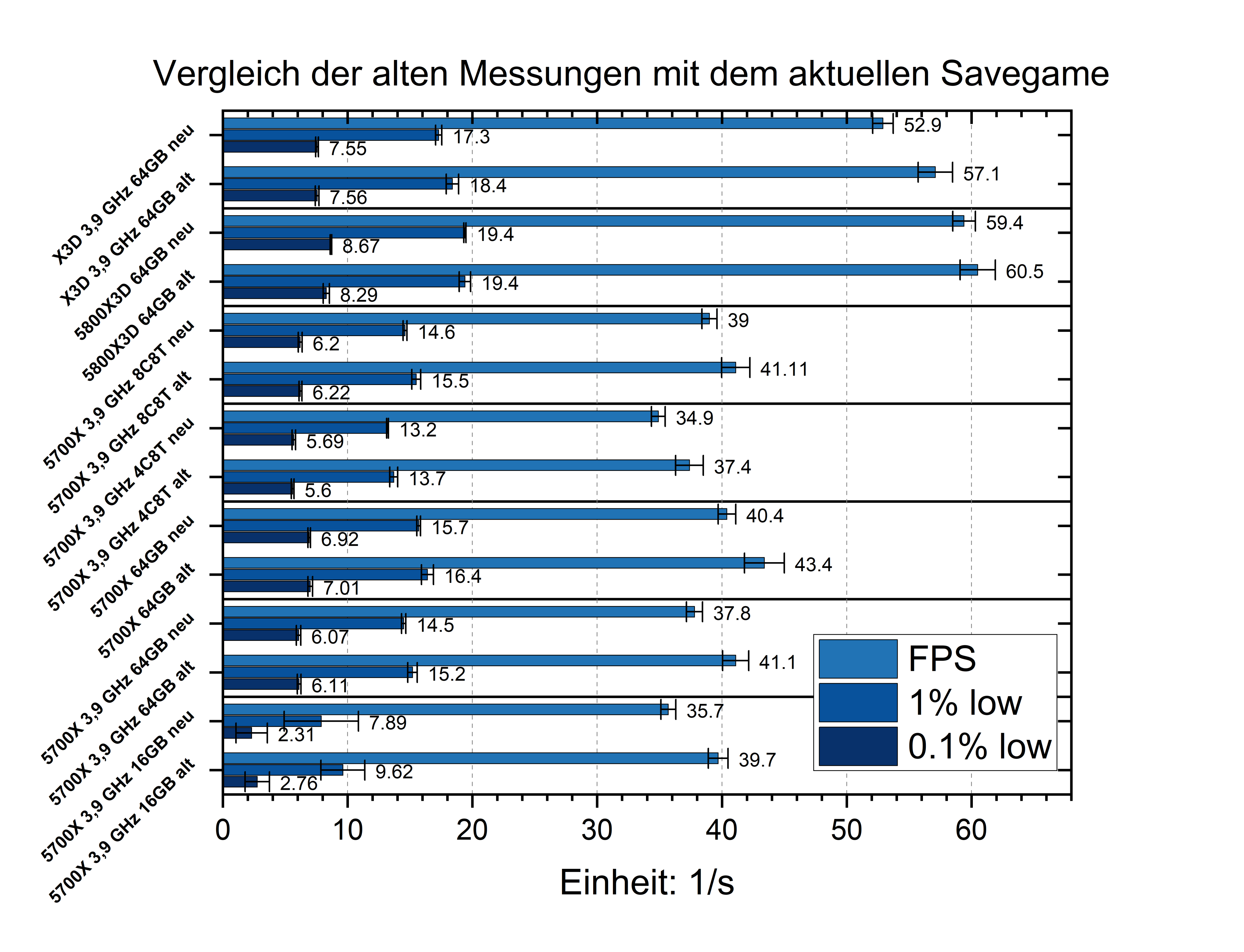

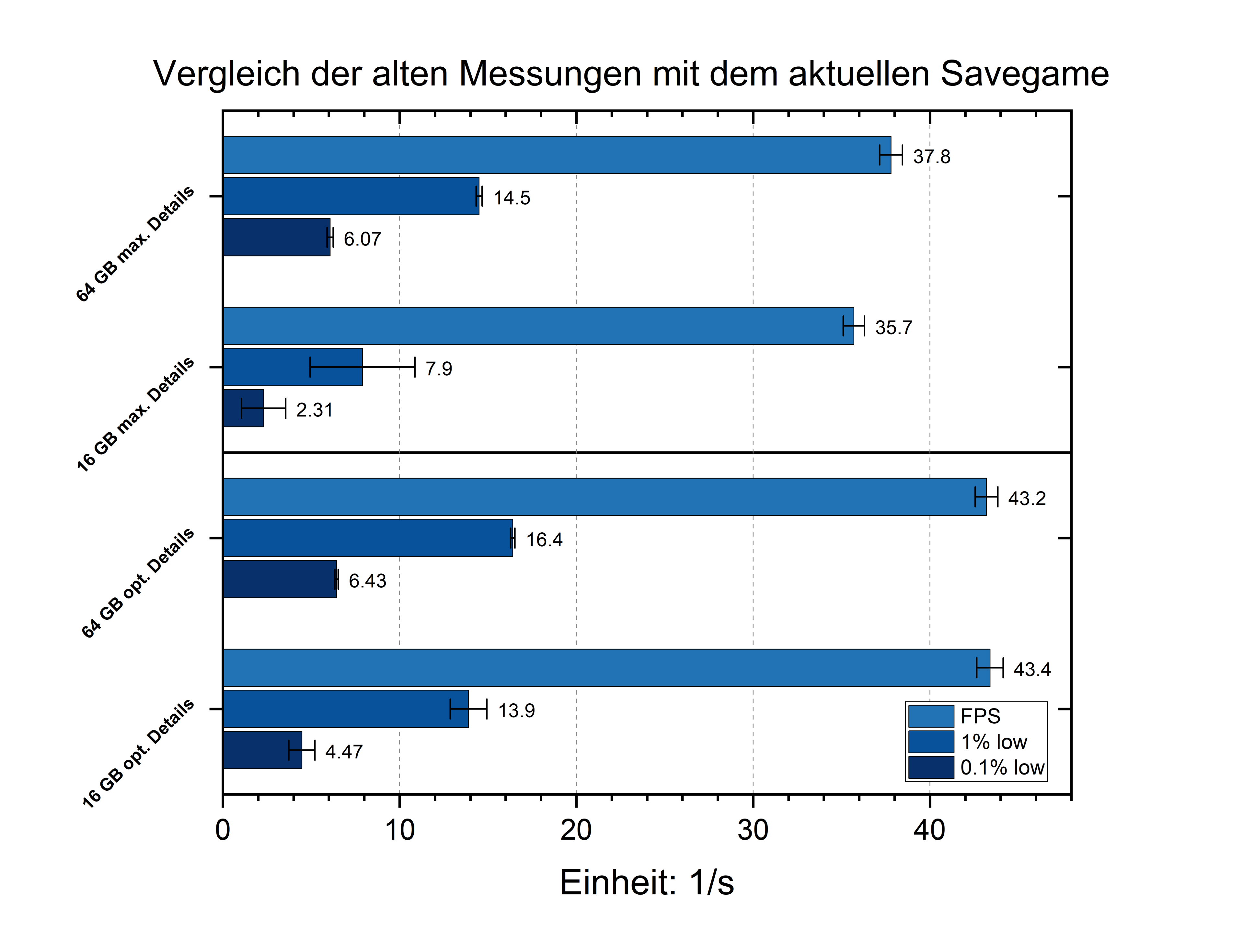

Es mag etwas unübersichtlich sein, aber je zwei Einträge entsprechen der gleichen Hardware Konfiguration mit dem alten bzw. neuen Savegames.

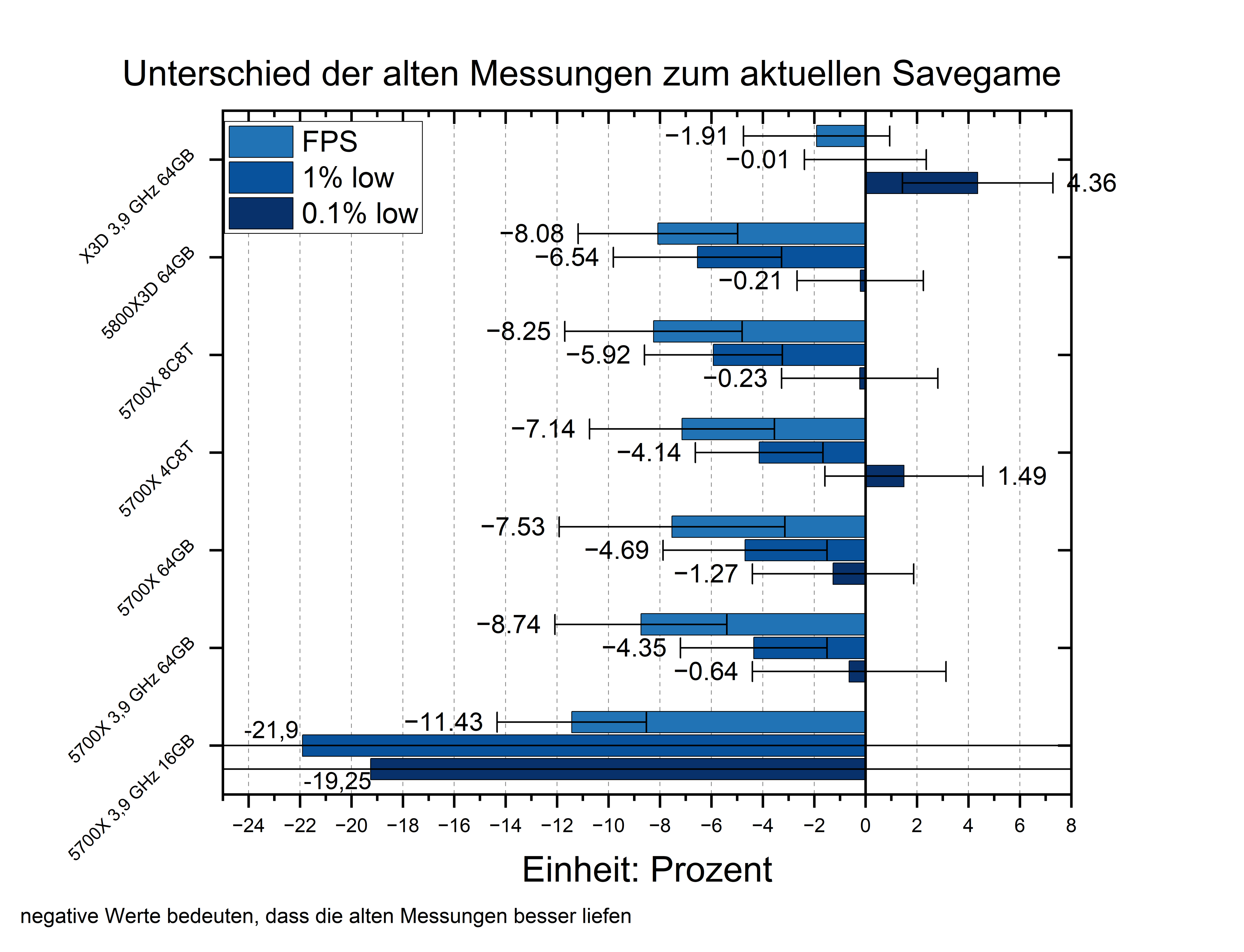

Um die Veränderngen besser sehen zu können habe ich die prozentualen Unterschiede aufgetragen:

Negative Werte bedeuten, dass das alte savegame wie erwartet schneller lief.

Bei den 0,1% low Frametimes hat es meist keine eindeutige Änderung gegeben, mit Ausnahme der Messungen mit dem 5800X3D, wo sich die 0,1% low Frametimes sogar verbessert haben und den 16GB RAM, bei denen sich die Werte besonders verschlechtert haben. Ein Anzeichen für einen gestiegenen RAM-Bedarf.

Nimmt man diese Ausreißer raus, sinken die FPS im Schnitt um 8,6%, die 1% low Frametimes um 5,3% und die 0,1% low Frametimes um kaum messbare 0,5%.

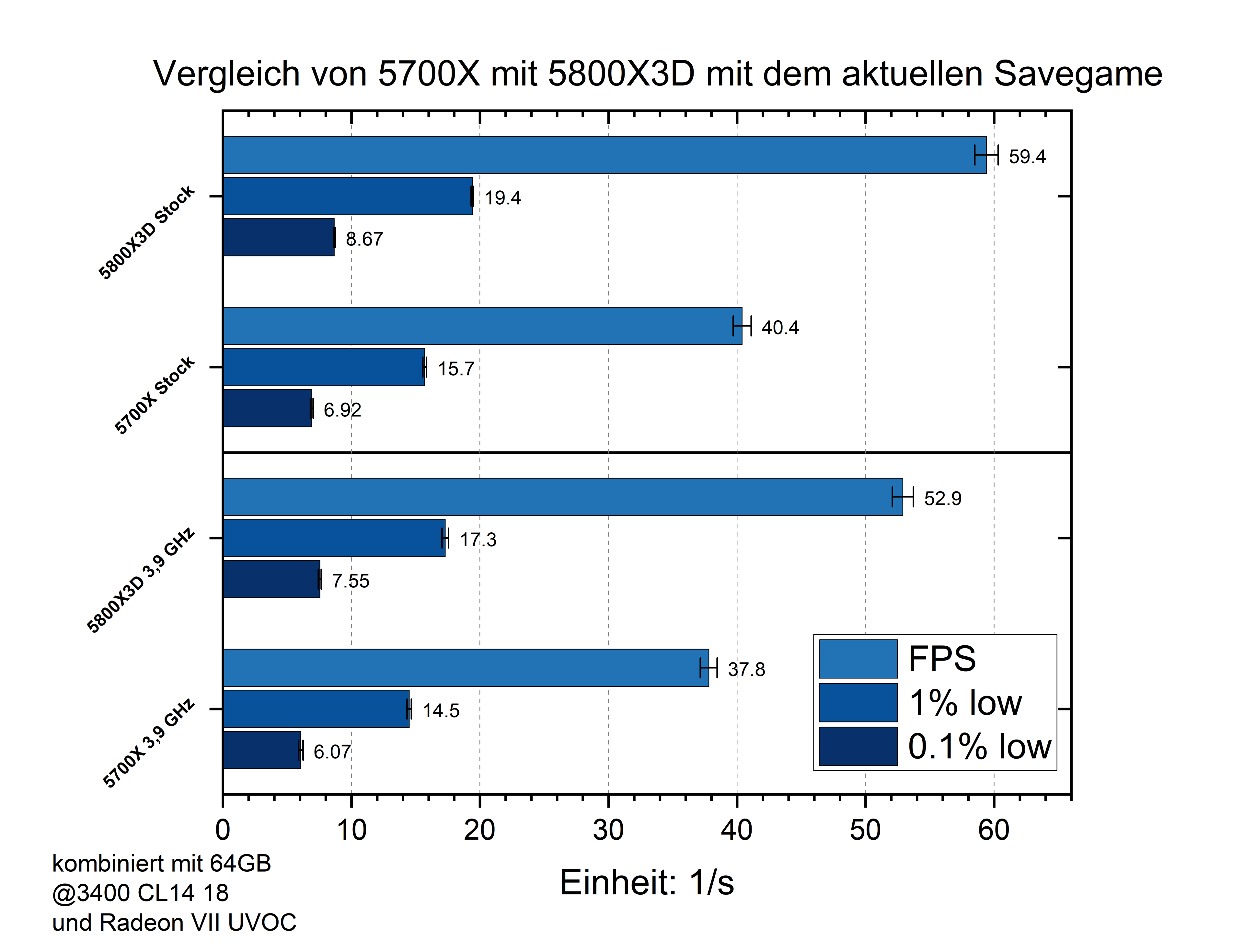

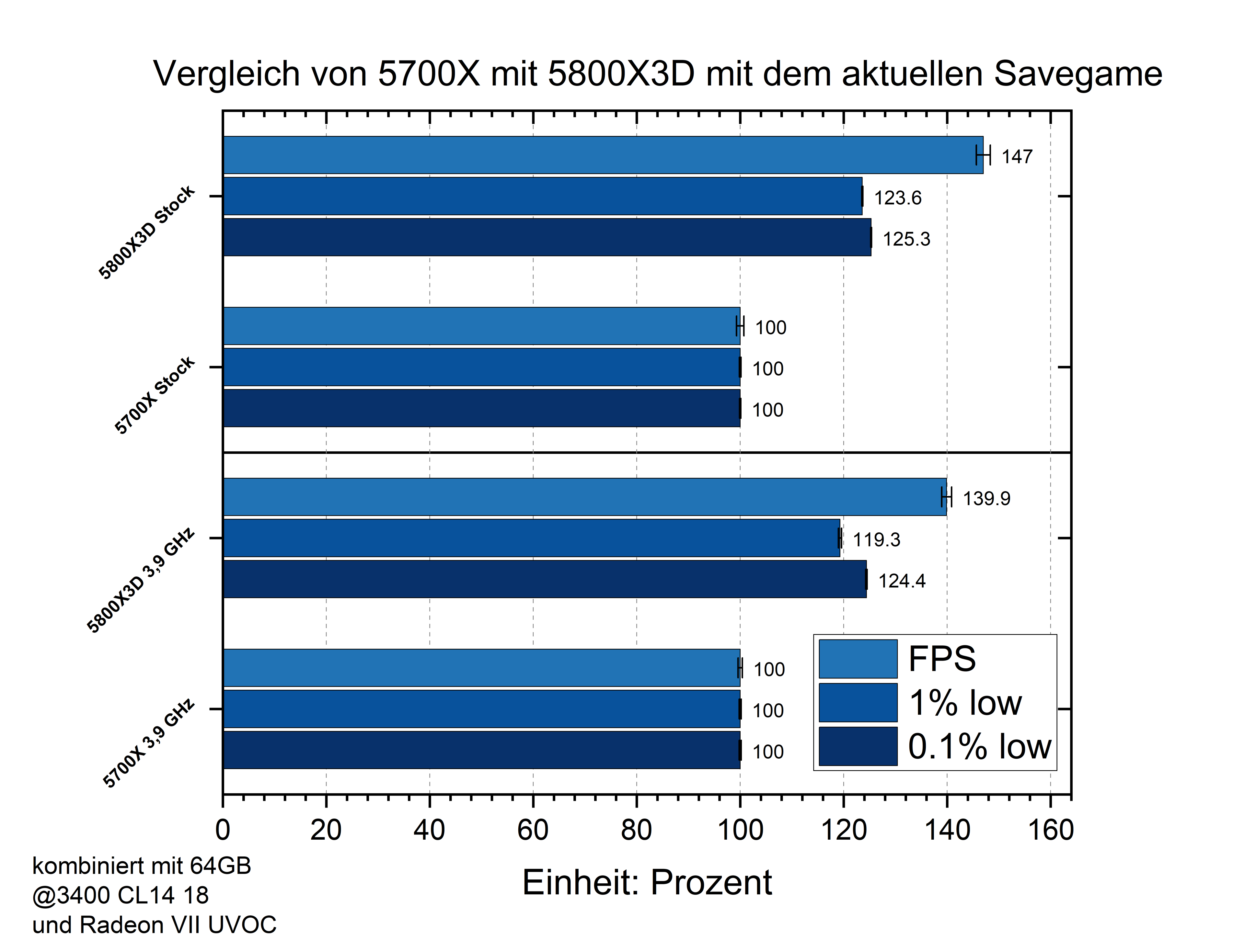

Sowohl Stock als auch mit festgesetztem CPU Takt deklassiert der 5800X3D den 5700X

47% mehr FPS bringen ihn auf fast 60 FPS, wo sich der 5700X mit spielbaren, aber spürbar schlechteren 40 FPS präsentiert.

Das ist nochmal eine Steigerung zu den 39% die der X3D im alten Spielstand vorne lag....damals war der X3D jedoch auch durch ein einsetzendes GPU Limit begrenzt.

Bei den 1% low Frametimes war der Unterschied damals 18,3% und nun 23,6%.

Es scheint nicht so, als würde der Vorteil dem L3 Cache mit mehr Spielinhalt sinken, sondern eher steigen.

Mit den neuen savegame hat sich die neue Welt vergrößert und die zusätzlichen DLCs benötigen ebenfalls mehr Speicher.

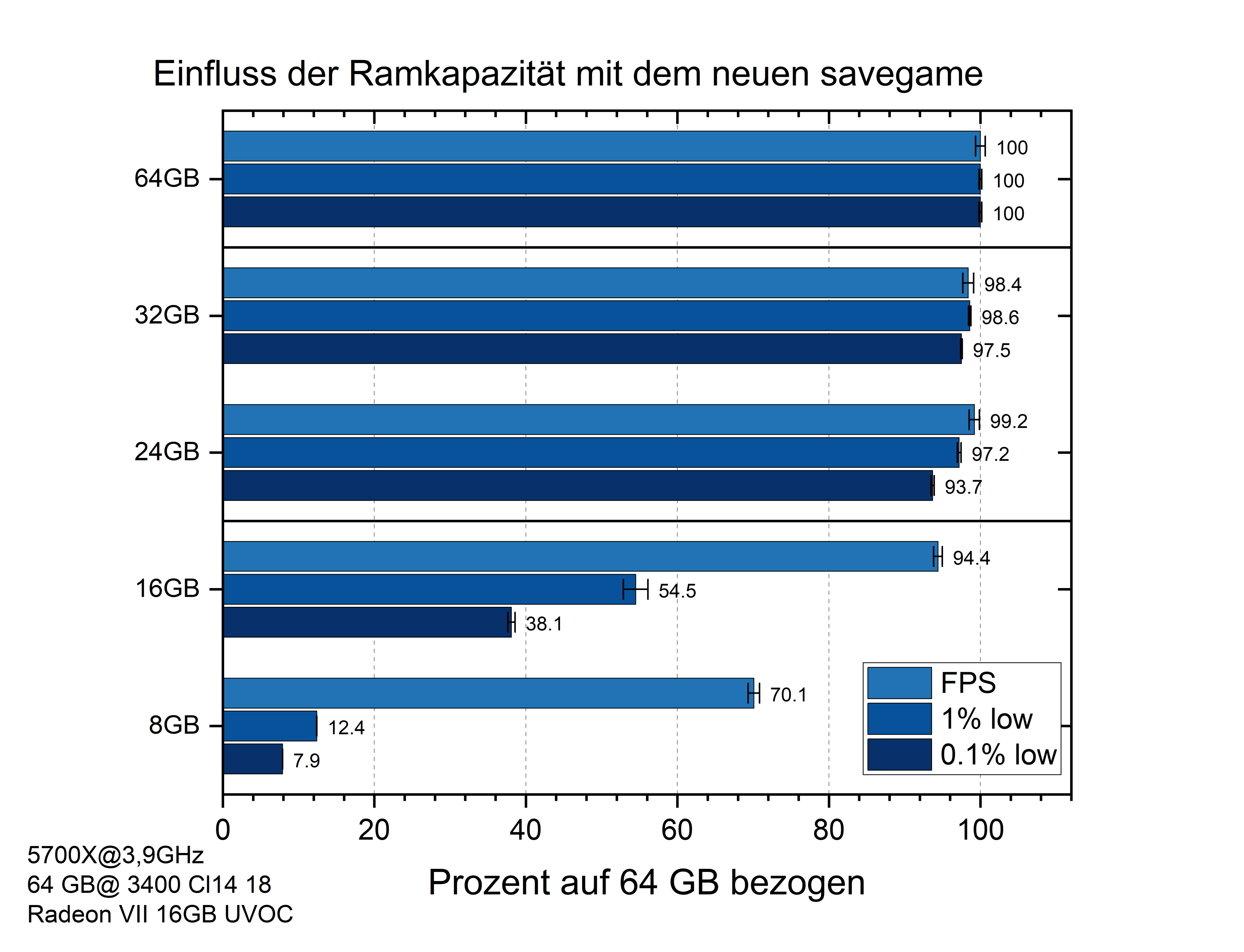

An der Empfehlung zu 32GB ändert sich daher nichts.

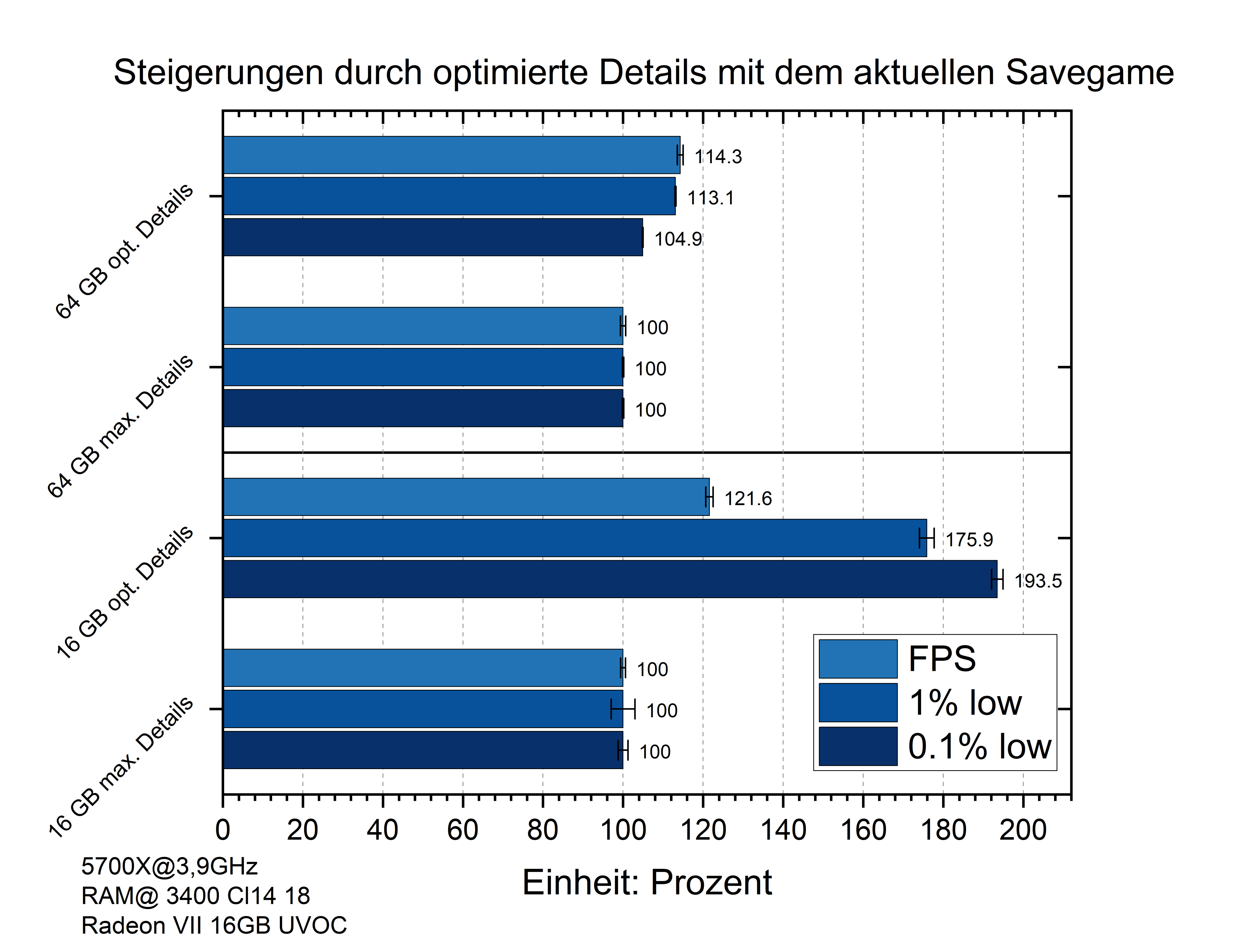

Schaut man sich die Leistungssteigerung durch den Wechsel von den maximalen zu den optimierten Details an, sieht man, dass die Vorteile bei 16 GB viel stärker ausgeprägt sind.

Mit 64 GB RAM lassen sich vor allem die FPS und damit der Input-Lag verbessern und die Ruckler werden weniger verbessert.

Mit 16 GB RAM profitieren die FPS zwar stärker, aber die großen Vorteile liegen bei den Frametimes die massiv profitieren.

Schaut man sich die FPS an, sieht man dass es mit den optimierten Details keinen Unterschied gibt, aber mit den maximalen Details sind die 16GB zu wenig und die FPS sinken um 5,5%.

Bei den Frametimes haben die 16 GB trotz den optimierten Details starke Einbußen. Diese Einbußen sind aber weniger ausgeprägt.

So sinken die 1% low Frametimes mit den maximalen Details um ganze 55% und mit optimierten nur um 15%.

Möchte man Anno 1800 bis ins lategame spielen und hat nicht die Möglichkeit auf 32 GB aufzurüsten, dann ist eine Anpassung der Grafikoptionen eine sinnvolle Möglichkeit, die nicht einmal spürbar die Optik beeinflussen muss, wie die Vergleichsbilder dem vorherigen Thema zeigen.

Wie schon mit dem alten Savegame sind die Leistungsverluste durch weniger CPU Kerne gering, solange es mindestens 4 sind.

Von 8 auf 6 Kerne bei aktivem SMT sind es nun 3 statt 2% weniger FPS.

Auf 4 Kerne mit SMT sind es nun 7,7 statt 6,6% weniger FPS.

Der deutliche Unterschied liegt bei 4 Kernen und deaktiviertem SMT.

Mit dem alten savegame war es nicht nur mit mehr Kernen, sondern auch mit 4 Kernen besser SMT deaktivert zu lassen.

Mit dem neuen savegame dreht sich das Bild hier und es gehen 8% Leistung verloren.

Bei meinen Tests hat sich die CPU Auslastung nicht stark erhöht und liegt jetzt mit 16 Threads bei durchschnittlich 29 statt 27%.

Dieser kleine Unterschied scheint jetzt aber bei 4 Kernen kritisch zu werden und die virtuellen Threads bieten nun einen Vorteil anstelle eines Nachteils.

Hat man 6 oder mehr CPU Kerne gilt weiterhin, dass es dem Spiel hilt ihm die virtuellen Threads zu klauen um einen kleinen aber kostenlosen Leistungsschub(0,5-3%) zu erhalen.

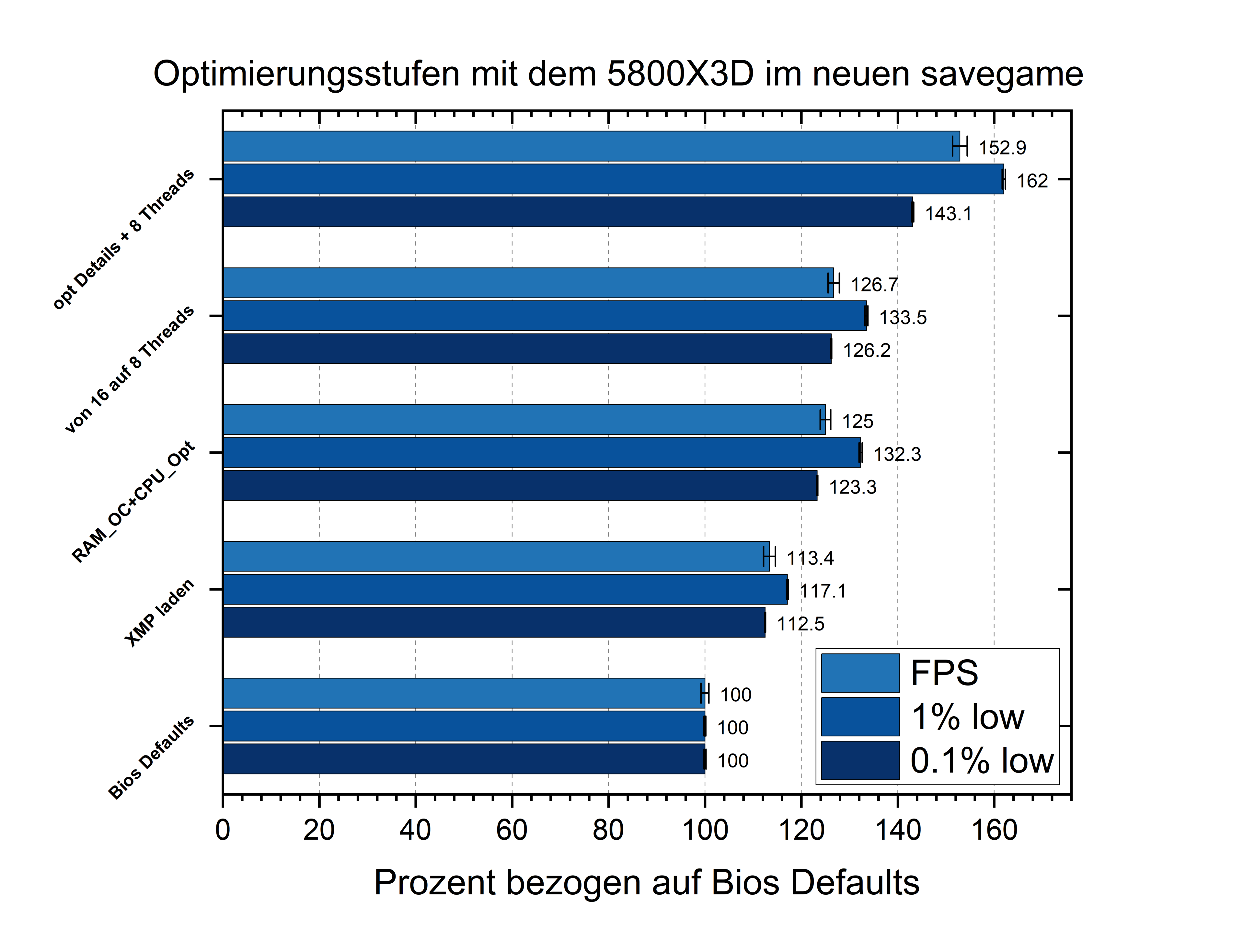

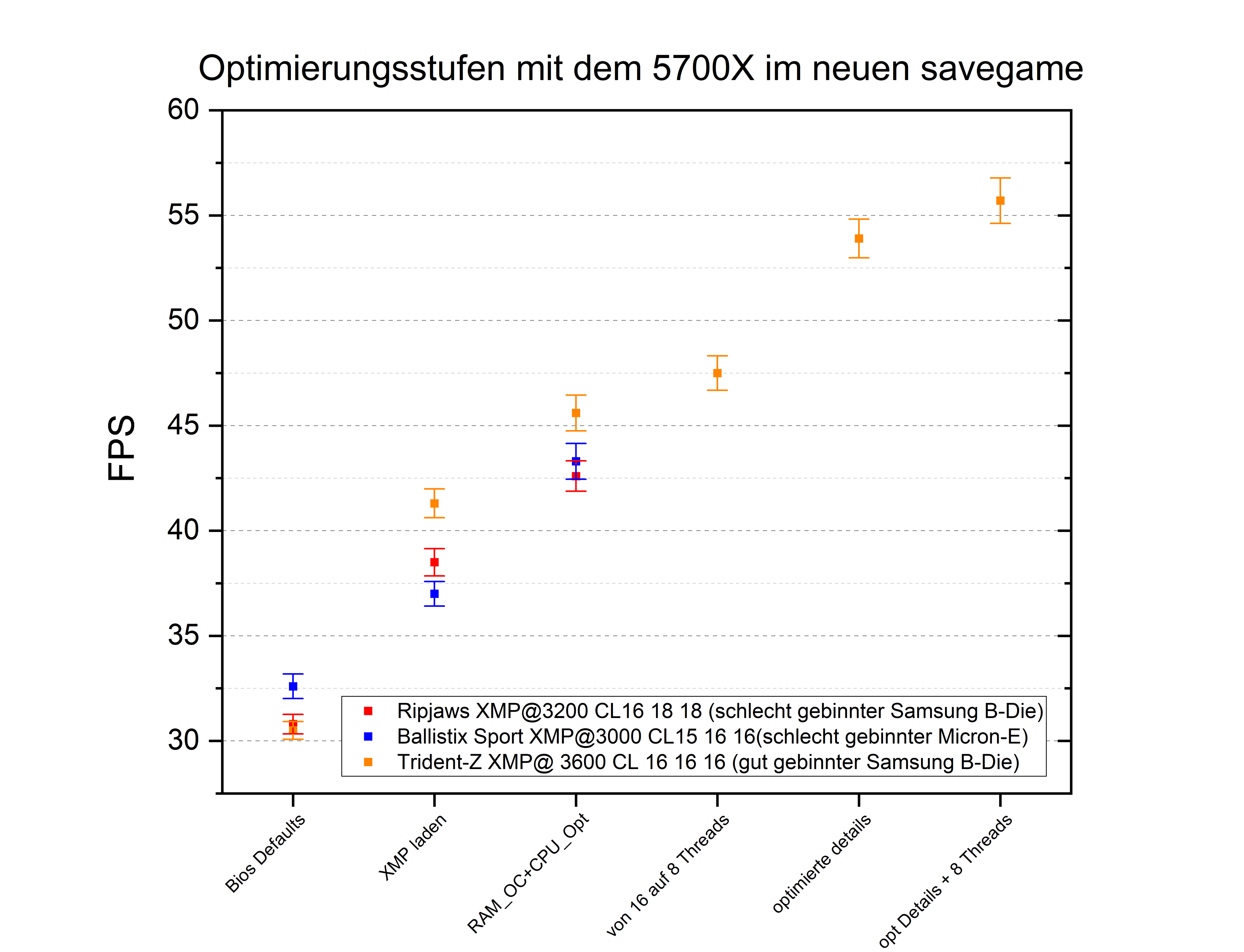

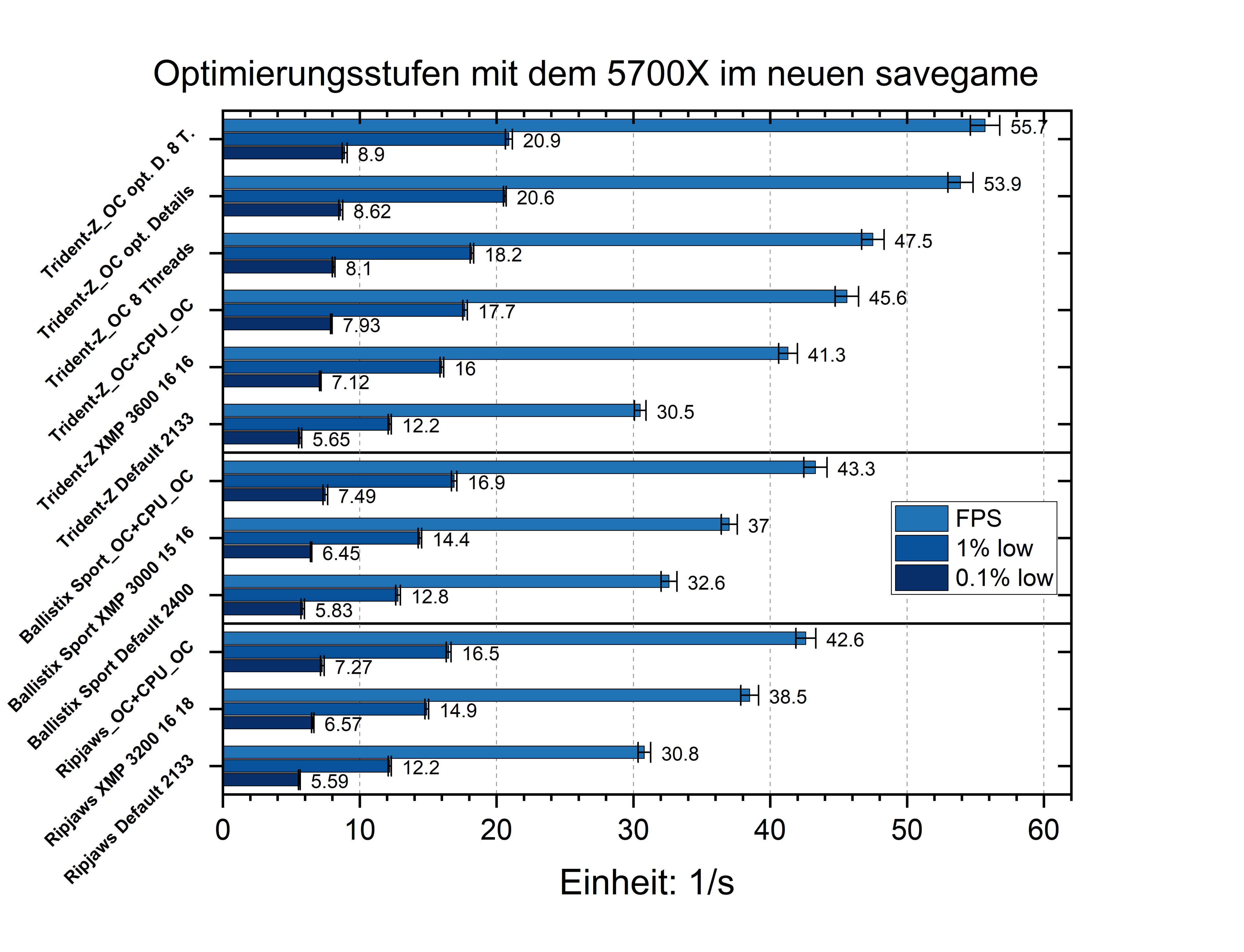

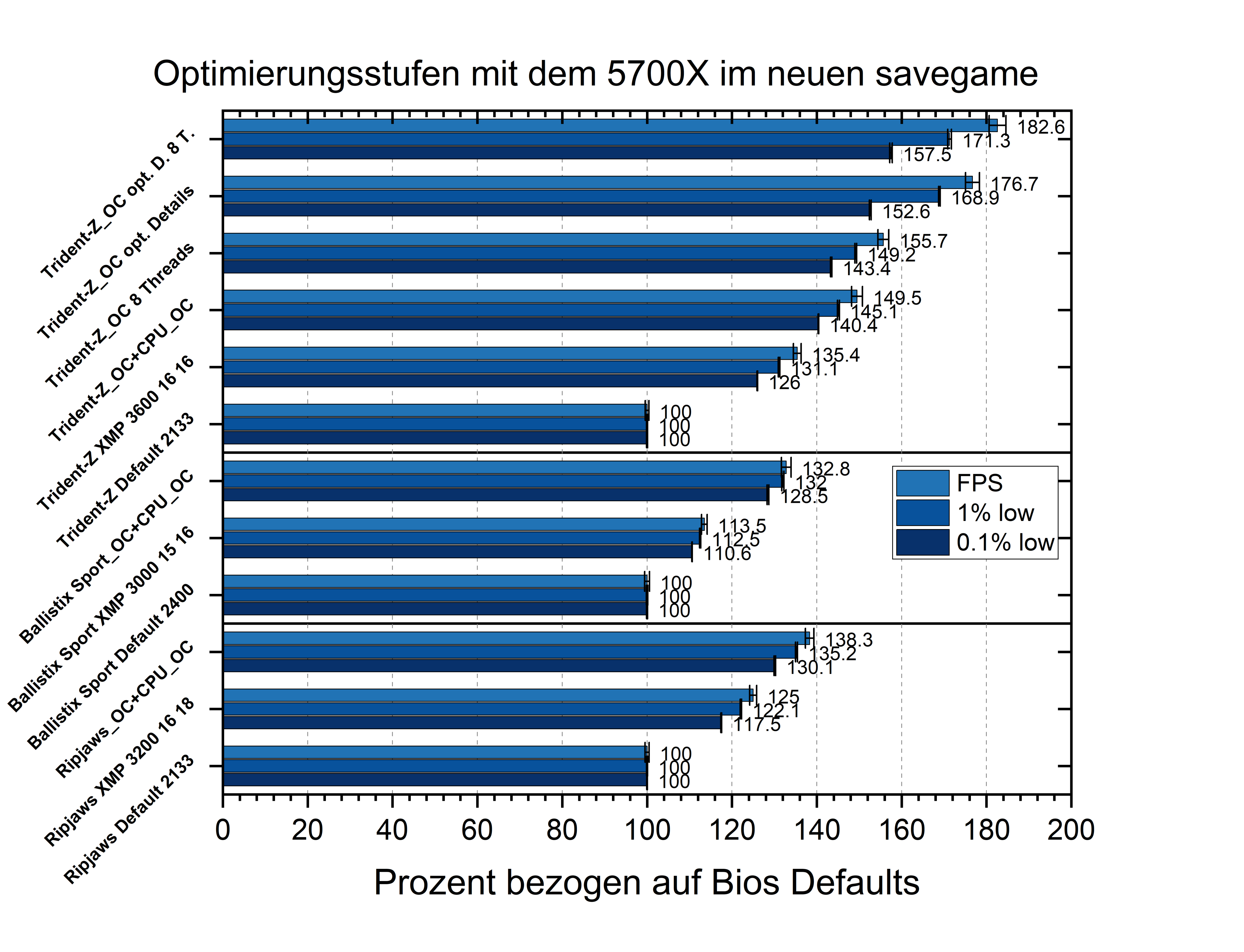

Ich habe in den vorherigen Tests den wissenschaftlicheren Ansatz gewählt und habe jeden Aspekt einzeln betrachtet und dabei andere Faktoren möglichst gut eliminiert/festgesetzt.

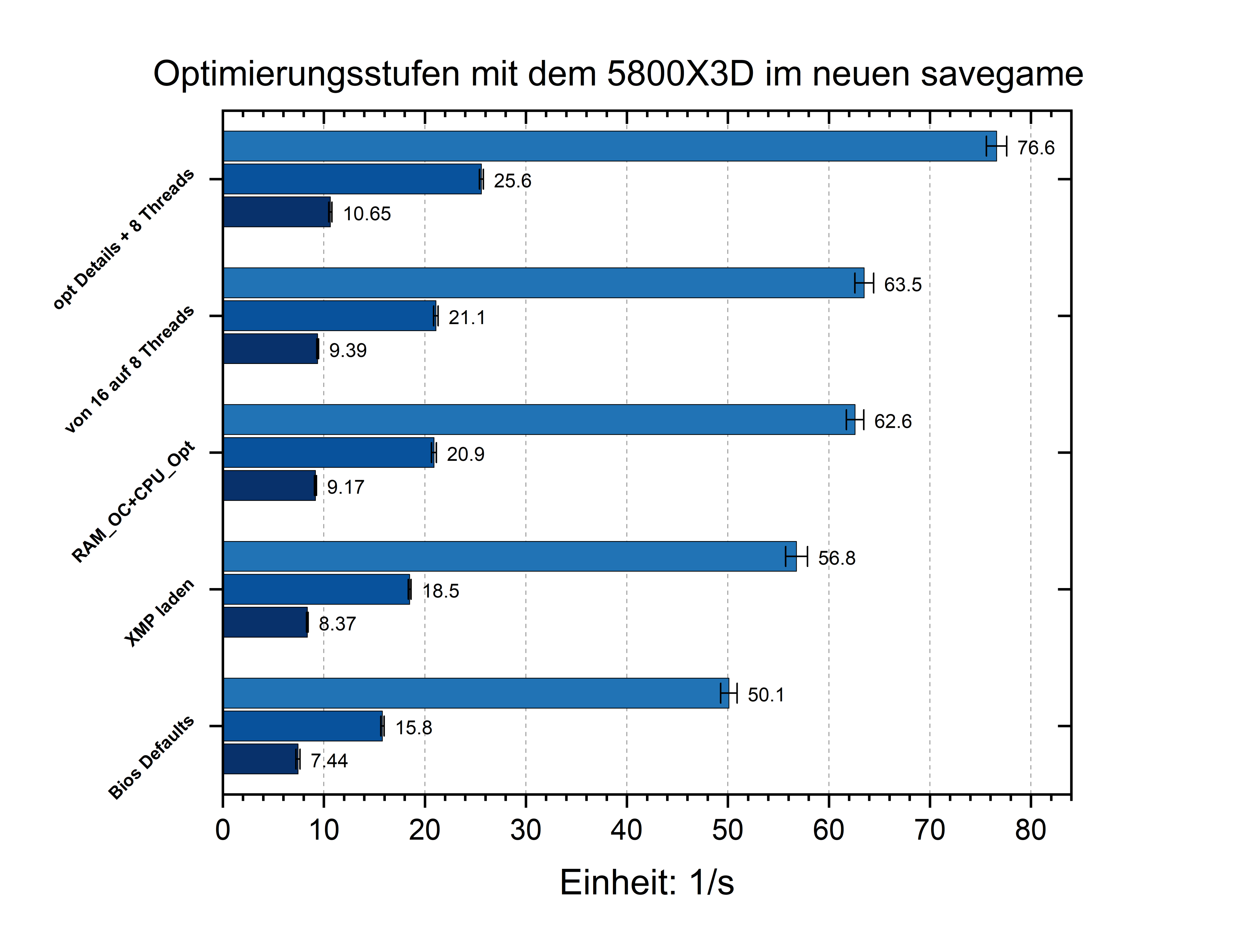

Hier teste ich einen realitätsnäheren Ansatz von Optimierungen und gehe in Stufen immer weiter, um zu sehen was man insgesamt erreichen kann.

Zusätzlich das Spiel auf 8 Threads zu begrenzen und die Grafikdetails zu optimieren, bringt den 5700X auf 55,7 FPS.

Eine riesige Steigerung, wenn man bedenkt, dass mit den Bios Defaults nur 30,5 drin waren.

Wer die sonstigen Grafikoptionen nicht absenken möchte, aber einen besseren Überblick bei Wimmelbildaufgaben haben möchte, kann den Wuselfaktor auf niedrig anpassen und damit 1-3% mehr Leistung dazu bekommen.

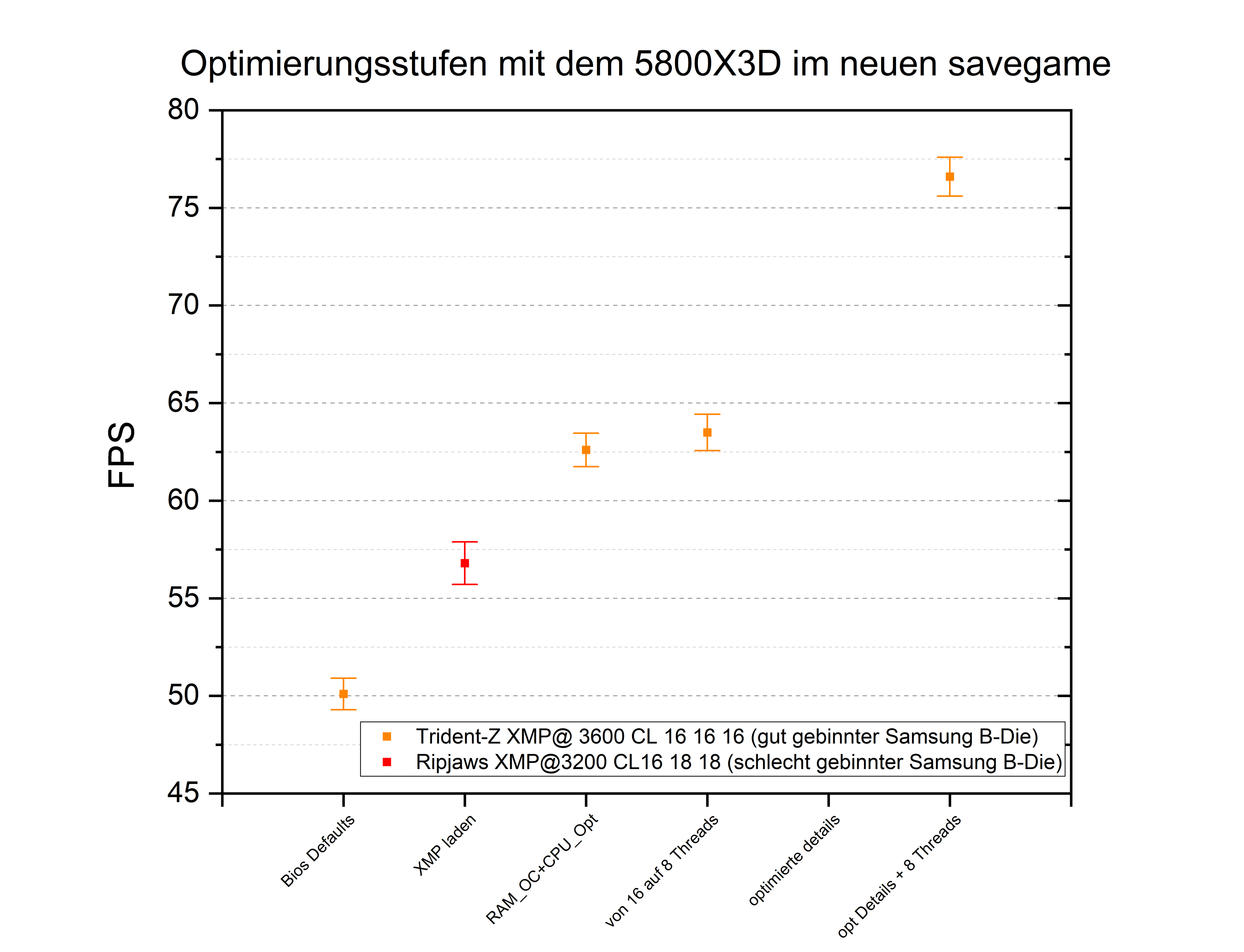

Die Möglichkeiten sind in der Tat eingeschränkter als beim 5700X. So kann der Boost nicht gesteigert werden und durch größere L3 Cache ist die CPU nicht ganz so von der Ramgeschwindigkeit abhängig.

Unabhängig macht das den 5800X3D aber bei weitem nicht und schon das XMP Profil des günstigen RipJaw-kits bringt 13,4% Steigerung der FPS und sogar 17% bei den 1% low Frametimes.

Das Trident-Z Kit auf 3800 Cl16 16 zu optimieren bringt in Verbindung mit dem CoreOptimizer auf -30 eine Steigerung von ca 27%.

Voll optimiert erreicht der X3D damit fast 77 FPS, was das Spiel trotz des fortgeschrittenen Spielverlaufs angenehm spielbar hält.

Doch auch ohne jegliche Optimierung waren die 50 FPS durchaus gut.

Ob man diese Erfolge als viel oder wenig Optimierungspotential ansieht ist natürlich subjektiv.

Ich sehe es so mittel.

Ich nehme die Erfolge der Optimierungen gerne mit und erhalte noch mehr Leistung.

Aber wer an dem Optimieren selbst keinen Spaß hat, der sollte nur XMP installieren und gerne auch mal die optimierten Grafikeinstellungen probieren.

Edit:

Edit: Ich habe nochmal Ladezeiten mit dem PC der Freundin getestet und dabei auch einmal Neuladen nach Ablauf meines Benchmarkskriptes getestet.

Ihr Rechner ist auf den täglichen Einsatz optimiert und hat im Moment einen Ryzen 3950X mit deaktiviertem SMT und PPT bei 105W. Es sind 64 GB verbaut, die mit 3200 Cl14 18 laufen und eine Vega64, bei der die GPU undervolted ist und der HBM2 ist leicht übertaktet.

Der initiale Ladevorgang hat ca. 72 Sekunden gedauert und damit ein gutes Stück langsamer als mit dem 5700X oder 5800X3D.

Das Neuladen hat dann mit 78 Sekunden nur etwas länger gedauert und nach Ablauf der 2h Benchmarkskript lag ein Neuladen bei fast 99 Sekunden.

Der 3950X boostet meist auf 4225 MHz, und beim Ladevorgang auch machmal etwas höher Richtung 4,4 GHz. Er ist also auch bei mehr Takt als der 5700X@3,9 GHz langsamer.

Ist ausreichend RAM vorhanden, beschleunigt nur eine schnellere CPU den Ladevorgang deutlich und hier kommt es vor allem auf CPU-Takt/CPU-Architektur und nicht auf Cache oder RAM an.

Mein Spielstand benutzt zwar alles was es im Spiel zu tun gibt aus und hat daher eine hohe Anforderung an die Hardware, aber es ist kein Rekordbau Spielstand mit Inseln voller Hochhäuser.

Wie sich das im Vergleich auswirkt, hatte ich in der Komentarspalte diskutiert und gemessen.

Die großen Überraschungen sind ausgeblieben.

Der weitergespielte Spielstand mit den zusätzlichen DLCs läuft wie erwartet etwas langsamer.

Der benötigte RAM und die CPU Rohleistung sind etwas gestiegen und so sind 32 GB RAM noch wichtiger und bei 4 CPU Kernen werden die zusätzlichen virtuellen Threads durch SMT sinnvoll.

Schneller RAM hilft weiterhin deutlich und zusammen mit anderen Optimierungen kann man den Ryzen 5700X auf ein angenehmes Niveau heben und der Ryzen 5800X3D braucht eigentlich keine Hilfe, kann aber auch von Optimierungen profitieren.

Ein kurzer Blick auf die Ladezeiten hat ergeben, dass fast nur die CPU Geschwindigkeit zählt und das ein Nachladen aus dem Spiel heraus länger dauert, als der initiale Ladevorgang.

Positiv für mich ist, dass der Skript-Benchmark jetzt wieder mit dem neuen UserInterface funktioniert und die Messungen gut zu den bisherigen Ergebnissen passen.

Also weiter zu dem umfassenderen Fazit des ganzen Artikels.

<- Vorheriger Thread(Optimierung/Einfluss der Grafik) --Übersicht-- nächster Thread(Zusammenfassung und Fazit) ->

Der Hauptthread mit den Inhaltsverzeichnis bietet Erläuterungen die vorher gelesen werden sollten.

Update! mit neuen DLCs und fortgeschrittenem Spielstand

Edit: Es gibt ein Update mit den Messwerten eines Ryzen 5600G in Beitrag #4 ...für alle die wissen wollen wie Zen3 mit weniger Cache reagiert und wie sich eine iGPU schlägt.Es ist viel Zeit vergangen, nachdem ich die ursprünglichen Messungen gemacht hatte und damals fehlten dem Spielstand den ich getestet hatte noch die letzten drei großen DLCs aus 2022(Hacienda, Luftschiffe/Post und größere Neue Welt+Artistas).

Diese habe ich inzwischen soweit bespielt, dass alles freigeschaltet und benutzt wird. Es ist aber noch längst nicht überall integriert. Das wird bei mir aber auch nicht mehr passieren und ich bin damit zufrieden.

Ich habe mir, bis auf das Flottendekor, auch die Schönbau-DLCs gekauft und ebenfalls alles irgendwo platziert.

Das alte Skript funktionierte nach dem Update des UIs nicht mehr und es musste natürlich auch die erweiterte Neue Welt und die neuen Inhalte im Benchmark berücksichtigt werden.

Also wurde das Skript an die neue Situation angepasst. Die Vorbereitungsmessung und die Zwischensequenz wurden etwas länger um die neuen Inhalte in den Speicher zu laden.

Die Benchmarksequenz bleibt, für eine bessere Vergleichbarkeit, in Dauer und Zusammensetzung gleich.

In der neuen Welt ist jetzt jedoch die neue Rieseninsel der Ersatz für meine alte Hauptinsel und einige Szenen sind angepasst worden.

Bei der Schiffsansammlung in der neuen Welt schweben noch zusätzlich die neuen Luftschiffe rum. In der Arktis gibt es mehr Luftschiffe im Nebel und es sind insgesamt mehr Schiffsrouten und Luftschiffrouten unterwegs.

Einige Produktionen sind etwas angepasst und sollten jetzt eine bessere Vollversorgung erreichen.

Es klingt nicht nach viel, aber das Bugfixing hat eine Weile gedauert, da durch leicht geänderte Menügrößen, herumfliegende Luftschiffe und andere Kleinigkeiten seltene Skriptfehler aufgetreten sind.

Da ich vorher teilweise in ein partielles GPU Limit gelaufen bin, habe ich nun im Spiel FSR auf der "ausgewogen" Stufe aktiviert um die GPU weitestgehend als Einflussfaktor zu eliminieren. Nun gab es höchstens einzelne Messungen mit 1% an GPU Limit laut CapFrameX.

Ich habe mir, bis auf das Flottendekor, auch die Schönbau-DLCs gekauft und ebenfalls alles irgendwo platziert.

Das alte Skript funktionierte nach dem Update des UIs nicht mehr und es musste natürlich auch die erweiterte Neue Welt und die neuen Inhalte im Benchmark berücksichtigt werden.

Also wurde das Skript an die neue Situation angepasst. Die Vorbereitungsmessung und die Zwischensequenz wurden etwas länger um die neuen Inhalte in den Speicher zu laden.

Die Benchmarksequenz bleibt, für eine bessere Vergleichbarkeit, in Dauer und Zusammensetzung gleich.

In der neuen Welt ist jetzt jedoch die neue Rieseninsel der Ersatz für meine alte Hauptinsel und einige Szenen sind angepasst worden.

Bei der Schiffsansammlung in der neuen Welt schweben noch zusätzlich die neuen Luftschiffe rum. In der Arktis gibt es mehr Luftschiffe im Nebel und es sind insgesamt mehr Schiffsrouten und Luftschiffrouten unterwegs.

Einige Produktionen sind etwas angepasst und sollten jetzt eine bessere Vollversorgung erreichen.

Es klingt nicht nach viel, aber das Bugfixing hat eine Weile gedauert, da durch leicht geänderte Menügrößen, herumfliegende Luftschiffe und andere Kleinigkeiten seltene Skriptfehler aufgetreten sind.

Da ich vorher teilweise in ein partielles GPU Limit gelaufen bin, habe ich nun im Spiel FSR auf der "ausgewogen" Stufe aktiviert um die GPU weitestgehend als Einflussfaktor zu eliminieren. Nun gab es höchstens einzelne Messungen mit 1% an GPU Limit laut CapFrameX.

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

Vergleich von meinem alten Savegame zu dem Neuen mit den zusätzlichen DLCs

Es mag etwas unübersichtlich sein, aber je zwei Einträge entsprechen der gleichen Hardware Konfiguration mit dem alten bzw. neuen Savegames.

Um die Veränderngen besser sehen zu können habe ich die prozentualen Unterschiede aufgetragen:

Negative Werte bedeuten, dass das alte savegame wie erwartet schneller lief.

Bei den 0,1% low Frametimes hat es meist keine eindeutige Änderung gegeben, mit Ausnahme der Messungen mit dem 5800X3D, wo sich die 0,1% low Frametimes sogar verbessert haben und den 16GB RAM, bei denen sich die Werte besonders verschlechtert haben. Ein Anzeichen für einen gestiegenen RAM-Bedarf.

Wie ändert sich der Abstand zwischen 5700X und 5800X3D mit dem neuen Savegame?

Sowohl Stock als auch mit festgesetztem CPU Takt deklassiert der 5800X3D den 5700X

47% mehr FPS bringen ihn auf fast 60 FPS, wo sich der 5700X mit spielbaren, aber spürbar schlechteren 40 FPS präsentiert.

Das ist nochmal eine Steigerung zu den 39% die der X3D im alten Spielstand vorne lag....damals war der X3D jedoch auch durch ein einsetzendes GPU Limit begrenzt.

Bei den 1% low Frametimes war der Unterschied damals 18,3% und nun 23,6%.

Es scheint nicht so, als würde der Vorteil dem L3 Cache mit mehr Spielinhalt sinken, sondern eher steigen.

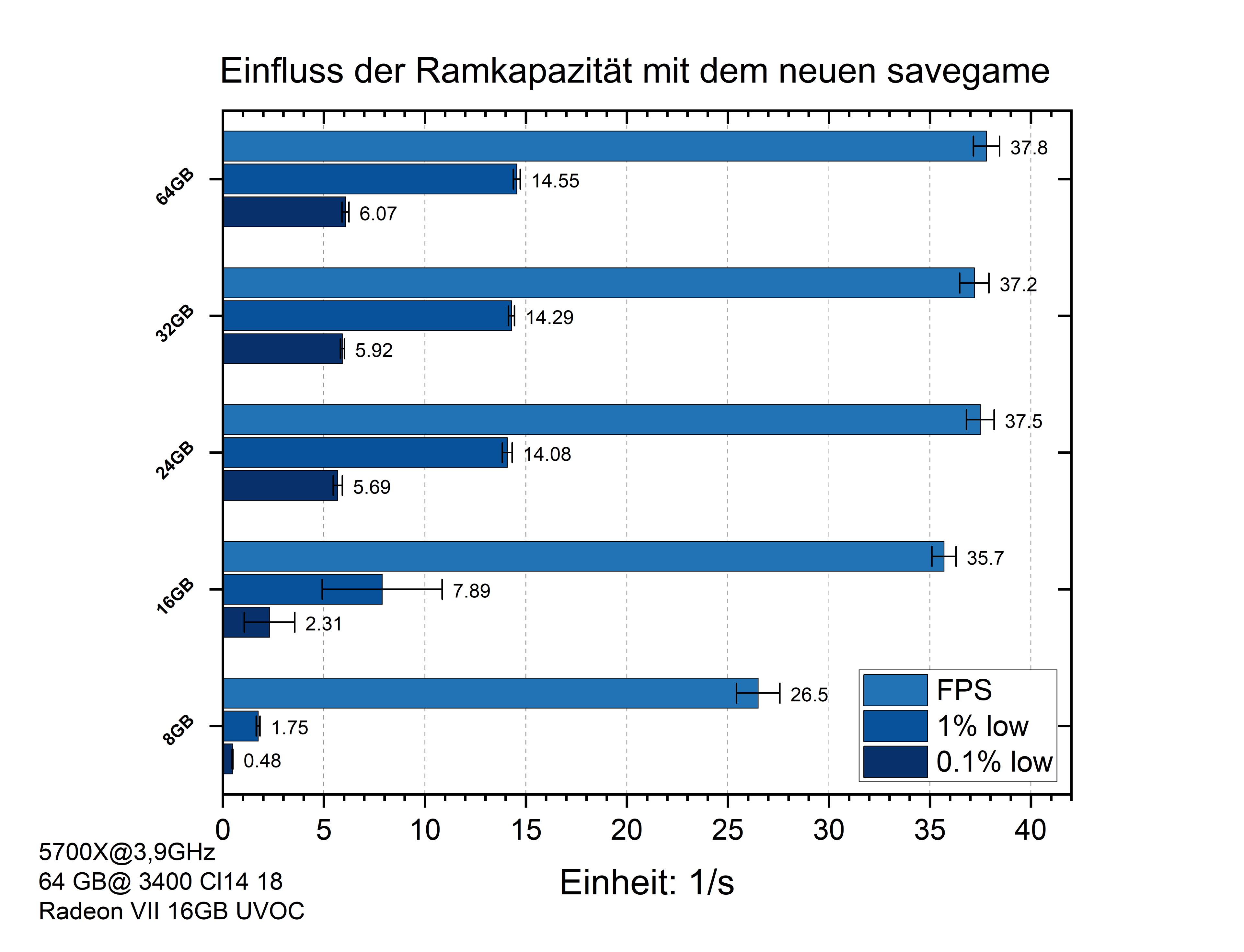

Hat sich die Menge an sinnvollem RAM geändert?

Mit den neuen savegame hat sich die neue Welt vergrößert und die zusätzlichen DLCs benötigen ebenfalls mehr Speicher.

Mit dem alten Spielstand hatte sich herausgestellt, dass 32 GB RAM voll gemacht werden und im Laufe des 2h Skriptverlaufes auch ca. drei statt einem GB(bei 48 oder 64 GB RAM) an Daten auf das Systemlaufwerk geschrieben werden.

Einen negativen Einfluss auf die Leistung hatte das jedoch nicht und 32 GB waren völlig ausreichend.

Selbst 24 GB RAM waren kaum messbar schlechter.

Mit 16 oder gar 8 GB musste man aber deutliche Nachteile erwarten.

Nun mit dem neuen savegame:

Wie man sieht beginnen nun 32 und vor allem 24 GB RAM, minimale Leistungseinbußen zu zeigen.

Ich würde sie immer noch als gut ausreichend bezeichnen, aber es ist ein Abwärtstrend zu erkennen.

Vergleiche ich die RAM-Belegung von dem altem mit dem neuem Savegame, dann stieg die Belegung von 33,5 +-0,4 GB auf 35,2 +- 0,4 GB an.

Wie schon mit dem alten savegamezeigt sich ein deutlich größerer Leistungs Unterschied 16 GB RAM, der minimal stärker ausgeprägt ist und nun auch die FPS und nicht nur die Frametimes sinken lässt.

8GB RAM sind spielerisch schier nicht zu ertragen und sollten absolut vermieden werden....das war aber auch schon vorher so.

Einen negativen Einfluss auf die Leistung hatte das jedoch nicht und 32 GB waren völlig ausreichend.

Selbst 24 GB RAM waren kaum messbar schlechter.

Mit 16 oder gar 8 GB musste man aber deutliche Nachteile erwarten.

Nun mit dem neuen savegame:

Wie man sieht beginnen nun 32 und vor allem 24 GB RAM, minimale Leistungseinbußen zu zeigen.

Ich würde sie immer noch als gut ausreichend bezeichnen, aber es ist ein Abwärtstrend zu erkennen.

Vergleiche ich die RAM-Belegung von dem altem mit dem neuem Savegame, dann stieg die Belegung von 33,5 +-0,4 GB auf 35,2 +- 0,4 GB an.

Wie schon mit dem alten savegamezeigt sich ein deutlich größerer Leistungs Unterschied 16 GB RAM, der minimal stärker ausgeprägt ist und nun auch die FPS und nicht nur die Frametimes sinken lässt.

8GB RAM sind spielerisch schier nicht zu ertragen und sollten absolut vermieden werden....das war aber auch schon vorher so.

Kann man den Leistungsverlust mit 16 GB RAM durch optimierte Grafiksettings negieren?

Schaut man sich die Leistungssteigerung durch den Wechsel von den maximalen zu den optimierten Details an, sieht man, dass die Vorteile bei 16 GB viel stärker ausgeprägt sind.

Mit 64 GB RAM lassen sich vor allem die FPS und damit der Input-Lag verbessern und die Ruckler werden weniger verbessert.

Mit 16 GB RAM profitieren die FPS zwar stärker, aber die großen Vorteile liegen bei den Frametimes die massiv profitieren.

Schaut man sich die FPS an, sieht man dass es mit den optimierten Details keinen Unterschied gibt, aber mit den maximalen Details sind die 16GB zu wenig und die FPS sinken um 5,5%.

Bei den Frametimes haben die 16 GB trotz den optimierten Details starke Einbußen. Diese Einbußen sind aber weniger ausgeprägt.

So sinken die 1% low Frametimes mit den maximalen Details um ganze 55% und mit optimierten nur um 15%.

Haben die gestiegenen Anforderungen einen Einfluss auf die Bewertung zu den benötigten CPU Kernen und SMT?

Wie schon mit dem alten Savegame sind die Leistungsverluste durch weniger CPU Kerne gering, solange es mindestens 4 sind.

Von 8 auf 6 Kerne bei aktivem SMT sind es nun 3 statt 2% weniger FPS.

Auf 4 Kerne mit SMT sind es nun 7,7 statt 6,6% weniger FPS.

Der deutliche Unterschied liegt bei 4 Kernen und deaktiviertem SMT.

Mit dem alten savegame war es nicht nur mit mehr Kernen, sondern auch mit 4 Kernen besser SMT deaktivert zu lassen.

Mit dem neuen savegame dreht sich das Bild hier und es gehen 8% Leistung verloren.

Bei meinen Tests hat sich die CPU Auslastung nicht stark erhöht und liegt jetzt mit 16 Threads bei durchschnittlich 29 statt 27%.

Dieser kleine Unterschied scheint jetzt aber bei 4 Kernen kritisch zu werden und die virtuellen Threads bieten nun einen Vorteil anstelle eines Nachteils.

Welche Erfolge kann man mit dem verketten von Optimierungen erreichen?

Ich habe in den vorherigen Tests den wissenschaftlicheren Ansatz gewählt und habe jeden Aspekt einzeln betrachtet und dabei andere Faktoren möglichst gut eliminiert/festgesetzt.

Hier teste ich einen realitätsnäheren Ansatz von Optimierungen und gehe in Stufen immer weiter, um zu sehen was man insgesamt erreichen kann.

Von Default BIOS und maximalen Details, über das einfache aktivieren von XMP(drei verschiedene Kits) zu RAM und CPU Optimierung, hin zu dem deaktivieren von virtuellen Threads und dem anpassen der Grafikeinstellungen.

Mit BIOS Defaults ziegt das RAM-Kit der Ballistix Sport etwas vorne, da hier das JEDEC Profil mit 2400 MT/s zu werke geht und die des Trident-Z und des Ripjaw Kits mit 2133 auskommen müssen.

Ist XMP dann aktiviert ordnen sich die Kits entsprechend ihrer XMP Profile ein. Aus den 3000 Cl15 16 16 werden 16 16 16, da der aktivierte GearDownMode eine gerade CAS latency erzwingt.

Neben der maximal möglichen Optimierung der RAM-Kits wurde im nächsten Schritt auch die CPU optimiert.

Für den 5700X wurden dabei über den CoreOptimizer alle Kerne auf den maximalen Wert von -30 gesetzt, das Powerlimit wurde erhöht und der CPU-Boost um +200MHz angehoben.

Man erkennt eine deutliche Steigerung auf 42,6 FPS mit den Ripjaws, 43,3 FPS mit den Ballistix Sport und 45,6 FPS mit dem Trident-Z Kit.

Bei dem Ballistix Sport mit Micron-E Chips wäre es eventuell noch möglich gewesen, mehr herauszuholen aber ich habe mich auf maximal 1,45V beschränkt. Auch mit 1,5V wäre das gute Samsung B-Die Kit besser gewesen.

Mit BIOS Defaults ziegt das RAM-Kit der Ballistix Sport etwas vorne, da hier das JEDEC Profil mit 2400 MT/s zu werke geht und die des Trident-Z und des Ripjaw Kits mit 2133 auskommen müssen.

Ist XMP dann aktiviert ordnen sich die Kits entsprechend ihrer XMP Profile ein. Aus den 3000 Cl15 16 16 werden 16 16 16, da der aktivierte GearDownMode eine gerade CAS latency erzwingt.

Neben der maximal möglichen Optimierung der RAM-Kits wurde im nächsten Schritt auch die CPU optimiert.

Für den 5700X wurden dabei über den CoreOptimizer alle Kerne auf den maximalen Wert von -30 gesetzt, das Powerlimit wurde erhöht und der CPU-Boost um +200MHz angehoben.

Man erkennt eine deutliche Steigerung auf 42,6 FPS mit den Ripjaws, 43,3 FPS mit den Ballistix Sport und 45,6 FPS mit dem Trident-Z Kit.

Bei dem Ballistix Sport mit Micron-E Chips wäre es eventuell noch möglich gewesen, mehr herauszuholen aber ich habe mich auf maximal 1,45V beschränkt. Auch mit 1,5V wäre das gute Samsung B-Die Kit besser gewesen.

Eine riesige Steigerung, wenn man bedenkt, dass mit den Bios Defaults nur 30,5 drin waren.

Wer die sonstigen Grafikoptionen nicht absenken möchte, aber einen besseren Überblick bei Wimmelbildaufgaben haben möchte, kann den Wuselfaktor auf niedrig anpassen und damit 1-3% mehr Leistung dazu bekommen.

Dem Ryzen 5800X3D wird wenig Potential bei der Optimierung nachgesagt....zu Recht?

Die Möglichkeiten sind in der Tat eingeschränkter als beim 5700X. So kann der Boost nicht gesteigert werden und durch größere L3 Cache ist die CPU nicht ganz so von der Ramgeschwindigkeit abhängig.

Unabhängig macht das den 5800X3D aber bei weitem nicht und schon das XMP Profil des günstigen RipJaw-kits bringt 13,4% Steigerung der FPS und sogar 17% bei den 1% low Frametimes.

Das Trident-Z Kit auf 3800 Cl16 16 zu optimieren bringt in Verbindung mit dem CoreOptimizer auf -30 eine Steigerung von ca 27%.

Voll optimiert erreicht der X3D damit fast 77 FPS, was das Spiel trotz des fortgeschrittenen Spielverlaufs angenehm spielbar hält.

Doch auch ohne jegliche Optimierung waren die 50 FPS durchaus gut.

Ob man diese Erfolge als viel oder wenig Optimierungspotential ansieht ist natürlich subjektiv.

Ich sehe es so mittel.

Ich nehme die Erfolge der Optimierungen gerne mit und erhalte noch mehr Leistung.

Aber wer an dem Optimieren selbst keinen Spaß hat, der sollte nur XMP installieren und gerne auch mal die optimierten Grafikeinstellungen probieren.

Edit:

Ihr Rechner ist auf den täglichen Einsatz optimiert und hat im Moment einen Ryzen 3950X mit deaktiviertem SMT und PPT bei 105W. Es sind 64 GB verbaut, die mit 3200 Cl14 18 laufen und eine Vega64, bei der die GPU undervolted ist und der HBM2 ist leicht übertaktet.

Für die Vergleichbarkeit mit den Messungen an 5700X und 5800X3D, wo ich FSR benutzt habe um ein einsetzendes GPU Limit zu kontern, wurde auch hier FSR benutzt.

Mit den Details für maximale CPU Auslastung kommt das System nur auf:

FPS = 33,8 +-0,5

1% lows = 13,3 +- 0,2

0,1% lows = 5,06 +- 0,1

Damit ist das System zwar schneller als der 5700X mit Bios Defaults(JEDEC RAM), aber ein Stück langsamer als der 5700X mit verschiedenen XMP Profilen.

Um die GPUs aus dem CPU/RAM Vergleich herauszuhalten hatte ich für die neuen Messungen FSR benutzt. Um zu sehen wie groß der Einfluss ist, habe ich die Messreihe nochmal mit nativer Auflösung wiederholt:

FPS = 34,6 +-0,5

1% lows = 13,3 +- 0,1

0,1% lows = 4,78 +- 0,1

Der Einfluss ist sehr gering. Die FPS liegennahe zusammen und sind mit der nativen Auflösung sogar höher

Die 0,1% low Frametimes werden scheinbar leicht schlechter.

Ich habe die Messungen noch einmal wiederholt um das zu verifizieren und es hat sich bestätigt.

Meiner Logik nach hätte sich ein umgedrehtes Bild ergeben müssen, da sich anhand der GPU Auslastung zeigt, dass diese eher bei den hohen FPS hoch geht und eher die FPS limitert und die 0,1% low Frametimes immer von der CPU limitiert sind und daher gleich bleiben müssten.

Eventuell ist es ein ähniches Verhalten wie es von @zogger CkY mit DLSS in seinem Leserartikel beobachtet wurde.

Da findet er heraus, dass DLSS auch mehr Arbeit für die CPU ist und es daher im CPU Limit eine schlechtere Leistung geben kann, wenn die upscaling Technik angewendet wird.

Ich habe mir die durchschnittliche CPU Auslastung aus den CapFrameX Sensordaten angeguckt und kann bei Anno keinen Unterschied zwischen FSR und kein FSR finden.

Das muss aber nicht unbedingt etwas heißen, da Anno einfach nicht mehr CPU Threads ausnutzen kann und so kann es sein, dass FSR mehr Arbeit erzeugt, die sich aber nicht in einer höhere Auslastung zeigen kann.

Die durchschnittliche GPU Auslastung lag laut CapFrameX ohne FSR bei 39-40% und mit FSR bei 28-29%.

Wechselt man auf die optimierten Details steigert sich die Leistung spürbar und so spielt meine Freundin das Spiel auch:

FPS = 39,8 +-0,3

1% lows = 15,8 +- 0,2

0,1% lows = 6,19 +- 0,06

Bios Defaults oder OC werde ich mit diesem System nicht testen, da das MSI Bios(Carbon gaming wifi) mich in den Wahnsinn treibt und erstmal aus Prinzip kein gespeichertes Profil akzeptiert oder es nicht komplett anwendet....dann die ewige Wartezeit nach jedem Zurücksetzen usw.... dafür habe ich einfach keine Nerven mehr übrig.

Für die Vergleichbarkeit mit den Messungen an 5700X und 5800X3D, wo ich FSR benutzt habe um ein einsetzendes GPU Limit zu kontern, wurde auch hier FSR benutzt.

Mit den Details für maximale CPU Auslastung kommt das System nur auf:

FPS = 33,8 +-0,5

1% lows = 13,3 +- 0,2

0,1% lows = 5,06 +- 0,1

Damit ist das System zwar schneller als der 5700X mit Bios Defaults(JEDEC RAM), aber ein Stück langsamer als der 5700X mit verschiedenen XMP Profilen.

Um die GPUs aus dem CPU/RAM Vergleich herauszuhalten hatte ich für die neuen Messungen FSR benutzt. Um zu sehen wie groß der Einfluss ist, habe ich die Messreihe nochmal mit nativer Auflösung wiederholt:

FPS = 34,6 +-0,5

1% lows = 13,3 +- 0,1

0,1% lows = 4,78 +- 0,1

Der Einfluss ist sehr gering. Die FPS liegennahe zusammen und sind mit der nativen Auflösung sogar höher

Die 0,1% low Frametimes werden scheinbar leicht schlechter.

Ich habe die Messungen noch einmal wiederholt um das zu verifizieren und es hat sich bestätigt.

Meiner Logik nach hätte sich ein umgedrehtes Bild ergeben müssen, da sich anhand der GPU Auslastung zeigt, dass diese eher bei den hohen FPS hoch geht und eher die FPS limitert und die 0,1% low Frametimes immer von der CPU limitiert sind und daher gleich bleiben müssten.

Eventuell ist es ein ähniches Verhalten wie es von @zogger CkY mit DLSS in seinem Leserartikel beobachtet wurde.

Da findet er heraus, dass DLSS auch mehr Arbeit für die CPU ist und es daher im CPU Limit eine schlechtere Leistung geben kann, wenn die upscaling Technik angewendet wird.

Ich habe mir die durchschnittliche CPU Auslastung aus den CapFrameX Sensordaten angeguckt und kann bei Anno keinen Unterschied zwischen FSR und kein FSR finden.

Das muss aber nicht unbedingt etwas heißen, da Anno einfach nicht mehr CPU Threads ausnutzen kann und so kann es sein, dass FSR mehr Arbeit erzeugt, die sich aber nicht in einer höhere Auslastung zeigen kann.

Die durchschnittliche GPU Auslastung lag laut CapFrameX ohne FSR bei 39-40% und mit FSR bei 28-29%.

Wechselt man auf die optimierten Details steigert sich die Leistung spürbar und so spielt meine Freundin das Spiel auch:

FPS = 39,8 +-0,3

1% lows = 15,8 +- 0,2

0,1% lows = 6,19 +- 0,06

Bios Defaults oder OC werde ich mit diesem System nicht testen, da das MSI Bios(Carbon gaming wifi) mich in den Wahnsinn treibt und erstmal aus Prinzip kein gespeichertes Profil akzeptiert oder es nicht komplett anwendet....dann die ewige Wartezeit nach jedem Zurücksetzen usw.... dafür habe ich einfach keine Nerven mehr übrig.

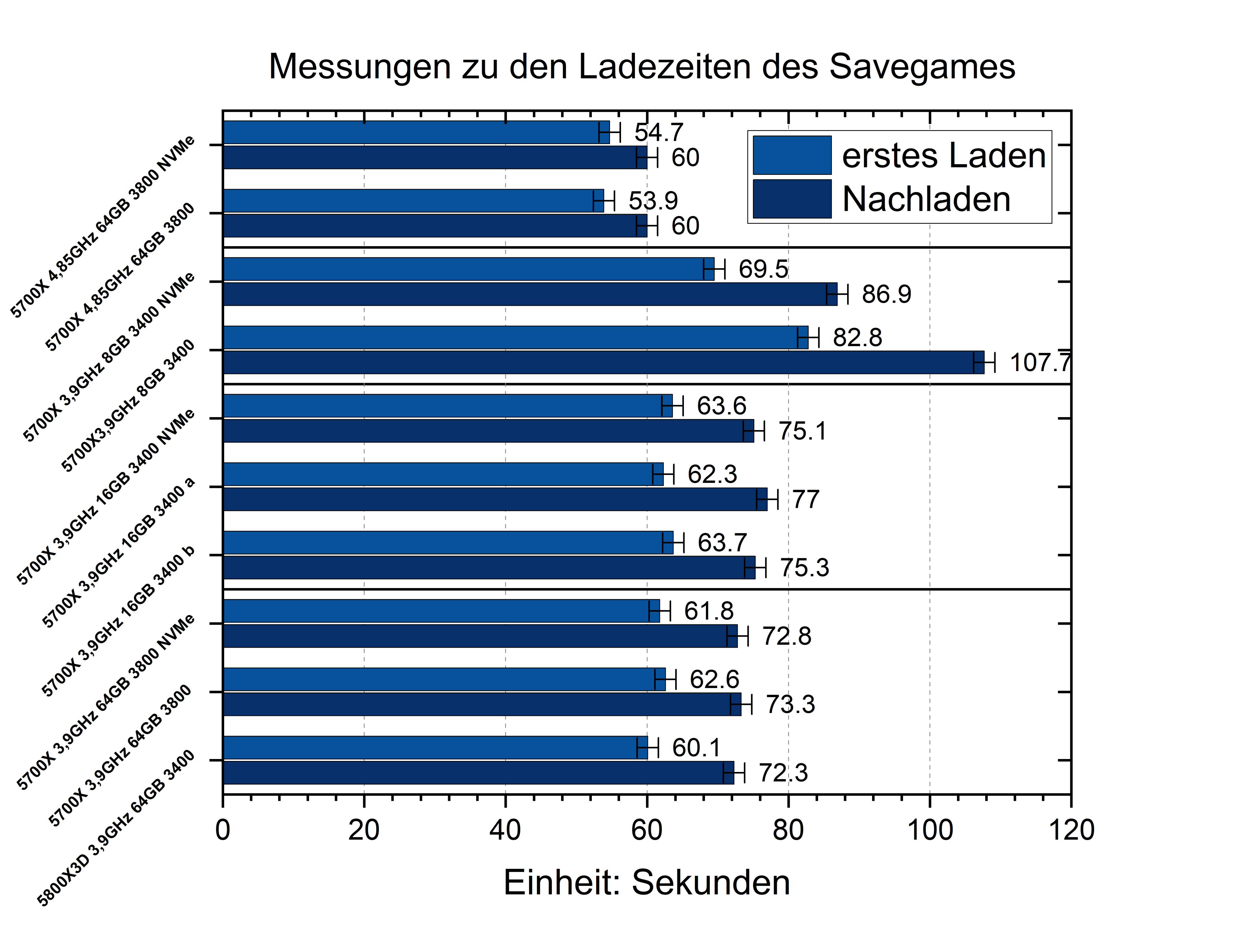

Ladezeiten

In den Kommentaren wurde ich nach Messungen zu den Ladezeiten gefragt und hier sind einige.Da ich diese mit der Hand stoppen musste und ich wenig Lust habe weitere dutzende Male auf den Ladebalken zu starren um den richtigen Moment nicht zu verpassen, habe ich hier auf das Mitteln von mehreren Messungen verzichtet und nehme einfach ein großzügiges Fehlerintervall von 1,5 Sekunden an. Die gleiche Messung nach einem Neustart zu wiederholen hat teilweise über eine Sekunde Unterschied gemacht und daher darf man hier nicht zu viel in kleine Unterschiede hineininterpretieren.

Gemessen wird dabei einmal die Zeit für den Ladevorgang meines neuen Benchmark-Savegames nach einem PC Neustart.

Und direkt danach lade ich den Spielstand aus dem Spiel heraus erneut, um zu simulieren wie es sich verhält wenn man z.B. eine Fehlentscheidung rückgängig machen möchte.

Ich habe horizontale Linien eingefügt, um die Werte in Blöcke zu unterteilen auf die ich mich beziehen kann.

Wie man beim Vergleich von Block 3 und 4 sieht ist der Unterschied von 16 zu 64 GB RAM im Bereich der Messungenauigkeit für den ersten Ladevorgang.

Auch wenn Betriebssystem und Spiel auf NVMe SSDs statt Sata liegen ändert sich das Ergebnis nicht.

Die besseren RAM Einstellungen mit OC auf 3800 MT/s könnten einen minimalen Vorteil bieten, jedoch erlaubt die Reproduzierbarkeit hier keine gesicherte Aussage.

Was einen deutlichen Einfluss hat, ist der CPU Takt. Die Messungen aus dem ersten Block wurden mit einem um 200MHz erhöhten Boost und einem negativen Spannungsoffset durch den CoreOptimizer durchgeführt.

24% mehr CPU Takt zeigen ca. 13% kürzere Ladezeiten für den ersten Ladevorgang.

Nur 8 GB RAM im Block 2 zeigen einen deutlichen Unterschied zwischen Sata und NVMe SSDs. Hier verlängert sich der Ladevorgang gegenüber 16 GB mit NVMe um 9%, aber mit Sata SSDs um ganze 30%.

Der zusätzliche L3 Cache des 5800X3D in Block 4 führt nicht zu spürbar besseren Ladezeiten und es sind höchstens 2 Sekunden Vorteil, die aber auch zur Messunsicherheit gehören können.

In Block 3 gibt es dazu zwei gleiche Messungen und man sieht an dem Unterschied, dass die Reproduzierbarkeit besser sein könnte.

Nicht in der Liste aufgeführt ist noch eine Messung mit meinen optimierte Grafikeinstellungen und 64 GB RAM.

Entgegen meiner Erwartungen hat dies den Ladevorgang nicht messbar verbessert.

Ich wollte noch eine Messung mit meinen optimierte Grafikeinstellungen und 8/16 GB RAM durchführen, aber leider hat Ubisoft mir ab hier für jede Hardwareänderung viele Stunden lang den Zugriff aufs Spiel blockiert und ich musste meine Hardware Anpassungen sorgsam auswählen.

Ich hätte erwartet, dass der Ladevorgang zumindest bei zu wenig RAM durch die Grafikoptionen beeinflusst wäre, aber das hatte ich auch schon für die 64 GB erwartet.

Im Schnitt ganze 19%, wobei es mit hohem CPU Takt nur ca. 10% sind, mit 16 bis 64 GB RAM ca. 17-18% und mit 8 GB RAM 25%(Nvme) und 30%(SATA).

Gemessen wird dabei einmal die Zeit für den Ladevorgang meines neuen Benchmark-Savegames nach einem PC Neustart.

Und direkt danach lade ich den Spielstand aus dem Spiel heraus erneut, um zu simulieren wie es sich verhält wenn man z.B. eine Fehlentscheidung rückgängig machen möchte.

Der initiale Ladevorgang

Ich habe horizontale Linien eingefügt, um die Werte in Blöcke zu unterteilen auf die ich mich beziehen kann.

Wie man beim Vergleich von Block 3 und 4 sieht ist der Unterschied von 16 zu 64 GB RAM im Bereich der Messungenauigkeit für den ersten Ladevorgang.

Auch wenn Betriebssystem und Spiel auf NVMe SSDs statt Sata liegen ändert sich das Ergebnis nicht.

Die besseren RAM Einstellungen mit OC auf 3800 MT/s könnten einen minimalen Vorteil bieten, jedoch erlaubt die Reproduzierbarkeit hier keine gesicherte Aussage.

Was einen deutlichen Einfluss hat, ist der CPU Takt. Die Messungen aus dem ersten Block wurden mit einem um 200MHz erhöhten Boost und einem negativen Spannungsoffset durch den CoreOptimizer durchgeführt.

24% mehr CPU Takt zeigen ca. 13% kürzere Ladezeiten für den ersten Ladevorgang.

Nur 8 GB RAM im Block 2 zeigen einen deutlichen Unterschied zwischen Sata und NVMe SSDs. Hier verlängert sich der Ladevorgang gegenüber 16 GB mit NVMe um 9%, aber mit Sata SSDs um ganze 30%.

Der zusätzliche L3 Cache des 5800X3D in Block 4 führt nicht zu spürbar besseren Ladezeiten und es sind höchstens 2 Sekunden Vorteil, die aber auch zur Messunsicherheit gehören können.

In Block 3 gibt es dazu zwei gleiche Messungen und man sieht an dem Unterschied, dass die Reproduzierbarkeit besser sein könnte.

Nicht in der Liste aufgeführt ist noch eine Messung mit meinen optimierte Grafikeinstellungen und 64 GB RAM.

Entgegen meiner Erwartungen hat dies den Ladevorgang nicht messbar verbessert.

Ich wollte noch eine Messung mit meinen optimierte Grafikeinstellungen und 8/16 GB RAM durchführen, aber leider hat Ubisoft mir ab hier für jede Hardwareänderung viele Stunden lang den Zugriff aufs Spiel blockiert und ich musste meine Hardware Anpassungen sorgsam auswählen.

Ich hätte erwartet, dass der Ladevorgang zumindest bei zu wenig RAM durch die Grafikoptionen beeinflusst wäre, aber das hatte ich auch schon für die 64 GB erwartet.

Der zweite Ladevorgang aus dem Spielen heraus

Hier dauert der Ladevorgang sogar länger als der erste, was für mich überraschend war.Im Schnitt ganze 19%, wobei es mit hohem CPU Takt nur ca. 10% sind, mit 16 bis 64 GB RAM ca. 17-18% und mit 8 GB RAM 25%(Nvme) und 30%(SATA).

Ihr Rechner ist auf den täglichen Einsatz optimiert und hat im Moment einen Ryzen 3950X mit deaktiviertem SMT und PPT bei 105W. Es sind 64 GB verbaut, die mit 3200 Cl14 18 laufen und eine Vega64, bei der die GPU undervolted ist und der HBM2 ist leicht übertaktet.

Der initiale Ladevorgang hat ca. 72 Sekunden gedauert und damit ein gutes Stück langsamer als mit dem 5700X oder 5800X3D.

Das Neuladen hat dann mit 78 Sekunden nur etwas länger gedauert und nach Ablauf der 2h Benchmarkskript lag ein Neuladen bei fast 99 Sekunden.

Der 3950X boostet meist auf 4225 MHz, und beim Ladevorgang auch machmal etwas höher Richtung 4,4 GHz. Er ist also auch bei mehr Takt als der 5700X@3,9 GHz langsamer.

Fazit zu den Ladezeiten

So wie ich diese Daten interpretiere, limitiert bei den Ladevorgängen nicht die Lesegeschwindigkeit der Laufwerks, welches die Spieledateien beherbergt und der Ladevorgang wird nur dann von dem Systemlaufwerk beeinflusst, wenn unter 16 GB RAM verbaut sind und wenn daher schon während des Ladevorgangs die Auslagerungsdatei verwendet werden muss.Ist ausreichend RAM vorhanden, beschleunigt nur eine schnellere CPU den Ladevorgang deutlich und hier kommt es vor allem auf CPU-Takt/CPU-Architektur und nicht auf Cache oder RAM an.

Zusammenfassung: 10 Millionen Einwohner Spielstand

Mein Spielstand benutzt zwar alles was es im Spiel zu tun gibt aus und hat daher eine hohe Anforderung an die Hardware, aber es ist kein Rekordbau Spielstand mit Inseln voller Hochhäuser.

Wie sich das im Vergleich auswirkt, hatte ich in der Komentarspalte diskutiert und gemessen.

Die Leistungsmetriken aus meinem Spielstand kann man schlecht mit diesem anderen Rekordbau-Spielstand vergleichen. Ich hatte dabei nur ein sehr grob zusammengeschustertes Skript verwendet, dass nicht in Dauer und Aufteilung mit meinem vergleichbar war.

Vergleicht man die FPS trotzdem, sind diese z.B. mit dem 5700X@3,9Ghz von 41,2 auf 36,2 1/s gefallen.

Die CPU Auslastung mit 16 Threads ist von durchschnittlich 28 auf 42%(26 auf 48% mit dem 5700X) gestiegen. Das hatte ich mir nicht so deutlich vorgestellt.

Ich war mit meiner Radeon VII stärker im GPU Limit, aber grundsätzlich haben sich die Erfahrungen mit diesem Rekordbau Spielstand mit denen aus meinem damaligen Spielstand gedeckt.

RAM Optimierung hilft viel, der dreifache L3 Cache des 5800X3D hilft viel und sogar bei 4 aktiven Kernen ist es besser SMT zu deaktivieren(trotz gestiegener CPU Auslastung).

Hier habe ich auch zuerst den kumulativen Einfluss von verschiedenen Optimierungen getestet und nicht jede Optimierung gesondert betrachtet.

Von Bios Defaults und maximalen Details bis zu CPU/RAM/Software Optimierung konnten die FPS des 5700X von 26,5 auf 51,4 1/s gesteigert werden....damit war auch dieser Rekordbau Spielstand angenehm spielbar.

Vergleicht man die FPS trotzdem, sind diese z.B. mit dem 5700X@3,9Ghz von 41,2 auf 36,2 1/s gefallen.

Die CPU Auslastung mit 16 Threads ist von durchschnittlich 28 auf 42%(26 auf 48% mit dem 5700X) gestiegen. Das hatte ich mir nicht so deutlich vorgestellt.

Ich war mit meiner Radeon VII stärker im GPU Limit, aber grundsätzlich haben sich die Erfahrungen mit diesem Rekordbau Spielstand mit denen aus meinem damaligen Spielstand gedeckt.

RAM Optimierung hilft viel, der dreifache L3 Cache des 5800X3D hilft viel und sogar bei 4 aktiven Kernen ist es besser SMT zu deaktivieren(trotz gestiegener CPU Auslastung).

Hier habe ich auch zuerst den kumulativen Einfluss von verschiedenen Optimierungen getestet und nicht jede Optimierung gesondert betrachtet.

Von Bios Defaults und maximalen Details bis zu CPU/RAM/Software Optimierung konnten die FPS des 5700X von 26,5 auf 51,4 1/s gesteigert werden....damit war auch dieser Rekordbau Spielstand angenehm spielbar.

Fazit zu dem Update

Die großen Überraschungen sind ausgeblieben.

Der weitergespielte Spielstand mit den zusätzlichen DLCs läuft wie erwartet etwas langsamer.

Der benötigte RAM und die CPU Rohleistung sind etwas gestiegen und so sind 32 GB RAM noch wichtiger und bei 4 CPU Kernen werden die zusätzlichen virtuellen Threads durch SMT sinnvoll.

Schneller RAM hilft weiterhin deutlich und zusammen mit anderen Optimierungen kann man den Ryzen 5700X auf ein angenehmes Niveau heben und der Ryzen 5800X3D braucht eigentlich keine Hilfe, kann aber auch von Optimierungen profitieren.

Ein kurzer Blick auf die Ladezeiten hat ergeben, dass fast nur die CPU Geschwindigkeit zählt und das ein Nachladen aus dem Spiel heraus länger dauert, als der initiale Ladevorgang.

Positiv für mich ist, dass der Skript-Benchmark jetzt wieder mit dem neuen UserInterface funktioniert und die Messungen gut zu den bisherigen Ergebnissen passen.

Also weiter zu dem umfassenderen Fazit des ganzen Artikels.

<- Vorheriger Thread(Optimierung/Einfluss der Grafik) --Übersicht-- nächster Thread(Zusammenfassung und Fazit) ->

Zuletzt bearbeitet: