Hallo allerseits!

Leider habe ich ein Problem, bei dem ich nicht weiß wo ich ansetzen soll. Daher möchte ich euch um Hilfe und Unterstützung bitten.

Auf meinem NAS (QNAP TS-673A) lasse ich mehrere VMs mit Debian 12 mit unterschiedlichen Anwendungen laufen. Um schon mal zwei Problemkinder zu nennen:

Dazu bin ich hergegangen und habe habe einen Freigabeordner namens

Um der VM den Zugriff auf den Freigabeordner zu ermöglichen, habe ich eine

- Installation des NFS client package

- Erstellen von Mountingpoints

- Editieren um folgenden Inhalt am Ende der fstab-Datei für eine dauerhafte Einbindung des Freigabeordners

- Neustart der VM

- Ausführen der Docker Compose-yml

Alles funktioniert so wie gewünscht, nur

Schalte ich mich auf die VM wenn ich mich mal wieder nicht anmelden kann sehe ich jedoch, dass der Freigabeordner gemountet ist.

Nun meine Frage an euch: wo könnte hier das Problem sein? Ich bin leider nicht so bewandert was Linux anbelangt und musss mir viel anlesen und auch mal was ausprobieren. Meiner Vermutung nach verstreicht im Hintergrund eine Zeit, die die NFS-Verbindung kappt. Kann das sein?

Vielen Dank für eure Bemühungen!

Schöne Grüße

Sebastian

Leider habe ich ein Problem, bei dem ich nicht weiß wo ich ansetzen soll. Daher möchte ich euch um Hilfe und Unterstützung bitten.

Auf meinem NAS (QNAP TS-673A) lasse ich mehrere VMs mit Debian 12 mit unterschiedlichen Anwendungen laufen. Um schon mal zwei Problemkinder zu nennen:

Nginx Proxy Manager und PhotoPrism. Bis dato war es so, dass die Daten innerhalb der VM lagen - dies sollte sich nun ändern um die Daten besser sichern zu können.Dazu bin ich hergegangen und habe habe einen Freigabeordner namens

Docker angelegt, in dem für unterschiedliche Programme (Beispiele siehe oben) die Daten abgelegt werden. In den Docker Compose-Dateien habe ich entsprechend auf die Pfade verwiesen.Um der VM den Zugriff auf den Freigabeordner zu ermöglichen, habe ich eine

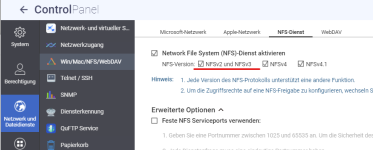

NFS-Freigabe erstellt und die IP-Adressen der VMs eingetragen. Zwecks Zugriff bin ich wie folgt vorgegangen:- Installation des NFS client package

Code:

apt update

apt install nfs-common- Erstellen von Mountingpoints

Code:

cd /mnt

mkdir NFS_Multimedia_SebReg

mkdir NFS_Docker- Editieren um folgenden Inhalt am Ende der fstab-Datei für eine dauerhafte Einbindung des Freigabeordners

Code:

nano /etc/fstab

Code:

# <file system> <dir> <type> <options> <dump> <pass>

10.20.18.40:/Multimedia_SebReg /mnt/NFS_Multimedia_SebReg nfs defaults 0 0

10.20.18.40:/Docker /mnt/NFS_Docker nfs defaults 0 0- Neustart der VM

Code:

systemctl reboot- Ausführen der Docker Compose-yml

Alles funktioniert so wie gewünscht, nur

nach einer gewissen Zeit scheint keine Verbindung mehr zum Freigabeordner zu bestehen. Dies macht sich dadurch bemerkbar, dass ich mich weder bei Nginx noch bei PhotoPrism anmelden kann - falscher Benutzer / Passwort. Starte ich die VMs neu läuft für eine gewisse Zeit wieder alles.Schalte ich mich auf die VM wenn ich mich mal wieder nicht anmelden kann sehe ich jedoch, dass der Freigabeordner gemountet ist.

Nun meine Frage an euch: wo könnte hier das Problem sein? Ich bin leider nicht so bewandert was Linux anbelangt und musss mir viel anlesen und auch mal was ausprobieren. Meiner Vermutung nach verstreicht im Hintergrund eine Zeit, die die NFS-Verbindung kappt. Kann das sein?

Vielen Dank für eure Bemühungen!

Schöne Grüße

Sebastian

Anhänge

Zuletzt bearbeitet:

(Screenshot hinzugefügt)