iNFECTED_pHILZ

Commodore

- Registriert

- Dez. 2008

- Beiträge

- 4.286

Hallo CB-Community,

einer der wenigen Neujahrsvorsätze meinerseits ist es, diesen Leseartikel endlich fertigzustellen und zu veröffentlichen. Das Jahr nähert sich nun aber schon wieder rasant dem Ende zu. Grund genug, es nun endlich mal fertig zu stellen.

Vorwort

Mit dem folgenden Text werde ich versuchen, die Grundprinzipien und Einflüsse auf den Betrieb einer GPU zusammenzufassen und dem geneigten Leser näher zu bringen.

Mir persönlich war trotz jahrelangem Interesse am Thema vieles nicht klar. Vergleichbar einfache Zusammenhänge wurden nicht gesehen oder falsch interpretiert.

Das Ganze darf maximal als Hobby meinerseits angesehen werden. Es werden sich sicher die ein oder andere fachliche Unschärfe oder gar ein Fehler einschleichen. Hier bitte ich um eure Rücksicht und Feedback.

Dabei richte ich mich bewusst an Neulinge zu dem Thema.

DeepDives gibt es hier glücklicherweise schon genug

Genug Theorie, denn im zweiten Teil wird das Gelernte nun angewendet.

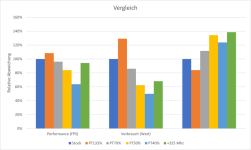

Ich erspare euch hässliche Exceltabellen, sondern stelle die gewonnenen Daten direkt als Grafen dar. Jede Darstellung wird zudem noch kurz beschrieben und anschließend diskutiert.

Die knapp 40% höhere Effizienz die die 4090 bei manuellem OC/UV erreicht, zeigt wie viel Potential in manchen Karten schlummert. Die Leistung fällt dabei kaum nennenswert ab und der Lüfter bleibt eigentlich immer sehr leise. Man sollte jedoch genau wissen, was man tut, und ein bisschen Zeit investieren um das ganz individuelle Maximum aus seiner Karte rauskitzeln.

Bei der mobilen Variante der RTX3080Mobile hat sich gezeigt, dass manchmal unerwartete Limits die GPU ausbremsen können.

Eine nennenswert höhere Effizienz wie bei der 4090 konnte nicht erreicht werden.

Dafür konnte die Leistung in über 40% erhöht werden ohne das dabei die Effizienz gelitten hätte.

Um seinen ganz eigenen optimalen Betriebspunkt zu erreichen sollte zunächst geprüft werden, ob es Limits gibt, wo man sie zunächst nicht erwartet.

Kann man diese ausschließen, bieten sich besonders das Einstellen eines Power Target und das anpassen der Takt/Spannungskurve an.

Für Anfänger ist das verschieben des Power Target eine feine Sache. Es geht nichts kaputt und man zeigt einfach ob die Richtung in die man hin will.

Trotz der eher geringeren Effizienzsteigerungen beim Absenken des Power Targets eignet sich diese Methode jedoch nicht nur für Anfänger. Es kann auch als Ergänzung für weitere Betriebspunktoptimierungen genutzt werden.

Der Vorteil bei einer Kombination mit einen reduzierten Power Target kommt in manchen Hauptmenüs zum tragen. Hier werden oft Werte von vielen hundert FPS erreicht, die aber nur einen kleinen Teil der GPU-Recheneinheiten auslasten. Mit diesem unüblichen Lastpunkt wirkt die GPU oft überfordert und reagiert in solchen Menüs mit Spulenfiepen und einem Hochfahren der Lüfter.

Ein verringertes PowerTarget lässt hier die GPU nicht unnötig hochschießen und die Lüfter bleiben eher ruhig, das Spulenfiepen wird reduziert.

Am Beispiel der RTX4090 zwigt z.B. ein Power Target von 70% zeigt eine gute Effizienz bei ebenfalls vernachlässigbarer Minderleistung gegenüber dem Referenz-Betriebspunkt und ist somit meine Empfehlung für jeden, der sich nicht lange mit Details beschäftigen und einfach zocken will.

Man sollte es aber auch nicht übertreiben.

Unter einem Power Target von 50% kann die RTX4090 aber kaum noch ihre Stärken ausspielen. Das Korsett ist zu eng und der Chip kann sprichwörtlich nicht mehr richtig atmen. Jedoch kann es insbesondere in den heißen Sommertagen verlocken sein, die Abwärme auf unter 200W zu drosseln.

Wer mehr Leistung aus seiner RTX4090 holen will, kann das nur sehr begrenzt tun.

Nach oben ist kaum Luft, denn selbst eine TDP von 466W (350W*1,33) resultieren in nur geringen 10% Mehrleistung.

Ob es das für einen wert ist, muss jeder selbst entscheiden. An Rohleistung mangelt es der 4090 jedenfalls nicht.

Ein Speicher OC sollte in jedem Fall mitgenommen werden, da dies sowohl der Performance als auch der Effizienz zuträglich ist.

Ein FrameLimit macht aber in den meisten Fällen sowieso Sinn, weshalb man das ganze Thema hier nur on top sehen sollte.

Daher, Probieren geht über Studieren! Guckt selbst, was euch am besten taugt und passt eure GPU euren ganz persönlichen Vorlieben an!

Ich hoffe ich konnte euch Lesern einen groben Einblick in die Welt der Grafikkarten verschaffen. Ich freue mich auf Feedback und hoffentlich konstruktive Kritik.

einer der wenigen Neujahrsvorsätze meinerseits ist es, diesen Leseartikel endlich fertigzustellen und zu veröffentlichen. Das Jahr nähert sich nun aber schon wieder rasant dem Ende zu. Grund genug, es nun endlich mal fertig zu stellen.

- Vorwort

- Einleitung

- Umsetzung an einer RTX4090 FE

- Umsetzung an einer RTX3080Mobile (ASUS Zephyrus G15 2020)

- Fazit

Vorwort

Mit dem folgenden Text werde ich versuchen, die Grundprinzipien und Einflüsse auf den Betrieb einer GPU zusammenzufassen und dem geneigten Leser näher zu bringen.

Mir persönlich war trotz jahrelangem Interesse am Thema vieles nicht klar. Vergleichbar einfache Zusammenhänge wurden nicht gesehen oder falsch interpretiert.

Das Ganze darf maximal als Hobby meinerseits angesehen werden. Es werden sich sicher die ein oder andere fachliche Unschärfe oder gar ein Fehler einschleichen. Hier bitte ich um eure Rücksicht und Feedback.

Dabei richte ich mich bewusst an Neulinge zu dem Thema.

DeepDives gibt es hier glücklicherweise schon genug

Einleitung

Die Idee für diesen Artikel kam mir eigentlich schon mit der Inbetriebnahme meines Laptops (Asus Zephyrus G15) vor knapp 2 Jahren.

Dieser besitzt eine RTX3080 in der mobilen Variante.

Während die Eckdaten der jeweiligen GPU noch relativ leicht nachzuschlagen und somit qualitativ vergleichbar sind, liegt wie so oft der Teufel im Detail.

Denn allein die Anzahl der Recheneinheiten lässt noch keinen Schluss zur eigentlichen Performance zu. Benchmarks zeigen eine Streuung der mobilen RTX3080 von bis zu 50%.

Und selbst die Performance wird hier nur eine Metrik von vielen sein, denn zum Betrieb einer GPU gehört dann eben doch mehr als reine FPS.

Das Thema Kühlung ist bei einem Laptop zudem viel allgegenwärtiger als bei den meisten Desktop-Aufbauten. Der geringe Platz für Kühlfinnen und Lüfter lassen vergleichbar wenig Spielraum bei der Abwärme und limitieren so den zulässigen Stromverbrauch.

Aufgrund Familie, neuer Job und vielen kleinen anderen Baustellen habe ich diesen Artikel aber derart vor mir hergeschoben, dass besagter Laptop längst hier im Markt verkauft wurde (RIP CB Marktplatz) und es wieder ein vollwertiger Desktop-Rechner wurde. Mit diesem wurde jetzt auch alles durchgebencht und getestet.

Aber der Reihe nach.

Die Idee für diesen Artikel kam mir eigentlich schon mit der Inbetriebnahme meines Laptops (Asus Zephyrus G15) vor knapp 2 Jahren.

Dieser besitzt eine RTX3080 in der mobilen Variante.

Während die Eckdaten der jeweiligen GPU noch relativ leicht nachzuschlagen und somit qualitativ vergleichbar sind, liegt wie so oft der Teufel im Detail.

Denn allein die Anzahl der Recheneinheiten lässt noch keinen Schluss zur eigentlichen Performance zu. Benchmarks zeigen eine Streuung der mobilen RTX3080 von bis zu 50%.

Und selbst die Performance wird hier nur eine Metrik von vielen sein, denn zum Betrieb einer GPU gehört dann eben doch mehr als reine FPS.

Das Thema Kühlung ist bei einem Laptop zudem viel allgegenwärtiger als bei den meisten Desktop-Aufbauten. Der geringe Platz für Kühlfinnen und Lüfter lassen vergleichbar wenig Spielraum bei der Abwärme und limitieren so den zulässigen Stromverbrauch.

Aufgrund Familie, neuer Job und vielen kleinen anderen Baustellen habe ich diesen Artikel aber derart vor mir hergeschoben, dass besagter Laptop längst hier im Markt verkauft wurde (RIP CB Marktplatz) und es wieder ein vollwertiger Desktop-Rechner wurde. Mit diesem wurde jetzt auch alles durchgebencht und getestet.

Aber der Reihe nach.

Was macht eine GPU aus?

Eine GPU macht im Grunde genau zwei Sachen, die für den Nutzer relevant sind.

Sie rendert die Bilder (Ertrag = FPS) und verbraucht dabei Strom (Aufwand = Power).

Setzen wir beides ins Verhältnis erhalten wir zunächst einmal die Energieeffizienz für eben dieses Rendern (nennen wir sie folgend einfach "X").

X = FPS / Power

Oder ausgeschrieben:

Effizienz = Ertrag / Aufwand

Je höher der Wert von X in einem Spiel wird, desto energieeffizienter arbeitet die GPU also.

Dieser Wert ist jedoch niemals fix für eine GPU. Er hängt massiv vom jeweiligen Last- und Betriebspunkt ab und kann vom Herstellerpartner (z.B. OC-Versionen) oder Nutzer angepasst werden.

Durch das mittlerweile automatisierte Boostverhalten moderner Karten zeigen sich auch schneller Schwankungen zwischen eigentlich identischen Grafikkarten.

Dies ist durch die jeweilige Chipgüte zu erklären. Jeder Chip ist streng genommen ein Unikat und benötigt für bestimmte Taktraten eine ganz individuelle Spannung.

Den meisten Nutzern wird die eigentliche Höhe des Boosttaktes oder der Spannung nur indirekt interessieren.

Relevant ist am Ende eher, was bei rauskommt (FPS) und ob es einem der Aufwand (Stromverbrauch) wert ist.

Hinzu kommt natürlich der eigene Anspruch an Features. Ob Themen wie Raytracing, FrameGeneration oder Video-Encoding ausreichend abgedeckt sind, sollte vor der Wahl der Grafikkarte beachtet werden.

Für viele Spieler stellt zudem die Speichergröße ein wichtiges Merkmal dar.

Dieser stellt Sachen wie Texturen bereit und sorgt dafür, dass die eigentliche GPU mit ausreichend Daten versorgt wird.

Man sollte dabei aber wissen, dass ein größerer Speicher erst einmal keine Leistungsvorteile gegenüber einem kleinen Speicher bringt. Ein kleiner Speicher macht sich erst dann bemerkbar, wenn er vollläuft und Daten in den RAM des Rechners auslagern muss. Die Leistung bricht ein.

Böse Zungen behaupten, dass ein zum Releasedatum gerade noch ausreichend bemessener Speicher eine Art geplante Obsoleszenz wäre. Dies ist zwar nicht ganz von der Hand zu weisen, jedoch treibt ein zu groß bemessener Speicher die ohnehin schon hohen GPU Preise nur noch weiter in die Höhe. Wie so oft, muss man abwägen.

Für viele weniger relevant ist der technische Unterbau. Also die Chip-Basis, auf der die Grafikkarte aufgebaut ist. Es wird meist nur auf den Namen geguckt, mit dem dann ein gewisses Leistungsspektrum verbunden wird.

Diese Unwissenheit ist den Herstellern sehr recht. Eine RTX3060 aus 2021 gleicht eben nicht unbedingt einer RTX3060 aus 2022

https://www.computerbase.de/news/grafikkarten/ga104-150-nvidia-wechselt-ein-weiteres-mal-den-chip-der-rtx-3060.78081/

Oft wird der Käufer auch bewusst in die Irre geführt. So ist die von mir eingangs erwähnte RTX3080Mobile technisch eine RTX3070, welche auf Effizienz getrimmt wurde.

Hier gilt, sich nicht von der Benennung oder Speichergröße blenden lassen, sondern Tests lesen.

Eine GPU macht im Grunde genau zwei Sachen, die für den Nutzer relevant sind.

Sie rendert die Bilder (Ertrag = FPS) und verbraucht dabei Strom (Aufwand = Power).

Setzen wir beides ins Verhältnis erhalten wir zunächst einmal die Energieeffizienz für eben dieses Rendern (nennen wir sie folgend einfach "X").

X = FPS / Power

Oder ausgeschrieben:

Effizienz = Ertrag / Aufwand

Je höher der Wert von X in einem Spiel wird, desto energieeffizienter arbeitet die GPU also.

Dieser Wert ist jedoch niemals fix für eine GPU. Er hängt massiv vom jeweiligen Last- und Betriebspunkt ab und kann vom Herstellerpartner (z.B. OC-Versionen) oder Nutzer angepasst werden.

Durch das mittlerweile automatisierte Boostverhalten moderner Karten zeigen sich auch schneller Schwankungen zwischen eigentlich identischen Grafikkarten.

Dies ist durch die jeweilige Chipgüte zu erklären. Jeder Chip ist streng genommen ein Unikat und benötigt für bestimmte Taktraten eine ganz individuelle Spannung.

Den meisten Nutzern wird die eigentliche Höhe des Boosttaktes oder der Spannung nur indirekt interessieren.

Relevant ist am Ende eher, was bei rauskommt (FPS) und ob es einem der Aufwand (Stromverbrauch) wert ist.

Hinzu kommt natürlich der eigene Anspruch an Features. Ob Themen wie Raytracing, FrameGeneration oder Video-Encoding ausreichend abgedeckt sind, sollte vor der Wahl der Grafikkarte beachtet werden.

Für viele Spieler stellt zudem die Speichergröße ein wichtiges Merkmal dar.

Dieser stellt Sachen wie Texturen bereit und sorgt dafür, dass die eigentliche GPU mit ausreichend Daten versorgt wird.

Man sollte dabei aber wissen, dass ein größerer Speicher erst einmal keine Leistungsvorteile gegenüber einem kleinen Speicher bringt. Ein kleiner Speicher macht sich erst dann bemerkbar, wenn er vollläuft und Daten in den RAM des Rechners auslagern muss. Die Leistung bricht ein.

Böse Zungen behaupten, dass ein zum Releasedatum gerade noch ausreichend bemessener Speicher eine Art geplante Obsoleszenz wäre. Dies ist zwar nicht ganz von der Hand zu weisen, jedoch treibt ein zu groß bemessener Speicher die ohnehin schon hohen GPU Preise nur noch weiter in die Höhe. Wie so oft, muss man abwägen.

Für viele weniger relevant ist der technische Unterbau. Also die Chip-Basis, auf der die Grafikkarte aufgebaut ist. Es wird meist nur auf den Namen geguckt, mit dem dann ein gewisses Leistungsspektrum verbunden wird.

Diese Unwissenheit ist den Herstellern sehr recht. Eine RTX3060 aus 2021 gleicht eben nicht unbedingt einer RTX3060 aus 2022

https://www.computerbase.de/news/grafikkarten/ga104-150-nvidia-wechselt-ein-weiteres-mal-den-chip-der-rtx-3060.78081/

Oft wird der Käufer auch bewusst in die Irre geführt. So ist die von mir eingangs erwähnte RTX3080Mobile technisch eine RTX3070, welche auf Effizienz getrimmt wurde.

Hier gilt, sich nicht von der Benennung oder Speichergröße blenden lassen, sondern Tests lesen.

Der Stromverbrauch

Anders als bei Laptops, wo der Verbrauch des ganzen Systems bei etwa 50-120W liegt (große Gaming Laptops gehen auch gerne mal über 160W) können die Hersteller von Desktopkarten massive 3-4 Slot Kühldesigns auf ihre Karten schnallen. Somit steigen die kühlbaren Verbräuche heutzutage auch auf über 400W.

Im Fachjargon spricht man beim Thema Verbrauch oft von TDP (Thermal Design Parameter), TBP (Total Board Power) und TGP (Total Graphics Power).

Die TDP ist eigentlich DIE relevante Kennzahl zur Dimensionierung der Kühlung. Sprich: So viel Strom wird der Chip im Mittel ziehen, die man eben wegkühlen muss.

Verwendet man beim gleichen Chip verschiedene TDP, erreicht man auch unterschiedliche Leistungen. Dieser Leistungsunterschied steigt/fällt aber nicht linear mit der TDP. So kann eine Verdopplung der TDP in nur 10% Leistungszuwachs münden.

Eine GPU wird in der Regel auf einen engen TDP-Bereich hin designt und wird dort auch am besten arbeiten können. Weicht man davon zu stark ab, kann es passieren, dass die Leistung der GPU unverhältnismäßig stark absinkt.

Die TDP ist jedoch NUR für die Kühlung relevant. Die Stromversorgung muss aufgrund Lastspitzen, Spannungsdynamik etc. anders dimensioniert werden.

Die TBP und TGP sind hier weitaus komplexer und auch von AMD und Nvidia je anders definiert.

Wer sich hier tiefer in die Materie einlesen möchte, ist bei Igor gut aufgehoben.

Für uns relevant ist jedenfall, dass die später herangezogene Leistungsaufnahme von der TDP abweichen wird, da noch Nebenverbraucher wie Speicherchips dazugerechnet werden. Wir werden folgend jedoch vom Power Limit sprechen, da dies der Nomenklatur im AfterBurner entspricht und für die meisten der griffigere Begriff sein dürfte.

Anders als bei Laptops, wo der Verbrauch des ganzen Systems bei etwa 50-120W liegt (große Gaming Laptops gehen auch gerne mal über 160W) können die Hersteller von Desktopkarten massive 3-4 Slot Kühldesigns auf ihre Karten schnallen. Somit steigen die kühlbaren Verbräuche heutzutage auch auf über 400W.

Im Fachjargon spricht man beim Thema Verbrauch oft von TDP (Thermal Design Parameter), TBP (Total Board Power) und TGP (Total Graphics Power).

Die TDP ist eigentlich DIE relevante Kennzahl zur Dimensionierung der Kühlung. Sprich: So viel Strom wird der Chip im Mittel ziehen, die man eben wegkühlen muss.

Verwendet man beim gleichen Chip verschiedene TDP, erreicht man auch unterschiedliche Leistungen. Dieser Leistungsunterschied steigt/fällt aber nicht linear mit der TDP. So kann eine Verdopplung der TDP in nur 10% Leistungszuwachs münden.

Eine GPU wird in der Regel auf einen engen TDP-Bereich hin designt und wird dort auch am besten arbeiten können. Weicht man davon zu stark ab, kann es passieren, dass die Leistung der GPU unverhältnismäßig stark absinkt.

Die TDP ist jedoch NUR für die Kühlung relevant. Die Stromversorgung muss aufgrund Lastspitzen, Spannungsdynamik etc. anders dimensioniert werden.

Die TBP und TGP sind hier weitaus komplexer und auch von AMD und Nvidia je anders definiert.

Wer sich hier tiefer in die Materie einlesen möchte, ist bei Igor gut aufgehoben.

Für uns relevant ist jedenfall, dass die später herangezogene Leistungsaufnahme von der TDP abweichen wird, da noch Nebenverbraucher wie Speicherchips dazugerechnet werden. Wir werden folgend jedoch vom Power Limit sprechen, da dies der Nomenklatur im AfterBurner entspricht und für die meisten der griffigere Begriff sein dürfte.

Die Leistung

Für viele wohl der absolut wichtigste Wert einer GPU.

Ob nun Punkte in Benchmarks oder das Ziel einer möglichst ruckelfreien Erlebnis des Lieblingsshooters, es ist die Leistung an der GPUs zuallererst gemessen werden.

Diese kann je nach Engine und Lastart variieren.

Beispielhaft sei hier das häufig sehr gute Abschneiden von Nvidia Grafikkarten bei Titeln, die die Unreal-Engine nutzen. Wie CB aber in den großen Tests oft zeigt, gibt es Titel wie Starfield oder Forza, bei denen z.B. AMD auch mal 1-2 Klassensprünge ggü. Nvidia macht.

Sollte es ein Hauptspiel geben, empfehle ich daher, dass man auch davon seinen Grafikkartenkauf abhängig macht. Ansonsten zeigt aber das ComputerBase-Ranking sowieso einen gesunden Mix.

Oft wird die Leistung in gemittelten FPS gemessen. Die ist eine vergleichbar einfache Messung. Die meisten integrierten Benchmarks machen es so. Mit diesem Wert werde ich auch den "Ertrag" definieren. Also bei kommenden Betrachtungen ist mit FPS, sofern nicht anders beschrieben, ein gemittelter Wert über eine Spielszene gemeint.

Ebenfalls interessant sind die MinFPS. Diese zeigen ob trotz hoher FPS vereinzelte Ruckler zu erwarten sind. Die Gründe hierfür können jedoch bei der GPU, der CPU, dem RAM oder etwas ganz anderem liegen. So wichtig dieser Wert für viele Spieler auch sein mag, er wird von mir hier nicht weiter betrachtet.

Für viele wohl der absolut wichtigste Wert einer GPU.

Ob nun Punkte in Benchmarks oder das Ziel einer möglichst ruckelfreien Erlebnis des Lieblingsshooters, es ist die Leistung an der GPUs zuallererst gemessen werden.

Diese kann je nach Engine und Lastart variieren.

Beispielhaft sei hier das häufig sehr gute Abschneiden von Nvidia Grafikkarten bei Titeln, die die Unreal-Engine nutzen. Wie CB aber in den großen Tests oft zeigt, gibt es Titel wie Starfield oder Forza, bei denen z.B. AMD auch mal 1-2 Klassensprünge ggü. Nvidia macht.

Sollte es ein Hauptspiel geben, empfehle ich daher, dass man auch davon seinen Grafikkartenkauf abhängig macht. Ansonsten zeigt aber das ComputerBase-Ranking sowieso einen gesunden Mix.

Oft wird die Leistung in gemittelten FPS gemessen. Die ist eine vergleichbar einfache Messung. Die meisten integrierten Benchmarks machen es so. Mit diesem Wert werde ich auch den "Ertrag" definieren. Also bei kommenden Betrachtungen ist mit FPS, sofern nicht anders beschrieben, ein gemittelter Wert über eine Spielszene gemeint.

Ebenfalls interessant sind die MinFPS. Diese zeigen ob trotz hoher FPS vereinzelte Ruckler zu erwarten sind. Die Gründe hierfür können jedoch bei der GPU, der CPU, dem RAM oder etwas ganz anderem liegen. So wichtig dieser Wert für viele Spieler auch sein mag, er wird von mir hier nicht weiter betrachtet.

Betriebs- & Lastpunkt

Jede Anwendung hat ihre ganz speziellen Anforderungen an das System. So kann es sein, dass die GPU durch diverse Limitierungen nicht mal annähernd zu 100% ausgelastet wird oder aber zusätzliche Einheiten wie RayTracing-Cores plötzlich verwendet werden.

Ein Chip ist wie eine riesige Fabrik zu verstehen, bei der nur in den seltensten Fällen alles gleichmäßig ausgelastet ist. Daher wird jede Anwendung diese Fabrik auch anders fordern.

Dies wird besonders deutlich, wenn man sich die erreichten Taktraten anguckt. Bei manchen Spielen werden höhere Taktraten erreicht als bei anderen, obwohl in beiden Fällen gleich viel Strom verbraucht wird.

Mit dem Betriebspunkt wird definiert, was die Grafikkarte darf und wie sie die zur Verfügung stehenden Ressourcen zu verwenden hat.

Unter Last versucht die GPU immer ihren eingestellten Betriebspunkt zu erreichen, der Betriebspunkt ist somit anwendungsunabhängig.

Der Lastpunkt hingegen ist anwendungsabhängig. Daher sind die Anwendungen hier so gewählt, dass Sie ein möglichst breites Spektrum an Lastpunkten abdecken. Sprich mal ist besonders viel Shader-Last, RayTracing oder Speicherbandbreite gefragt.

Jede der Anwendungen wird die GPU zu 95-100% auslasten. Jedoch in einem ganz eigenen Lastpunkt.

Den größten Einfluss habe ich jedoch auf die Betriebspunkte. Hier sind es die Parameter Takt und TDP, welche leicht vom Nutzer angepasst werden können und daher hier beleuchtet werden.

Jede Anwendung hat ihre ganz speziellen Anforderungen an das System. So kann es sein, dass die GPU durch diverse Limitierungen nicht mal annähernd zu 100% ausgelastet wird oder aber zusätzliche Einheiten wie RayTracing-Cores plötzlich verwendet werden.

Ein Chip ist wie eine riesige Fabrik zu verstehen, bei der nur in den seltensten Fällen alles gleichmäßig ausgelastet ist. Daher wird jede Anwendung diese Fabrik auch anders fordern.

Dies wird besonders deutlich, wenn man sich die erreichten Taktraten anguckt. Bei manchen Spielen werden höhere Taktraten erreicht als bei anderen, obwohl in beiden Fällen gleich viel Strom verbraucht wird.

Mit dem Betriebspunkt wird definiert, was die Grafikkarte darf und wie sie die zur Verfügung stehenden Ressourcen zu verwenden hat.

Unter Last versucht die GPU immer ihren eingestellten Betriebspunkt zu erreichen, der Betriebspunkt ist somit anwendungsunabhängig.

Der Lastpunkt hingegen ist anwendungsabhängig. Daher sind die Anwendungen hier so gewählt, dass Sie ein möglichst breites Spektrum an Lastpunkten abdecken. Sprich mal ist besonders viel Shader-Last, RayTracing oder Speicherbandbreite gefragt.

Jede der Anwendungen wird die GPU zu 95-100% auslasten. Jedoch in einem ganz eigenen Lastpunkt.

Den größten Einfluss habe ich jedoch auf die Betriebspunkte. Hier sind es die Parameter Takt und TDP, welche leicht vom Nutzer angepasst werden können und daher hier beleuchtet werden.

Limitierungen

Die sich für den Betrieb des Chips ergebenden Limitierungen wurden eben schon genannt:

Es wird immer ein Limit geben, welches die Leistung der GPU begrenzen wird, da ansonsten unendlich FPS generiert werden würden.

Natürlich ist es jedoch ärgerlich wenn die GPU eigentlich viel mehr leisten könnte, aber durch ein einzelnes, tiefliegendes Limit zurückgehalten wird.

Dies zeigt dann auch den eigentlichen Kern meiner Intension für diesen Artikel:

Wie ändere ich Limits so ab, dass die GPU für meine Bedürfnisse optimal läuft?

Hierzu muss man sich zunächst fragen, welche Limits überhaupt in einem vertretbaren Rahmen veränderbar sind und welche eben nicht.

Im Prinzip sollte man aber immer eine FrameLimiter passend zur Bildwiederholrate des eigenen Monitors wählen.

Wenn der Monitor eine SyncTechnologie unterstützt, macht es Sinn 2-3% unter der maximalen Frequenz zu liegen.

Wenn der Monitor keine SyncTechnologie unterstützt und somit eine feste Abtastrate hat, sollte man die maximalen FPS auf genau diesen wert limitieren.

Ansonsten werden nur mehr Frames gerendert, als angezeigt werden. Der Verbrauch und die Lautstärke steigt, am Spielerlebnis ändert sich nichts.

Die sich für den Betrieb des Chips ergebenden Limitierungen wurden eben schon genannt:

| Limit Benennung | Beschreibung |

| Power | Siehe TDP. |

| Temperatur | Maximal zulässige Temperatur bevor gedrosselt wird |

| Takt | Maximal zulässiger Takt der zu Erreichen versucht wird |

| Spannung (evtl. Taktabhängig) | (Taktabhängige) Spannungskurve die der Chip sieht |

| Extern | z.B. FPS-Begrenzer |

| Daten | z.B. CPU-Limit oder Engine-Limits |

Es wird immer ein Limit geben, welches die Leistung der GPU begrenzen wird, da ansonsten unendlich FPS generiert werden würden.

Natürlich ist es jedoch ärgerlich wenn die GPU eigentlich viel mehr leisten könnte, aber durch ein einzelnes, tiefliegendes Limit zurückgehalten wird.

Dies zeigt dann auch den eigentlichen Kern meiner Intension für diesen Artikel:

Wie ändere ich Limits so ab, dass die GPU für meine Bedürfnisse optimal läuft?

Hierzu muss man sich zunächst fragen, welche Limits überhaupt in einem vertretbaren Rahmen veränderbar sind und welche eben nicht.

Im Prinzip sollte man aber immer eine FrameLimiter passend zur Bildwiederholrate des eigenen Monitors wählen.

Wenn der Monitor eine SyncTechnologie unterstützt, macht es Sinn 2-3% unter der maximalen Frequenz zu liegen.

Wenn der Monitor keine SyncTechnologie unterstützt und somit eine feste Abtastrate hat, sollte man die maximalen FPS auf genau diesen wert limitieren.

Ansonsten werden nur mehr Frames gerendert, als angezeigt werden. Der Verbrauch und die Lautstärke steigt, am Spielerlebnis ändert sich nichts.

Anforderungen

Jeder Mensch hat andere Anforderungen an seinen Rechner. Sei es ein kompromissloser Gaming-Rechner, der jedes FPS jagen soll, ein möglichst leises System oder aber auch irgendwas dazwischen. Bei steigenden Strompreisen kann einem auch z.B. ein möglichst geringer Stromverbrauch am wichtigsten sein.

Da ich mit Kopfhörern spiele, ist mir die Lautstärke eher weniger wichtig. Dennoch will ich keine Turbine neben mir stehen haben

Wenn im Sommer zudem die Zimmertemperaturen eh schon recht hoch sind, macht ein Rechner mit 800W Verbrauch auch wenig Spaß, denn die Wärmemenge, die abgegeben wird, gleicht einem Fön.

Aber Ihr seht schon, es gibt nicht diese eine perfekte Einstellung für Alle.

Jeder Mensch hat andere Anforderungen an seinen Rechner. Sei es ein kompromissloser Gaming-Rechner, der jedes FPS jagen soll, ein möglichst leises System oder aber auch irgendwas dazwischen. Bei steigenden Strompreisen kann einem auch z.B. ein möglichst geringer Stromverbrauch am wichtigsten sein.

Da ich mit Kopfhörern spiele, ist mir die Lautstärke eher weniger wichtig. Dennoch will ich keine Turbine neben mir stehen haben

Wenn im Sommer zudem die Zimmertemperaturen eh schon recht hoch sind, macht ein Rechner mit 800W Verbrauch auch wenig Spaß, denn die Wärmemenge, die abgegeben wird, gleicht einem Fön.

Aber Ihr seht schon, es gibt nicht diese eine perfekte Einstellung für Alle.

Die Takt/Spannungskurve am Beispiel Afterburner

Nachtrag (10.09.23 – Aufgrund Feedback von @Baal Netbeck )

Der zum Rendern verbrauchte Strom ist stark abhängig von der angelegten Spannung. Diese Spannung ist jedoch nicht zu jedem Zeitpunkt gleich.

Prinzipiell gilt:

Je höher der Takt, desto höher ist die nötige Spannung.

Je höher die Spannung, desto mehr verbraucht der Chip und desto heißer wird er.

Ihr merkt schon, die Spannung sollte demnach so gering wie möglich gehalten werden.

Leider weiß aber selbst der Chiphersteller selbst nicht, welche Spannung jetzt für welchen Takt genau nötig wäre. Um auf Nummer sicher zu gehen, wird daher immer eine höhere Spannung verwendet.

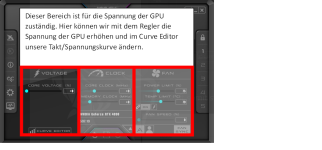

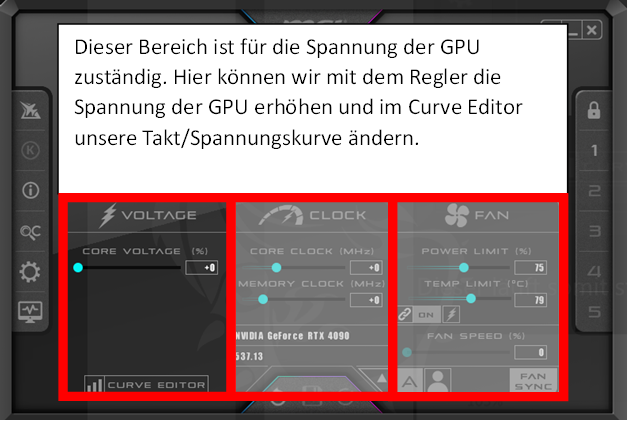

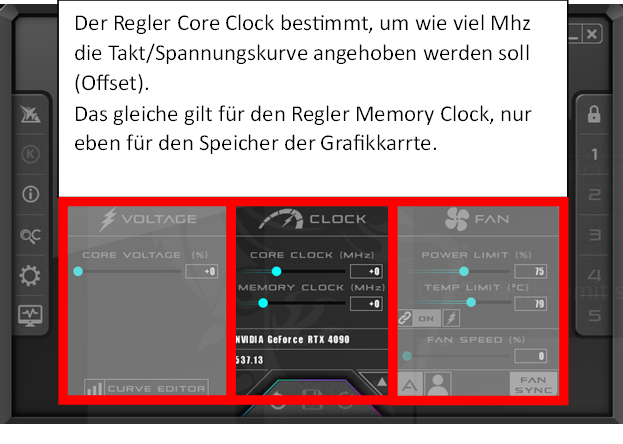

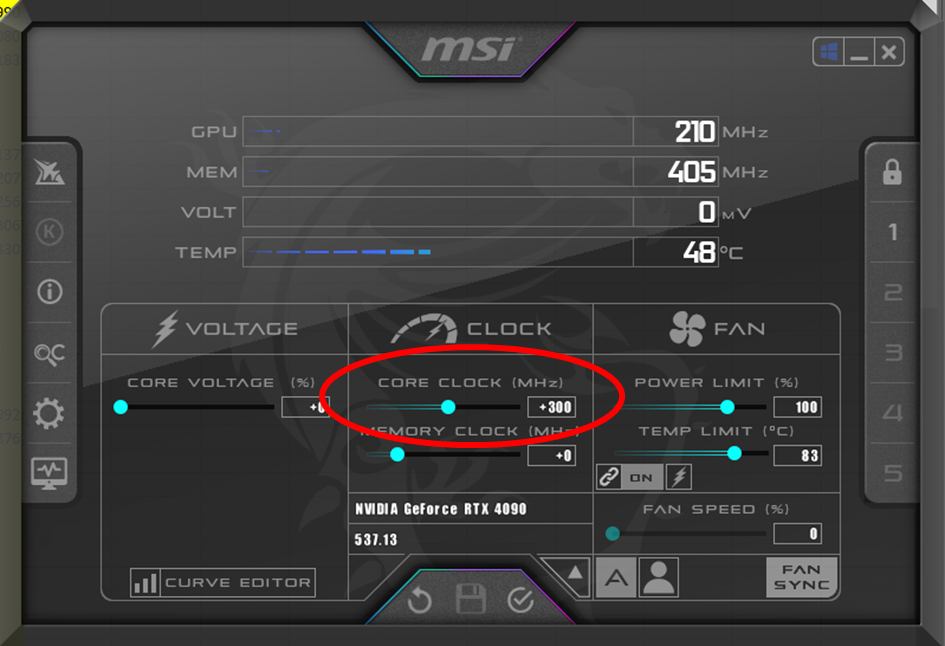

Da folgend mit Afterburner gearbeitet wird und das Thema zudem recht komplex wirken kann, zeige ich an dieser Stelle noch, wie man das durchaus umfangreiche Tool bedient. Insbesonderen Anfängern zu diesem Thema dürfte hier in manchen Erklärungen einiges zu schnell gehen. Daher gehen wir gemeinsam Schritt für Schritt alles Relevante durch.

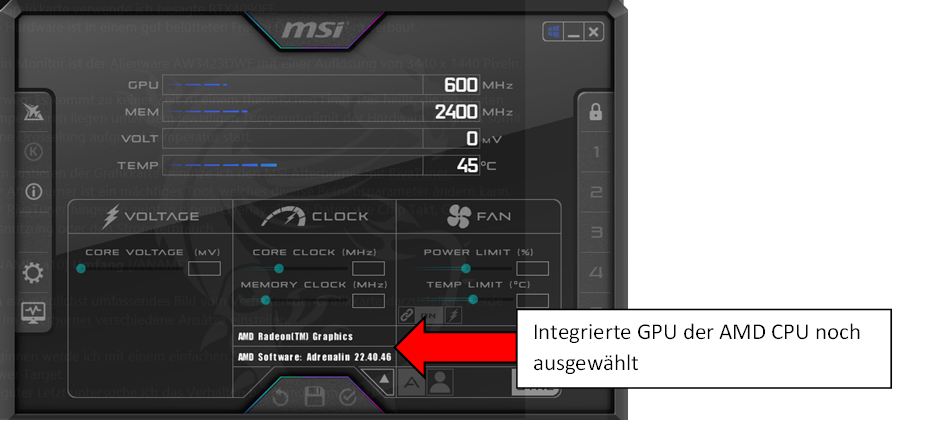

Nach der Installation kann es durchaus sein, dass zunächst vieles ausgegraut ist. Das liegt daran, dass nicht jede GPU im selben Umfang vom AfterBurner angesprochen werden kann.

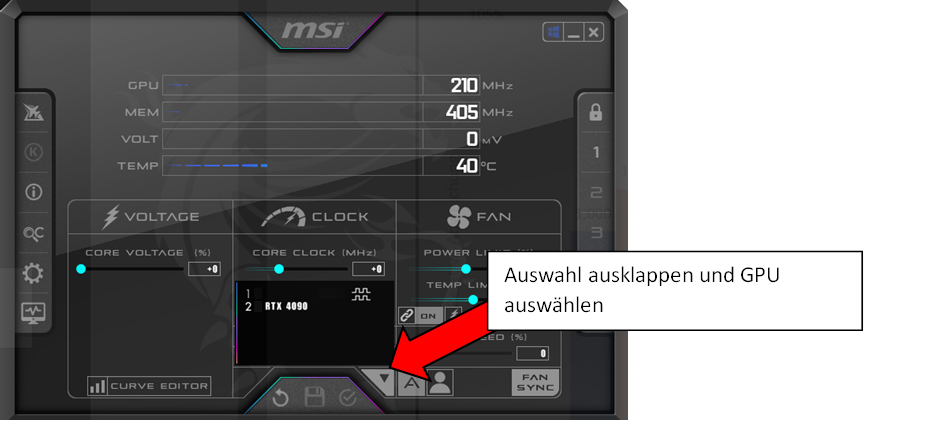

Man muss also erst die passende GPU auswählen.

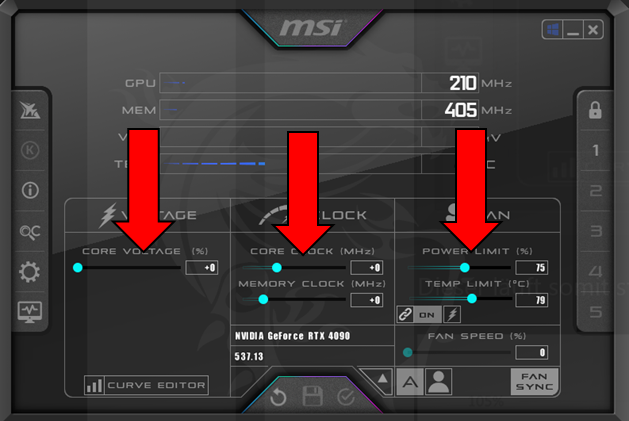

Jetzt sollte die Oberfläche die Regler zum größten Teil freigeschaltet haben

Diese scheint im ersten Moment etwas unübersichtlich, ist aber ein sehr nützliches Tool zum Optimieren der GPU.

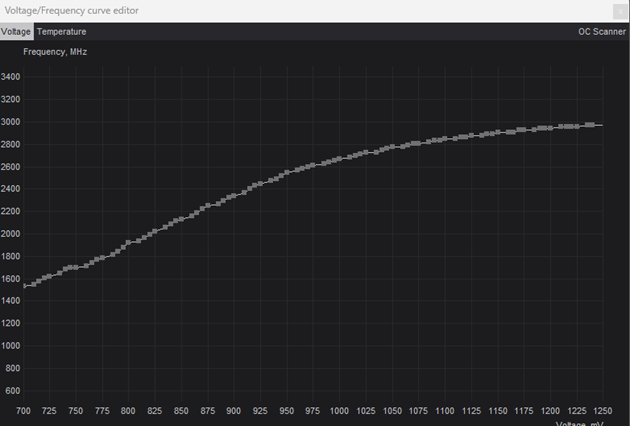

Jedem Taktpunkt wird hier eine Spannung zugeordnet. Mit höherem Taktpunkt liegt auch eine höhere Spannung an, da ein höherer Takt in der Regel auch immer eine höhere Spannung benötigt um stabil gehalten zu werden. Ob die Kurve linear, abflachend oder sogar steiler werdend aussieht, liegt ganz am Chipdesign. Üblich sind aber die wie hier zu sehen abflachende Kurven.

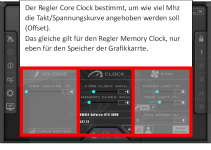

Der zweite Block bestimmt die Taktraten der GPU und dessen Speicher.

Anders als beim Core, gibt es beim Memory hier jedoch keine einfache Möglichkeit die Takt/Spannungskurve zu manipulieren.

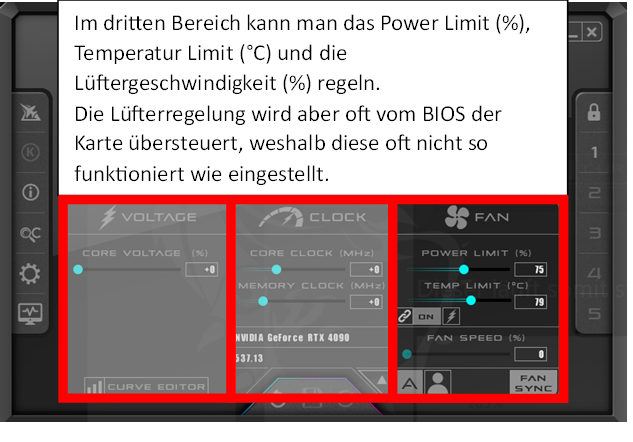

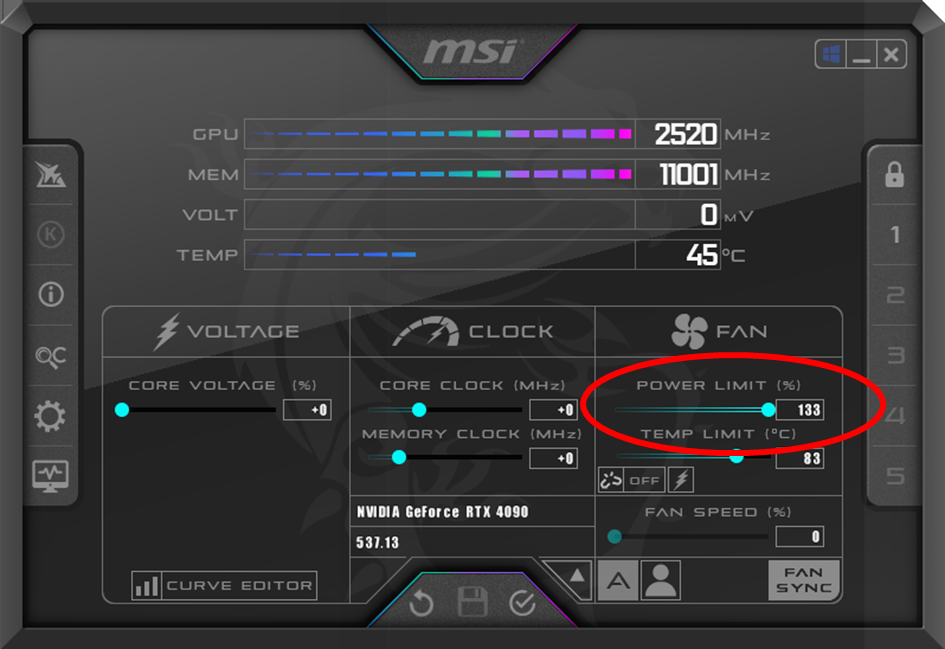

Standartmäßig ist das Power Limit (bezieht sich auf die TBP) mit dem Temperaturlimit gekoppelt. Diese Kopplung macht am meisten bei Notebooks Sinn, in meinen Tests aber eher weniger. Daher habe ich sie hier herausgenommen. Die Gefahr bei den Tests in ein versehentlich gewähltes Temperaturlimit zu rennen wollte ich hier nicht noch vergrößern.

Die jeweiligen Limits der Regler werden vom Profil der Karte bestimmt. Da man hier aber außerhalb der offiziell gewählten Betriebspunkte agiert sollte man insbesondere bei größerer Abweichung zur Referenz genau wissen, was man tut.

Damit der ganze Prozess etwas griffiger wird, erkläre ich ausführlich wie ich die Takt/Spannungskurve angepasst habe.

Nachtrag (10.09.23 – Aufgrund Feedback von @Baal Netbeck )

Der zum Rendern verbrauchte Strom ist stark abhängig von der angelegten Spannung. Diese Spannung ist jedoch nicht zu jedem Zeitpunkt gleich.

Prinzipiell gilt:

Je höher der Takt, desto höher ist die nötige Spannung.

Je höher die Spannung, desto mehr verbraucht der Chip und desto heißer wird er.

Ihr merkt schon, die Spannung sollte demnach so gering wie möglich gehalten werden.

Leider weiß aber selbst der Chiphersteller selbst nicht, welche Spannung jetzt für welchen Takt genau nötig wäre. Um auf Nummer sicher zu gehen, wird daher immer eine höhere Spannung verwendet.

Da folgend mit Afterburner gearbeitet wird und das Thema zudem recht komplex wirken kann, zeige ich an dieser Stelle noch, wie man das durchaus umfangreiche Tool bedient. Insbesonderen Anfängern zu diesem Thema dürfte hier in manchen Erklärungen einiges zu schnell gehen. Daher gehen wir gemeinsam Schritt für Schritt alles Relevante durch.

Nach der Installation kann es durchaus sein, dass zunächst vieles ausgegraut ist. Das liegt daran, dass nicht jede GPU im selben Umfang vom AfterBurner angesprochen werden kann.

Man muss also erst die passende GPU auswählen.

Jetzt sollte die Oberfläche die Regler zum größten Teil freigeschaltet haben

Diese scheint im ersten Moment etwas unübersichtlich, ist aber ein sehr nützliches Tool zum Optimieren der GPU.

Jedem Taktpunkt wird hier eine Spannung zugeordnet. Mit höherem Taktpunkt liegt auch eine höhere Spannung an, da ein höherer Takt in der Regel auch immer eine höhere Spannung benötigt um stabil gehalten zu werden. Ob die Kurve linear, abflachend oder sogar steiler werdend aussieht, liegt ganz am Chipdesign. Üblich sind aber die wie hier zu sehen abflachende Kurven.

Der zweite Block bestimmt die Taktraten der GPU und dessen Speicher.

Anders als beim Core, gibt es beim Memory hier jedoch keine einfache Möglichkeit die Takt/Spannungskurve zu manipulieren.

Standartmäßig ist das Power Limit (bezieht sich auf die TBP) mit dem Temperaturlimit gekoppelt. Diese Kopplung macht am meisten bei Notebooks Sinn, in meinen Tests aber eher weniger. Daher habe ich sie hier herausgenommen. Die Gefahr bei den Tests in ein versehentlich gewähltes Temperaturlimit zu rennen wollte ich hier nicht noch vergrößern.

Die jeweiligen Limits der Regler werden vom Profil der Karte bestimmt. Da man hier aber außerhalb der offiziell gewählten Betriebspunkte agiert sollte man insbesondere bei größerer Abweichung zur Referenz genau wissen, was man tut.

Damit der ganze Prozess etwas griffiger wird, erkläre ich ausführlich wie ich die Takt/Spannungskurve angepasst habe.

- Offset wähen

Hier muss man sich langsam herantasten. Wird ein zu hoher Wert gewählt schmiert die Grafikkarte ab. Auch wenn die Schutzmechanismen moderner Grafikkarten gut funktionieren, kann ein Schaden nie ausgeschlossen werden. Daher von unten nach oben in 25-50Mhz Schritten bewegen.

Wann ein Wert stabil ist, ist nicht ganz eindeutig.

Von RockStable spricht man, wenn man selbst mit extremen Belastungen (z.B. Furmark o. MSI Combuster) in langen Tests (>2h) nicht schafft, die Karte zum Abstürzen zu bringen.

Vielen reicht es aber, wenn das gewünschte Spiel ohne Probleme läuft.

Mein Kriterium war, dass die Grafikkarte in den ganzen verschiedenen Lastpunkten die ich im Test anfahre nicht abstürzt.

- Einstellung anwenden

Nun bestätigen wir mit dem Haken im Hauptmenü. Seid euch aber bewusst, dass sobald ihr auf Bestätigen klickt, der eingestellte Betriebspunkt auch angesteuert wird. Geht hier einfach nochmal sicher, dass Ihr keinen Zahlendreher oder eine 0 zu viel habt.

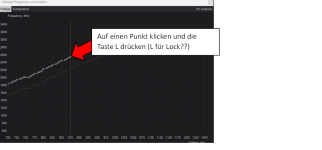

- Takt/Spannungskurve öffnen

Man sieht hier jetzt schön, was das Program gemacht hat. Die neue Kurve (weiß mit Punkten) liegt exakt 300Mhz über der alten Kurve (Grau)

Um das weitere Vorgehen nachvollziehen zu können, muss man verstehen, dass ein einfacher Offset nicht wirklich ideal ist.

Kleine Taktraten werden unter Umständen problemlos gehalten, bei größeren Taktraten kann es aber schnell zu Problemen führen. Das würde eigentlich für jeden Takt einen individuellen Offset bedeuten. Diesen aber herauszufinden wäre wahnsinnig aufwendig und führt auch zu kaum besseren Ergebnissen.

Der Trick besteht darin, einfach ein Taktlimit zu setzen.

- Taktgrenze einstellen

Durch den „Lock“ des angewählten Punkts wir dieser festgehalten.

Sobald alle Punkte rechts von unserem Zieltakt markiert sind, kann man diese nach unten ziehen. Darauf achten, dass auch der letzte Punkt unterhalb des Zieltaktes liegt.

- Eingabe bestätigen

Die Takt/Spannungskurve sollte nun so aussehen:

Das ganze kann man natürlich gedanklich auch umdrehen und statt des Zieltaktes eine Zielspannung wählen. Diese wäre jetzt in dem Falle 875mV.

Das hat sogar gleich mehrere Vorteile, auf die ich später eingehe. Ich habe es jedoch erst mal mit einem Zieltakt erklärt, da es so leichter verständlich wird.

- Einstellung speichern

Damit das Prozedere nicht bei jedem Neustart von vorne gemacht werden muss, kann man sich die Einstellungen auch in einem Profil speichern.

Ist das Schloss offen, kann über die Diskette auf einem der fünf Profilslots gespeichert werden.

Das wars, ihr habt ein Profil angelegt.

- Starten mit Windows

Den meisten wird es wahrscheinlich ein Anliegen sein, nicht jedes Mal nach dem Hochfahren des Rechners nochmal gesondert Afterburner zu starten und das Profil zu laden. Daher bietet das Programm die Option dies gleich mit dem Starten von Windows zu tun.

Aber Achtung, ist das eingestellte Profil derart instabil, kann es dazu führen, dass Ihr nicht mehr ohne weiteres in den Afterburner kommt und es wieder anpassen könnt.

Daher aktiviert diese Option erst, wenn ihr sicher seid, dass die Settings stabil laufen.

Ein blau leuchtendes Windows Symbol zeigt an, dass ein Start mit Windows aktiv ist.

Die Option kann nur ausgewählt werden, wenn das Schloss „offen“ ist. Also genau wie das Speichern der Profile nochmals über einen Klick abgesichert.

Die GPU Core Spannung

Wie oben erwähnt, macht es durchaus Sinn sich auf eine GPU Spannung festzulegen.

Oft gibt es auch bereits Erfahrungswerte bei denen eine GPU bis wieviel eine GPU gefahrlos angesprochen werden kann oder besonders effizient arbeitet.

Dadurch spart man sich viel Zeit und kann direkt einen Wert wählen, der zum gewünschten Ergebnis führt.

Wie oben erwähnt, macht es durchaus Sinn sich auf eine GPU Spannung festzulegen.

Oft gibt es auch bereits Erfahrungswerte bei denen eine GPU bis wieviel eine GPU gefahrlos angesprochen werden kann oder besonders effizient arbeitet.

Dadurch spart man sich viel Zeit und kann direkt einen Wert wählen, der zum gewünschten Ergebnis führt.

System & Tools

Mein Rechner hat einen AMD 7600X mit 32GB RAM. Der Ram läuft mit XMP Settings bei 6000Mhz, bei der CPU wurde hingegen nichts im BIOS umgestellt.

Als Grafikkarte verwende ich besagte RTX4090FE.

Die Hardware ist in einem gut belüfteten Fractal Design Torrent verbaut.

Mein Monitor ist der Alienware AW3423DWF mit einer Auflösung von 3440 x 1440 Pixeln.

Vorweg: Es kommt zu keiner Zeit zu einem thermischen Limit. Das heißt, die erreichten Temperaturen liegen unter dem jeweiligen Temperaturlimit der Hardware. Es findet somit keine Drosselung aufgrund Temperatur statt.

Zum Justieren der Grafikkarte benutze ich den MSI Afterburner mit RivaTuner.

Der Afterburner ist ein mächtiges Tool, welches diverse Betriebsparameter ändern kann.

Der RivaTuner hingegen zeigt in einem Overlay allerlei Daten wie Chip Takt, GPU-Ausnutzung oder den Stromverbrauch.

Mein Rechner hat einen AMD 7600X mit 32GB RAM. Der Ram läuft mit XMP Settings bei 6000Mhz, bei der CPU wurde hingegen nichts im BIOS umgestellt.

Als Grafikkarte verwende ich besagte RTX4090FE.

Die Hardware ist in einem gut belüfteten Fractal Design Torrent verbaut.

Mein Monitor ist der Alienware AW3423DWF mit einer Auflösung von 3440 x 1440 Pixeln.

Vorweg: Es kommt zu keiner Zeit zu einem thermischen Limit. Das heißt, die erreichten Temperaturen liegen unter dem jeweiligen Temperaturlimit der Hardware. Es findet somit keine Drosselung aufgrund Temperatur statt.

Zum Justieren der Grafikkarte benutze ich den MSI Afterburner mit RivaTuner.

Der Afterburner ist ein mächtiges Tool, welches diverse Betriebsparameter ändern kann.

Der RivaTuner hingegen zeigt in einem Overlay allerlei Daten wie Chip Takt, GPU-Ausnutzung oder den Stromverbrauch.

Umfang

Um ein möglichst umfassendes Bild vom Verhalten der Grafikkarte darzustellen, werde ich im Afterburner verschiedene Ansätze einstellen.

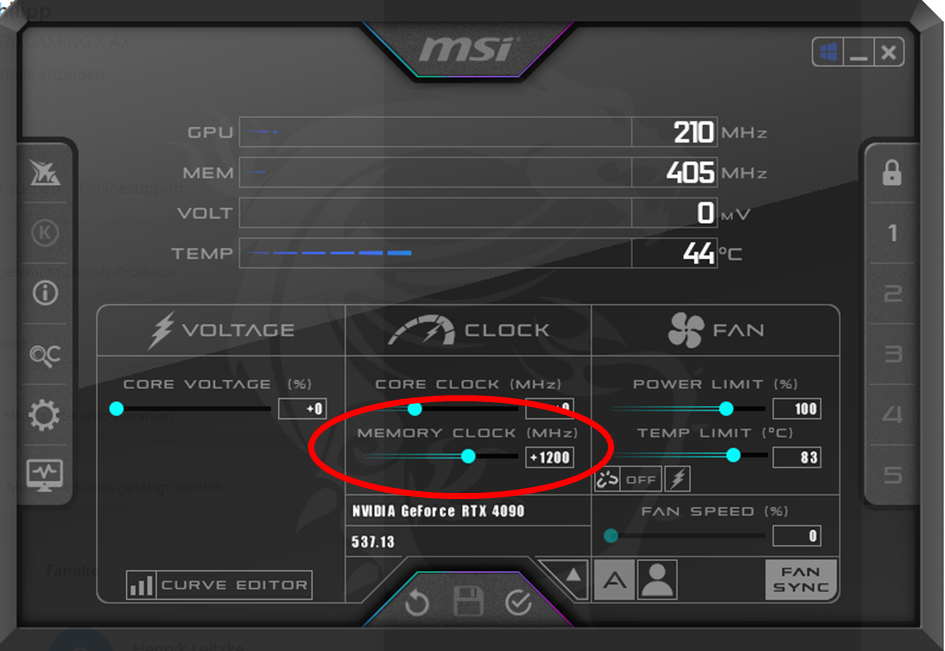

Beginnen werde ich mit einem einfachen Speicher-OC. Im zweiten Teil ändere ich das Power Target.

Zu guter Letzt untersuche ich das Verhalten bei manuellem OC/UV.

Diese verschiedenen Betriebspunkte werden ich jeweils in den folgenden Spielen durchbenchen:

Cyberpunk2077

Hogwarts Legacy

Last of us

Red Dead Redemption 2

Hitman 3

Online-Games habe ich aus dem Test entfernt, da diese eine größere Streuung der Ergebnisse gezeigt haben.

Die Auswahl soll eine möglichst breite Bandbreite an Engines abdecken, um so trotz 100% GPU-Auslastung verschiedene Lastpunkte abzudecken.

Die Spiele werden alle in MaxedOut Grafiksettings gespielt, da ich so die Grafikkarte möglichst fordere. Ein unerwartetes CPU-Limit würde unserem Ziel das Verhalten der Grafikkarte zu analysieren eher hinderlich sein.

Hier aber nochmal der Hinweis: Das ist kein Test unter Laborbedingungen. Mal war Discord/Chrome etc. im Hintergrund am Laufen, mal nicht. Es ist zudem kein klinisch reines Windows, sondern eben das, welches man nach einem Jahr Benutzung an manchen Ecken auch mal zugemüllt hat.

Ich habe zwar einige Plausibilitätsprüfungen gemacht, doch ist das kein Vergleich zu einem vergleichbar belastbaren Benchmarkparkour wie es beispielsweise ComputerBase macht.

Da ich aus meiner Vorrecherche weiß, dass ein besonders effizienter Betriebspunkt bei 875mV möglich ist, wird dieser auch als späterer Spannungswert verwendet.

Ein Erhöhen der Spannung bringt hingegen wenig und wird über ein höheres Power Target erreicht. Hier gäbe es zwar noch Potential, doch war mir das manuelle Erhöhen der Spannung bei einer RTX4090 doch etwas zu heikel.

Um ein möglichst umfassendes Bild vom Verhalten der Grafikkarte darzustellen, werde ich im Afterburner verschiedene Ansätze einstellen.

Beginnen werde ich mit einem einfachen Speicher-OC. Im zweiten Teil ändere ich das Power Target.

Zu guter Letzt untersuche ich das Verhalten bei manuellem OC/UV.

Diese verschiedenen Betriebspunkte werden ich jeweils in den folgenden Spielen durchbenchen:

Cyberpunk2077

Hogwarts Legacy

Last of us

Red Dead Redemption 2

Hitman 3

Online-Games habe ich aus dem Test entfernt, da diese eine größere Streuung der Ergebnisse gezeigt haben.

Die Auswahl soll eine möglichst breite Bandbreite an Engines abdecken, um so trotz 100% GPU-Auslastung verschiedene Lastpunkte abzudecken.

Die Spiele werden alle in MaxedOut Grafiksettings gespielt, da ich so die Grafikkarte möglichst fordere. Ein unerwartetes CPU-Limit würde unserem Ziel das Verhalten der Grafikkarte zu analysieren eher hinderlich sein.

Hier aber nochmal der Hinweis: Das ist kein Test unter Laborbedingungen. Mal war Discord/Chrome etc. im Hintergrund am Laufen, mal nicht. Es ist zudem kein klinisch reines Windows, sondern eben das, welches man nach einem Jahr Benutzung an manchen Ecken auch mal zugemüllt hat.

Ich habe zwar einige Plausibilitätsprüfungen gemacht, doch ist das kein Vergleich zu einem vergleichbar belastbaren Benchmarkparkour wie es beispielsweise ComputerBase macht.

Da ich aus meiner Vorrecherche weiß, dass ein besonders effizienter Betriebspunkt bei 875mV möglich ist, wird dieser auch als späterer Spannungswert verwendet.

Ein Erhöhen der Spannung bringt hingegen wenig und wird über ein höheres Power Target erreicht. Hier gäbe es zwar noch Potential, doch war mir das manuelle Erhöhen der Spannung bei einer RTX4090 doch etwas zu heikel.

Umsetzung an einer RTX4090FE

Genug Theorie, denn im zweiten Teil wird das Gelernte nun angewendet.

Ich erspare euch hässliche Exceltabellen, sondern stelle die gewonnenen Daten direkt als Grafen dar. Jede Darstellung wird zudem noch kurz beschrieben und anschließend diskutiert.

Das Speicher OC

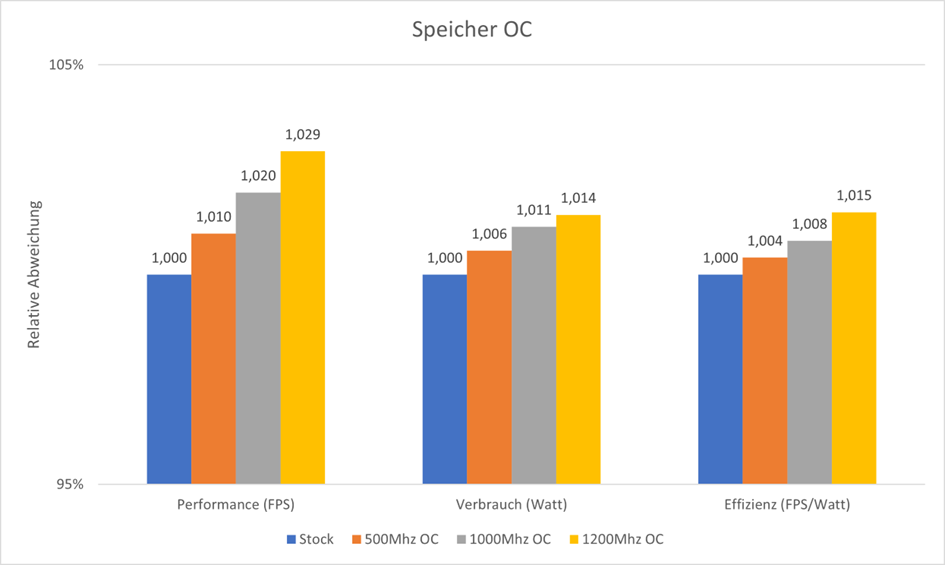

Zunächst wird im AfterBurner untersucht, was ein Ändern des Speichertakts für folgen hat.

Dieser läuft somit statt der standardmäßigen 10500Mhz auf 11700Mhz.

Die 1200Mhz sind der maximale Speichertakt, den ich ohne Abstürze habe einstellen können.

Der erreichbare Leistungsgewinn beträgt 3%. Dabei steigt der Verbrauch um etwa 1,4%.

Somit wird die Karte mit dem höher taktenden Speicher effizienter.

Zunächst wird im AfterBurner untersucht, was ein Ändern des Speichertakts für folgen hat.

Dieser läuft somit statt der standardmäßigen 10500Mhz auf 11700Mhz.

Die 1200Mhz sind der maximale Speichertakt, den ich ohne Abstürze habe einstellen können.

Der erreichbare Leistungsgewinn beträgt 3%. Dabei steigt der Verbrauch um etwa 1,4%.

Somit wird die Karte mit dem höher taktenden Speicher effizienter.

Das Ändern des PowerTarget

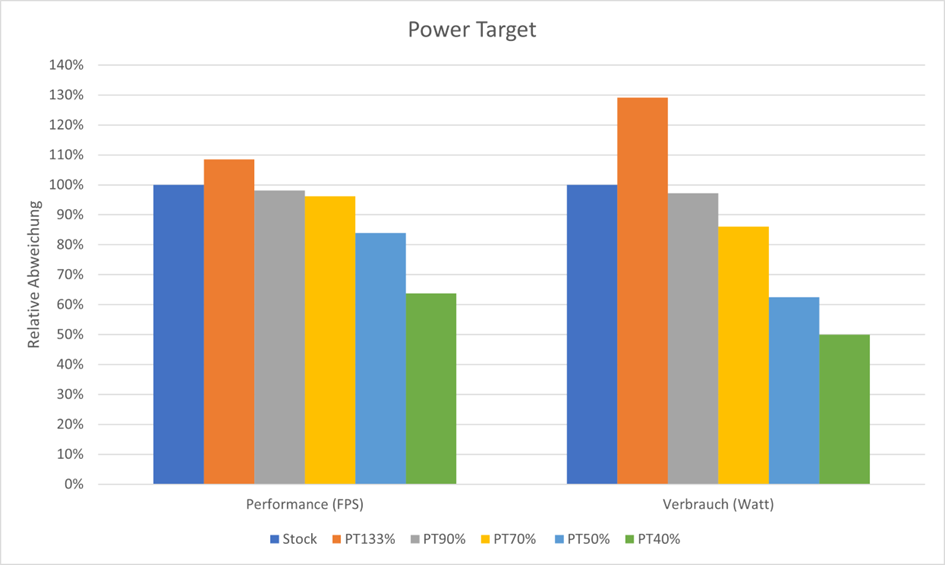

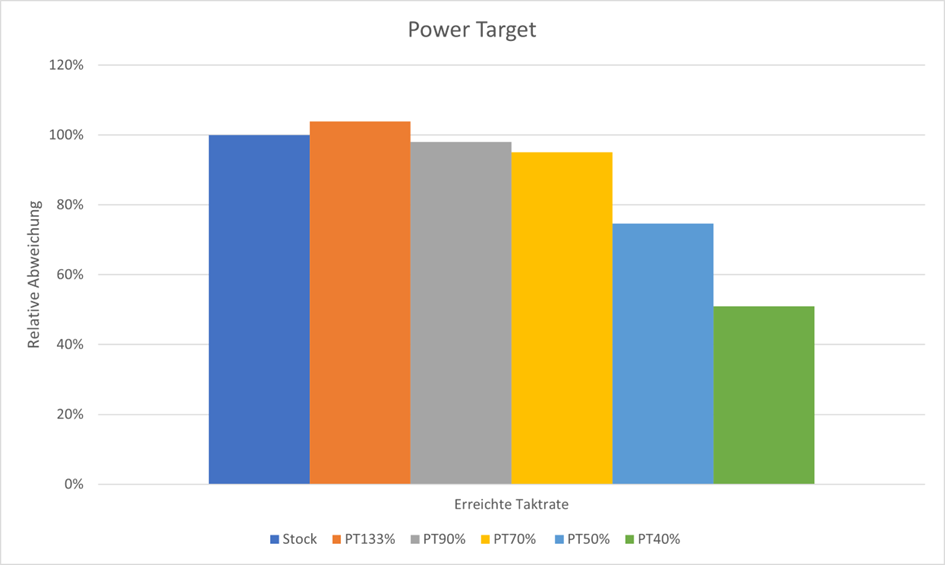

Meine Abstufungen hierbei sind: 40%, 50%, 70%, 100% und 133%.

Die 133% sind das Maximum, welches ich ohne weitere Eingriffe im Afterburner einstellen kann.

Ab einem PT von <70% zeigt sich wiederrum schon sehr deutlich, was mit der Leistung passiert.

Man erhält durch das höhere Power Target von 133% eine Mehrleistung von knapp 10%, der Verbrauch steigt hierbei aber um knapp 30%

Hier fällt auf, dass das Power Target nicht 1:1 auf den Verbrauch übertragbar ist. Das kommt daher, dass das Power Target nur für den Grafik-Chip selbst gilt. Jedoch nicht die Nebenverbraucher auf der Karte miteinbezieht.

So ergibt beispielsweise ein Power Target von 133% eine Verbrauchserhöhung um nur knapp 30%, ein Power Target von 40% senkt den Verbrauch jedoch nur auf etwa 50% des Ursprungswert.

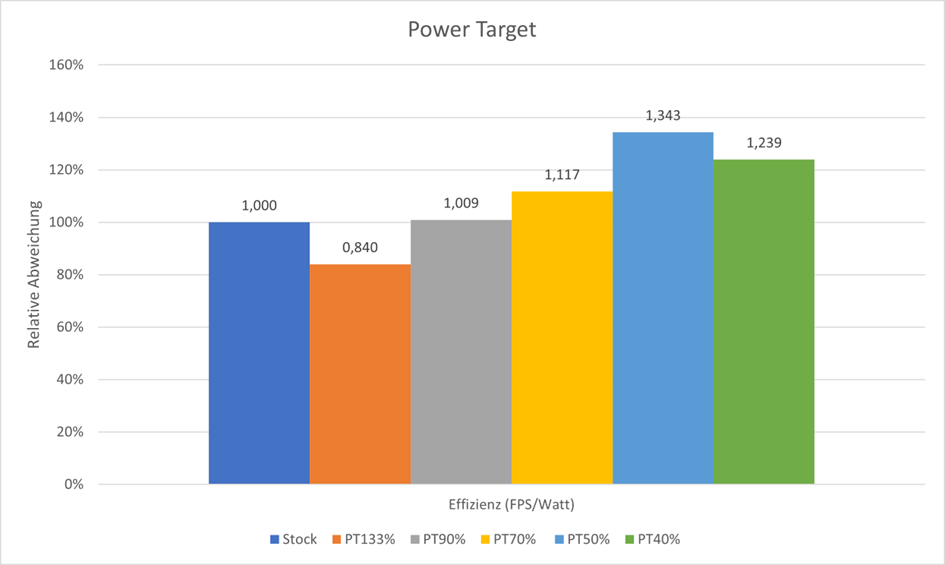

Setzt man diese Werte ins Verhältnis und betrachtet die Effizienz sieht man ein Ansteigen dieser bis zu einem Power Target von 50%.

Das ein PT von 40% senkt zwar noch weiter den Verbrauch, die erreichten Taktraten brechen jedoch ein.

Während der Takteinbruch bei einem Power Target von 70% noch recht klein ist, zeigt sich ab 50% ein enormer Verlust des Maximaltaktes.

Die erreichten Taktraten sind jedoch schnell irreführend, denn diese spiegeln nur den maximalen Takt wieder.

Die Performance wurde aber gemittelt gemessen. Bei fordernden Szenen bricht bei höheren PT der Takt jedoch nicht so stark ein.

Ein über den Benchmark gemittelter Takt wäre an der Stelle aussagekräftiger, jedoch sehen wir das Resultat ja in den erreichten FPS.

Es kann aber wie hier hilfreich sein, zu verstehen warum die Effizienz bei einem zu geringen Power Target nicht weiter steigt. Die Karte ist für diesen Betriebspunkt einfach nicht ausgelegt.

Meine Abstufungen hierbei sind: 40%, 50%, 70%, 100% und 133%.

Die 133% sind das Maximum, welches ich ohne weitere Eingriffe im Afterburner einstellen kann.

Ab einem PT von <70% zeigt sich wiederrum schon sehr deutlich, was mit der Leistung passiert.

Man erhält durch das höhere Power Target von 133% eine Mehrleistung von knapp 10%, der Verbrauch steigt hierbei aber um knapp 30%

Hier fällt auf, dass das Power Target nicht 1:1 auf den Verbrauch übertragbar ist. Das kommt daher, dass das Power Target nur für den Grafik-Chip selbst gilt. Jedoch nicht die Nebenverbraucher auf der Karte miteinbezieht.

So ergibt beispielsweise ein Power Target von 133% eine Verbrauchserhöhung um nur knapp 30%, ein Power Target von 40% senkt den Verbrauch jedoch nur auf etwa 50% des Ursprungswert.

Setzt man diese Werte ins Verhältnis und betrachtet die Effizienz sieht man ein Ansteigen dieser bis zu einem Power Target von 50%.

Das ein PT von 40% senkt zwar noch weiter den Verbrauch, die erreichten Taktraten brechen jedoch ein.

Während der Takteinbruch bei einem Power Target von 70% noch recht klein ist, zeigt sich ab 50% ein enormer Verlust des Maximaltaktes.

Die erreichten Taktraten sind jedoch schnell irreführend, denn diese spiegeln nur den maximalen Takt wieder.

Die Performance wurde aber gemittelt gemessen. Bei fordernden Szenen bricht bei höheren PT der Takt jedoch nicht so stark ein.

Ein über den Benchmark gemittelter Takt wäre an der Stelle aussagekräftiger, jedoch sehen wir das Resultat ja in den erreichten FPS.

Es kann aber wie hier hilfreich sein, zu verstehen warum die Effizienz bei einem zu geringen Power Target nicht weiter steigt. Die Karte ist für diesen Betriebspunkt einfach nicht ausgelegt.

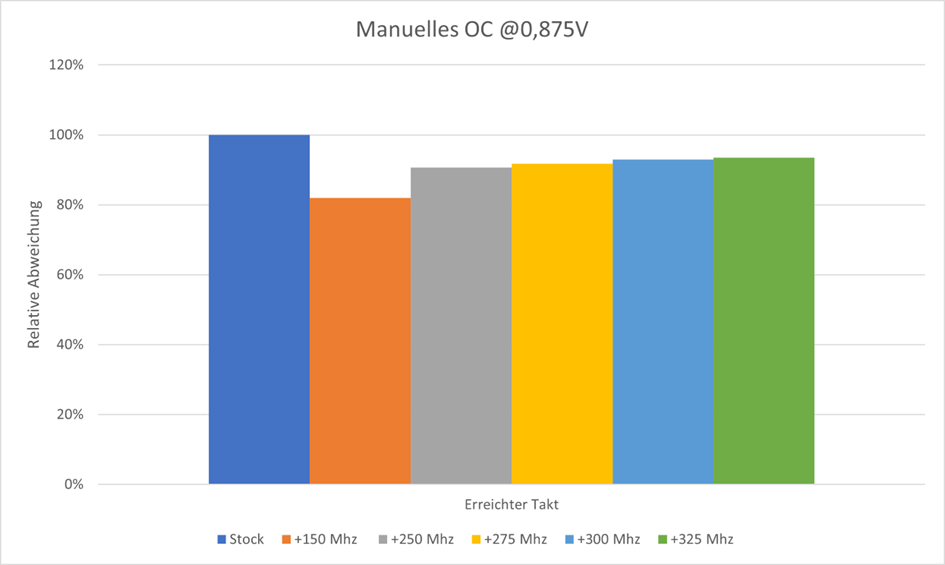

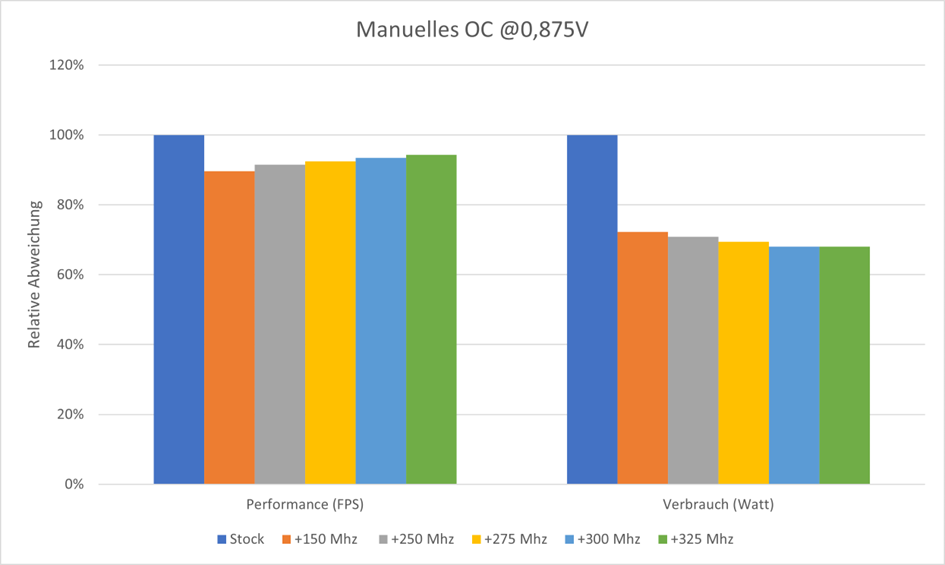

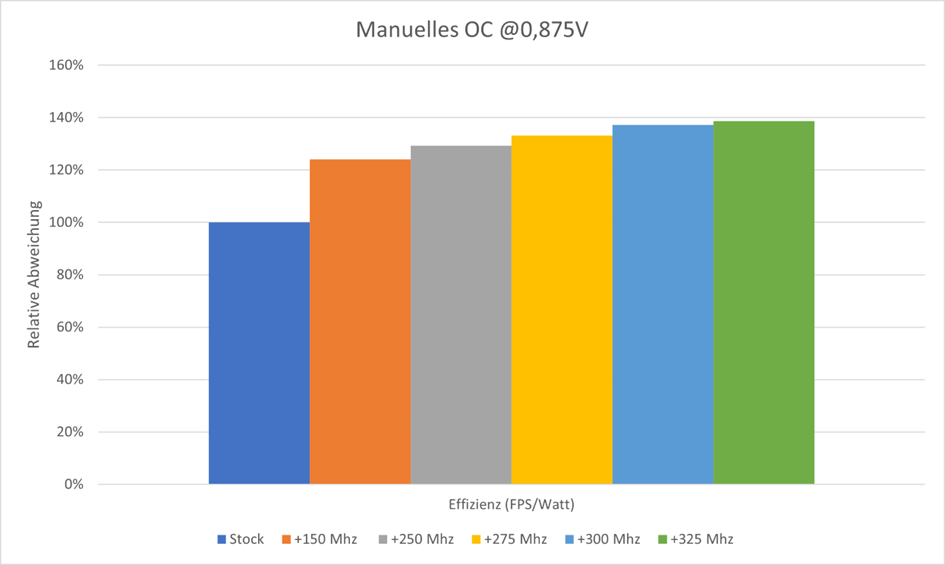

Das manuelle OC/UV

Hier ändere ich gleich zwei Sachen gleichzeitig. Zum einen stelle ich einen OffSet zum Standarttakt ein.

Gleichzeitig begrenze ich jedoch die der GPU zur Verfügung stehenden Spannung.

Um den Umfang von diesem Bericht nicht zu sprengen, habe ich mich auf den Wert von 0,875V festgelegt.

Hier ist der hinterlegte Takt/Spannungskurve zu sehen.

Mit steigendem Zieltakt steigt die angelegte Spannung. Die ausgegraute Linie zeigt die Standardkurve. Die helle mit Punkten dargestellte Linie meine angepasste Kurve.

Es wird somit nie versucht mehr als die hier eingestellten 2550Mhz zu erreichen, weshalb die maximale Voltage bei 0,875V bleibt.

Der eingestellte Takt wird jedoch so gut wie nie erreicht oder gar gehalten. Das Verhalten der Karte ist sehr komplex und würde an dieser Stelle viel zu tief ins Detail gehen.

Zusammenfassend kann man sagen, dass ich mich mit steigendem OffSet immer weniger Spannung dem Chip zugebe.

Bei einer zugelassenen Spannung von 0,875V erreiche ich maximal einen Offset von +325Mhz. Bei größeren OffSet reicht die Spannung nicht mehr aus und die Karte stürzt ab.

Jedoch ist der erreichbare Takt wie oben beschrieben kein gutes Mittel, um die Leistung zu bewerten.

Durch das Festriegeln der Maximalspannung auf 0,875V sinkt der Verbrauch. Da aber gleichzeitig immer höhere Taktraten aufgrund des steigenden Offsets erreicht werden, steigt hier auch die Leistung immer weiter.

Hier zeigt sich dann auch das Verhalten, was man bei einem klassischen UV erwarten würde. Je mehr ich mich von der ursprünglichen Takt/Spannungskurve entferne, desto effizienter kann die GPU arbeiten. Es wird so im Maximum eine knapp 40% höhere Effizienz erreicht.

Der höchste erreichte OffSet ist also in jeder betrachteten Disziplin den geringeren OffSet Werten überlegen.

Hier ändere ich gleich zwei Sachen gleichzeitig. Zum einen stelle ich einen OffSet zum Standarttakt ein.

Gleichzeitig begrenze ich jedoch die der GPU zur Verfügung stehenden Spannung.

Um den Umfang von diesem Bericht nicht zu sprengen, habe ich mich auf den Wert von 0,875V festgelegt.

Hier ist der hinterlegte Takt/Spannungskurve zu sehen.

Mit steigendem Zieltakt steigt die angelegte Spannung. Die ausgegraute Linie zeigt die Standardkurve. Die helle mit Punkten dargestellte Linie meine angepasste Kurve.

Es wird somit nie versucht mehr als die hier eingestellten 2550Mhz zu erreichen, weshalb die maximale Voltage bei 0,875V bleibt.

Der eingestellte Takt wird jedoch so gut wie nie erreicht oder gar gehalten. Das Verhalten der Karte ist sehr komplex und würde an dieser Stelle viel zu tief ins Detail gehen.

Zusammenfassend kann man sagen, dass ich mich mit steigendem OffSet immer weniger Spannung dem Chip zugebe.

Bei einer zugelassenen Spannung von 0,875V erreiche ich maximal einen Offset von +325Mhz. Bei größeren OffSet reicht die Spannung nicht mehr aus und die Karte stürzt ab.

Jedoch ist der erreichbare Takt wie oben beschrieben kein gutes Mittel, um die Leistung zu bewerten.

Durch das Festriegeln der Maximalspannung auf 0,875V sinkt der Verbrauch. Da aber gleichzeitig immer höhere Taktraten aufgrund des steigenden Offsets erreicht werden, steigt hier auch die Leistung immer weiter.

Hier zeigt sich dann auch das Verhalten, was man bei einem klassischen UV erwarten würde. Je mehr ich mich von der ursprünglichen Takt/Spannungskurve entferne, desto effizienter kann die GPU arbeiten. Es wird so im Maximum eine knapp 40% höhere Effizienz erreicht.

Der höchste erreichte OffSet ist also in jeder betrachteten Disziplin den geringeren OffSet Werten überlegen.

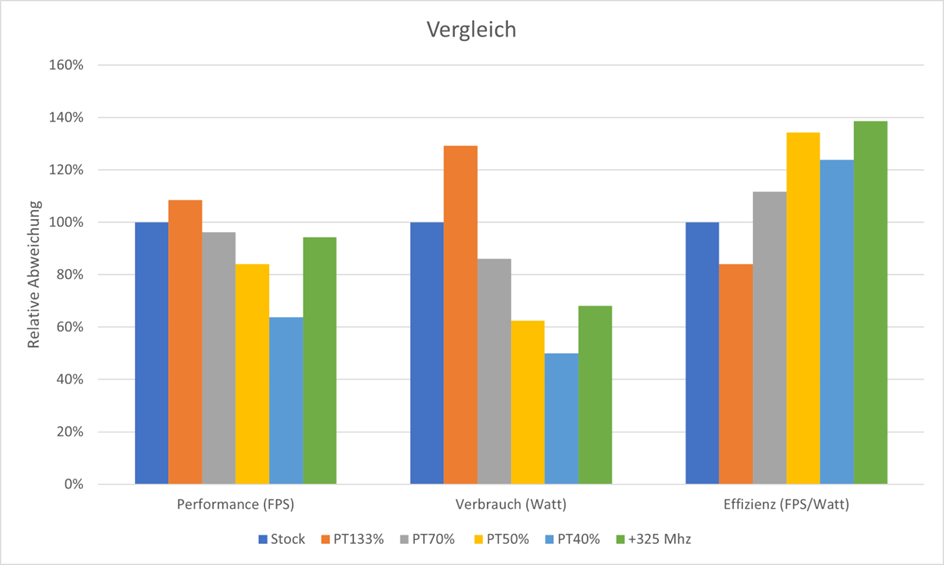

Vergleich und Auswertung der Betriebspunkte

Folgend werde ich die relevanten Betriebspunkte nochmals gegenüberstellen und die jeweiligen Vor- und Nachteile nennen.

Wer die maximale Leistung aus seiner Karte will, kommt kaum um ein Erhöhen des Power Limits herum. So können knapp 10% mehr aus der 4090 gekitzelt werden. Der Verbrauch steigt aber auch um etwa 30%. Man erhält damit deutlich die ineffizienteste Karte.

Das Power Target von 70% erreicht in etwa mit 94% Prozent der Performance in etwa das gleiche Niveau wie ein Spannungs-Offset von 325Mhz. Der Verbrauch sinkt aber mit -17% deutlich weniger gegenüber der OffSet Variante. Hier beträgt der Vorteil zur Referenz ganze -32%.

Wer mit 18% Leistungseinbußen leben kann, erhält mit einem Power Target von 50% einen sparsamen und effizienten Betriebspunkt. Doch auch hier ist beim Vergleich mit der OffSet Variante ratsam, da ähnliche Verbrauchsvorteile bei weniger Performanceverlust realisiert werden können.

Einzig ein Power Target von 40% zeigt nochmals einen merkbar geringeren Verbrauch. Jedoch bricht auch die Leistung überproportional ein.

Folgend werde ich die relevanten Betriebspunkte nochmals gegenüberstellen und die jeweiligen Vor- und Nachteile nennen.

Wer die maximale Leistung aus seiner Karte will, kommt kaum um ein Erhöhen des Power Limits herum. So können knapp 10% mehr aus der 4090 gekitzelt werden. Der Verbrauch steigt aber auch um etwa 30%. Man erhält damit deutlich die ineffizienteste Karte.

Das Power Target von 70% erreicht in etwa mit 94% Prozent der Performance in etwa das gleiche Niveau wie ein Spannungs-Offset von 325Mhz. Der Verbrauch sinkt aber mit -17% deutlich weniger gegenüber der OffSet Variante. Hier beträgt der Vorteil zur Referenz ganze -32%.

Wer mit 18% Leistungseinbußen leben kann, erhält mit einem Power Target von 50% einen sparsamen und effizienten Betriebspunkt. Doch auch hier ist beim Vergleich mit der OffSet Variante ratsam, da ähnliche Verbrauchsvorteile bei weniger Performanceverlust realisiert werden können.

Einzig ein Power Target von 40% zeigt nochmals einen merkbar geringeren Verbrauch. Jedoch bricht auch die Leistung überproportional ein.

Umsetzung an einer RTX3080Mobile (ASUS Zephyrus G15 2020)

Das Ergebnis der 3080Mobile hat mich damals dazu bewegt, diesen Artikel überhaupt erst zu schreiben.

Um den für mich idealen Betriebspunkt zu finden, benötigte es einige Schritte mehr als bei der RTX4090. Daher entschied ich mich, diesen Weg als zweites vorzustellen und den Leser so besser ans Thema heranzuführen.

Liest man RTX3080, denken die meisten wohl an das damalige Oberklassemodell aus dem Desktop. Das die mobile Variante dem nicht ganz entspricht, deutet vielleicht schon der Namenszusatz „Mobile“ an. Aber wie groß soll der Unterschied schon?

Nun, nachdem ich die ersten eigenen Benchmarks mit meinem damals neu gekauften Laptop durchgeführt hatte, kam die große Ernüchterung. Durchweg nur etwa 30-40% der Leistung, die von einer RTX3080 aus dem Desktop zu erwarten war. Also ganze 70% weniger als manch einer zunächst vermuten würde!

Dem Lüftergeräusch nach zu urteilen hätte ich aber einen Supercomputer erwarten dürfen. Schon kurz nach Spielstart wurde volle Drehzahl erreicht und gehalten. Gaming Laptops halt -.-

Ein Teil der Minderperformance lässt sich dadurch erklären, dass bei der mobilen Variante nicht der Chip der 3080, sondern der der 3070 verbaut wird. Die 3070 besitzt gegenüber etwa 20-25% weniger Performance. Zudem kommt der effizientere Betriebspunkt, der bewusst ein paar Mhz an Boosttakt rausnimmt, aber dafür eben effizienter arbeitet. Also grob 30% Minderleistung die gegenüber der Desktop RTX3080 zu erwarten wäre, statt beobachteter 70%.

Meine Suche nach der restlichen 40% begann.

Das Ergebnis der 3080Mobile hat mich damals dazu bewegt, diesen Artikel überhaupt erst zu schreiben.

Um den für mich idealen Betriebspunkt zu finden, benötigte es einige Schritte mehr als bei der RTX4090. Daher entschied ich mich, diesen Weg als zweites vorzustellen und den Leser so besser ans Thema heranzuführen.

Liest man RTX3080, denken die meisten wohl an das damalige Oberklassemodell aus dem Desktop. Das die mobile Variante dem nicht ganz entspricht, deutet vielleicht schon der Namenszusatz „Mobile“ an. Aber wie groß soll der Unterschied schon?

Nun, nachdem ich die ersten eigenen Benchmarks mit meinem damals neu gekauften Laptop durchgeführt hatte, kam die große Ernüchterung. Durchweg nur etwa 30-40% der Leistung, die von einer RTX3080 aus dem Desktop zu erwarten war. Also ganze 70% weniger als manch einer zunächst vermuten würde!

Dem Lüftergeräusch nach zu urteilen hätte ich aber einen Supercomputer erwarten dürfen. Schon kurz nach Spielstart wurde volle Drehzahl erreicht und gehalten. Gaming Laptops halt -.-

Ein Teil der Minderperformance lässt sich dadurch erklären, dass bei der mobilen Variante nicht der Chip der 3080, sondern der der 3070 verbaut wird. Die 3070 besitzt gegenüber etwa 20-25% weniger Performance. Zudem kommt der effizientere Betriebspunkt, der bewusst ein paar Mhz an Boosttakt rausnimmt, aber dafür eben effizienter arbeitet. Also grob 30% Minderleistung die gegenüber der Desktop RTX3080 zu erwarten wäre, statt beobachteter 70%.

Meine Suche nach der restlichen 40% begann.

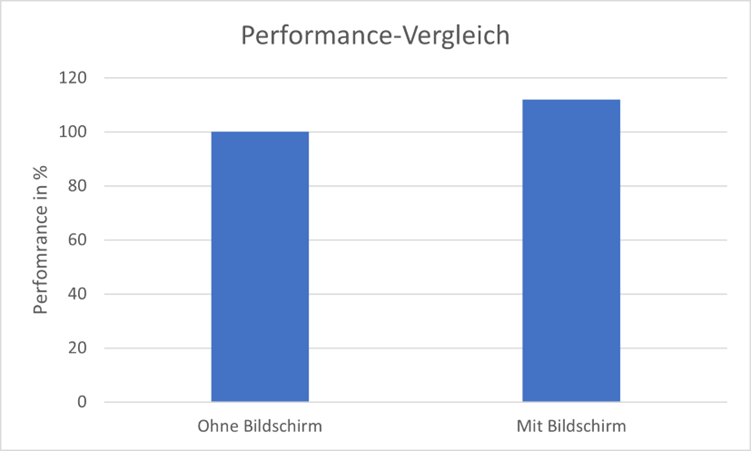

Das erste Limit

Nach mehreren Benchmarks und Tests, gab es eine große Auffälligkeit:

Zuhause hatte ich etwa 10% mehr Performance als bei meinen Eltern.

An der Temperatur konnte es nicht liegen, da das Dachgeschosszimmer meine Eltern definitiv wärmer war als meine damalige Wohnung.

Zuhause habe ich jedoch auf einen externen Monitor gespielt, bei meinen Eltern hatte ich nur den Laptop mit.

Beim Asus Zephyrus G15 ist der interne Monitor direkt mit der integrierten GPU-Einheit der AMD CPU verbunden. Ein sogenannter MUX-Switch fehlt.

Die 3080M muss daher immer durch die integrierte GPU zum Display kommunizieren.

Schließe ich aber einen Monitor an einen der USB-C Ausgänge an, kann die 3080M diesen direkt ansteuern. Die Performance steigt.

Dadurch kam ich der erwünschten Performance zwar näher, aber befriedigend fand ich die Situation nicht.

Nach mehreren Benchmarks und Tests, gab es eine große Auffälligkeit:

Zuhause hatte ich etwa 10% mehr Performance als bei meinen Eltern.

An der Temperatur konnte es nicht liegen, da das Dachgeschosszimmer meine Eltern definitiv wärmer war als meine damalige Wohnung.

Zuhause habe ich jedoch auf einen externen Monitor gespielt, bei meinen Eltern hatte ich nur den Laptop mit.

Beim Asus Zephyrus G15 ist der interne Monitor direkt mit der integrierten GPU-Einheit der AMD CPU verbunden. Ein sogenannter MUX-Switch fehlt.

Die 3080M muss daher immer durch die integrierte GPU zum Display kommunizieren.

Schließe ich aber einen Monitor an einen der USB-C Ausgänge an, kann die 3080M diesen direkt ansteuern. Die Performance steigt.

Dadurch kam ich der erwünschten Performance zwar näher, aber befriedigend fand ich die Situation nicht.

Das zweite Limit

Der Laptop bot mit der Asus-Software Armory Crate ein Tool an, mit dem man verschiedene Profile verwenden konnte. Im Wesentlichen änderten sich Lüfterkurve und zugelassene TDP.

Die TDP teilen sich beim Laptop CPU und GPU, da sie über Heatpipes am selben Kühlkörper hängen. Daher ist es üblich, dass der GPU eine fixes Power Limit zugestanden wird, die je nach Prozessorlast noch etwas höher liegen darf. So bleibt in Summe die Abwärme gleich und man kann das Kühlsystem maximal ausreizen.

In meinem Fall war das im TurboModus (maximale GPU Perfomance) ein Power Limit von 80W für die GPU und einem möglichen Boost von +25W.

Angezeigt wurde mir über AfterBurner jedoch stehts 75-80W, nie mehr.

Erst als ich Windows neu aufgesetzt und sämtliche Systemtools manuell installiert habe, schien das dynamische Aufteilen der geteilten Abwärmemenge zu funktionieren.

Mit nun 100-103W als GPU-Verbrauch stiegen auch die erreichten Taktraten von ehemals 1300Mhz auf etwa 1500Mhz.

Vergleicht man die 80W Power Limit mit anderen Geräten, die eine 3080M verbaut haben, dann ist das definitiv im unteren Bereich angesiedelt. Nvidia schein hier keine Vorgaben zu machen, da zwischen 80W-150W alles am Markt vertreten ist.

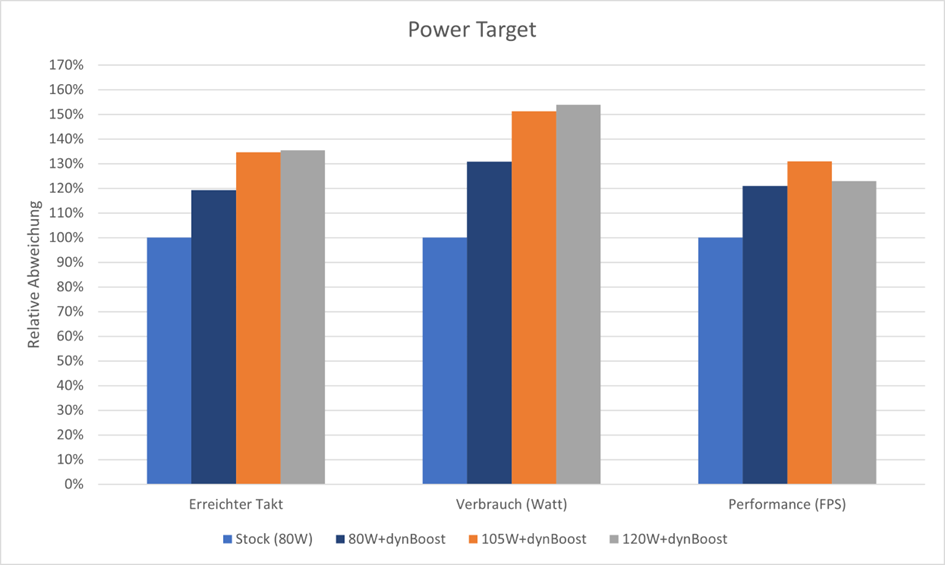

Ich entschloss mich, das Verhalten mit verschiedenen Power Limits besser zu verstehen und installierte zwei weitere BiosVersionen auf meine 3080M. Einmal mit 105W und einmal mit 120W.

Bis zu 105W(+dynBoost) lässt sich eine Verbesserung in Takt und Perfomance erkennen. Das 120W Bios schien jedoch Probleme zu haben.

Der maximale Takt konnte zwar noch leicht gesteigert werden, jedoch war die Leistung rückläufig. Ein Blick in den Taktverlauf zeigte das Problem jedoch recht schnell. Der Chip wurde zu warm. Das Kühlsystem wurde nun bedeutend mehr gefordert und schaffte es nicht mehr, die aufgerufene Wattage wegzuführen.

Der Laptop bot mit der Asus-Software Armory Crate ein Tool an, mit dem man verschiedene Profile verwenden konnte. Im Wesentlichen änderten sich Lüfterkurve und zugelassene TDP.

Die TDP teilen sich beim Laptop CPU und GPU, da sie über Heatpipes am selben Kühlkörper hängen. Daher ist es üblich, dass der GPU eine fixes Power Limit zugestanden wird, die je nach Prozessorlast noch etwas höher liegen darf. So bleibt in Summe die Abwärme gleich und man kann das Kühlsystem maximal ausreizen.

In meinem Fall war das im TurboModus (maximale GPU Perfomance) ein Power Limit von 80W für die GPU und einem möglichen Boost von +25W.

Angezeigt wurde mir über AfterBurner jedoch stehts 75-80W, nie mehr.

Erst als ich Windows neu aufgesetzt und sämtliche Systemtools manuell installiert habe, schien das dynamische Aufteilen der geteilten Abwärmemenge zu funktionieren.

Mit nun 100-103W als GPU-Verbrauch stiegen auch die erreichten Taktraten von ehemals 1300Mhz auf etwa 1500Mhz.

Vergleicht man die 80W Power Limit mit anderen Geräten, die eine 3080M verbaut haben, dann ist das definitiv im unteren Bereich angesiedelt. Nvidia schein hier keine Vorgaben zu machen, da zwischen 80W-150W alles am Markt vertreten ist.

Ich entschloss mich, das Verhalten mit verschiedenen Power Limits besser zu verstehen und installierte zwei weitere BiosVersionen auf meine 3080M. Einmal mit 105W und einmal mit 120W.

Bis zu 105W(+dynBoost) lässt sich eine Verbesserung in Takt und Perfomance erkennen. Das 120W Bios schien jedoch Probleme zu haben.

Der maximale Takt konnte zwar noch leicht gesteigert werden, jedoch war die Leistung rückläufig. Ein Blick in den Taktverlauf zeigte das Problem jedoch recht schnell. Der Chip wurde zu warm. Das Kühlsystem wurde nun bedeutend mehr gefordert und schaffte es nicht mehr, die aufgerufene Wattage wegzuführen.

Das dritte Limit

Das es Kühlsystem irgendwann an seine Grenzen kommt, war abzusehen. Jetzt kann der Kühlkörper in einem Laptop aber nicht einfach getauscht oder gar vergrößert werden.

Es half, mit einem Ventilator von unten gegen den Laptop zu blasen. Eine Dauerlösung war dies aber nicht.

Die einzige Möglichkeit die Kühlleistung nennenswert zu erhöhen war ein Neuanbringen der Wärmeleitpaste. Ich entschloss mich sowohl CPU als auch GPU mit Flüssigmetall zu versehen.

Als der Laptop dafür aufgeschraubt wurde, wurde auch schnell klar, dass die Kühlung nicht optimal laufen kann. Der Grafikchip wurde nur zur Hälfte benetzt und hatte somit weniger Kontaktfläche zum Kühlsystem.

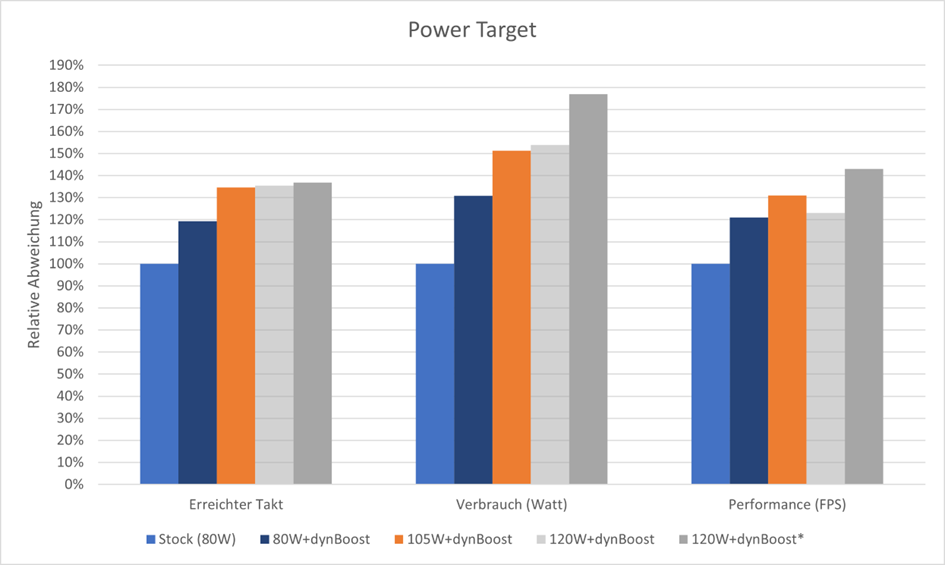

Nach erfolgreichem Re-Pasting (Aufrischen / Austauschen der Wärmeleitpaste) wurde auch sofort neu getestet:

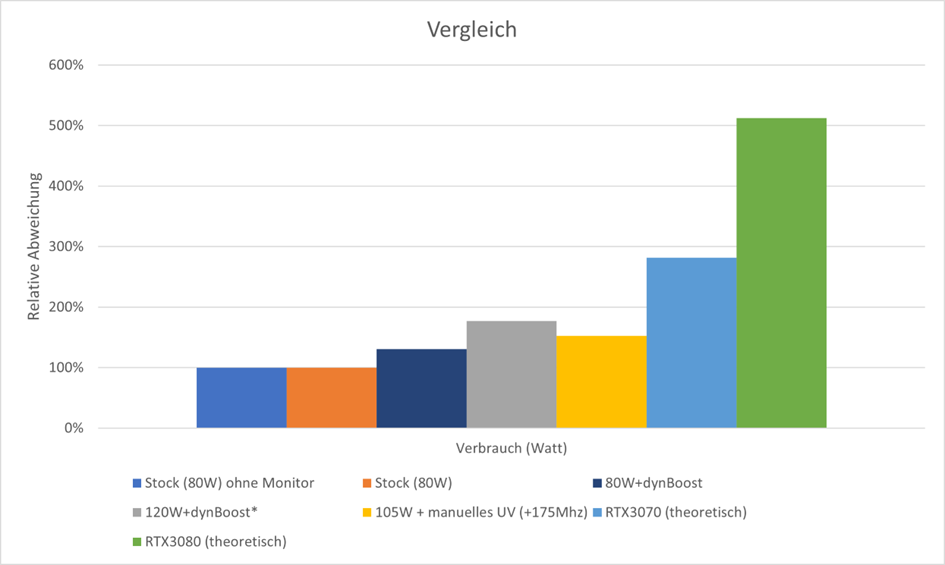

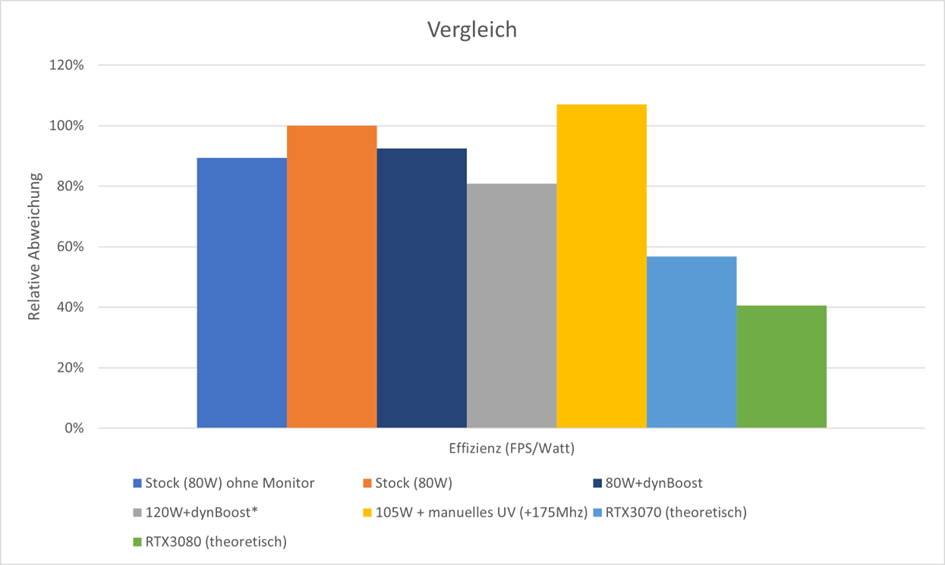

Der mit einem * markierte Wert (gelbe Balken) zeigt, dass nun auch das 120W-BIOS reibungslos funktioniert. Gute 40% Mehrperformance gegenüber dem (falsch funktionierendem) 80W-BIOS konnte zugelegt werden. Der Verbrauch stieg aber auch um 75% an.

Das es Kühlsystem irgendwann an seine Grenzen kommt, war abzusehen. Jetzt kann der Kühlkörper in einem Laptop aber nicht einfach getauscht oder gar vergrößert werden.

Es half, mit einem Ventilator von unten gegen den Laptop zu blasen. Eine Dauerlösung war dies aber nicht.

Die einzige Möglichkeit die Kühlleistung nennenswert zu erhöhen war ein Neuanbringen der Wärmeleitpaste. Ich entschloss mich sowohl CPU als auch GPU mit Flüssigmetall zu versehen.

Als der Laptop dafür aufgeschraubt wurde, wurde auch schnell klar, dass die Kühlung nicht optimal laufen kann. Der Grafikchip wurde nur zur Hälfte benetzt und hatte somit weniger Kontaktfläche zum Kühlsystem.

Nach erfolgreichem Re-Pasting (Aufrischen / Austauschen der Wärmeleitpaste) wurde auch sofort neu getestet:

Der mit einem * markierte Wert (gelbe Balken) zeigt, dass nun auch das 120W-BIOS reibungslos funktioniert. Gute 40% Mehrperformance gegenüber dem (falsch funktionierendem) 80W-BIOS konnte zugelegt werden. Der Verbrauch stieg aber auch um 75% an.

Das vierte Limit

Der Laptop verhielt sich nach dem Re-Pasting anders. Am auffälligsten war, dass die Lüfter im Laptop beim Idlen nicht mehr alle 5 Minuten zu pusten anfingen. Allgemein wurden viel geringere Drehzahlen in den Benchmarks benötigt. Der sonst immer laute Laptop (Mein erster Gaming-Laptop, die sind halt laut….) zeigt nun, dass es durchaus Abstufungen gibt.

Das führte dazu, dass ich selbst unter Kopfhörer das 120W-BIOS als störend laut empfand und ich mich daher für das 105W-BIOS entschied.

Da Geräuschmessungen eine Wissenschaft für sich sind und ich nicht annähernd das nötige Equipment zuhause habe, spare ich mir hier jegliche Messwerte.

Es war für mich einfach eine gefühlte Lautstärke, welche ich beim Laptop akzeptieren wollte.

Der Laptop verhielt sich nach dem Re-Pasting anders. Am auffälligsten war, dass die Lüfter im Laptop beim Idlen nicht mehr alle 5 Minuten zu pusten anfingen. Allgemein wurden viel geringere Drehzahlen in den Benchmarks benötigt. Der sonst immer laute Laptop (Mein erster Gaming-Laptop, die sind halt laut….) zeigt nun, dass es durchaus Abstufungen gibt.

Das führte dazu, dass ich selbst unter Kopfhörer das 120W-BIOS als störend laut empfand und ich mich daher für das 105W-BIOS entschied.

Da Geräuschmessungen eine Wissenschaft für sich sind und ich nicht annähernd das nötige Equipment zuhause habe, spare ich mir hier jegliche Messwerte.

Es war für mich einfach eine gefühlte Lautstärke, welche ich beim Laptop akzeptieren wollte.

Verschieben des dritten Limits (Manuelles UV/OC)

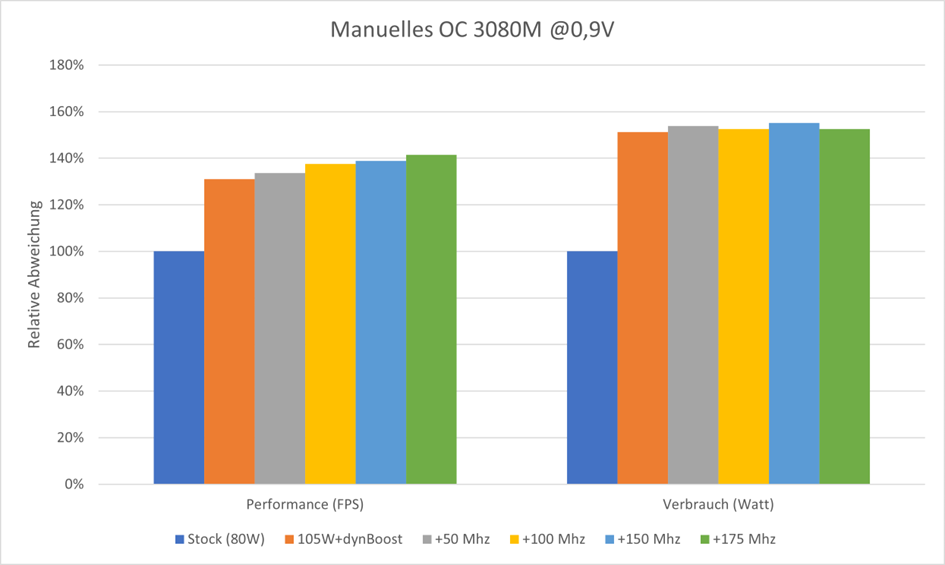

Um die 105W + ggf. dynamischen Boost noch besser auszunutzen, entschied ich mich dazu, die Takt/Spannungskurve anzupassen.

Ich habe eine Maximalspannung von 0,9V am GPU-Core eingestellt und mich in +50Mhz Schritten im Offset an die Mindestspannung herangetastet.

Weniger Spannung bedeutet auch weniger Stromverbrauch. Da wir limitiert vom Power Target sind, sollte dies in einer besseren Performance münden.

Die kleinen Abweichungen (1-3W) im Verbrauch sehe ich als Messungenauigkeit, anders kann ich es mir nicht erklären.

Die Performance zeigt aber wie zu erwarten einen deutlichen Trend. Bei einem Anheben der Takt/Spannungskurve von +200Mhz war Schluss und die Karte stürzte ab.

Mit einem OffSet von +175Mhz konnten gut +40% Mehrleistung gegenüber dem Ausgangszustand (Betrieb am Monitor) gewonnen werden.

Um die 105W + ggf. dynamischen Boost noch besser auszunutzen, entschied ich mich dazu, die Takt/Spannungskurve anzupassen.

Ich habe eine Maximalspannung von 0,9V am GPU-Core eingestellt und mich in +50Mhz Schritten im Offset an die Mindestspannung herangetastet.

Weniger Spannung bedeutet auch weniger Stromverbrauch. Da wir limitiert vom Power Target sind, sollte dies in einer besseren Performance münden.

Die kleinen Abweichungen (1-3W) im Verbrauch sehe ich als Messungenauigkeit, anders kann ich es mir nicht erklären.

Die Performance zeigt aber wie zu erwarten einen deutlichen Trend. Bei einem Anheben der Takt/Spannungskurve von +200Mhz war Schluss und die Karte stürzte ab.

Mit einem OffSet von +175Mhz konnten gut +40% Mehrleistung gegenüber dem Ausgangszustand (Betrieb am Monitor) gewonnen werden.

Vergleich der Betriebspunkte

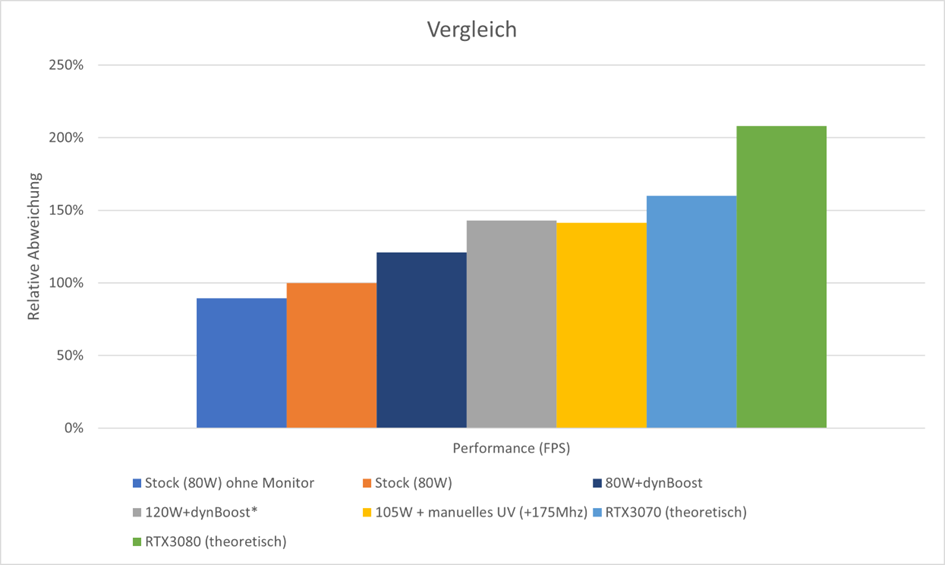

Nachdem diverse Limits identifiziert und verschoben wurden, wird es Zeit die erarbeiteten Betriebspunkte gegenüberzustellen.

Als Referenz habe ich den Betrieb am Monitor genommen. Ansonsten hätte ich für die Daten alle Schritte nochmal ohne Monitor erstellen müssen, was spätestens mit dem Re-Pasting nicht mehr möglich war.

Das 120W-BIOS wurde anders als das 105W-BIOS nicht nochmal mit einer UV-Kurve getunt, weswegen hier noch etwas mehr Leistung denkbar gewesen wäre. Jedoch war mir die Lautstärke hier einfach zu hoch.

Zudem habe ich für eine bessere Orientation noch eine RTX3070 & RTX3080 Founders Edition in die Übersicht eingefügt und die Messwerte für meine interpoliert. (Quelle CB Test)

Bei der absoluten Performance unter WQHD zeigt sich nochmal deutlich, warum ich anfangs so unglücklich war.

Der Umstand, dass nur mit externem Monitor die volle Leistung erzielt werden kann, hat mich überrascht. Themen wie MUX kannte ich aus dem Desktop noch nicht, sind aber für einen Gaming Laptop definitiv nicht unwichtig.

Mit größeren. funktionierendem Boost konnte die Performance um etwa 24% verbessert werden. Lässt man noch mehr Spielraum für den Verbrauch, sind sogar über 40% Mehrleistung möglich.

Die RTX3070 FE wird somit fast erreicht.

Eine RTX3080 FE aber wird von einer RTX3080Mobile selbst mit viel Tuning und Anpassungen nicht mal ansatzweise eingeholt und ist hinsichtlich der weit überlegen.

Auch beim Verbrauch führt die RTX3080 FE.

Hier zeigt sich, dass bei den mobilen Varianten einfach das Kühlsystem limitiert. Bei Leistungen über 150W können die Temperaturen nicht mehr im grünen Bereich gehalten werden, daher sind hier einfach Limits gesetzt.

Interessant ist aber, dass trotz ähnlicher Performance zum 120W-BIOS das 105W-BIOS mitsamt UV eine ganze Ecke weniger verbraucht.

Dieses Verhalten wird dann auch bei der Effizienz deutlich. Die angepasste Takt/Spannungskurve lässt das 105W-BIOS sogar effizienter laufen, als den deutlich niedriger taktenden 80W Betriebspunkt. Die Performance steigt hierbei stärker als es der Mehrverbrauch tut.

Allgemein sind alle Betriebspunkte der mobilen GPU effizienter als bei den Desktop Karten.

Das 120W-BIOS zeigt zwar die höchste Performance, aber auch die schlechteste Effizienz im Vergleich der Betriebspunkte untereinander.

Nachdem diverse Limits identifiziert und verschoben wurden, wird es Zeit die erarbeiteten Betriebspunkte gegenüberzustellen.

Als Referenz habe ich den Betrieb am Monitor genommen. Ansonsten hätte ich für die Daten alle Schritte nochmal ohne Monitor erstellen müssen, was spätestens mit dem Re-Pasting nicht mehr möglich war.

Das 120W-BIOS wurde anders als das 105W-BIOS nicht nochmal mit einer UV-Kurve getunt, weswegen hier noch etwas mehr Leistung denkbar gewesen wäre. Jedoch war mir die Lautstärke hier einfach zu hoch.

Zudem habe ich für eine bessere Orientation noch eine RTX3070 & RTX3080 Founders Edition in die Übersicht eingefügt und die Messwerte für meine interpoliert. (Quelle CB Test)

Bei der absoluten Performance unter WQHD zeigt sich nochmal deutlich, warum ich anfangs so unglücklich war.

Der Umstand, dass nur mit externem Monitor die volle Leistung erzielt werden kann, hat mich überrascht. Themen wie MUX kannte ich aus dem Desktop noch nicht, sind aber für einen Gaming Laptop definitiv nicht unwichtig.

Mit größeren. funktionierendem Boost konnte die Performance um etwa 24% verbessert werden. Lässt man noch mehr Spielraum für den Verbrauch, sind sogar über 40% Mehrleistung möglich.

Die RTX3070 FE wird somit fast erreicht.

Eine RTX3080 FE aber wird von einer RTX3080Mobile selbst mit viel Tuning und Anpassungen nicht mal ansatzweise eingeholt und ist hinsichtlich der weit überlegen.

Auch beim Verbrauch führt die RTX3080 FE.

Hier zeigt sich, dass bei den mobilen Varianten einfach das Kühlsystem limitiert. Bei Leistungen über 150W können die Temperaturen nicht mehr im grünen Bereich gehalten werden, daher sind hier einfach Limits gesetzt.

Interessant ist aber, dass trotz ähnlicher Performance zum 120W-BIOS das 105W-BIOS mitsamt UV eine ganze Ecke weniger verbraucht.

Dieses Verhalten wird dann auch bei der Effizienz deutlich. Die angepasste Takt/Spannungskurve lässt das 105W-BIOS sogar effizienter laufen, als den deutlich niedriger taktenden 80W Betriebspunkt. Die Performance steigt hierbei stärker als es der Mehrverbrauch tut.

Allgemein sind alle Betriebspunkte der mobilen GPU effizienter als bei den Desktop Karten.

Das 120W-BIOS zeigt zwar die höchste Performance, aber auch die schlechteste Effizienz im Vergleich der Betriebspunkte untereinander.

Fazit

Die knapp 40% höhere Effizienz die die 4090 bei manuellem OC/UV erreicht, zeigt wie viel Potential in manchen Karten schlummert. Die Leistung fällt dabei kaum nennenswert ab und der Lüfter bleibt eigentlich immer sehr leise. Man sollte jedoch genau wissen, was man tut, und ein bisschen Zeit investieren um das ganz individuelle Maximum aus seiner Karte rauskitzeln.

Bei der mobilen Variante der RTX3080Mobile hat sich gezeigt, dass manchmal unerwartete Limits die GPU ausbremsen können.

Eine nennenswert höhere Effizienz wie bei der 4090 konnte nicht erreicht werden.

Dafür konnte die Leistung in über 40% erhöht werden ohne das dabei die Effizienz gelitten hätte.

Um seinen ganz eigenen optimalen Betriebspunkt zu erreichen sollte zunächst geprüft werden, ob es Limits gibt, wo man sie zunächst nicht erwartet.

Kann man diese ausschließen, bieten sich besonders das Einstellen eines Power Target und das anpassen der Takt/Spannungskurve an.

Für Anfänger ist das verschieben des Power Target eine feine Sache. Es geht nichts kaputt und man zeigt einfach ob die Richtung in die man hin will.

Trotz der eher geringeren Effizienzsteigerungen beim Absenken des Power Targets eignet sich diese Methode jedoch nicht nur für Anfänger. Es kann auch als Ergänzung für weitere Betriebspunktoptimierungen genutzt werden.

Der Vorteil bei einer Kombination mit einen reduzierten Power Target kommt in manchen Hauptmenüs zum tragen. Hier werden oft Werte von vielen hundert FPS erreicht, die aber nur einen kleinen Teil der GPU-Recheneinheiten auslasten. Mit diesem unüblichen Lastpunkt wirkt die GPU oft überfordert und reagiert in solchen Menüs mit Spulenfiepen und einem Hochfahren der Lüfter.

Ein verringertes PowerTarget lässt hier die GPU nicht unnötig hochschießen und die Lüfter bleiben eher ruhig, das Spulenfiepen wird reduziert.

Am Beispiel der RTX4090 zwigt z.B. ein Power Target von 70% zeigt eine gute Effizienz bei ebenfalls vernachlässigbarer Minderleistung gegenüber dem Referenz-Betriebspunkt und ist somit meine Empfehlung für jeden, der sich nicht lange mit Details beschäftigen und einfach zocken will.

Man sollte es aber auch nicht übertreiben.

Unter einem Power Target von 50% kann die RTX4090 aber kaum noch ihre Stärken ausspielen. Das Korsett ist zu eng und der Chip kann sprichwörtlich nicht mehr richtig atmen. Jedoch kann es insbesondere in den heißen Sommertagen verlocken sein, die Abwärme auf unter 200W zu drosseln.

Wer mehr Leistung aus seiner RTX4090 holen will, kann das nur sehr begrenzt tun.

Nach oben ist kaum Luft, denn selbst eine TDP von 466W (350W*1,33) resultieren in nur geringen 10% Mehrleistung.

Ob es das für einen wert ist, muss jeder selbst entscheiden. An Rohleistung mangelt es der 4090 jedenfalls nicht.

Ein Speicher OC sollte in jedem Fall mitgenommen werden, da dies sowohl der Performance als auch der Effizienz zuträglich ist.

Ein FrameLimit macht aber in den meisten Fällen sowieso Sinn, weshalb man das ganze Thema hier nur on top sehen sollte.

Daher, Probieren geht über Studieren! Guckt selbst, was euch am besten taugt und passt eure GPU euren ganz persönlichen Vorlieben an!

Ich hoffe ich konnte euch Lesern einen groben Einblick in die Welt der Grafikkarten verschaffen. Ich freue mich auf Feedback und hoffentlich konstruktive Kritik.

Anhänge

Zuletzt bearbeitet: