Hallo zusammen,

ich habe eine Frage zur Dekodierungslatenz von Moonlight (als Client auf einem Android-TV).

Gestreamt wird von einem Ryzen 5/RX6650XT in 1440p. Alles läuft soweit wirklich gut und es gibt keine Lags. Ich hab als Client aber auch den PC meiner Frau ausprobiert und dort "fühlt" es sich noch einen ticken flüssiger an. Daher eine Frage zur Dekodierungslatenz von Moonlight:

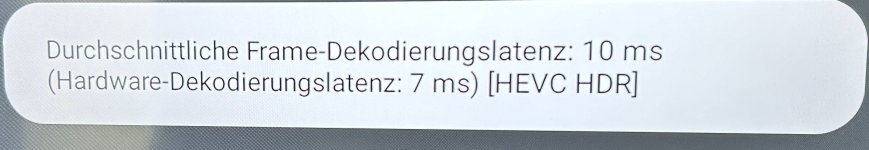

Auf dem Fernseher bekomme ich als Zusammenfassung den Screenshot 1 unten angezeigt. In 1440p ohne HDR liegt diese bei "Durchschnittliche Frame-Dekodierungslatenz: 10 ms; Hardware-Dekodierungslatenz: 7 ms).

Frage 1: Muss ich beide Zeiten addieren, also liegt die Gesamtdekodierungszeit bei 17ms oder sind die 7ms ein Teil der 10 ms, also Teil der durchschnittlichen Dekodierungslatenz"?

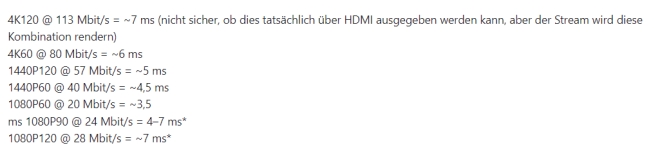

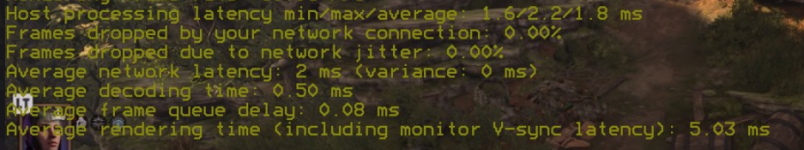

Frage 2: Bei GitHub werden in dem Thread beispielsweise Dekodierungslatenzen von einem Fire-TV-Stick angegeben, z.B. 1440P60 @ 40 Mbit/s = ~4,5 ms. Dies wäre dann deutlich schneller als mein Android-TV. Bei meiner Frau steht in der Anzeige aber mehr (Screenshot). Vergleichen muss ich lediglich die "Average decoding time", oder?

ich habe eine Frage zur Dekodierungslatenz von Moonlight (als Client auf einem Android-TV).

Gestreamt wird von einem Ryzen 5/RX6650XT in 1440p. Alles läuft soweit wirklich gut und es gibt keine Lags. Ich hab als Client aber auch den PC meiner Frau ausprobiert und dort "fühlt" es sich noch einen ticken flüssiger an. Daher eine Frage zur Dekodierungslatenz von Moonlight:

Auf dem Fernseher bekomme ich als Zusammenfassung den Screenshot 1 unten angezeigt. In 1440p ohne HDR liegt diese bei "Durchschnittliche Frame-Dekodierungslatenz: 10 ms; Hardware-Dekodierungslatenz: 7 ms).

Frage 1: Muss ich beide Zeiten addieren, also liegt die Gesamtdekodierungszeit bei 17ms oder sind die 7ms ein Teil der 10 ms, also Teil der durchschnittlichen Dekodierungslatenz"?

Frage 2: Bei GitHub werden in dem Thread beispielsweise Dekodierungslatenzen von einem Fire-TV-Stick angegeben, z.B. 1440P60 @ 40 Mbit/s = ~4,5 ms. Dies wäre dann deutlich schneller als mein Android-TV. Bei meiner Frau steht in der Anzeige aber mehr (Screenshot). Vergleichen muss ich lediglich die "Average decoding time", oder?