CPU

Lieutenant

- Registriert

- Jan. 2006

- Beiträge

- 704

Hallo Community,

mit dem neuen HTML5 Canvas-Objekt habe ich in JavaScript einen wirklich einfachen Renderer für 3D Objekte erstellt. Hier ist er: Anhang anzeigen 3d_fin.html.txt. Die Rotation der Objekte mit der Maus ist noch nicht so hübsch, aber das kommt noch.

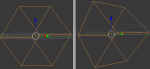

Auf jeden Fall möchte ich jetzt gerne diese Parallelprojektion in eine perspektivishe Projektion umwandeln. Also, dass das Bild für den Betrachter "natürlicher" aussieht. So (links die Parallelprojektion und rechts die gewünsche Projektion):

Aber im Netz kann ich kaum Ansatzpunkte finden, um meinen Renderer weiterzuentwickeln . Oder ich verstehe das alles falsch. Und daher erhoffe ich mir von Euch einen Anstoß wie ich weitermachen kann, um mein Ziel zu erreichen. Habt Ihr irgendwelche Ideen?

Viele Grüße,

CPU

mit dem neuen HTML5 Canvas-Objekt habe ich in JavaScript einen wirklich einfachen Renderer für 3D Objekte erstellt. Hier ist er: Anhang anzeigen 3d_fin.html.txt. Die Rotation der Objekte mit der Maus ist noch nicht so hübsch, aber das kommt noch.

Auf jeden Fall möchte ich jetzt gerne diese Parallelprojektion in eine perspektivishe Projektion umwandeln. Also, dass das Bild für den Betrachter "natürlicher" aussieht. So (links die Parallelprojektion und rechts die gewünsche Projektion):

Aber im Netz kann ich kaum Ansatzpunkte finden, um meinen Renderer weiterzuentwickeln . Oder ich verstehe das alles falsch. Und daher erhoffe ich mir von Euch einen Anstoß wie ich weitermachen kann, um mein Ziel zu erreichen. Habt Ihr irgendwelche Ideen?

Viele Grüße,

CPU