- Registriert

- Apr. 2008

- Beiträge

- 13.153

Dies ist ein ausgelagertes Thema aus diesem Hauptthread:

https://www.computerbase.de/forum/t...kussion-zu-spieletests.1728575/#post-20678303

Edit: Hitman wird in diesen Tests als Beispiel für eine FPS limitierung angeführt.

Das FPS Cap ist mit neueren Versionen aufgehoben und die 8 Kerne werden deutlich besser genutzt. Das erhöht die FPS von 87,5 auf 119,3 und ohne es neu getestet zu haben gehe ich davon aus, dass nun, wie bei dem i5, eine größere Abhängigkeit von der Ramgeschwindigkeit zu sehen wäre.

Edit2: Ich habe mir jetzt noch eine andere Szene in Marrakesh herausgesucht, auf die ich eventuell wechseln möchte. Und hier habe ich auch 3200 gegen 2133MHz mit dem Ryzen getestet und es ergeben sich tatsächlich große Unterschiede. Mit 2133 fallen die avg FPS von 105,9 +- 0,13 auf 83,64+-0,08 1/s.

Die 1% low von 73,32+-0,47 auf 57,12+-0.16.

Das sind 26,6% mehr FPS für 3200MHz ram und 28,4% mehr bei den 1%low.

Intro:

Nachdem ich zwölf Spiele getestet und einzeln untersucht habe, wollte ich hier zusammenfassend die Wichtigkeit von schnellem Ram allgemeiner betrachten.

Die Testkandidaten sind mein Ryzen 1800X mit 2x16GB DDR4 von 2133 bis 3200MHz und mein alter i5 3570K mit 2x8GB DDR3 von 1333 bis 1866MHz.

Jeweils mit meiner Vega64 LC(undervolted) gepaart.

Sämtliche im Bios einstellbaren Timings wurden für die höchste effektive Ram Taktrate optimiert und manuell festgesetzt(bei dem Ryzen Sytem könnte ich noch tRFC und FAW weiter optimieren, hatte aber keine Lust mehr ).

).

DDR3 ist CL11 12 11 28.... und DDR4 14 13 13 26 usw.

Das prozentuale ändern des Ram Taktes ändert also nicht nur die Peak Bandbreite sondern auch die Arbeitsgeschwindigkeit und die Latenzen des Ram linear.

Siehe dieser Vergleich der Leseraten:

Cinebench und Ram Geschwindigkeit meiner Systeme

Die erhobenen Daten sind aus dem März 2018 und sind sicher gegen Meltdown, aber ohne patches/Microcodeupdates gegen Spectre.

Windows 10 und Treiber waren aktuell, HPET aus, Energieoptionen auf Höchstleistung.

Die zwölf getesteten Spiele waren :

Ashes of the Singularity, Cities Skylines, Elex, Heroes of the Storm, Hitman, Prison Architect, Rome TW Barbarian Invasion, Rise of the Tomb Raider, Starcraft 2, Thief(vier), The Witcher 2, und The Witcher 3.

Spiel Einstellungen:

Hierbei habe ich mich nicht auf maximale FPS durch niedrige Auflösungen und Einstellungen konzentriert, sondern die Auflösung auf 1440p gelassen und nur in komplett CPU limiterten Spielen die maximalen Details genutzt.

Wo die Grafikkarte eine Rolle spielt, habe ich die Optionen individuell angepasst um einen guten Kompromiss aus Grafik und FPS um die 80-100 pro Sekunde zu finden.

Ich habe die Spiele also so eingestellt, wie ich sie selbst spielen würde und dann getestet welche Unterschiede sich bei diesen realen Situationen ergeben.

Die getesteten Szenen waren dabei natürlich so gewählt, dass sie für die CPU typisch bis besonders anspruchsvoll sind.

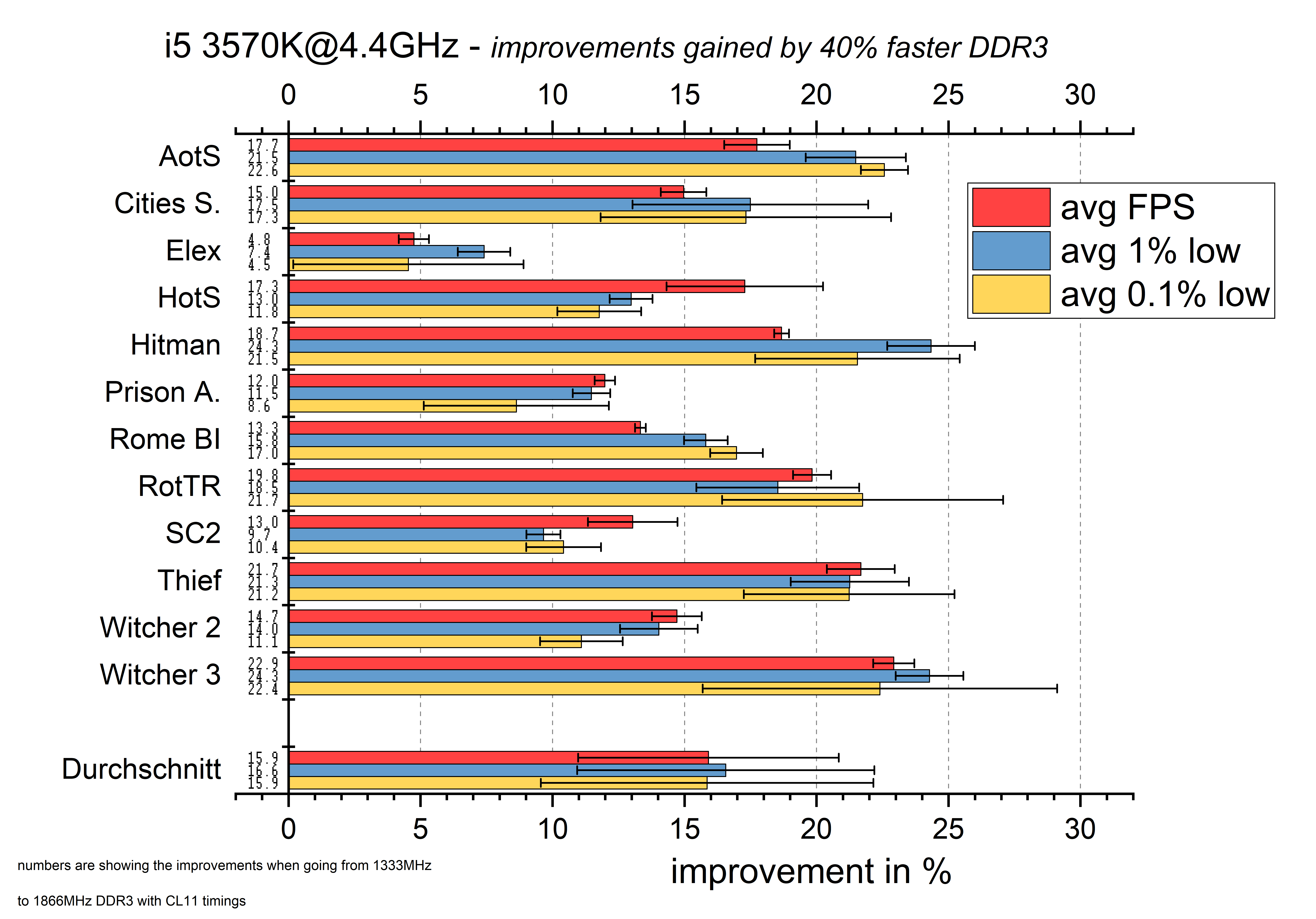

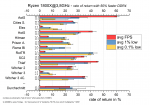

Prozentuale Verbesserung mit DDR3:

Für dieses Diagramm habe ich die prozentuale Verbesserung der Durchschnittlichen FPS, der 1% low Frametimes und der 0.1% Frametimes aufgetragen.

Die Verbesserung der avg FPS sagt uns wie viel mehr Frames herausgepumpt werden und die Frametimes Werte sagen, wie sich das Spielgefühl verbessert hat.

Die 0.1% low zeigen dabei mehr von den Ausreißern, sind aber schwerer zu reproduzieren. Deshalb sind die 1% low aus meiner Sicht ein guter Mittelweg.

Schauen wir uns die Spiele an, dann sehen wir, dass Elex nur sehr gering auf schnelleren Ram reagiert. Hier sind wir fast die ganze Zeit im GPU Limit und es gibt wenig Spielraum für Verbesserungen.

Die anderen Spiele zeigen grob Verbesserungen von 10% bis 22%.

Dabei profitieren die avg FPS und die Frametimes relativ ähnlich.

Um zu zeigen wie viel % Performancezuwachs man mit X% zusätzlicher Ramgeschwindigkeit erwarten kann, habe ich eine "Rendite" ausgerechnet.

Also Gewinn(Performancezuwachs im Spiel)/eingesetztes Kapital(zusätzliche Ramgeschwindigkeit)*100%.

An der generellen Verteilung hat sich natürlich nichts getan aber es erlaubt uns gleich einen besseren Vergleich zu DDR4 mit dem Ryzen System zu ziehen und gibt eine grobe Abschätzung, was man erwarten kann, wenn man seine DDR3 Geschwindigkeit nicht um 40% sondern um einen anderen Faktor ändert.

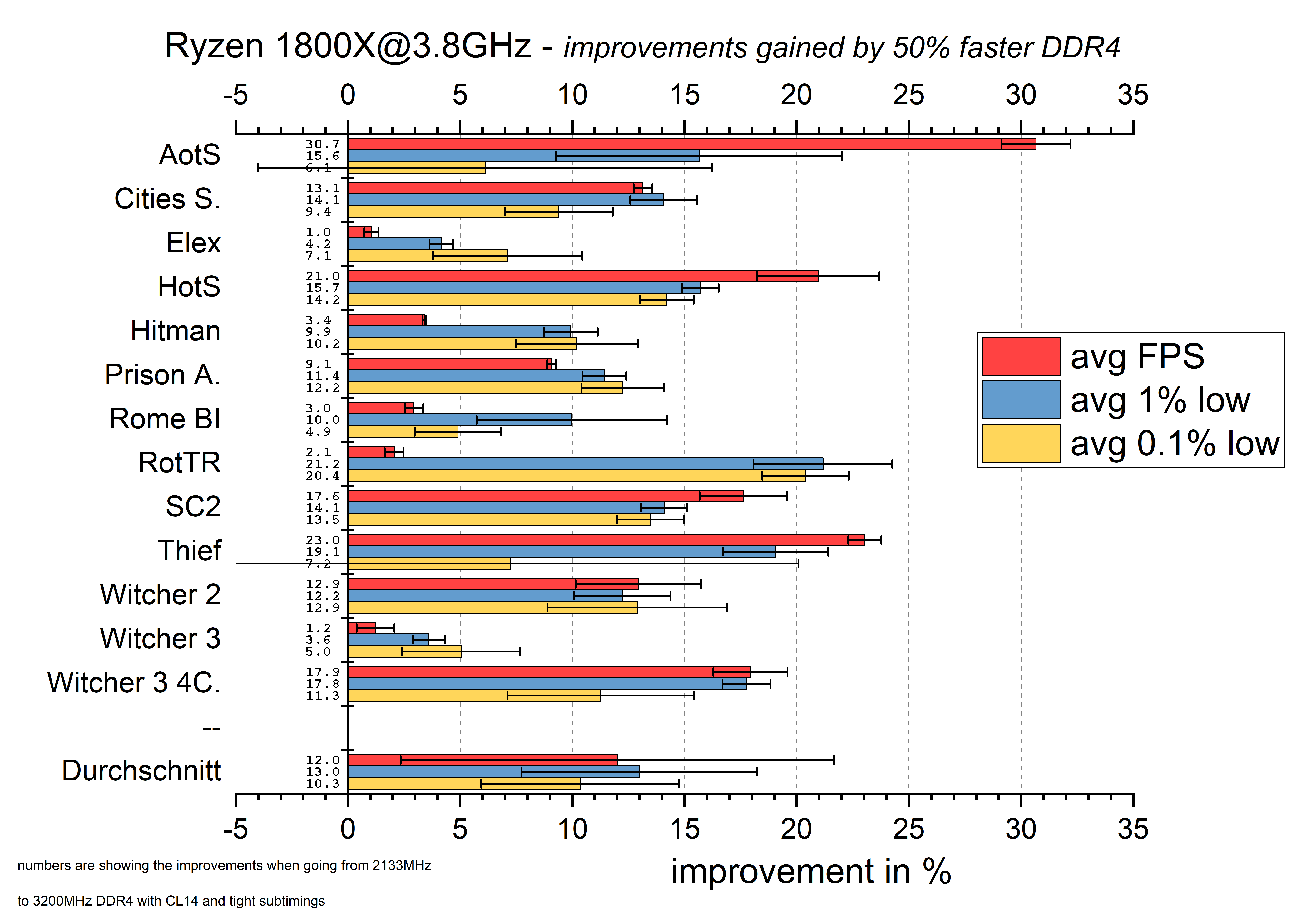

Prozentuale Verbesserung mit DDR4:

Hier zeigen sich deutlich größere Schwankungen von Spiel zu Spiel.

Wie schon bei dem i5, sieht man bei Elex das GPU limit.

Ashes of the Singularity zeigt große Verbesserungen der avg FPS, jedoch keine zuverlässige Verbesserung der 0.1% low.

Die Reproduzierbarkeit ist leider zu schlecht.

Rome BI reagiert sehr schlecht auf den DDR4 Speicher, obwohl hier definitiv kein GPU limit vorliegt.

Vermutlich ist DDR4 generell deutlich schneller als benötigt und daher bleiben die Zuwächse klein.

Hitman läuft in ein FPS limit, RotTR und The Witche 3 laufen mit den 8 Kernen fast immer ins GPU limit.

Es zeigt sich jedoch schön, wie das Ram OC trotzdem etwas bringt, weil sich die Frametimes weiterhin verbessern.

Die anderen Spiele und The Witcher 3 mit nur 4 Zen Kernen profitieren grob um die 10 bis 17%

Da ich hier von DDR4 Basistakt 2133 zu teuren 3200 MHz springe möchte ich darauf hinweisen, dass der Verlauf dazwischen nicht immer linear ist.

In der Regel verbessern sich die wichtigen Frametimes stärker von 2133 zu 2666 als von 2666 zu 3200.

Beispiel linear:

Beispiel Frametimes sättigend:

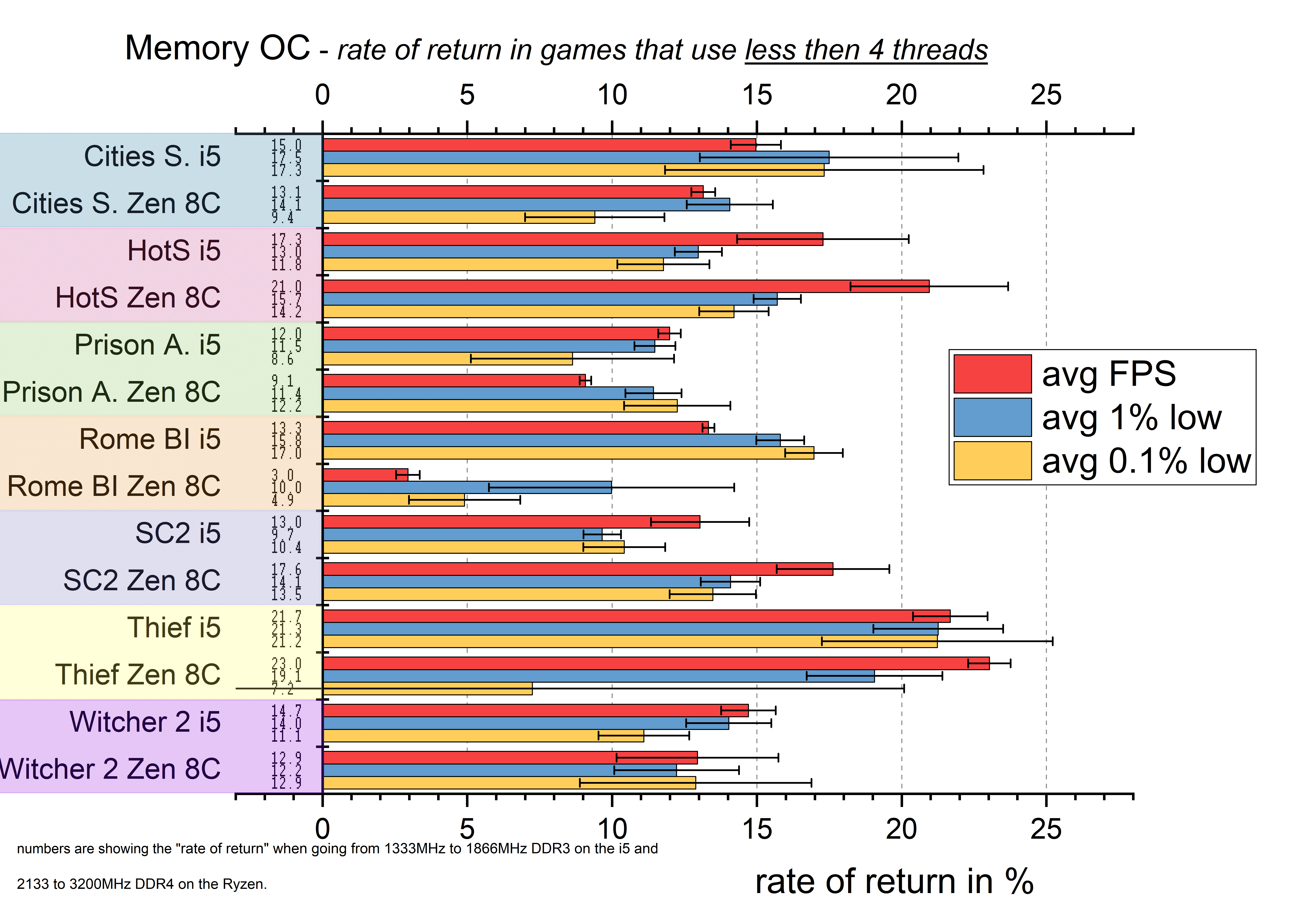

Vergleich von DDR3 und DDR4:

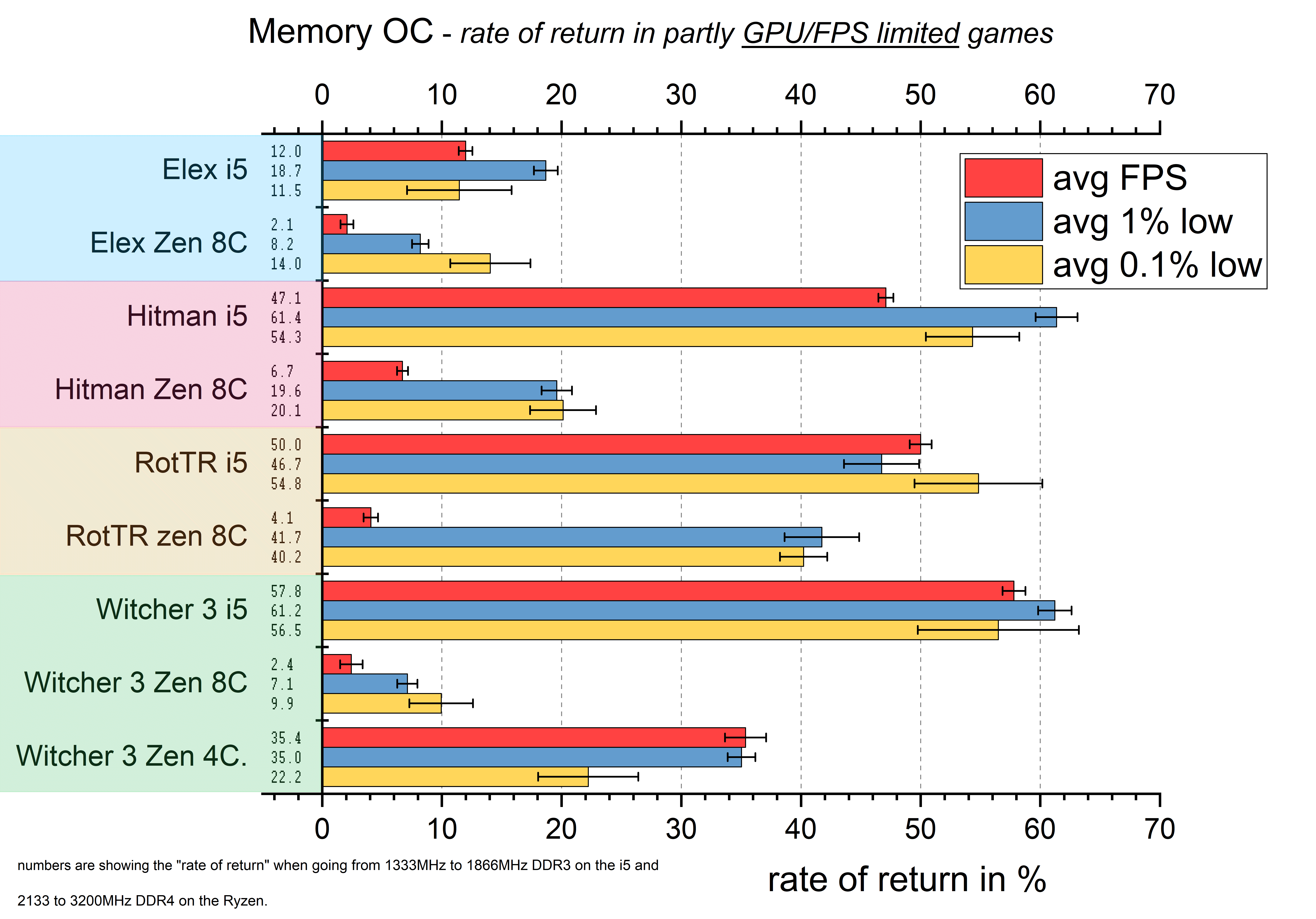

Hier möchte ich die Spiele in zwei Gruppen teilen.

Einmal die Spiele, die nur bis zu 4 CPU Threads nutzen und daher nicht von den 8 Kernen und 16 Threads des Ryzen 1800X profitieren.

Und dann die Spiele, die mehr Threads nutzen können und in meiner Auswahl auf 8 Kernen in ein GPU oder FPS limit laufen.

Den Ashes of the Singularity CPU-Benchmark habe ich ausgeklammert, da er in keine der zwei Gruppen passt. Hier hilft das Ram OC vor allem den avg FPS, selbst die 16 Threads werden zu 80%+ ausgelastet und die Frametimes profitieren geringer, weil das Spiel scheinbar immer unreproduzierbare Frametimepeaks hat.

Fangen wir mit den Spielen ohne gute Multithreadunterstützung an:

Ich vergleiche hier wieder die Rendite, also wie viel von dem prozentualen Geschwindigkeitszuwachs des Rams, in prozentuale Performance in den verschiedenen Spielen umgesetzt wird.

Mit Ausname von Rome Barbarian Invasion, das auf dem Ryzen deutlich weniger mit dem schnellem Ram gewinnt, sind die Unterschiede zwischen dem ivy Bridge und dem Zen System gering.

Der i5 mit DDR3 gewinnt mehr in Cities Skylines und The Witcher 2.

Der Ryzen 1800X mit DDR4 gewinnt mehr in Heroes of the Storm und Starcraft 2.

Bei Thief und Prison Architect ist es schwer zu sagen, auch weil die 0.1% zu ungenau sind.

Gucken wir uns jetzt die limitierten Spiele an:

Hier gewinnt eigentlich immer der i5 mit DDR3 stärker.

Für den Ryzen zeigt sich in allen vier Spielen ein nur geringer Einfluss auf die avg FPS, was logisch ist, weil nicht die CPU das alleinige Limit darstellt und der schnellere Ram nur hilft sich näher an dieses Limit heranzuschmiegen.

Gerade in Rise of the Tomb Raider und Hitman, verbessern sich die Frametimes jedoch deutlich und auch Elex und The Witcher 3 zeigen mehr Verbesserung bei den Frametimes als bei den avg FPS.

Ganz unten habe ich noch die Werte für Ryzen limitiert auf 4 Kerne und 4 Threads in The Witcher 3 hinzugefügt.

Hier sieht man nun deutliche Verbesserungen durch schnellen Ram, weil wir uns wieder mehr Richtung CPU limit verschieben.

Der i5 profitiert jedoch weiterhin deutlich mehr.

Bewertung von Gerüchten:

Ich würde mir natürlich Vergleichsdaten zu einem aktuellen Intel System wünschen, die Vergleiche zu DDR3 fand ich allerdings auch sehr interessant.

Als ich damals meinen i5 3570K gekauft habe war in CB und anderen Foren noch die festsitzende Meinung, dass schneller Ram(damals eben DDR3) nichts bringt und man höchstens 1600er nehmen sollte wenn der Aufpreis ganz gering ist.

Bei den neueren Intel CPUs hat sich diese Meinung größtenteils gehalten und erst mit Ryzen meinten dann plötzlich alle(also gefühlt alle ). Dass Ryzen schnellen Ram braucht weil sonst der Infinity Fabric limitert.

). Dass Ryzen schnellen Ram braucht weil sonst der Infinity Fabric limitert.

Ohne hier intensiv auf den IF eingehen zu wollen, habe ich nicht die Erfahrung gemacht, dass man schnellen Ram braucht um den IF zu beschleunigen!

Der IF zeigt sich zwar leicht hinderlich, Geschwindigkeitszuwächse duch schnellen Ram würde ich jedoch nicht auf diese Eigenart von Ryzen schieben sondern einfach durch verringerte Wartezeiten für die CPU erklären.

Fazit:

Schneller OC Ram bringt viel mehr als in der Vergangenheit behauptet wurde.

Der Ivy Bridge i5 profitiert sogar oft mehr als die Ryzen 1000er Serie.

Die Vorteile liegen sind natürlich vor allem im CPU Limit(System Limit, Software Limit wie auch immer ihr etwas bezeichnen wollt, was nicht GPU Limit oder Nachladeruckler ist) zu sehen.

Trotz GPU Limit oder FPS Limit haben sich die Frametimes teils deutlich verbessert.

Damit hatte ich selbst nicht gerechnet.

So langsam ändert sich die Einstellung zu schnellem Ram ja sogar auf CB, wobei meiner Meinung nach inzwischen, in den Kaufberatungen schon fast etwas über das Ziel hinaus geschossen wird.

Von 2133MHz rate ich zwar ab, jedoch halte ich 2666/2800 durchaus für eine legitime Kaufempfehlung solange ordentliche Timings von CL14/15 benutzt werden.

Einige Spiele profitieren deutlich von schnellerem Ram und profitieren auch noch bis 3200MHz ohne eine Sättigung zu zeigen...potentiell also noch darüber hinaus.

Ich konnte meine Timings mit 3333MHz leider noch nicht richtig stabil bekommen. Da bräuche ich wohl singel ranked ram, oder mehr Mut bei den Spannungen .

.

Der Aufpreis für 3000MHz+ sind oft so, dass man bei begrenztem Budget lieber in andere Komponenten investieren sollte und die hohen Ramtaktraten überstrahlen oft die schlechten Timings und bringen dann im Endeffekt nicht viel.

Ein häufiger Fehler bei bisherigen Tests zur Ram Skalierung.

Da werden oft verschiedene Ram Kits mit ganz anderen Timings oder zumindest anderen Subtimings verwendet.

Wer eh schon eine schnelle CPU hat, sollte sich jedoch am Ram OC versuchen und schnellen Ram kaufen.

Gerne würde ich noch Samsung B single ranked Ram kaufen und mit meinem dual ranked ram vergleichen....

Und Hynix Ram kaufen um zu sehen ob ich den schnell hinbekomme.

Und einen 2700X kaufen und einen 1200.....und ein X470 MB, Und einen neuen Intel.....nur erscheint mir das etwas zu teuer für so ein Hobby.

Eventuell mache ich manches spontan doch....mal sehen

Was sind eure Meinungen dazu?

Habt ihr Verbesserungsvorschläge oder wollt ihr besimmte Sachen sehen, die ich hier nicht behandelt habe?

https://www.computerbase.de/forum/t...kussion-zu-spieletests.1728575/#post-20678303

Edit: Hitman wird in diesen Tests als Beispiel für eine FPS limitierung angeführt.

Das FPS Cap ist mit neueren Versionen aufgehoben und die 8 Kerne werden deutlich besser genutzt. Das erhöht die FPS von 87,5 auf 119,3 und ohne es neu getestet zu haben gehe ich davon aus, dass nun, wie bei dem i5, eine größere Abhängigkeit von der Ramgeschwindigkeit zu sehen wäre.

Edit2: Ich habe mir jetzt noch eine andere Szene in Marrakesh herausgesucht, auf die ich eventuell wechseln möchte. Und hier habe ich auch 3200 gegen 2133MHz mit dem Ryzen getestet und es ergeben sich tatsächlich große Unterschiede. Mit 2133 fallen die avg FPS von 105,9 +- 0,13 auf 83,64+-0,08 1/s.

Die 1% low von 73,32+-0,47 auf 57,12+-0.16.

Das sind 26,6% mehr FPS für 3200MHz ram und 28,4% mehr bei den 1%low.

Intro:

Nachdem ich zwölf Spiele getestet und einzeln untersucht habe, wollte ich hier zusammenfassend die Wichtigkeit von schnellem Ram allgemeiner betrachten.

Die Testkandidaten sind mein Ryzen 1800X mit 2x16GB DDR4 von 2133 bis 3200MHz und mein alter i5 3570K mit 2x8GB DDR3 von 1333 bis 1866MHz.

Jeweils mit meiner Vega64 LC(undervolted) gepaart.

Sämtliche im Bios einstellbaren Timings wurden für die höchste effektive Ram Taktrate optimiert und manuell festgesetzt(bei dem Ryzen Sytem könnte ich noch tRFC und FAW weiter optimieren, hatte aber keine Lust mehr

DDR3 ist CL11 12 11 28.... und DDR4 14 13 13 26 usw.

Das prozentuale ändern des Ram Taktes ändert also nicht nur die Peak Bandbreite sondern auch die Arbeitsgeschwindigkeit und die Latenzen des Ram linear.

Siehe dieser Vergleich der Leseraten:

Cinebench und Ram Geschwindigkeit meiner Systeme

Die erhobenen Daten sind aus dem März 2018 und sind sicher gegen Meltdown, aber ohne patches/Microcodeupdates gegen Spectre.

Windows 10 und Treiber waren aktuell, HPET aus, Energieoptionen auf Höchstleistung.

Die zwölf getesteten Spiele waren :

Ashes of the Singularity, Cities Skylines, Elex, Heroes of the Storm, Hitman, Prison Architect, Rome TW Barbarian Invasion, Rise of the Tomb Raider, Starcraft 2, Thief(vier), The Witcher 2, und The Witcher 3.

Spiel Einstellungen:

Hierbei habe ich mich nicht auf maximale FPS durch niedrige Auflösungen und Einstellungen konzentriert, sondern die Auflösung auf 1440p gelassen und nur in komplett CPU limiterten Spielen die maximalen Details genutzt.

Wo die Grafikkarte eine Rolle spielt, habe ich die Optionen individuell angepasst um einen guten Kompromiss aus Grafik und FPS um die 80-100 pro Sekunde zu finden.

Ich habe die Spiele also so eingestellt, wie ich sie selbst spielen würde und dann getestet welche Unterschiede sich bei diesen realen Situationen ergeben.

Die getesteten Szenen waren dabei natürlich so gewählt, dass sie für die CPU typisch bis besonders anspruchsvoll sind.

Prozentuale Verbesserung mit DDR3:

Für dieses Diagramm habe ich die prozentuale Verbesserung der Durchschnittlichen FPS, der 1% low Frametimes und der 0.1% Frametimes aufgetragen.

Die Verbesserung der avg FPS sagt uns wie viel mehr Frames herausgepumpt werden und die Frametimes Werte sagen, wie sich das Spielgefühl verbessert hat.

Die 0.1% low zeigen dabei mehr von den Ausreißern, sind aber schwerer zu reproduzieren. Deshalb sind die 1% low aus meiner Sicht ein guter Mittelweg.

Schauen wir uns die Spiele an, dann sehen wir, dass Elex nur sehr gering auf schnelleren Ram reagiert. Hier sind wir fast die ganze Zeit im GPU Limit und es gibt wenig Spielraum für Verbesserungen.

Die anderen Spiele zeigen grob Verbesserungen von 10% bis 22%.

Dabei profitieren die avg FPS und die Frametimes relativ ähnlich.

Um zu zeigen wie viel % Performancezuwachs man mit X% zusätzlicher Ramgeschwindigkeit erwarten kann, habe ich eine "Rendite" ausgerechnet.

Also Gewinn(Performancezuwachs im Spiel)/eingesetztes Kapital(zusätzliche Ramgeschwindigkeit)*100%.

An der generellen Verteilung hat sich natürlich nichts getan aber es erlaubt uns gleich einen besseren Vergleich zu DDR4 mit dem Ryzen System zu ziehen und gibt eine grobe Abschätzung, was man erwarten kann, wenn man seine DDR3 Geschwindigkeit nicht um 40% sondern um einen anderen Faktor ändert.

Prozentuale Verbesserung mit DDR4:

Hier zeigen sich deutlich größere Schwankungen von Spiel zu Spiel.

Wie schon bei dem i5, sieht man bei Elex das GPU limit.

Ashes of the Singularity zeigt große Verbesserungen der avg FPS, jedoch keine zuverlässige Verbesserung der 0.1% low.

Die Reproduzierbarkeit ist leider zu schlecht.

Rome BI reagiert sehr schlecht auf den DDR4 Speicher, obwohl hier definitiv kein GPU limit vorliegt.

Vermutlich ist DDR4 generell deutlich schneller als benötigt und daher bleiben die Zuwächse klein.

Hitman läuft in ein FPS limit, RotTR und The Witche 3 laufen mit den 8 Kernen fast immer ins GPU limit.

Es zeigt sich jedoch schön, wie das Ram OC trotzdem etwas bringt, weil sich die Frametimes weiterhin verbessern.

Die anderen Spiele und The Witcher 3 mit nur 4 Zen Kernen profitieren grob um die 10 bis 17%

Da ich hier von DDR4 Basistakt 2133 zu teuren 3200 MHz springe möchte ich darauf hinweisen, dass der Verlauf dazwischen nicht immer linear ist.

In der Regel verbessern sich die wichtigen Frametimes stärker von 2133 zu 2666 als von 2666 zu 3200.

Beispiel linear:

Beispiel Frametimes sättigend:

Vergleich von DDR3 und DDR4:

Hier möchte ich die Spiele in zwei Gruppen teilen.

Einmal die Spiele, die nur bis zu 4 CPU Threads nutzen und daher nicht von den 8 Kernen und 16 Threads des Ryzen 1800X profitieren.

Und dann die Spiele, die mehr Threads nutzen können und in meiner Auswahl auf 8 Kernen in ein GPU oder FPS limit laufen.

Den Ashes of the Singularity CPU-Benchmark habe ich ausgeklammert, da er in keine der zwei Gruppen passt. Hier hilft das Ram OC vor allem den avg FPS, selbst die 16 Threads werden zu 80%+ ausgelastet und die Frametimes profitieren geringer, weil das Spiel scheinbar immer unreproduzierbare Frametimepeaks hat.

Fangen wir mit den Spielen ohne gute Multithreadunterstützung an:

Ich vergleiche hier wieder die Rendite, also wie viel von dem prozentualen Geschwindigkeitszuwachs des Rams, in prozentuale Performance in den verschiedenen Spielen umgesetzt wird.

Mit Ausname von Rome Barbarian Invasion, das auf dem Ryzen deutlich weniger mit dem schnellem Ram gewinnt, sind die Unterschiede zwischen dem ivy Bridge und dem Zen System gering.

Der i5 mit DDR3 gewinnt mehr in Cities Skylines und The Witcher 2.

Der Ryzen 1800X mit DDR4 gewinnt mehr in Heroes of the Storm und Starcraft 2.

Bei Thief und Prison Architect ist es schwer zu sagen, auch weil die 0.1% zu ungenau sind.

Gucken wir uns jetzt die limitierten Spiele an:

Hier gewinnt eigentlich immer der i5 mit DDR3 stärker.

Für den Ryzen zeigt sich in allen vier Spielen ein nur geringer Einfluss auf die avg FPS, was logisch ist, weil nicht die CPU das alleinige Limit darstellt und der schnellere Ram nur hilft sich näher an dieses Limit heranzuschmiegen.

Gerade in Rise of the Tomb Raider und Hitman, verbessern sich die Frametimes jedoch deutlich und auch Elex und The Witcher 3 zeigen mehr Verbesserung bei den Frametimes als bei den avg FPS.

Ganz unten habe ich noch die Werte für Ryzen limitiert auf 4 Kerne und 4 Threads in The Witcher 3 hinzugefügt.

Hier sieht man nun deutliche Verbesserungen durch schnellen Ram, weil wir uns wieder mehr Richtung CPU limit verschieben.

Der i5 profitiert jedoch weiterhin deutlich mehr.

Bewertung von Gerüchten:

Ich würde mir natürlich Vergleichsdaten zu einem aktuellen Intel System wünschen, die Vergleiche zu DDR3 fand ich allerdings auch sehr interessant.

Als ich damals meinen i5 3570K gekauft habe war in CB und anderen Foren noch die festsitzende Meinung, dass schneller Ram(damals eben DDR3) nichts bringt und man höchstens 1600er nehmen sollte wenn der Aufpreis ganz gering ist.

Bei den neueren Intel CPUs hat sich diese Meinung größtenteils gehalten und erst mit Ryzen meinten dann plötzlich alle(also gefühlt alle

Ohne hier intensiv auf den IF eingehen zu wollen, habe ich nicht die Erfahrung gemacht, dass man schnellen Ram braucht um den IF zu beschleunigen!

Der 8 Kerner gibt mir die Möglichkeit Kerne zu deaktivieren und sowohl eine 2+2 als auch 4+0 Konfiguration einzustellen.

Mit 4+0 gibt es keine Kommunikation zwischen den Kernen über den IF.

Wären die bessere Spieleperformance durch schnelleren Ramtakt also eine Folge des schnelleren IF, sollte 4+0, verglichen mit 2+2 nur geringe Verbesserungen erfahren.

Die Methode ist leider nicht so eindeutig wie ich es gerne hätte, da 4+0 den Nachteil hat, nur auf 8MB L3 Cache zurückgreifen zu können. Dadurch zeigt sich in einigen Spielen, mit 2133er Ram, bei den Frametimes schlechtere Werte für 4+0, obwohl gerade hier 2+2 besonders benachteiligt sein sollte.

Es scheint so als würde der doppelte L3 Cache für 2+2 den langsamen Ram abfedern und den Effekt des langsameren IF massiv überlagern.

Wie in diesem Beispiel zu sehen ist 4+0 zwar in der Regel 2+2 überlegen.....

.....beide profitieren allerdings fast gleich von schnellem Ram.

Ich habe noch Beispiele, wo es genau andersherum ist, oder der Effekt stärker zu sehen ist.

Am stärksten zeigte es sich in Starcraft 2, wo der IF um die 6% ausgemacht hat. Verglichen mit den ca 15% die man hier generell auch bei 4+4(weniger Wahrscheinlichkeit für IF Kommunikation als bei 2+2)durch schnellen Ram gewonnen hat, sollten die höchstens 6% nicht der primäre Grund sein um auf schnellen Ram zu setzen.

Vor allem weil in den meisten anderen Spielen der Effekt nur 0-2% bei den avg FPS war.

Mit 4+0 gibt es keine Kommunikation zwischen den Kernen über den IF.

Wären die bessere Spieleperformance durch schnelleren Ramtakt also eine Folge des schnelleren IF, sollte 4+0, verglichen mit 2+2 nur geringe Verbesserungen erfahren.

Die Methode ist leider nicht so eindeutig wie ich es gerne hätte, da 4+0 den Nachteil hat, nur auf 8MB L3 Cache zurückgreifen zu können. Dadurch zeigt sich in einigen Spielen, mit 2133er Ram, bei den Frametimes schlechtere Werte für 4+0, obwohl gerade hier 2+2 besonders benachteiligt sein sollte.

Es scheint so als würde der doppelte L3 Cache für 2+2 den langsamen Ram abfedern und den Effekt des langsameren IF massiv überlagern.

Wie in diesem Beispiel zu sehen ist 4+0 zwar in der Regel 2+2 überlegen.....

.....beide profitieren allerdings fast gleich von schnellem Ram.

Ich habe noch Beispiele, wo es genau andersherum ist, oder der Effekt stärker zu sehen ist.

Am stärksten zeigte es sich in Starcraft 2, wo der IF um die 6% ausgemacht hat. Verglichen mit den ca 15% die man hier generell auch bei 4+4(weniger Wahrscheinlichkeit für IF Kommunikation als bei 2+2)durch schnellen Ram gewonnen hat, sollten die höchstens 6% nicht der primäre Grund sein um auf schnellen Ram zu setzen.

Vor allem weil in den meisten anderen Spielen der Effekt nur 0-2% bei den avg FPS war.

Fazit:

Schneller OC Ram bringt viel mehr als in der Vergangenheit behauptet wurde.

Der Ivy Bridge i5 profitiert sogar oft mehr als die Ryzen 1000er Serie.

Die Vorteile liegen sind natürlich vor allem im CPU Limit(System Limit, Software Limit wie auch immer ihr etwas bezeichnen wollt, was nicht GPU Limit oder Nachladeruckler ist) zu sehen.

Trotz GPU Limit oder FPS Limit haben sich die Frametimes teils deutlich verbessert.

Damit hatte ich selbst nicht gerechnet.

So langsam ändert sich die Einstellung zu schnellem Ram ja sogar auf CB, wobei meiner Meinung nach inzwischen, in den Kaufberatungen schon fast etwas über das Ziel hinaus geschossen wird.

Von 2133MHz rate ich zwar ab, jedoch halte ich 2666/2800 durchaus für eine legitime Kaufempfehlung solange ordentliche Timings von CL14/15 benutzt werden.

Einige Spiele profitieren deutlich von schnellerem Ram und profitieren auch noch bis 3200MHz ohne eine Sättigung zu zeigen...potentiell also noch darüber hinaus.

Ich konnte meine Timings mit 3333MHz leider noch nicht richtig stabil bekommen. Da bräuche ich wohl singel ranked ram, oder mehr Mut bei den Spannungen

Der Aufpreis für 3000MHz+ sind oft so, dass man bei begrenztem Budget lieber in andere Komponenten investieren sollte und die hohen Ramtaktraten überstrahlen oft die schlechten Timings und bringen dann im Endeffekt nicht viel.

Ein häufiger Fehler bei bisherigen Tests zur Ram Skalierung.

Da werden oft verschiedene Ram Kits mit ganz anderen Timings oder zumindest anderen Subtimings verwendet.

Wer eh schon eine schnelle CPU hat, sollte sich jedoch am Ram OC versuchen und schnellen Ram kaufen.

Gerne würde ich noch Samsung B single ranked Ram kaufen und mit meinem dual ranked ram vergleichen....

Und Hynix Ram kaufen um zu sehen ob ich den schnell hinbekomme.

Und einen 2700X kaufen und einen 1200.....und ein X470 MB, Und einen neuen Intel.....nur erscheint mir das etwas zu teuer für so ein Hobby.

Eventuell mache ich manches spontan doch....mal sehen

Was sind eure Meinungen dazu?

Habt ihr Verbesserungsvorschläge oder wollt ihr besimmte Sachen sehen, die ich hier nicht behandelt habe?

Zuletzt bearbeitet: