Die Leistungsentfaltung die fast linear mit mehr Watt Eintritt wäre ja kein Problem, wenn es Kühllösungen geben würde, welche die Notebooks anstatt bei 40-60 eben bei 20-30 decibel kühlen.

Es wäre kein Problem wenn die Effizienz des Gesamtsystems eben bei der Leistung einer 4080 a, ohne Strom gar nicht funktioniert und b, selbst bei 1/4 und 1/5 der Leistung nicht schon nach 2h das Teil die Arbeit einstellt.

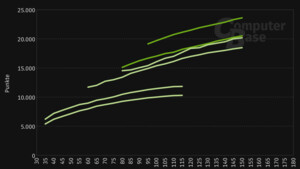

Die Benchmarks zeigen sehr anschaulich , gibts du der Grafikkarte mehr Watt, dann gibts in etwa dieselbe Anzahl an Leistung, die einzelnen Architekturunterschiede fallen da schon fast weniger ins Gewicht.

Geht also am Ende doch nur darum wie viel Strom durch die Leitung gepresst wird.

Mir scheinen die Architekturen zu fehlen (sowohl bei X86 als auch ARM) wo die Architektur viel viel besser mit mehr Recheneinheiten als auch mehr Watt nicht nur linear skalieren.

Auch bei Apple ist die mehr Leistung dieses Jahr auf mehr Watt und Kerne zurück zu führen aber sehr, sehr nah an linear mehr Leistung dran.

Nur die schaffen es trotzdem effizienter zu sein am Ende.

Witzig sind dann unplugged Blender Benchmarks wo eine 3080Ti mobile hinter einer M2 Max GPU zurück fällt und da sieht man dann schon, warum nVidia eben in 3D Rendering benchmarks oft besser performt, gibst du 5 mal mehr Watt kriegst du 5 mal schnelleres Rendering.

Würde mir wünschen beide würden sich etwas in die Richtung des Anderen entwickeln, Apple mehr Watt freigeben für mehr Leistung und nVidia und AMD die GPUs im mobilen Bereich mal mehr auf Effizienz trimmen als auf Leistungshunger.

Wobei wahrscheinlich tun sie es schon nur schaffen es eben nicht um meiner Wunschlösung näher zu kommen.