AssassinWarlord

Lt. Commander

- Registriert

- Okt. 2008

- Beiträge

- 1.058

Tachchen allerseits, ich möchte hier mal etwas auf das Thema VRM (Voltage Regulator Module) bzw. die Spannungswandler auf den Grafikkarten eingehen um so den willigen Käufern zu zeigen - das viel nicht immer viel hilft bzw. besser sein muss. Es geht hier um die VRM Wandler Effizienz, die eben nicht automatisch besser sein muss als wenn man nur wenig Phasen hat...wobei das meistens mehr der Spar-Politik geschuldet ist, aber reinweg fürs Marketing klingt es halt erstmal cooler wenn man hinschreiben kann - 16 Phasen.

Jedenfalls- habe jetzt mal etwas zeit gefunden, mich mal mit meiner GTX1080TI Amp Extreme von Zotac näher auseinander zu setzen, wo ich die GPU getauscht hatte, ein RAM versetzt habe (weil die spender 1080TI GPU den lasercut für den fehlenden Speicher an einer anderen stelle hat) aber auch die 48 Mosfets.

Hier das Video dazu, recht weit am ende ist das mit den Mosfets (40:45 Minute)

Das der tausch alleine erstmal noch nicht soviel bringt, war klar - weil ja nichts an der Antakt-Frequenz geändert wurde.

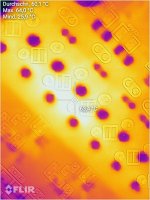

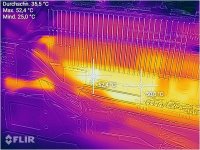

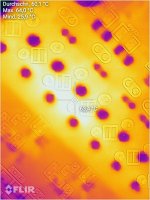

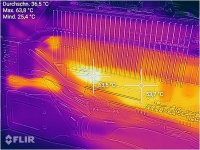

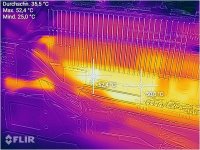

Hier wie die Hitzeentwicklung auf der Rückseite der Karte vorher war - getestet mit 100% Lüfterdrehzahl, 10 Minuten GPUTool Stresstest gerade so groß gezogen dass noch kein PowerLimit entsteht, sondern die karte wirklich nahe der 300W maximal möglichen TDP liegt

und hier nach dem Tausch der Mosfets:

Rund 1,5°C Temperatur unterschied - also nicht der rede wert die 48 Mosfets tauschen zu wollen ;-)

Die Zotac hat ja 16 Phasen was erstmal richtig Overkill klingt und dass die sich eigentlich langweilen und dadurch auch recht effizient sein müssten. Tja, beim "müsste" ist es aber auch geblieben.

Wie "Actually Hardcore Overclocking" Hier in dem Video schon so schön zeigt, sind die verbauten Mosfets halt eher von der günstigen Sorte, diese haben Einschaltzeiten von 39ns für den HighSide Mosfet und 44,6ns für die LowSide Mosfets. Diese Rise-On time (=bis das GATE voll geladen ist und der Mosfet voll durchschaltet) sorgt für unnötige Erhitzung der Mosfets weil in dieser Rise-On time die Mosfets in einer Art "halbleitendem" zustand sind - was Mosfets garnicht mögen und dabei mehr Wärme "erzeugen" als wenn sie dann voll durchgesteuert sind. Und dadurch bedingt ist nur eine recht niedrige Schalt-Frequenzen möglich, weil sonst der Mosfet nie richtig durchschalten würde wenn die Frequenz so hoch ist das der Mosfet schonwieder sperren soll - obwohl er noch beim Rise-On ist (also dabei durch zu schalten). Würde man denn trotzdem zuschnel schalten kanns sogar passieren dass die DeadTime zu gering wird - die zeit wo gewartet wird bis der Mosfet wirklich aus sein solte und wo erst danach der andere eingeschaltet wird - sonst würde es schön knallen weil Kurzschluss...

Klar funktioniert das zwar, und die entstehende Hitze kann großflächig verteilt werden auf die 16 Phasen und dem recht kleinen Kühler - aber so richtig gut ist die Effizienz der ganzen sache nicht, da sind Founders Edition mit ihren Dual-N-Mosfets deutlich effizienter. Klar können Founders Edition karten zwar nicht in summe so hohe ströme bereits stellen wenn man richtig krass übertakten will, weil dann da bei Zeiten die Mosfets hops gehen würden - aber wie "Actually Hardcore Overclocking" in seinem Video schon sagte - wo bei der Zotac das VRM bei 300A ca. 42W an Abwärme macht, macht das Founders Edition VRM bei 300A gerade mal 35W Abwärme.

Klingt nicht viel, aber wen man bedenkt dass diese Leistung durch die Shunts mit gemessen wird, und die Wärme durch die meistens nur sehr kleinen Kühlkörper die für die VRMs spendiert wurden, weggekühlt werden muss - da sind 10W oder gar 20W (wenn man übertaktet) schon sehr viel - für das ganze VRM betrachtet

Auch entsteht viel Hitze in den Spulen selber - die das PCB natürlich als "Kühlkörper" mitverwenden bzw. als Wärmetransfereinheit. Das liegt daran weil die Spule ja immer nur ganz kurz "angetriggert" wird, also einen Stromimpuls reingeschoben bekommt durch die Mosfets. Der HighSide Mosfet schaltet ganz kurz die 12V durch, sodass diese an der Spule anliegen, aber der Stromfluss steigt langsam an - somit auch die Spannung. Wobei langsam relativ ist, weil wenige Nanosekunden ;-) aber in dem Bereich geht es eben. Die Kondensatoren am Mosfet puffern eben auch den Strom, sodass da deutlich mehr Strom geschoben werden kann als das PC Netzteil je könnte - aber für ein paar Nanosekunden reicht das zu bis der Mosfet wieder abschaltet und der LowSide Mosfet einschaltet und die Spule dann einen geschlossenen Stromkreis mit der GPU darstellt und somit die ~1V rauskommt... naja wird schon wieder zu theoretisch hier, will hier nicht gleich die komplette Funktionsweise eines Abwärtswandlers bzw. wie hier in dem falle - eines Synchronwandlers erklären...da gibts genug Lektüre in diversen Büchern oder im Internet.

Jedenfalls diese kurzen Impulse haben eben einen recht hohen Strom - und genau dieser Strom erwärmt die Spule. Wenn man jetzt die Antakt-Frequenz erhöht, verringern sich die Ströme weil die Spule in der gleichen Zeitspanne wie vorher - mehrmals Angetaktet wird - dadurch ergeben sich geringere Ripple-Ströme - die Kondensatoren und alle anderen Komponente laufen dadurch entspannter. Zwar ergeben sich auch wieder andere Nachteile mit höherer Antaktfrquenz wie eben Induktionsverluste ins PCB (wie ein Induktionsherd sozusagen) oder eben Schaltverluste (wegen Rise-on und Fall-Time beim Mosfet) oder Um-Magnetisierungs-Verluste in der Spule. Aber vielleicht kann man ja doch noch etwas rausholen in sachen Effizienz bei so einer Karte.

Nun habe ich ja auf meiner 1080TI hier Mosfets drauf, die deutlich schneller schalten könnten, also wären die Schaltverluste schonmal deutlich minimiert - somit kann ich was das angeht eine höhere Antakt-Frequenz versuchen und schauen wo ich rauskomme ohne das die Induktionsverluste zu groß werden - die Goldene Mitte also finden.

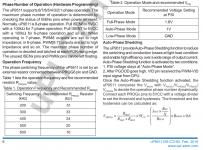

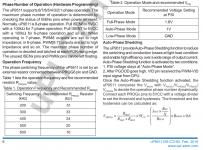

Die Antakt- bzw. Schaltfrequenz kann man hier recht einfach ändern, der wird am uP9511 PWM Controller durch einen einfachen Widerstand gegen Masse beim Einschalten des Controllers bestimmt.

Das passiert hier über den PROG6 PIN 3

Serienmäßig lag der Widerstand bei rund 33kOhm, was lt. Tabelle hier um die 300Khz ergibt

Nicht vergessen - die 16 Phasen kommen nicht direkt vom Controller, da sind PhaseDoubler verbaut, also taktet jede Phase effektiv mit 150Khz.

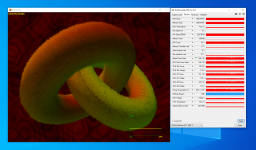

Damit habe ich erst einmal den Eingangstest gemacht und wie oben schon geschrieben "getestet mit 100% Lüfterdrehzahl, 10 Minuten GPUTool Stresstest-Fenster gerade so groß gezogen dass noch kein PowerLimit entsteht, sondern die karte wirklich nahe der 300W maximal möglichen TDP liegt"

Dabei hat sie sich rund 292W genehmigt lt. GPU-Z über die 10 Minuten. Natürlich hatte ich da erst gewartet bis der Stresstest lief und erst dann die Messung mitlaufen lassen.

Aus der Steckdose hat mein Testsystem da rund 389W gezogen.

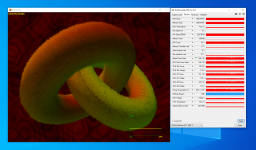

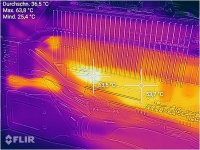

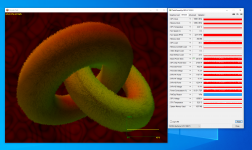

Hitzeentwicklung der Spule und dem Mosfet Kühler:

Die Spulen werden dabei rund 63°C Heiß - nicht vergessen bei dem Test läuft der Lüfter immer mit 100% (PWM Pin entfernt am Lüfteranschluss) um eben Messfehler durch eine Lüfterregelung auszuschließen.

mit der Regulären Lüfter Steuerung wird das ganze noch deutlich heißer, um die 90°C...

Auf geht's mit der Frequenzanpassung, dazu habe ich einfach den 33K Ohm widerstand entfernt, und dafür ein 50K Ohm 22-Gang Trim-Poti angelötet und nach außen verlegt um den so anzupassen.

Dabei habe ich zum versuch den Widerstand auf 40K Ohm eingestellt - nur um zu schauen was passiert wenn man die Frequenz weiter verringert.

Das machts nur noch schlechter jedenfalls

298W und öfter mal direkt ins PowerLimit gerannt, extern hat das System dabei direkt 405W aus der Dose gezogen.

Okay, also erstmal den Optimalen wert ermitteln wo der ganze Schwingkreis am optimalsten läuft - im lastfreien zustand weil ich das am einfachsten mit meinem Labornetzteil prüfen kann. Wenn also nur Strom an der Karte anliegt, die Karte in einem Riser steckt - aber keine PCIe Lanes angeschlossen sind. Damit startet zwar die karte, die Spannungswandler werden also alle aktiviert, GPU bekommt Spannung und Strom aber "Schläft" weils sie aufgrund der fehlenden Datenverbindung weiter im Reset-State bleibt. Macht aber nix, weil es geht hier ja nur um den VRM.

bei 33K Ohm , also 300Khz in etwa (also 34K Ohm), nimmt sich die Karte im Lastfreien zustand bei 12V genau 2,186A.

Jetzt kann ich das Poti immer etwas weiter runterdrehen um so die Frequenz zu erhöhen und kann über das Netzteil die Karte recht einfach ein und ausschalten, was auch nötig ist, weil der uP9511 PWM Controller die Antakt-Frequenz immer nur einmalig beim Starten bestimmt anhand des Widerstandes der am PROG6 Pin hängt.

Rausgekommen bin ich dann bei um die 15K Ohm wo der VRM die höchste Effizienz zeigte:

nur noch 1,687A bei 12V

wenn man noch niedriger geht mit dem Poti und die Frequenz noch höher schraubt, steigt der Stromfluss wieder steiler an und zwar deutlich - weil dann die Um-Magnetisierungsverluste und Schaltverluste zunehmen

Weiter gings jetzt mit dem echten Test unter Last. Das hat eben mehrere Stunden gedauert weil die 15K Ohm zwar unter Leerlauf und ohne Hitze der optimalste wert war - nicht aber unter Last. Da hatte die karte nur etwas weniger aus der Steckdose gezogen wie im Originalen Zustand - eben wegen genannten Verlusten und Temperatur-Koeffizient Verschiebung. Ich habe Wirklich viel probiert, System abgeschaltet, um 0.5K Ohm erhöht, wieder an, wieder 10 min Stresstest um Durchschnittswerte zu ermitteln, wieder aus, wieder 0.5 kOhm höhrer gegangen, wieder getestet, dokumentiert,...

Im Endeffekt ist der optimalste punkt bei Last und im Leerlauf, bei Kalter und bei Warmer Karte bei 17K Ohm - was ca. 560Khz Schaltfrequenz ergibt, also pro Phase um die 280Khz. Deutlich mehr als die Originalen 300/150Khz.

Aber was hats gebracht?

bei der selben Performance zieht die karte jetzt statt 292W nur noch 282W. Auch aus der Steckdose werden jetzt statt 389W nur noch 378W gezogen.

Also in Summe 10W weniger. Nicht viel - klar - aber das sind einfach nur Verluste die minimiert wurden durch den Schaltwandler - und das finde ich schon bemerkenswert. Dadurch könnte sie jetzt ihren Boost länger halten oder weiter ausbauen, weil diese 10W ja auch durch die Shunts mit gemessen werden.

Was ich abeer viel bessser finde: Dadurch laufen die VRMs aber auch gleich mal rund 10°C Kühler - nur durch elektrische Optimierung!

Das wäre mit den Werksseitigen Mosfets wie gesagt nicht möglich gewesen, da hatten wenige Khz mehr Taktfrequenz schon zu einem Effizenzverlust geführt.

Damit ist der VRM genauso hoch effizient wie der, einer Founders Edition - und die sind schon gut effizient ausgelegt.

Das hätte eigentlich auch der Hersteller so direkt verbauen können, oder? Nun, wie immer zählt da eben wie anfangs erwähnt der Preis mit rein - meine 48 Infineon OptiMos5 Mosfets hier sind natürlich einiges teurer als einfachere Mosfets, und gerade bei einer Massenproduktion kommt es ja bekanntlich auf jeden Cent an. Ich weiß nicht wieviel Cent die teurer wären wenn man die in großen Stückzahlen genommen hätte, ich kanns auch nicht pro Stück sagen weil ich keinerlei Preise über die Originalen Mosfets finden konnte - aber gut waren die jedenfalls nicht ;-)

Wie gesagt, das hier ist eher ein Versuch meinerseits was man noch so rausholen kann, eine Art Fein-Tuning. Und Fein-Tuning bringt bekanntlich nicht mehr so viel. Aber vielleicht haben sich andere auch schonmal gefragt was man noch so machen könnte um die ganze Karte zu Optimieren. Wobei ich wohl nicht unbedingt nochmal 48 Mosfets tauschen wöllte - auch wenn es in 20-30 Minuten erledigt ist, ich denke wenn man nicht bis aufs letzte Mhz übertaktet, kann man die auch Original beruight drauf lassen

Was ich eigentlich damit sagen will - lasst euch nicht nur von der bloßen Anzahl der Phasen blenden. Klar es gibt noch weniger effiziente Wandler wo noch mehr Energie einfach in Wärme verpufft, aber auch bessere Konzepte.

Und das nicht nur bei Grafikkarten - ist bei Mainboards genauso.

btw. Und ja, die die Mosfets für die Speicher-Spannungsversorgung habe ich unangetastet gelassen, weil die nicht soviel zutun hat, also da mit einer Verbesserung von vielleicht 1W zu rechnen wäre.

So, und jetzt noch allen ein frohes neues Jahr wünsche ich

Jedenfalls- habe jetzt mal etwas zeit gefunden, mich mal mit meiner GTX1080TI Amp Extreme von Zotac näher auseinander zu setzen, wo ich die GPU getauscht hatte, ein RAM versetzt habe (weil die spender 1080TI GPU den lasercut für den fehlenden Speicher an einer anderen stelle hat) aber auch die 48 Mosfets.

Hier das Video dazu, recht weit am ende ist das mit den Mosfets (40:45 Minute)

Das der tausch alleine erstmal noch nicht soviel bringt, war klar - weil ja nichts an der Antakt-Frequenz geändert wurde.

Hier wie die Hitzeentwicklung auf der Rückseite der Karte vorher war - getestet mit 100% Lüfterdrehzahl, 10 Minuten GPUTool Stresstest gerade so groß gezogen dass noch kein PowerLimit entsteht, sondern die karte wirklich nahe der 300W maximal möglichen TDP liegt

und hier nach dem Tausch der Mosfets:

Rund 1,5°C Temperatur unterschied - also nicht der rede wert die 48 Mosfets tauschen zu wollen ;-)

Die Zotac hat ja 16 Phasen was erstmal richtig Overkill klingt und dass die sich eigentlich langweilen und dadurch auch recht effizient sein müssten. Tja, beim "müsste" ist es aber auch geblieben.

Wie "Actually Hardcore Overclocking" Hier in dem Video schon so schön zeigt, sind die verbauten Mosfets halt eher von der günstigen Sorte, diese haben Einschaltzeiten von 39ns für den HighSide Mosfet und 44,6ns für die LowSide Mosfets. Diese Rise-On time (=bis das GATE voll geladen ist und der Mosfet voll durchschaltet) sorgt für unnötige Erhitzung der Mosfets weil in dieser Rise-On time die Mosfets in einer Art "halbleitendem" zustand sind - was Mosfets garnicht mögen und dabei mehr Wärme "erzeugen" als wenn sie dann voll durchgesteuert sind. Und dadurch bedingt ist nur eine recht niedrige Schalt-Frequenzen möglich, weil sonst der Mosfet nie richtig durchschalten würde wenn die Frequenz so hoch ist das der Mosfet schonwieder sperren soll - obwohl er noch beim Rise-On ist (also dabei durch zu schalten). Würde man denn trotzdem zuschnel schalten kanns sogar passieren dass die DeadTime zu gering wird - die zeit wo gewartet wird bis der Mosfet wirklich aus sein solte und wo erst danach der andere eingeschaltet wird - sonst würde es schön knallen weil Kurzschluss...

Klar funktioniert das zwar, und die entstehende Hitze kann großflächig verteilt werden auf die 16 Phasen und dem recht kleinen Kühler - aber so richtig gut ist die Effizienz der ganzen sache nicht, da sind Founders Edition mit ihren Dual-N-Mosfets deutlich effizienter. Klar können Founders Edition karten zwar nicht in summe so hohe ströme bereits stellen wenn man richtig krass übertakten will, weil dann da bei Zeiten die Mosfets hops gehen würden - aber wie "Actually Hardcore Overclocking" in seinem Video schon sagte - wo bei der Zotac das VRM bei 300A ca. 42W an Abwärme macht, macht das Founders Edition VRM bei 300A gerade mal 35W Abwärme.

Klingt nicht viel, aber wen man bedenkt dass diese Leistung durch die Shunts mit gemessen wird, und die Wärme durch die meistens nur sehr kleinen Kühlkörper die für die VRMs spendiert wurden, weggekühlt werden muss - da sind 10W oder gar 20W (wenn man übertaktet) schon sehr viel - für das ganze VRM betrachtet

Auch entsteht viel Hitze in den Spulen selber - die das PCB natürlich als "Kühlkörper" mitverwenden bzw. als Wärmetransfereinheit. Das liegt daran weil die Spule ja immer nur ganz kurz "angetriggert" wird, also einen Stromimpuls reingeschoben bekommt durch die Mosfets. Der HighSide Mosfet schaltet ganz kurz die 12V durch, sodass diese an der Spule anliegen, aber der Stromfluss steigt langsam an - somit auch die Spannung. Wobei langsam relativ ist, weil wenige Nanosekunden ;-) aber in dem Bereich geht es eben. Die Kondensatoren am Mosfet puffern eben auch den Strom, sodass da deutlich mehr Strom geschoben werden kann als das PC Netzteil je könnte - aber für ein paar Nanosekunden reicht das zu bis der Mosfet wieder abschaltet und der LowSide Mosfet einschaltet und die Spule dann einen geschlossenen Stromkreis mit der GPU darstellt und somit die ~1V rauskommt... naja wird schon wieder zu theoretisch hier, will hier nicht gleich die komplette Funktionsweise eines Abwärtswandlers bzw. wie hier in dem falle - eines Synchronwandlers erklären...da gibts genug Lektüre in diversen Büchern oder im Internet.

Jedenfalls diese kurzen Impulse haben eben einen recht hohen Strom - und genau dieser Strom erwärmt die Spule. Wenn man jetzt die Antakt-Frequenz erhöht, verringern sich die Ströme weil die Spule in der gleichen Zeitspanne wie vorher - mehrmals Angetaktet wird - dadurch ergeben sich geringere Ripple-Ströme - die Kondensatoren und alle anderen Komponente laufen dadurch entspannter. Zwar ergeben sich auch wieder andere Nachteile mit höherer Antaktfrquenz wie eben Induktionsverluste ins PCB (wie ein Induktionsherd sozusagen) oder eben Schaltverluste (wegen Rise-on und Fall-Time beim Mosfet) oder Um-Magnetisierungs-Verluste in der Spule. Aber vielleicht kann man ja doch noch etwas rausholen in sachen Effizienz bei so einer Karte.

Nun habe ich ja auf meiner 1080TI hier Mosfets drauf, die deutlich schneller schalten könnten, also wären die Schaltverluste schonmal deutlich minimiert - somit kann ich was das angeht eine höhere Antakt-Frequenz versuchen und schauen wo ich rauskomme ohne das die Induktionsverluste zu groß werden - die Goldene Mitte also finden.

Die Antakt- bzw. Schaltfrequenz kann man hier recht einfach ändern, der wird am uP9511 PWM Controller durch einen einfachen Widerstand gegen Masse beim Einschalten des Controllers bestimmt.

Das passiert hier über den PROG6 PIN 3

Serienmäßig lag der Widerstand bei rund 33kOhm, was lt. Tabelle hier um die 300Khz ergibt

Nicht vergessen - die 16 Phasen kommen nicht direkt vom Controller, da sind PhaseDoubler verbaut, also taktet jede Phase effektiv mit 150Khz.

Damit habe ich erst einmal den Eingangstest gemacht und wie oben schon geschrieben "getestet mit 100% Lüfterdrehzahl, 10 Minuten GPUTool Stresstest-Fenster gerade so groß gezogen dass noch kein PowerLimit entsteht, sondern die karte wirklich nahe der 300W maximal möglichen TDP liegt"

Dabei hat sie sich rund 292W genehmigt lt. GPU-Z über die 10 Minuten. Natürlich hatte ich da erst gewartet bis der Stresstest lief und erst dann die Messung mitlaufen lassen.

Aus der Steckdose hat mein Testsystem da rund 389W gezogen.

Hitzeentwicklung der Spule und dem Mosfet Kühler:

Die Spulen werden dabei rund 63°C Heiß - nicht vergessen bei dem Test läuft der Lüfter immer mit 100% (PWM Pin entfernt am Lüfteranschluss) um eben Messfehler durch eine Lüfterregelung auszuschließen.

mit der Regulären Lüfter Steuerung wird das ganze noch deutlich heißer, um die 90°C...

Auf geht's mit der Frequenzanpassung, dazu habe ich einfach den 33K Ohm widerstand entfernt, und dafür ein 50K Ohm 22-Gang Trim-Poti angelötet und nach außen verlegt um den so anzupassen.

Dabei habe ich zum versuch den Widerstand auf 40K Ohm eingestellt - nur um zu schauen was passiert wenn man die Frequenz weiter verringert.

Das machts nur noch schlechter jedenfalls

298W und öfter mal direkt ins PowerLimit gerannt, extern hat das System dabei direkt 405W aus der Dose gezogen.

Okay, also erstmal den Optimalen wert ermitteln wo der ganze Schwingkreis am optimalsten läuft - im lastfreien zustand weil ich das am einfachsten mit meinem Labornetzteil prüfen kann. Wenn also nur Strom an der Karte anliegt, die Karte in einem Riser steckt - aber keine PCIe Lanes angeschlossen sind. Damit startet zwar die karte, die Spannungswandler werden also alle aktiviert, GPU bekommt Spannung und Strom aber "Schläft" weils sie aufgrund der fehlenden Datenverbindung weiter im Reset-State bleibt. Macht aber nix, weil es geht hier ja nur um den VRM.

bei 33K Ohm , also 300Khz in etwa (also 34K Ohm), nimmt sich die Karte im Lastfreien zustand bei 12V genau 2,186A.

Jetzt kann ich das Poti immer etwas weiter runterdrehen um so die Frequenz zu erhöhen und kann über das Netzteil die Karte recht einfach ein und ausschalten, was auch nötig ist, weil der uP9511 PWM Controller die Antakt-Frequenz immer nur einmalig beim Starten bestimmt anhand des Widerstandes der am PROG6 Pin hängt.

Rausgekommen bin ich dann bei um die 15K Ohm wo der VRM die höchste Effizienz zeigte:

nur noch 1,687A bei 12V

wenn man noch niedriger geht mit dem Poti und die Frequenz noch höher schraubt, steigt der Stromfluss wieder steiler an und zwar deutlich - weil dann die Um-Magnetisierungsverluste und Schaltverluste zunehmen

Weiter gings jetzt mit dem echten Test unter Last. Das hat eben mehrere Stunden gedauert weil die 15K Ohm zwar unter Leerlauf und ohne Hitze der optimalste wert war - nicht aber unter Last. Da hatte die karte nur etwas weniger aus der Steckdose gezogen wie im Originalen Zustand - eben wegen genannten Verlusten und Temperatur-Koeffizient Verschiebung. Ich habe Wirklich viel probiert, System abgeschaltet, um 0.5K Ohm erhöht, wieder an, wieder 10 min Stresstest um Durchschnittswerte zu ermitteln, wieder aus, wieder 0.5 kOhm höhrer gegangen, wieder getestet, dokumentiert,...

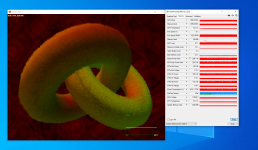

Im Endeffekt ist der optimalste punkt bei Last und im Leerlauf, bei Kalter und bei Warmer Karte bei 17K Ohm - was ca. 560Khz Schaltfrequenz ergibt, also pro Phase um die 280Khz. Deutlich mehr als die Originalen 300/150Khz.

Aber was hats gebracht?

bei der selben Performance zieht die karte jetzt statt 292W nur noch 282W. Auch aus der Steckdose werden jetzt statt 389W nur noch 378W gezogen.

Also in Summe 10W weniger. Nicht viel - klar - aber das sind einfach nur Verluste die minimiert wurden durch den Schaltwandler - und das finde ich schon bemerkenswert. Dadurch könnte sie jetzt ihren Boost länger halten oder weiter ausbauen, weil diese 10W ja auch durch die Shunts mit gemessen werden.

Was ich abeer viel bessser finde: Dadurch laufen die VRMs aber auch gleich mal rund 10°C Kühler - nur durch elektrische Optimierung!

Das wäre mit den Werksseitigen Mosfets wie gesagt nicht möglich gewesen, da hatten wenige Khz mehr Taktfrequenz schon zu einem Effizenzverlust geführt.

Damit ist der VRM genauso hoch effizient wie der, einer Founders Edition - und die sind schon gut effizient ausgelegt.

Das hätte eigentlich auch der Hersteller so direkt verbauen können, oder? Nun, wie immer zählt da eben wie anfangs erwähnt der Preis mit rein - meine 48 Infineon OptiMos5 Mosfets hier sind natürlich einiges teurer als einfachere Mosfets, und gerade bei einer Massenproduktion kommt es ja bekanntlich auf jeden Cent an. Ich weiß nicht wieviel Cent die teurer wären wenn man die in großen Stückzahlen genommen hätte, ich kanns auch nicht pro Stück sagen weil ich keinerlei Preise über die Originalen Mosfets finden konnte - aber gut waren die jedenfalls nicht ;-)

Wie gesagt, das hier ist eher ein Versuch meinerseits was man noch so rausholen kann, eine Art Fein-Tuning. Und Fein-Tuning bringt bekanntlich nicht mehr so viel. Aber vielleicht haben sich andere auch schonmal gefragt was man noch so machen könnte um die ganze Karte zu Optimieren. Wobei ich wohl nicht unbedingt nochmal 48 Mosfets tauschen wöllte - auch wenn es in 20-30 Minuten erledigt ist, ich denke wenn man nicht bis aufs letzte Mhz übertaktet, kann man die auch Original beruight drauf lassen

Was ich eigentlich damit sagen will - lasst euch nicht nur von der bloßen Anzahl der Phasen blenden. Klar es gibt noch weniger effiziente Wandler wo noch mehr Energie einfach in Wärme verpufft, aber auch bessere Konzepte.

Und das nicht nur bei Grafikkarten - ist bei Mainboards genauso.

btw. Und ja, die die Mosfets für die Speicher-Spannungsversorgung habe ich unangetastet gelassen, weil die nicht soviel zutun hat, also da mit einer Verbesserung von vielleicht 1W zu rechnen wäre.

So, und jetzt noch allen ein frohes neues Jahr wünsche ich

Zuletzt bearbeitet: