Meta Connect 2024: Llama 3.2 will mit ChatGPTs neuem Sprachmodus konkurrieren

Llama 3.2 ist das neue KI-Modell von Meta, das explizit auf die visuellen Fähigkeiten ausgelegt ist. Das Modell ist also in der Lage, Bilder und Kameraaufnahmen als Eingaben zu verarbeiten. Im Rahmen der Meta Connect 2024 präsentierte man, wie der Assistent Meta AI und die neuen KI-Brillen von den neuen Funktionen profitieren.

Llama 3.2 erscheint zunächst in vier Varianten, zwei großen und zwei kleinen. Die größeren Modelle haben 11 Milliarden und 90 Milliarden Parameter, diese beherrschen das visuelle Schlussfolgern. Somit lässt sich also auch Bilder analysieren, auf einer Aufnahme aus einem Wohnraum kann das Modell etwa einen Kamin identifizieren und Fragen dazu beantworten.

Vorteile soll das im Arbeitsalltag bieten. Denn auf diese Weise lassen sich etwa Dokumente verarbeiten, die neben Text auch Charts, Grafiken und Bilder beinhalten.

Laut Meta wurde für die Vision-Modelle eine neue Architektur entwickelt. Selbst wenn diese namentlich nur als Upgrade für Llama 3.1 wirken, hat sich unter der Haube einiges getan. Llama 3.1 war in diesem Fall der Startpunkt, dann erfolgten weitere Trainingsrunden, um die Bildverarbeitung zu integrieren.

Kleine Modelle als Konkurrent für Apple Intelligence

Die kleinen Modelle mit 1 Milliarde und 3 Milliarden Parametern sind hingegen auf Textfunktionen ausgelegt und können Anwendungen aufrufen. So haben Entwickler die Möglichkeit, KI-Agentensysteme bereitzustellen, die direkt auf den Geräten der Anwender laufen. Ein Plus im Bereich Privatsphäre, Apple verfolgt mit Apple Intelligence ein ähnliches Konzept.

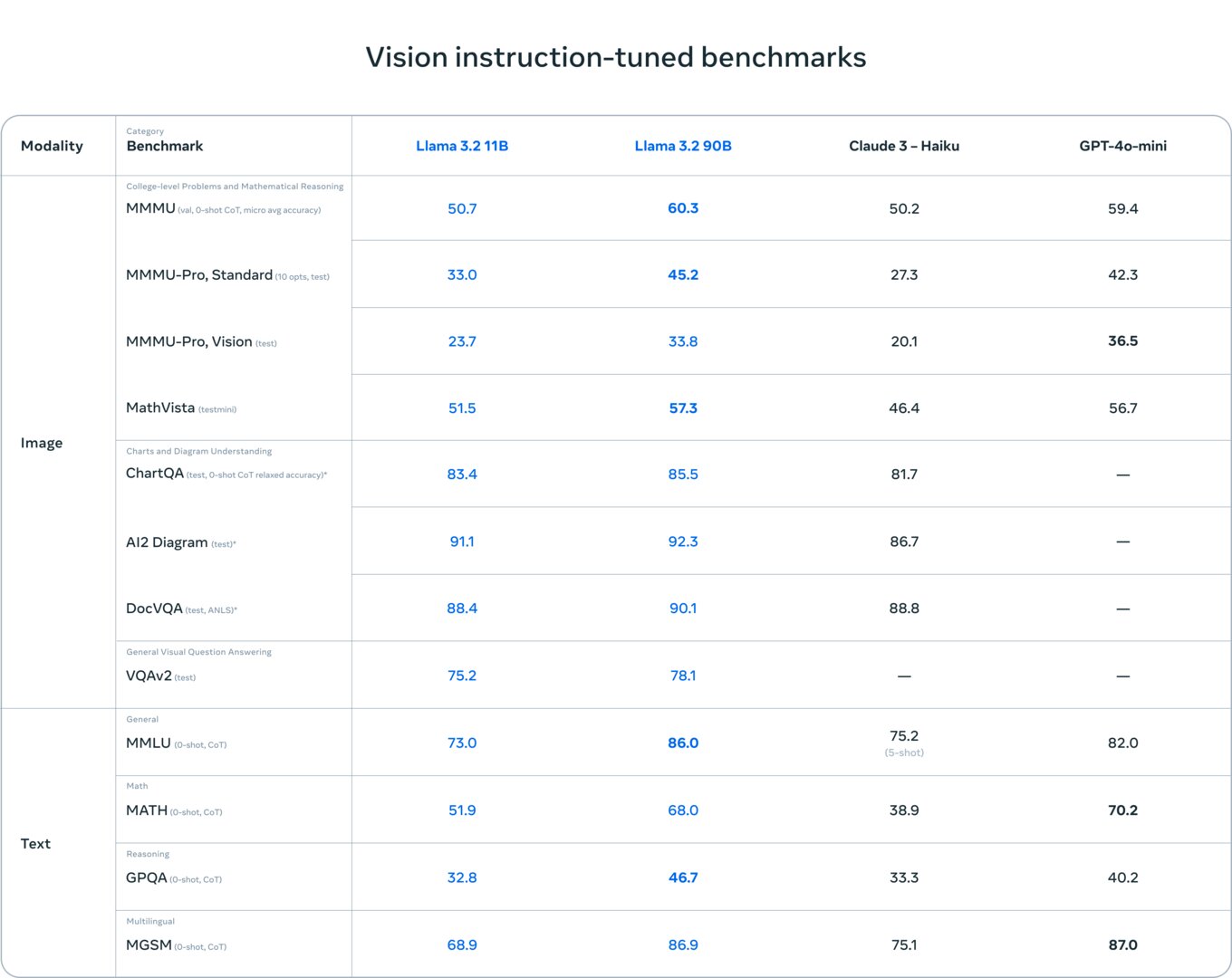

Bei den von Meta bereitgestellten Benchmarks schneiden die neuen Modelle gut ab. Vergleichsmaßstab sind jedoch nicht die Spitzenmodelle im Markt. Llama 3.2 11b und Llama 3.2 90b vergleicht Meta mit Anthropics Claude 3 Haiku (das kleinste Claude-3-Modell) und OpenAIs GPT-4o mini. Bei den kleinen Modellen sind Googles Gemma 2 und Microsofts Phi 3.5 mini der Vergleichsmaßstab.

Wie üblich veröffentlicht Meta die Modelle unter einer offenen Lizenz. Herunterladen lassen sie sich sowohl bei Meta als auch bei Hugging Face, möglich ist zudem der Cloud-Zugang bei Partnern wie AMD, AWS, Dell, Google, IBM, Intel, Microsoft und Nvidia.

Meta AI: Chatbot lernt sprechen

Von den Vision-Fähigkeiten profitiert Meta AI. Der Chatbot lässt sich ab jetzt auch per Spracheingabe steuern. Möglich sollen damit Gespräche sein, die authentisch wirken – also ähnlich wie bei dem neuen Sprachmodus von ChatGPT.

Nutzer können den Assistenten zudem personalisieren. So gibt es etwa Auswahl bei der Stimme. Zusätzlich ist Meta AI in der Lage, in Echtzeit zu antworten und Informationen aus dem Web abzurufen. Nutzer können zudem Bilder hochladen, die der Assistent hochlädt. Ebenso integriert wird ein Übersetzungstool. Auch Meta AI zählt damit neben ChatGPT, Google Gemini und Microsoft Copilot zur neuen Generationen der Assistenten, die deutlich mehr Raum im Alltag der Nutzer einnehmen sollen.

In der EU ist Meta AI aber wie gehabt nicht verfügbar, dasselbe gilt für Llama 2. Der Grund sind die regulatorischen Anforderungen in der EU. Wann der Start erfolgt, steht auch weiterhin nicht fest. Zuckerberg zeigte sich bei der Präsentation jedoch zuversichtlich, dass es eines Tages der Fall sein wird.

Meta Connect 2024: AI beflügelt Virtual-Reality-Konzepte

Von Meta AI profitierten auch die smarten Brillen wie die Ray-Ban-Modelle, die nun mit neuen KI-Funktionen ausgestattet werden. Mit Orion hat Meta zudem erstmals eine funktionierende AR-Brille mit holografischem Display vorgeführt, die ebenfalls auf visuelle Fähigkeiten der aktuellen KI-Modelle setzen.

- Meta Quest 3S: Quest-3-Mixed-Reality gibt es mit Abstrichen jetzt ab 329 Euro

- Meta zeigt Projekt Orion: Erste holografische AR-Brille mit KI und neuraler Steuerung

Was bei den neuen Präsentationen deutlich wird: Es zeigt sich, wie Metas Virtual-Reality-Sparte – die bislang vor allem für massive Verluste steht – von der KI-Entwicklung profitieren kann. Abstrakte Konzepte entwickeln sich allmählich zu Produkten.