GB300 NVL72: Nvidia Blackwell Ultra geht auf 288 GB HBM3e

Nvidia hat zur GTC 2025 mit Blackwell Ultra eine Weiterentwicklung der aktuellen Blackwell-Architektur vorgestellt. Damit einher geht eine Vergrößerung des Speichers um 50 Prozent auf bis zu 288 GB HBM3e. Das soll die Data-Center-Lösung fit für das Zeitalter der AI-Reasoning-Modelle mit höherer Inferencing-Anforderung machen.

Die B300-GPU ist eine Weiterentwicklung der letztes Jahr zur GTC vorgestellten B200-GPU, mit der Nvidia die Blackwell-Architektur eingeläutet hatte und die seit Ende des letzten Jahres bei mehreren Cloud Service Providern (CSPs) im Data Center angekommen ist. Blackwell Ultra setzt auf dieselbe Architektur und besteht deshalb ebenso aus zwei Dies, die über einen Die-to-Die-Link miteinander verbunden werden.

Inferencing von AI-Reasoning-Modellen im Fokus

Entwickelt wurde Blackwell Ultra unter anderem für die höheren Anforderungen beim Inferencing von AI-Reasoning-Modellen, die schnell mehrere Hunderttausend Tokens pro Anfrage verarbeiten und ausgeben müssen, da sie dem Anwender auch den Gedankengang der Anfrage präsentieren und somit einen höheren Rechenaufwand fordern.

HBM3e wächst auf 288 GB

Um diesen Anforderungen gerecht zu werden, erweitert Nvidia vor allem den Speicher von Blackwell Ultra auf bis zu 288 GB HBM3e, ausgehend von 192 GB HBM3e bei Blackwell mit der B200-GPU. Den 50 Prozent größeren High Bandwidth Memory verteilt Nvidia erneut über acht Stacks rund um die GPU, die jeweiligen Stapel sind jetzt aber 12 statt 8 DRAM-Chips hoch, sodass auf derselben Fläche eine 50 Prozent höhere Speicherdichte erzielt wird.

1,5-fache FP4-Inferencing-Leistung

Blackwell Ultra soll damit laut Nvidia die 1,5-fache FP4-Inferencing-Leistung im Vergleich zu Blackwell liefern, das Unternehmen spricht von 15 PetaFLOPS für FP4 Dense, also ohne die Sparsity-Beschleunigung, mit der 30 PetaFLOPS möglich sind. Für die ursprüngliche Blackwell-GPU lag diese Angabe noch bei 10 PetaFLOPS.

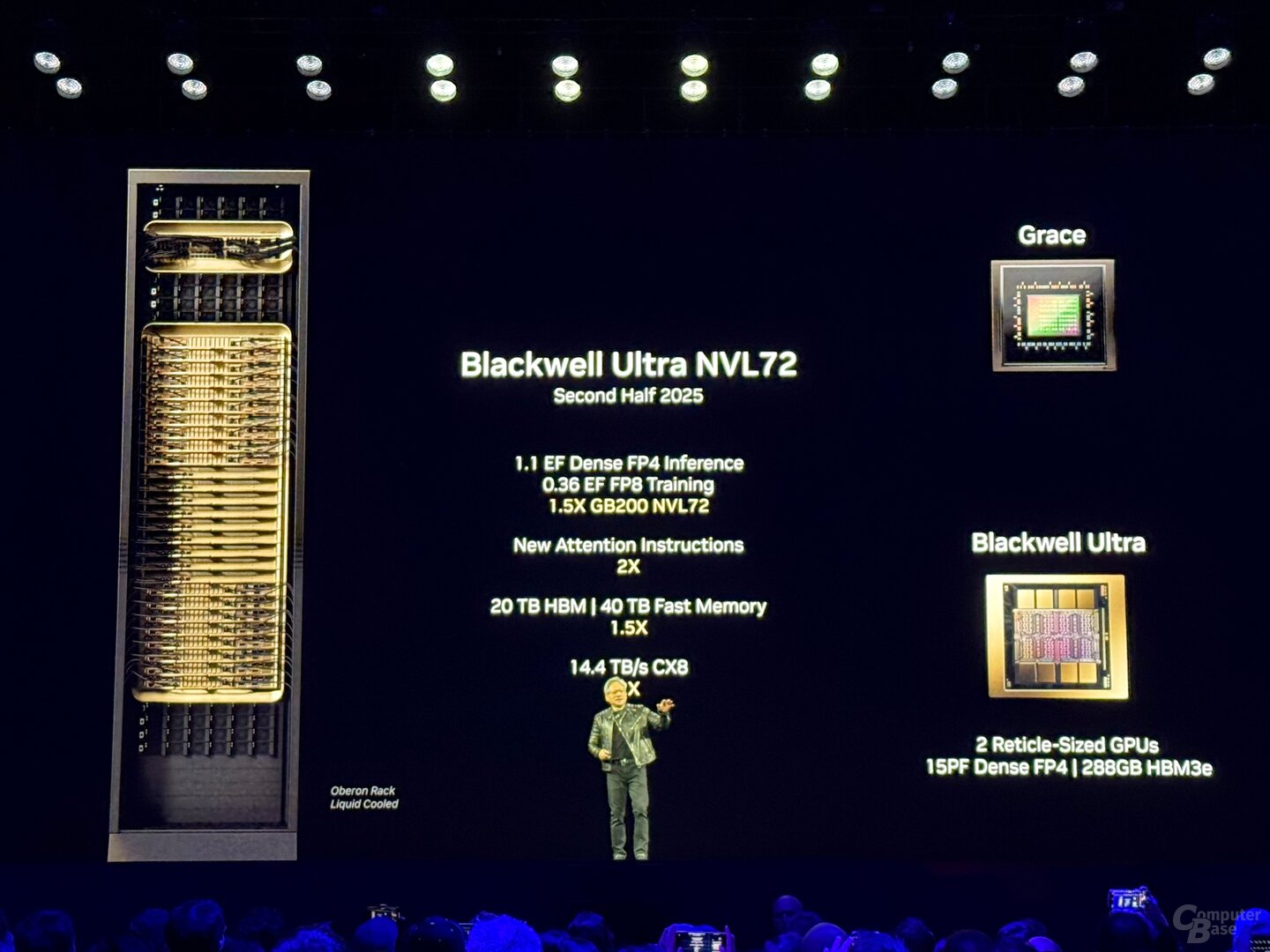

GB300 NVL72 mit 72 GPUs und 1,1 ExaFLOPS

Die Weiterentwicklung soll zu Beginn der initialen Verfügbarkeit in der zweiten Jahreshälfte 2025 in zwei Data-Center-Lösungen von Nvidia zum Einsatz kommen: GB300 NVL72 und HGX B300 NVL16. Bei GB300 NVL72 handelt es sich um eine Weiterentwicklung des bekannten Racks von GB200 NVL72, das 72 Blackwell-GPUs mit 36 Grace-CPUs mit Arm-Architektur in einem wassergekühlten Serverschrank vereint.

Bei GB300 NVL72 ist das nicht anders, auch hier bilden in den Einschüben insgesamt 36 Boards mit jeweils zwei GPUs und einer CPU die Grundlage der Lösung. Ein GB300 NVL72 kommt auf eine FP4-Leistung von insgesamt 1,1 ExaFLOPS, 20 TB (20.736 GB) HBM3e und 40 TB LPDDR5X für die Grace-CPUs. Gegenüber dem bisherigen Rack soll es auch nicht näher erläuterte Effizienzverbesserungen abseits der Compute-Boards geben.

NVLink mit 1,8 TB/s bildet das Rückgrat

Das Rückgrat, das die einzelnen Chips zu „einer großen GPU“ verbindet, bildet die 5. Generation des NVLink mit einer Bandbreite von 1,8 TB/s pro GPU und insgesamt 130 TB/s. NVLink kann seit Blackwell auch als Multi-Node-Interconnect verwendet werden, was zuvor über InfiniBand mit 100 GB/s abgewickelt wurde, sodass Nvidia für dieses konkrete Szenario von einer Leistungssteigerung um den Faktor 18x spricht. Der zugehörige„NVLink Switch 7.2T“ sitzt ebenso in dem Rack und ist ein nicht minder imposanter Chip. Auch den NVLink Switch lässt Nvidia in 4NP bei TSMC fertigen und kommt dabei auf 50 Milliarden Transistoren – das sind fast zwei Drittel der Transistoren von Hopper H100. Bis zu 576 GPUs lassen sich einer NVLink-Domain hinzufügen.

HGX B300 mit x86-Prozessor

Mit HGX B300 NVL16 bietet Nvidia außerdem eine Lösung ohne eigene Arm-CPU an. Wie der Verzicht auf das „G“ im Namen signalisiert, fehlt bei dieser Lösung die Grace-CPU, stattdessen kommen 16 per NVLink verbundene B300-GPUs und x86-Prozessoren zum Einsatz. Aufseiten des Prozessors kamen in der Vergangenheit AMD und Intel zum Zug.

Server-Anbieter und CSPs sind an Bord

Laut Nvidia wollen im ersten Schritt Cisco, Dell, Hewlett Packard Enterprise, Lenovo und Supermicro eine breite Palette von Blackwell-Ultra-Produkten anbieten, später sollen Aivres, ASRock, Asus, Eviden, Foxconn, Gigabyte, Inventec, Pegatron, Quanta, Wistron und Wiwynn folgen. Unter den Cloud Service Providern, die Blackwell Ultra anbieten wollen, finden sich AWS, Google Cloud, Microsoft Azure und Oracle. Blackwell-GPUs in der Cloud wollen außerdem CoreWeave, Crusoe, Lambda, Nebius, Nscale, Yotta und YTL anbieten.

ComputerBase hat Informationen zu diesem Artikel von Nvidia unter NDA im Vorfeld und im Rahmen einer Veranstaltung des Herstellers in San Jose, Kalifornien erhalten. Die Kosten für An-, Abreise und fünf Hotelübernachtungen wurden vom Unternehmen getragen. Eine Einflussnahme des Herstellers oder eine Verpflichtung zur Berichterstattung bestand nicht. Die einzige Vorgabe aus dem NDA war der frühestmögliche Veröffentlichungszeitpunkt.

- SOCAMM: LPDDR5X-basierte RAM-Riegel für hohe Kapazität und Bandbreite

- Nvidia RTX Pro 6000 (Max-Q): Blackwell mit 96 GB GDDR7 bei 300 bis 600 Watt ist offiziell

- Für Rubin und Feynman: SK Hynix, Samsung und Micron zeigen HBM4 mit bis zu 48-GB-Stack

- +6 weitere News