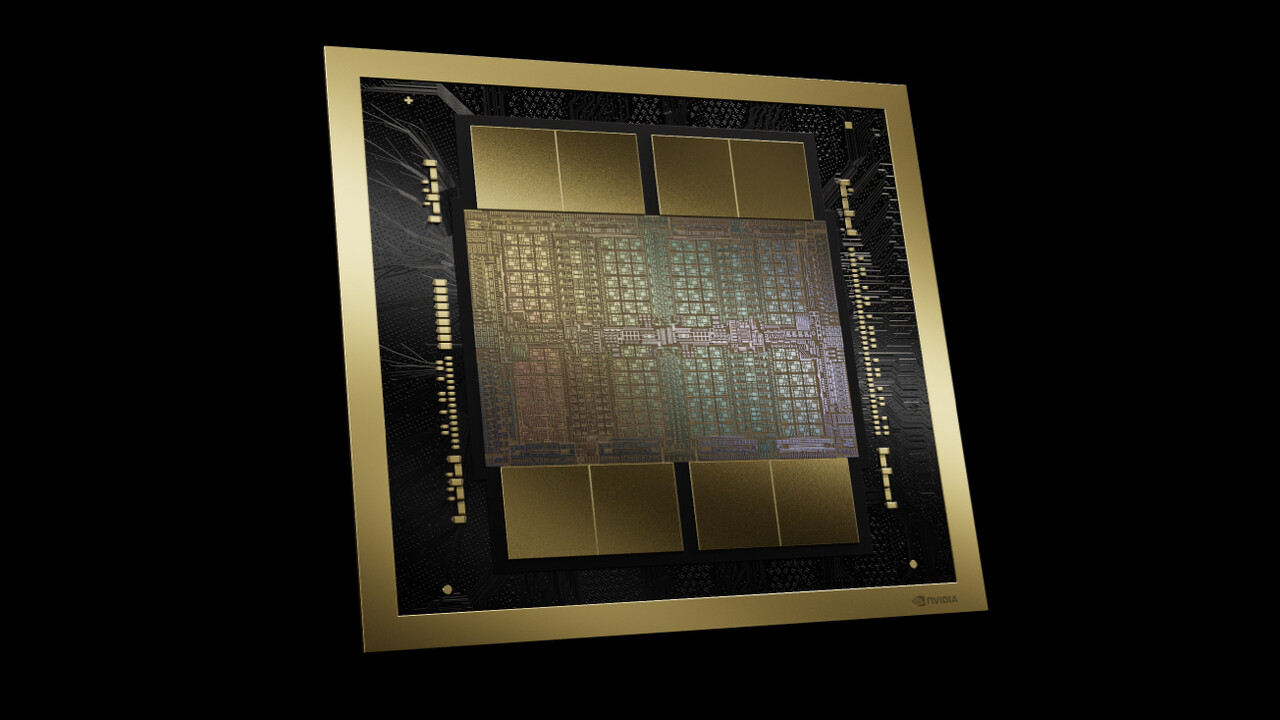

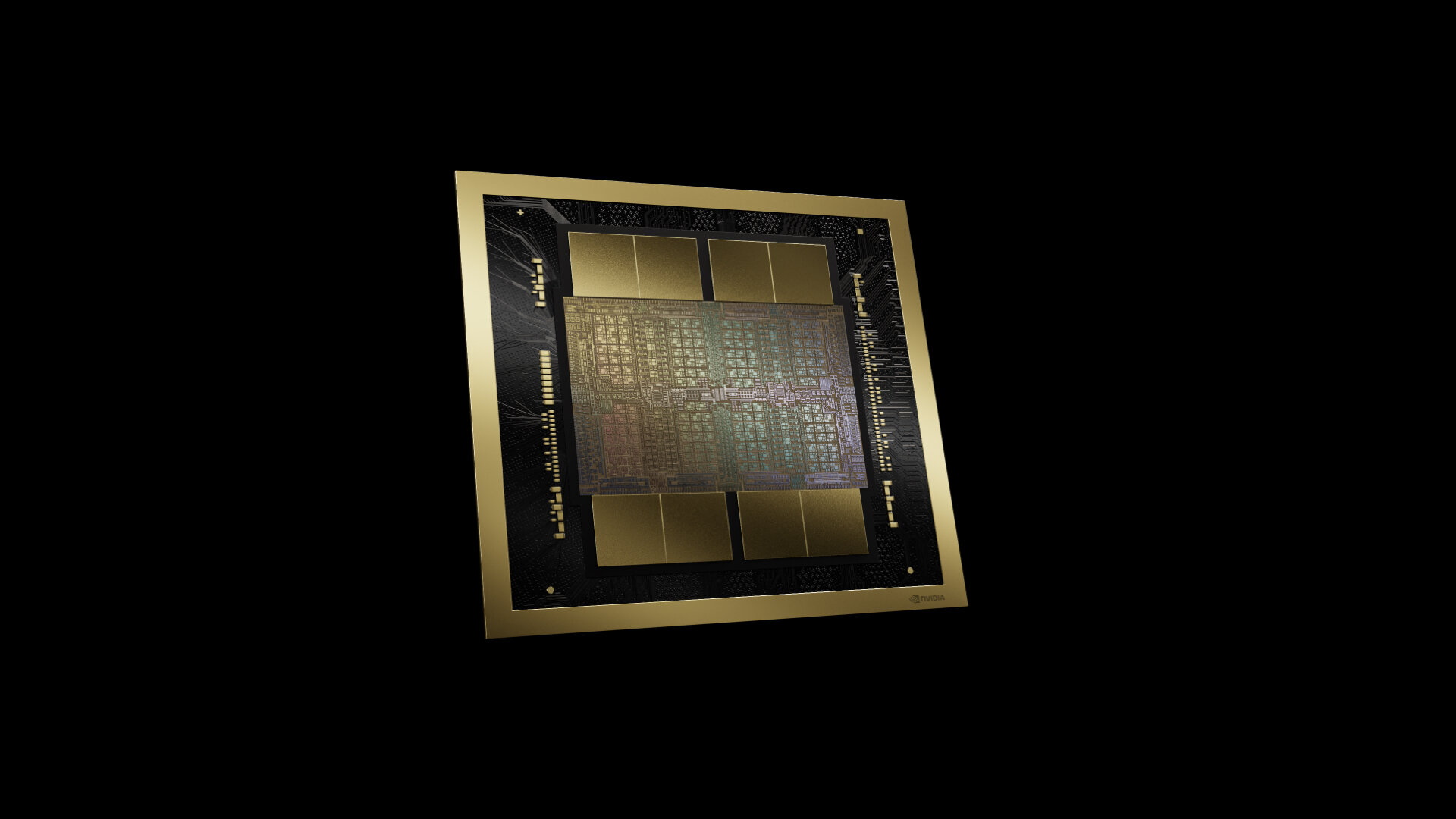

Nvidia Blackwell: B200-GPU kommt als Dual-Die mit 208 Milliarden Transistoren

Blackwell ist Nvidias neue Architektur für AI-Beschleuniger der nächsten Generation. Die B200-GPU besteht aus zwei Dies, die über einen Die-to-Die-Link miteinander verbunden werden, um als eine GPU zu agieren. Blackwell kommt in mehreren neuen Nvidia-Lösungen zum Einsatz und soll eine bis zu 30-fache AI-Leistung liefern.

Nvidia stößt bei der Chip-Entwicklung und beim Design so langsam an die physischen Grenzen dessen, was in der Halbleiterherstellung und modernen Fotolithografie derzeit mit einer Fotomaske (Retikel) möglich ist. Blackwell als neue GPU-Architektur für AI-Beschleuniger nutzt deshalb ein Design mit zwei identischen Dies, die wiederum über einen Die-to-Die-Link mit 10 TB/s kommunizieren und gegenüber Anwendungen als eine einzelne GPU agieren sollen, sodass laut Nvidia keine Nachteile eines klassischen Chiplet-Designs bestehen würden. Der Aufbau erinnert damit ein wenig an Apples M1 Ultra und M2 Ultra, die ein Die-to-Die-Interconnect mit 2,5 TB/s nutzen. AMD nutzt bei den neuesten Modellen MI300A und MI300X ein Chiplet-Design. Eine weitere Herangehensweise sind Wafer-Scale-Beschleuniger wie die WSE-3 von Cerebras.

Fertigung im Custom-Prozess 4NP TSMC

Die Fertigung der B200-GPU auf Basis der Blackwell-Architektur übernimmt der langjährige Foundry-Partner TSMC, der für Nvidia einen weiteren neuen Custom-Prozess entwickelt hat, der diesmal unter dem Namen 4NP TSMC läuft. Es ist davon auszugehen, dass es sich somit um eine speziell an die Bedürfnisse von Nvidia und Blackwell angepasste Fertigung handelt, die sich an dem Node N4P orientieren dürfte, die auch anderen Abnehmern zur Verfügung steht. Nvidias Dual-Die-Design resultiert in einer GPU mit 208 Milliarden Transistoren. Zum Vergleich: Der Vorgänger H100 kommt in seiner ursprünglichen Ausführung auf 80 Milliarden, AMD bei MI300X auf 153 Milliarden und eine riesige Wafer-Scale-Lösung wie WSE-3 auf 4 Billionen Transistoren.

B200 und B100 zum Start

Kam Hopper zum Start noch zuerst als H100 auf den Markt, bevor die Ausbaustufe (G)H200 folgte, liegt bei Blackwell der Fokus direkt auf der schnelleren Ausführung B200. Eine B100-GPU gibt es ausschließlich für die HGX-Systeme von Drittanbietern aber ebenso. Dabei handelt es sich um eine kleinere TDP-Konfiguration (700 versus 1.000 Watt) mit entsprechend reduzierter Leistung.

192 GB HBM3e mit 8 TB/s

Neben den zwei GPU-Dies sitzt der High Bandwidth Memory (HBM) verteilt auf acht Stacks, sofern die ersten von Nvidia veröffentlichten Renderings des Packages dem tatsächlichen Design entsprechen. Zum Einsatz kommen 192 GB HBM3e mit einer Speicherbandbreite von 8 TB/s. Der Vorgänger H100 war zu Beginn mit 80 GB HBM3 bestückt, später folgten auf Basis der Hopper-Architektur aber auch die Doppel-GPU-Lösung H100 NVL mit 188 GB HBM3 und zuletzt GH200 mit 141 GB HBM3e und einer Speicherbandbreite von 5 TB/s. 192 GB besitzt auch der AI-Beschleuniger MI300X von AMD, dort kommt allerdings der ältere Standard HBM3 mit 5,2 TB/s zum Einsatz.

Inferencing mit Transformer Engine beschleunigt

Nvidia gibt für Blackwell im Vergleich zu Hopper eine bis zu 4-fache Leistung beim AI-Training, eine bis zu 30-fache Leistung für das Inferencing und eine bis zu 25-fache Energieeffizienz an. Erreicht wird dies auch über die zweite Generation der Transformer Engine als Bestandteil der Tensor Cores. Transformer sind ein integraler Bestandteil quasi aller modernen Large Language Models (LLM) und namensgebend etwa beim „GPT“ von ChatGPT, das für „Generative Pre-trained Transformer“ steht. Hintergründe dazu liefert ComputerBase in einem Artikel speziell rund um Large Language Models. Beschleunigt werden kann mit der neuen Transformer Engine bei Blackwell jetzt auch das Inferencing mit FP4 für 4-Bit-Präzision. Das FP4-AI-Inferencing liefert Nvidia zufolge im Vergleich zu FP8 die doppelte Leistung bei doppelter Bandbreite für doppelt so große Models. War Hopper noch stark auf das AI-Training ausgerichtet, richtet sich Blackwell diesmal deutlich mehr auch an die Bedürfnisse beim Inferencing.

20 PetaFLOPS für FP4 und 10 PetaFLOPS für FP8

Die Leistung der B200-GPU gibt Nvidia mit 20 PetaFLOPS für FP4 und 10 PetaFLOPS für FP8 bei der Beschleunigung über die Tensor Cores an. Zum Vergleich: Eine H100 kommt als SXM5-Modul auf rund 4 PetaFLOPS, als H100 PCIe auf 3 PetaFLOPS und als H100 NVL mit zwei GPUs auf knapp 8 PetaFLOPS bezogen auf die Leistung bei FP8. FP4 konnte bei Hopper nicht über die Tensor Cores beschleunigt werden, weshalb hier kein direkter Vergleich möglich ist. Weitere Leistungsangaben zu Blackwell und den verschiedenen darauf basierenden Lösungen sind im Laufe der GTC zu erwarten. Auch zur TDP der einzelnen Umsetzungen hat Nvidia noch keine Daten veröffentlicht.

NVLink muss mitwachsen

Die GPU selbst ist allerdings nur ein Bestandteil der gesamten Datacenter-Architektur von Nvidia, die mit Blackwell auf die nächste Stufe gehoben wird. Ein bisheriger Flaschenhals sei die Kommunikation der GPUs untereinander über den NVLink gewesen, erklärt Nvidia. Damit ist am konkreten Beispiel von Blackwell nicht der neue Die-to-Die-Interconnect gemeint, sondern die Kommunikation aus der GPU heraus zu einer anderen. Die jetzt 5. Generation des NVLink arbeitet mit einer Bandbreite von 1,8 TB/s statt zuvor 900 GB/s. NVLink kann bei Blackwell auch als Multi-Node-Interconnect verwendet werden, was zuvor über InfiniBand mit 100 GB/s abgewickelt wurde, sodass Nvidia für dieses konkrete Szenario von einer Leistungssteigerung um den Faktor 18x spricht.

NVLink Switch zählt 50 Milliarden Transistoren

Der für den NVLink benötigte „NVLink Switch 7.2T“ ist ein ebenso imposanter Chip wie die daran angebundene B200-GPU. Auch den NVLink Switch lässt Nvidia in 4NP TSMC fertigen und kommt dabei auf 50 Milliarden Transistoren – das sind fast zwei Drittel der Transistoren von Hopper H100. Bis zu 576 GPUs lassen sich einer NVLink-Domain hinzufügen, sodass Nvidia laut eigener Aussage damit für die Verarbeitung von Large Language Models der nächsten Generation mit Billionen Parametern gewappnet sei.

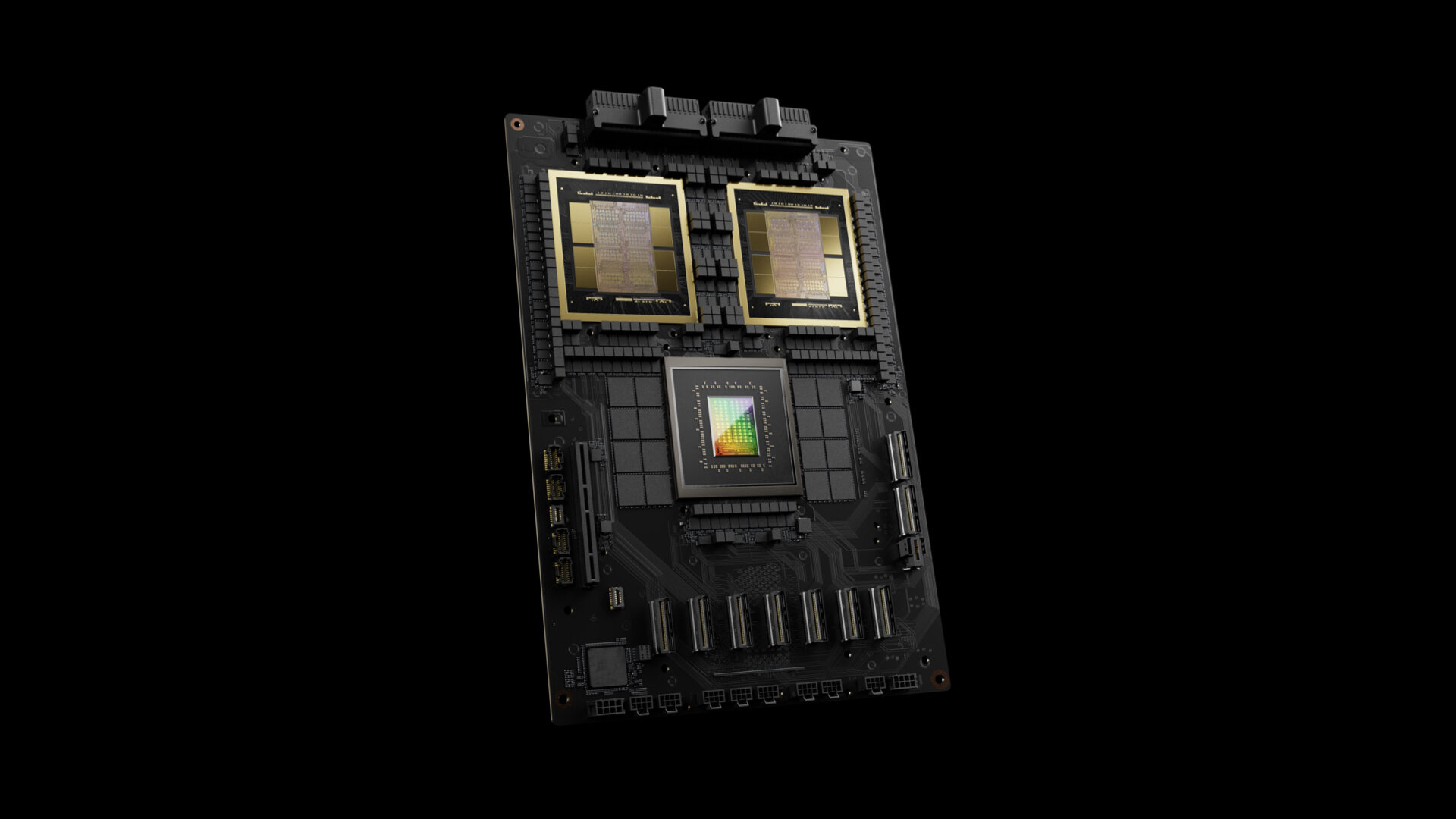

Blackwell kommt auch als Superchip

Zum Einsatz kommt Nvidias B200-GPU in zwei eigenen Lösungen: der B200-Ausführung als SXM-Modul, das für die eigenen DGX- und HGX-Systeme auf Basis einer CPU-Plattform mit x86-Architektur entwickelt wurde, und der Ausführung als GB200 Grace Blackwell Superchip auf Basis einer Arm-Architektur. Im Detail setzen DGX B200 und HGX B200 auf die 5. Generation Intel Xeon alias Emerald Rapids, nachdem bei DGX H100 und HGX H100 noch Sapphire Rapids genutzt wurde.

Der GB200 Grace Blackwell Superchip nutzt aufseiten der CPU hingegen die Arm-Architektur. Wie es der Name bereits vorweg nimmt, kommt Nvidias eigene Grace-CPU mit 72 Neoverse-V2-Kernen von Arm zum Einsatz. Daran angebunden wird anders als beim GH200 Grace Hopper Superchip aber nicht mehr nur eine GPU, sondern gleich zwei. Ein GB200 Grace Blackwell Superchip besteht somit stets aus zwei GPUs mit insgesamt vier Dies und einer Grace-CPU, die TDP kann laut Blackwell Technical Brief „bis zu 2.700 Watt“ betragen.

Mit dem GB200 Grace Blackwell Superchip bestückt sind von Nvidia selbst die Systeme DGX GB200 und GB200 NVL72.

Was die Systeme im Detail auszeichnet, darauf geht ein weiterer Artikel gesondert ein.

Die Branchengrößen stehen Schlange

Die etablierten Branchengrößen haben bereits Interesse an Blackwell bekundet. Laut Nvidia sind Amazon Web Services, Dell Technologies, Google, Meta, Microsoft, OpenAI, Oracle, Tesla und xAI die ersten Abnehmer entsprechender Lösungen.

ComputerBase hat Informationen zu diesem Artikel von Nvidia im Vorfeld und im Rahmen einer Veranstaltung des Herstellers in San Jose unter NDA erhalten. Die Kosten für Anreise, Abreise und vier Hotelübernachtungen wurden von dem Unternehmen getragen. Eine Einflussnahme des Herstellers auf die oder eine Verpflichtung zur Berichterstattung bestand nicht. Die einzige Vorgabe war der frühestmögliche Veröffentlichungszeitpunkt.

Im Nachgang der Vorstellung auf der GTC-2024-Keynote hat Nvidia einen Technik-Überblick zur Blackwell-Architektur veröffentlicht (PDF). Er bestätigt die 700 statt 1.000 Watt TDP für B100 im Vergleich zu B200 und nennt zugleich „bis zu 2.700 Watt“ für den GB200 Grace Blackwell Superchip mit zwei B200-GPUs und Grace-CPU.