Nvidia DGX GB200 SuperPOD: Supercomputer mit 576 Blackwell-GPUs liefert 11,5 ExaFLOPS

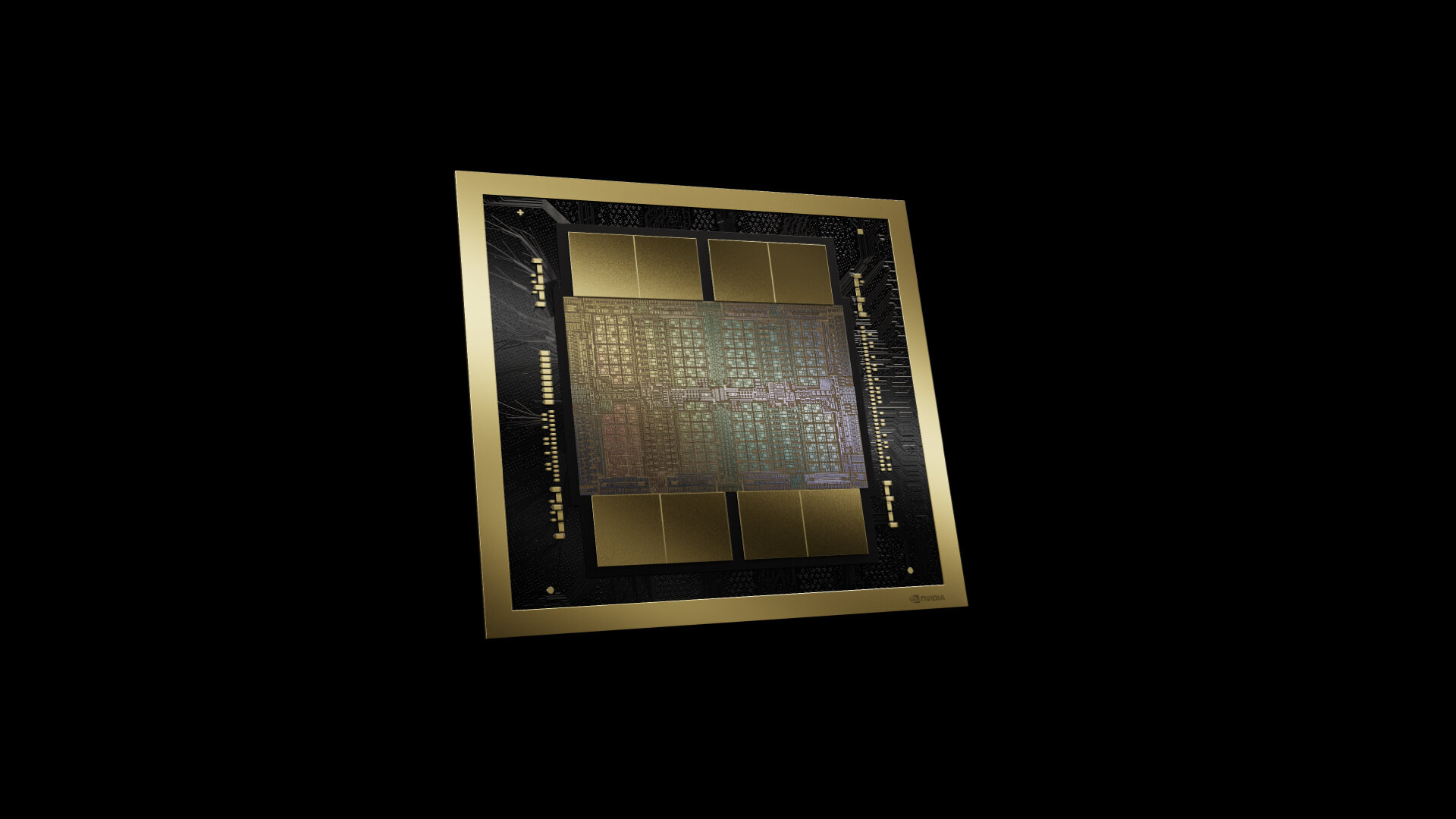

Auf die Vorstellung der B200-GPU auf Basis der Blackwell-Architektur lässt Nvidia mit dem B200-SXM-Modul und dem GB200 Grace Blackwell Superchip gleich die ersten Produkte mit dieser GPU folgen, die im DGX B200 und HGX B200 sowie im DGX GB200 und GB200 NVL72 zum Einsatz kommen. Damit lässt sich ein neuer SuperPOD bauen.

Analog zum DGX H100 und HGX H100 bietet Nvidia bei der Blackwell-Architektur erneut Datacenter-Lösungen nach Baukastensystem an, die entweder direkt von Nvidia (DGX) oder von einem Drittanbieter (HGX) stammen, den Nvidia mit einem Server-Mainboard beliefert, auf dem acht B200-GPUs als SXM-Modul sitzen. Bei den DGX-Systemen bietet Nvidia eine fertig bestückte Lösungen an, bei den HGX-Lösungen gibt es quasi einen Barebone, der vom Server-Anbieter und vom Käufer weiter angepasst werden kann.

Acht B200 bilden das DGX B200

Das eigene DGX B200 ist die bereits 6. Generation dieser Art von Systemen von Nvidia und kommt wie der Vorgänger in luftgekühlter Rack-Ausführung, wie sie in zahlreichen Datacenter-Standorten weltweit bereits zu finden sind. Die Kombination aus acht B200-GPUs stellt 1,4 TB HBM3e mit einer addierten Speicherbandbreite von 64 TB/s und eine FP4-Leistung von 144 PetaFLOPS zur Verfügung. Aufseiten des Netzwerks nutzt der DGX B200 weiterhin acht der bekannten ConnectX-7 NICs mit einer Anbindung von jeweils 400 Gbit/s.

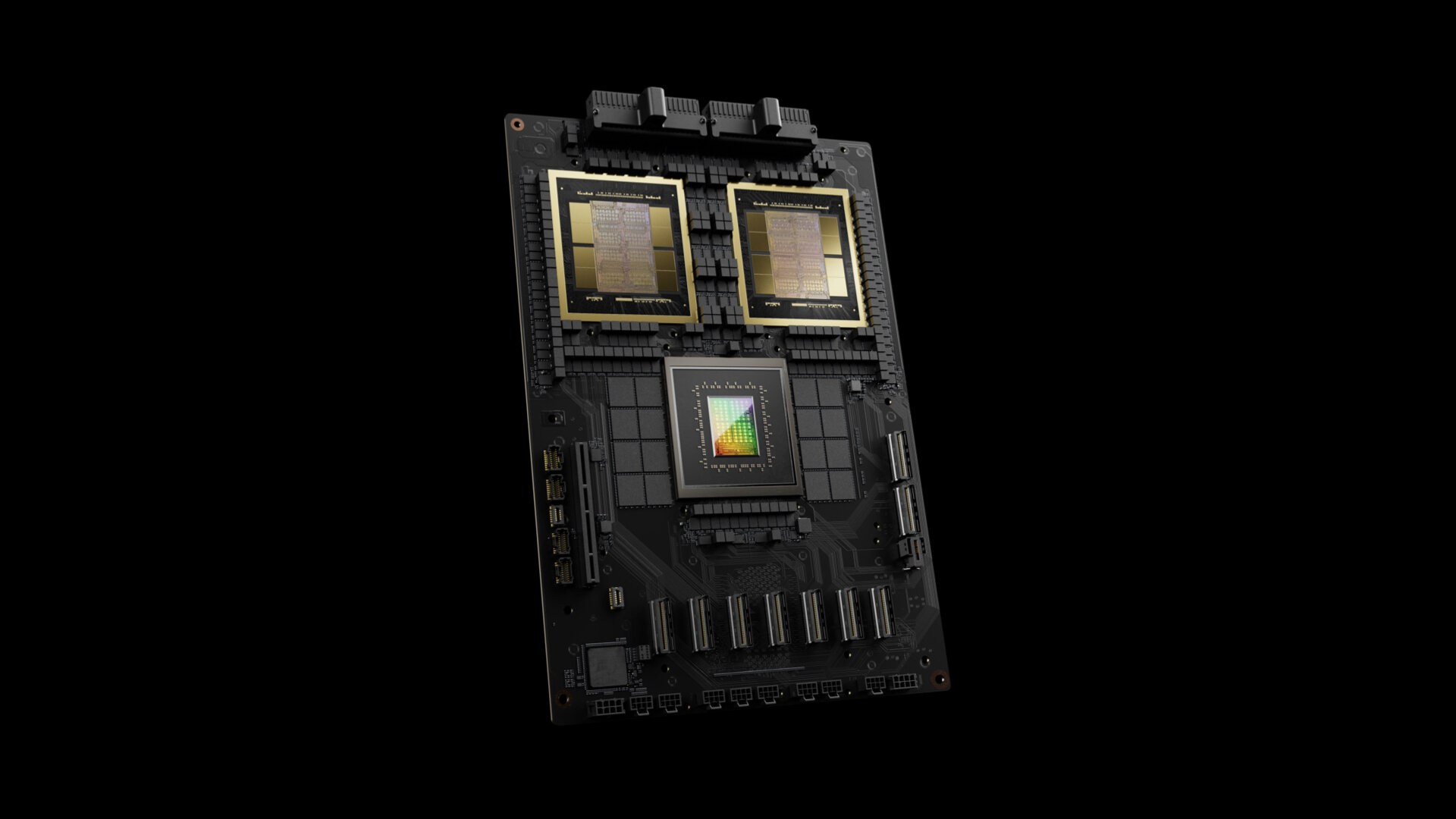

Grace Blackwell Superchip nutzt Doppel-GPU

Signifikant größer dimensioniert ist der DGX GB200 auf Basis des GB200 Grace Blackwell Superchips. Ein DGX GB200 nutzt gleich 36 GB200 Grace Blackwell Superchips, sodass 72 der neuen Blackwell-B200-GPUs (mit 144 Dies) und 36 Grace-CPUs zur Verfügung gestellt werden. Dort stehen 6,75 TB HBM3e und zusätzlich über die CPUs insgesamt 16,875 TB LPDDR5X zur Verfügung, weil jede Grace-CPU wie beim Vorgänger GH200 auf 480 GB LPDDR5X mit ECC-Support bei 546 GB/s setzt.

SuperPODs mit B200 und GB200

Aus beiden Lösungen, also DGX B200 und DGX GB200, lassen sich auch wieder sogenannte SuperPODs aufbauen, also für Supercomputer gedachte Umsetzungen mit mehreren dieser Lösungen. Einen SuperPOD definiert Nvidia als System mit acht oder mehr DGX B200 respektive DGX GB200. Beim DGX B200 SuperPOD gibt es somit mindestens 64 B200-GPUs als SXM-Modul und 8 Xeon-Prozessoren. Ein DGX GB200 SuperPOD erreicht hingegen sogar 576 B200-GPUs, 288 Grace-CPUs und liefert damit 11,5 ExaFLOPS FP4-Leistung. Nur beim DGX GB200 SuperPOD bietet Nvidia zudem das neue Quantum-X800 InfiniBand Networking mit 800 statt 400 Gbit/s an. Das DGX B200 bleibt bei 400 Gbit/s.

NVLink-Switch-Racks im GB200 NVL72

Den gesamten SuperPOD-Baustein aus DGX GB200 und NVLink-Switch-Racks bezeichnet Nvidia als GB200 NVL72. Darin stecken 18 GB200 Superchip Compute Trays, die jeweils eine Höhe von 1U besitzen und mit Wasser gekühlt werden. Nvidia attestiert jedem dieser Trays 1.728 GB „schnellen Speicher“, was sich davon ableitet, dass zwei GB200 Grace Blackwell Superchips auf 768 GB HBM3e für die vier GPUs und auf 960 GB LPDDR5X für die zwei Grace-CPUs kommen. In jedem GB200 NVL72 kommen zudem neun NVLink Switch Trays mit jeweils zwei NVLink Switch 7.2T für eine Gesamtbandbreite von 14,4 TB/s zum Einsatz.

Alle Server-Anbieter sind dabei

Nvidia erwartet, dass SuperPODs mit DGX GB200 und DGX B200 noch im Laufe dieses Jahres über die globalen Vertriebspartner verfügbar sein werden. Für den HGX B200 nennt Nvidia in erster Linie Cisco, Dell Technologies, Hewlett Packard Enterprise, Lenovo und Supermicro, aber auch Aivres, ASRock Rack, Asus, Eviden, Foxconn, Gigabyte, Inventec, Pegatron, QCT, Wistron, Wiwynn und ZT Systems.

ComputerBase hat Informationen zu diesem Artikel von Nvidia im Vorfeld und im Rahmen einer Veranstaltung des Herstellers in San Jose unter NDA erhalten. Die Kosten für Anreise, Abreise und vier Hotelübernachtungen wurden von dem Unternehmen getragen. Eine Einflussnahme des Herstellers auf die oder eine Verpflichtung zur Berichterstattung bestand nicht. Die einzige Vorgabe war der frühestmögliche Veröffentlichungszeitpunkt.